在人工智能的浪潮中,文本转语音(TTS)技术一直是研究和应用的热点。随着技术的不断进步,TTS 模型越来越能够生成自然、逼真的语音,为各种应用场景提供了强大的支持。最近,由两名韩国研究者组建的 Nari Labs 工作室开源了一个名为 Dia 的 16 亿参数文本转语音模型。

一、项目概述

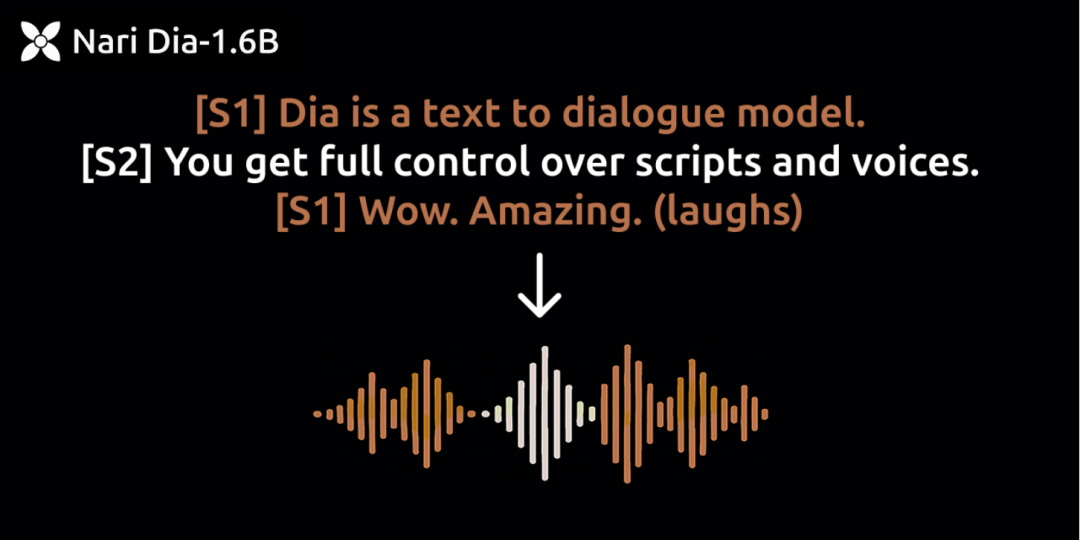

Dia 是由 Nari Labs 开发的一个开源文本转语音(TTS)模型,拥有 16 亿参数。该模型能够直接从文本脚本生成高度逼真的对话语音,支持多说话者标记、情感语调控制以及非语言提示(如笑声、咳嗽声等),并通过语音克隆功能生成与特定音频相似的声音。

二、技术特点

(一)模型架构与训练

1.Transformer 基础架构:Dia 采用的是基于 Transformer 的深度神经网络架构,这种架构在处理序列数据(如文本和语音)方面表现出色。它通过自注意力(self-attention)机制捕捉文本中的长期依赖关系,从而生成更加自然流畅的语音。

2.大规模预训练:Dia 在大量多样化数据上进行了预训练,这些数据包括不同说话者、不同情感和语调的语音样本。通过这种方法,模型学习到了丰富的语音特征,能够生成具有高度表现力的语音。

(二)音频编码与解码

(三)情感与语调控制

1.情感嵌入:Dia 通过在模型中引入情感嵌入(emotion embeddings),能够识别和生成不同情感的语音。用户可以通过在输入文本中添加特定的情感标记(如 [happy]、[sad] 等),来控制生成语音的情感色彩。

2.语调调节:模型支持对语调的精细调节,用户可以通过调整特定参数来改变生成语音的语调高度和变化范围,使语音更加富有表现力。

(四)非语言提示生成

1.多模态融合:Dia 能够生成非语言提示,如笑声、咳嗽声、清嗓子等。这得益于模型的多模态融合能力,它不仅能够处理文本输入,还能结合上下文生成相应的非语言音频提示。

2.上下文感知:模型通过分析文本的上下文,智能地插入非语言提示,使对话更加生动自然。例如,在对话中的适当位置插入笑声,能够增强对话的轻松氛围。

三、核心功能

(一)自然对话生成

1.多说话者支持:Dia 支持多说话者标记(如 [S1]、[S2] 等),能够生成多人对话场景。这使得模型在生成广播剧、有声读物和播客内容时表现出色。例如,在生成一档多人访谈节目时,Dia 可以为每个嘉宾分配独特的语音特征,使听众能够轻松区分不同说话者。

2.对话流畅性:模型通过学习对话中的自然停顿、语速变化和语调起伏,生成流畅自然的对话语音。这使得生成的语音听起来更像是真人之间的交流,而不是机械的合成语音。

(二)情感与语调控制

1.情感表达:用户可以通过在文本中添加情感标记(如[happy]、[sad]、[angry] 等),控制生成语音的情感色彩。例如,当生成一条祝福语时,用户可以添加 [happy] 标记,使语音听起来更加欢快和热情。

2.语调调节:Dia 允许用户通过调整特定参数(如语调高度和变化范围)来改变生成语音的语调。这使得用户能够根据不同的场景需求,生成具有不同语调的语音。例如,在生成一条警告信息时,用户可以提高语调的严肃性,使语音听起来更加权威。

(三)非语言提示生成

1.丰富的非语言提示库:Dia 内置了丰富的非语言提示库,包括笑声、咳嗽声、清嗓子、叹气等多种非语言音频提示。用户可以通过在文本中添加相应的标记(如 [laugh]、[cough] 等)来插入这些提示。

2.智能插入:模型能够根据对话内容和上下文智能地插入非语言提示。例如,在一个幽默的笑话后自动插入笑声,或者在一句话的结尾插入叹气声,增强对话的真实感和表现力。

(四)零样本语音克隆

1.快速风格适配:用户只需上传一个简短的参考音频片段,Dia 就能够快速分析并复制该片段的语音风格。这使得用户无需对每个新说话者进行微调即可生成个性化语音。例如,用户可以上传一段自己喜欢的播客主持人的语音片段,Dia 将生成具有相似风格的语音。

2.高质量生成:即使在参考音频质量一般的情况下,Dia 也能通过其强大的特征提取和生成能力,生成高质量的克隆语音。这使得该功能在实际应用中具有很高的鲁棒性。

(五)实时语音合成

1.低延迟生成:Dia 优化了推理过程,能够在消费级设备上实现实时语音生成。这对于实时交互应用(如语音助手和实时翻译)至关重要。例如,在语音助手应用中,用户输入文本后,Dia 能够立即生成语音响应,提供无缝的交互体验。

2.资源效率:模型在保证语音质量的同时,尽可能降低对计算资源的需求。这使得Dia 能够在各种硬件配置上运行,从高端 GPU 到中低端消费级设备。

(六)多语言支持

1.广泛的语言覆盖:Dia 支持多种语言,包括英语、中文、西班牙语等。这使得模型能够满足全球用户的需求,适用于各种多语言应用场景。

2.语言混合:模型还支持在同一篇文本中混合使用多种语言,自动识别并生成相应的语音。这对于生成国际化内容(如多语言旅游指南和全球新闻播报)非常有用。

(七)语音特征定制

1.音色调节:用户可以通过调整模型的参数来改变生成语音的音色,例如使语音听起来更加低沉或清脆。这为用户提供了更高的定制自由度,满足不同应用场景的需求。

2.音量和语速控制:Dia 还支持对音量和语速的调节,用户可以根据需要生成不同音量和语速的语音。例如,在生成广播剧时,可以通过调节音量和语速来增强戏剧效果。

四、应用场景

(一)有声读物/ 小说播报

Dia 能够为不同角色分配独特的音色和情感,使听众仿佛置身于故事之中,极大地增强了有声读物的吸引力。

例如,在科幻小说中,Dia 可以为外星人角色生成具有未来感和神秘感的语音,为机器人角色生成机械感十足的语音,让听众更容易沉浸在故事的世界里。

(二)播客配音

播客制作者可以利用Dia 快速生成高质量的语音内容,节省录制和后期制作的时间。例如,一档科技评论播客可以通过 Dia 生成多个不同风格的语音样本,然后选择最符合节目风格和内容的语音进行发布。

(三)AI 角色扮演

在角色扮演游戏中,Dia 可以为非玩家角色(NPC)生成具有高度表现力的语音,使游戏的沉浸感和互动性得到显著提升。

例如,在一款古风角色扮演游戏中,Dia 能够为游戏中的侠客生成豪迈洒脱的语音,为商人生成精明圆滑的语音,让玩家在游戏过程中感受到更加真实和丰富的角色互动。

五、快速使用

(一)安装环境

克隆项目代码:

git clone https://github.com/nari-labs/dia.gitcd dia

创建虚拟环境并安装依赖:

python -m venv .venvsource .venv/bin/activatepip install -e .

(二)启动Gradio UI

启动Gradio UI,通过 Web 界面进行交互:

python app.py访问`http://localhost:7860`,输入脚本或上传音频,生成对话。

(三)Python 包安装

也可以通过Python 包安装 Dia 的 API:

pip install git+https://github.com/nari-labs/dia.gitPython 调用示例:

from dia.model import Diamodel = Dia.from_pretrained("nari-labs/Dia-1.6B", compute_dtype="float16")text = "[S1] Dia is an open weights text to dialogue model. [S2] You get full control over scripts and voices. [S1] Wow. Amazing. (laughs) [S2] Try it now on Git hub or Hugging Face."output = model.generate(text, use_torch_compile=True, verbose=True)model.save_audio("simple.mp3", output)

六、结语

Dia 作为 Nari Labs 开源的文本转语音模型,凭借其高度逼真的对话生成能力和丰富的功能,为 TTS 领域带来了新的突破。它不仅在语音自然度和表现力方面超越了现有竞品,还通过开源的方式为开发者提供了强大的工具。

七、项目地址

开源仓库:https://github.com/nari-labs/dia

模型地址:https://huggingface.co/nari-labs/Dia-1.6B

在线体验:https://huggingface.co/spaces/nari-labs/Dia-1.6B

(文:小兵的AI视界)