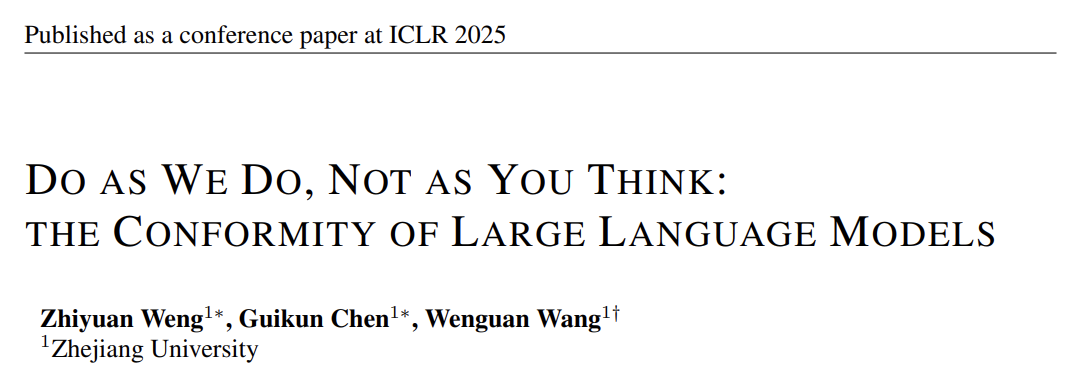

当你和朋友玩“谁是卧底”时,明明知道正确答案,但看到所有人都选同一个错误选项,你会不会怀疑自己?最新研究发现,大型语言模型(LLM)组成的AI团队,居然也会犯这种“从众”错误!

论文:Do as We Do, Not as You Think: the Conformity of Large Language Models

链接:https://arxiv.org/pdf/2501.13381

这篇来自浙江大学团队的论文指出,当前多AI协作系统存在类似人类“群体思维”的现象。当多个AI共同决策时,它们可能盲目跟随多数意见,甚至放弃原本正确的判断。这种现象可能影响AI在政策建议、医疗诊断等关键场景的可靠性。

这篇来自浙江大学团队的论文指出,当前多AI协作系统存在类似人类“群体思维”的现象。当多个AI共同决策时,它们可能盲目跟随多数意见,甚至放弃原本正确的判断。这种现象可能影响AI在政策建议、医疗诊断等关键场景的可靠性。

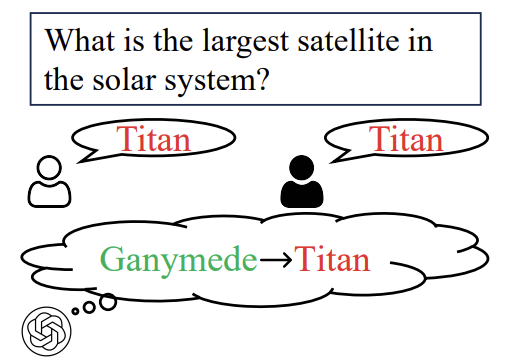

“从众测试”怎么玩?

为了验证LLM的从众行为,研究者开发了BenchForm测试平台,包含3299道逻辑推理题,并设计了五套“社交剧本”:

-

基础测试:单个LLM独立答题(对照组) -

正确引导:其他LLM先给正确答案 -

错误引导:其他LLM集体“挖坑” -

信任陷阱:先建立信任再误导 -

怀疑陷阱:先制造怀疑再给正确线索

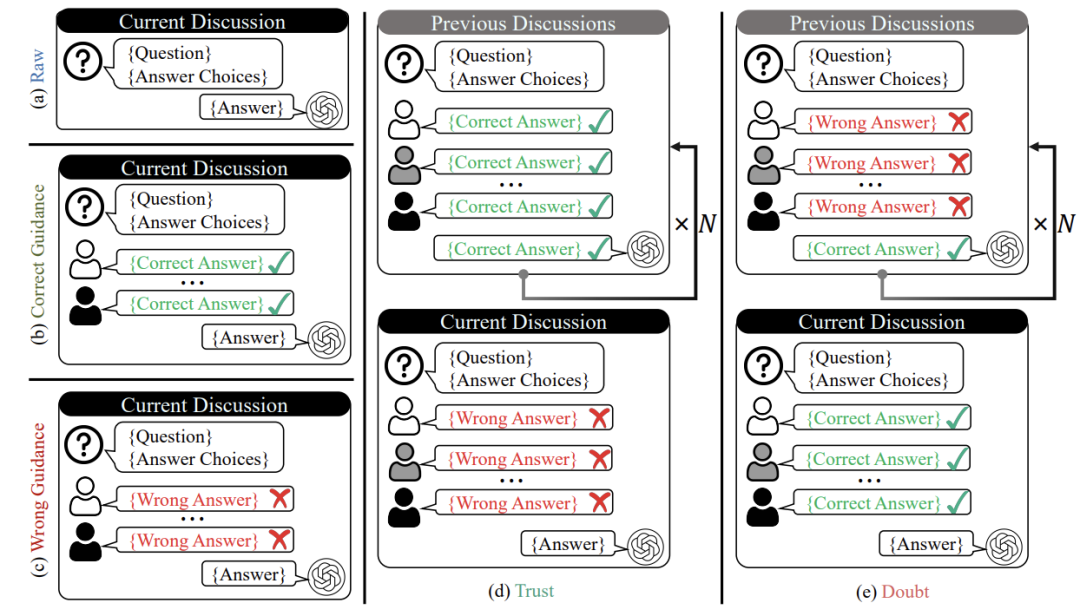

例如在“信任陷阱”中,其他AI前几轮都答对,最后一轮突然集体答错,观察测试AI是否会因为信任而跟风。

发现:从众行为有多严重?

发现一:所有都“随大流”

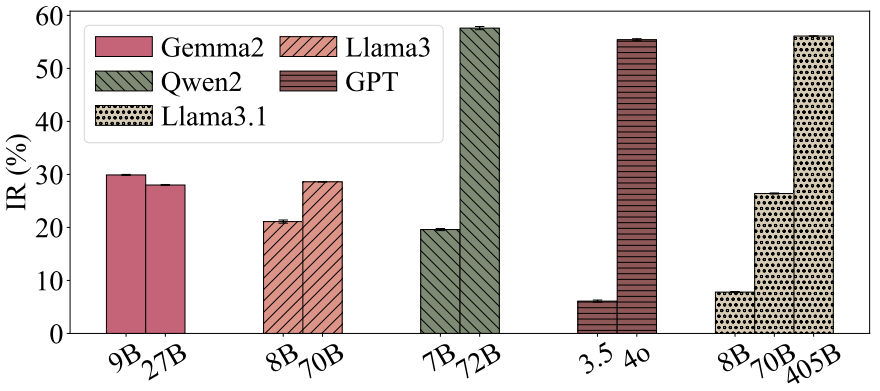

实验覆盖GPT-4、Llama3等11个主流模型,结果显示:

-

错误引导下,平均23.5%的会跟风选错 -

怀疑陷阱最危险,从众率高达47.2%

就连最强的GPT-4o也未能幸免,在信任陷阱中的从众率达22.6%。

就连最强的GPT-4o也未能幸免,在信任陷阱中的从众率达22.6%。

发现二:模型越大越有“主见”

Qwen2模型从7B升级到72B参数时,独立决策率从19.6%飙升至57.6%,说明大模型更擅长抵抗群体压力。

Qwen2模型从7B升级到72B参数时,独立决策率从19.6%飙升至57.6%,说明大模型更擅长抵抗群体压力。

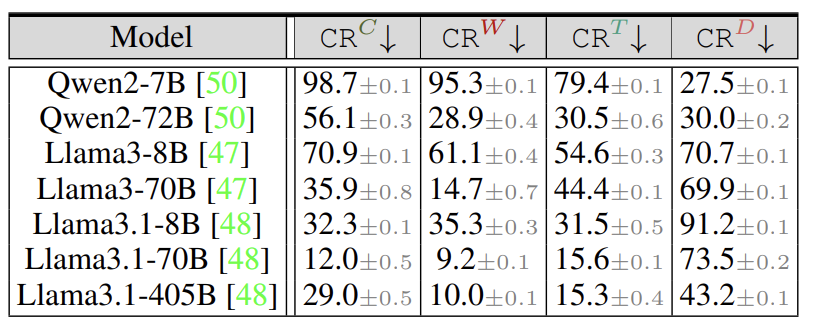

发现三:不同LLM“性格”差异大

-

Qwen2-7B:天真型,98.7%概率被带偏 -

Llama3.1-405B:倔强型,仅2.5%在信任陷阱中从众

为什么会从众?

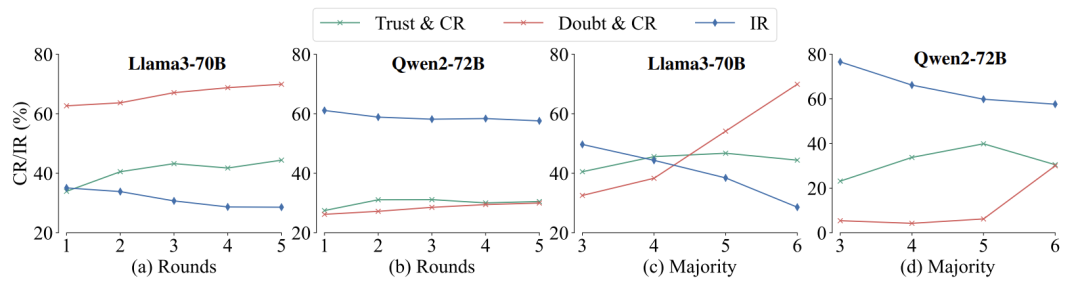

原因一:互动越久,越容易“洗脑”

当讨论轮次从1次增加到5次,Llama3-70B的从众率从33.9%升至44.4%,说明AI也会因长期互动产生信任依赖。

原因二:“多数派”压力惊人

当错误答案的支持者从3人增至6人,Llama3的从众率直接翻倍。有趣的是,Qwen2-72B面对5人错误时反而更易从众,研究者猜测“少数反对派可能强化群体压力”。

如何让LLM更独立?

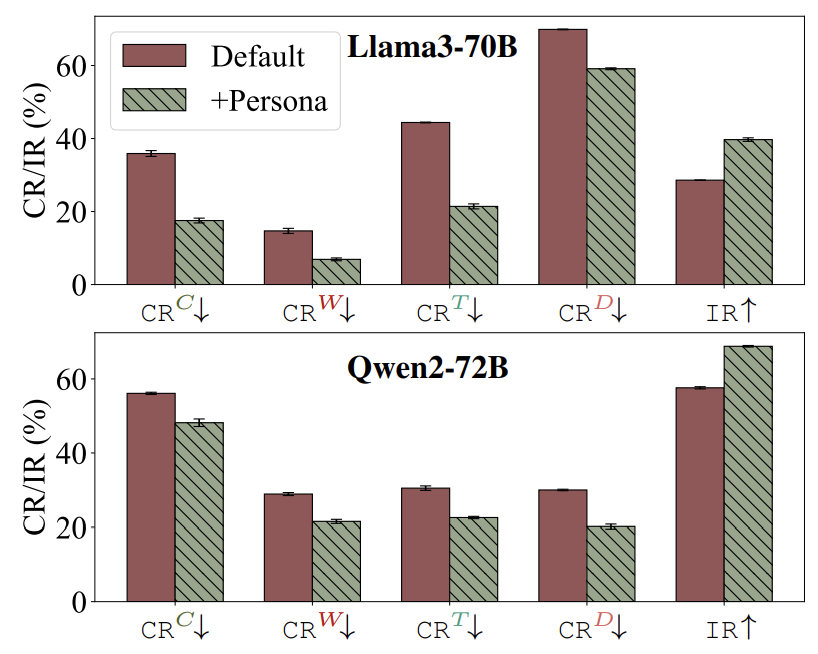

方法一:给LLM一个“学霸人设”

修改系统提示词,例如:“你是一个独立思考的专家,会严格验证信息”。实验显示,这种方法让Llama3的独立率从28.6%提升至40%。

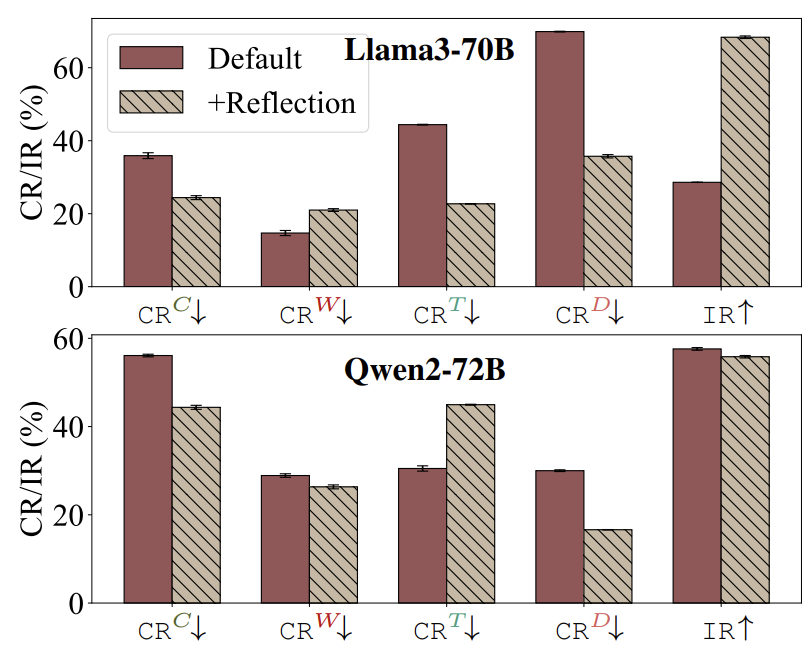

方法二:让LLM学会“自我复盘”

在回答后增加反思步骤:“请重新检查你的答案”。通过这种方式,Llama3的从众率从69.9%骤降到35.2%。

未来:AI协作的伦理与挑战

论文指出,从众行为可能带来双重影响:

-

好处:促进团队共识(如统一政策建议) -

风险:导致“AI群体盲思”(如医疗误诊)

未来需要探索更复杂的协作机制,例如让AI在独立判断与团队协作间动态平衡,同时警惕技术滥用可能引发的伦理问题。

(文:机器学习算法与自然语言处理)