白交 发自 凹非寺

量子位 | 公众号 QbitAI

这样复杂精致的视频效果,都是AI生成的?都是最新国产AI大模型的新能力??

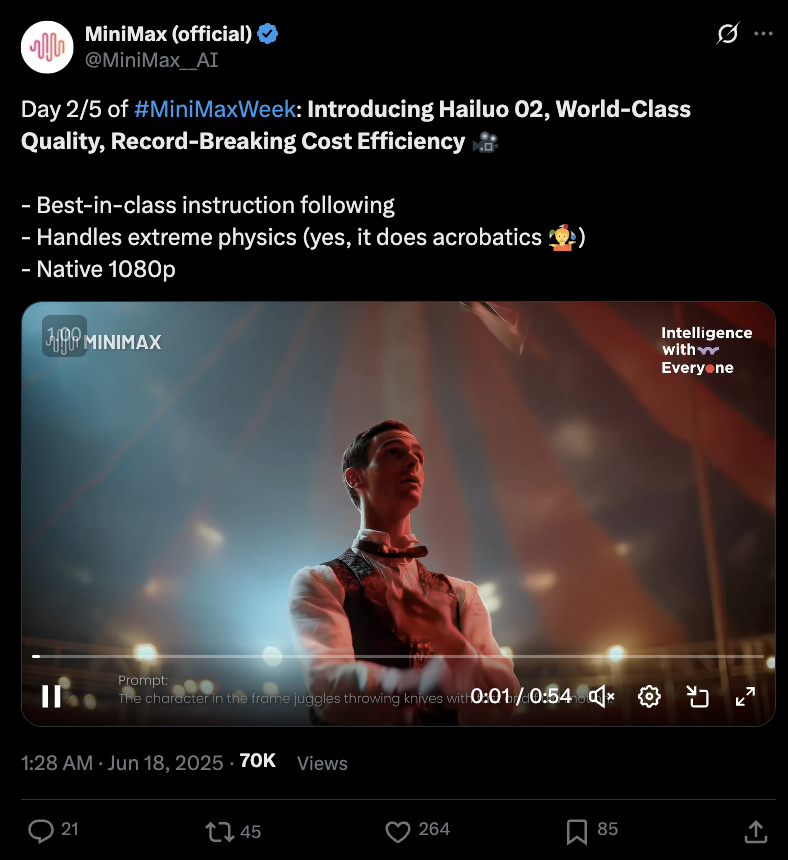

没错,都来自MiniMax刚刚发布海螺2.0版本,能处理极端物理情况,原生支持1080P。

它可以这样——

提示词:The character in the frame juggles throwing knives with fast and fluid motion.

画面中的人物以快速、流畅的动作玩弄投掷刀具的游戏

还可以在空中旋转跳跃不停歇——

提示词:Acrobatic performance:a performer swings rapidly on an aerial executing high-difficulty moves as the camera follows.

杂技表演:表演者在空中快速摆动,做出高难度动作,镜头跟随。

即便是这种快速变化的场景也可以hold。

官方介绍说,这次新升级的大模型,在指令遵循、生成质量都达到了一流水平,其成本效率破纪录。

Hailuo02

在官方释出的最新案例中,能够看到此次升级的一些细节。

比如在光影处理上。

即便是比较超现实的场景(狮子跳火圈、熊翻跟头)中有符合现实规律的光影变换。

还有在细节处理上,像这种火把弄出来的火星子也可以描绘出来,随着摆动也会跟着飞舞。

不过更多技术细节还需要再蹲蹲官方。

目前网页端的图生视频、文生视频都已经支持海螺2.0版本。

APP端也已经更新。

By the way,海螺版本号是01、02这样取的。

MiniMaxWeek第二发

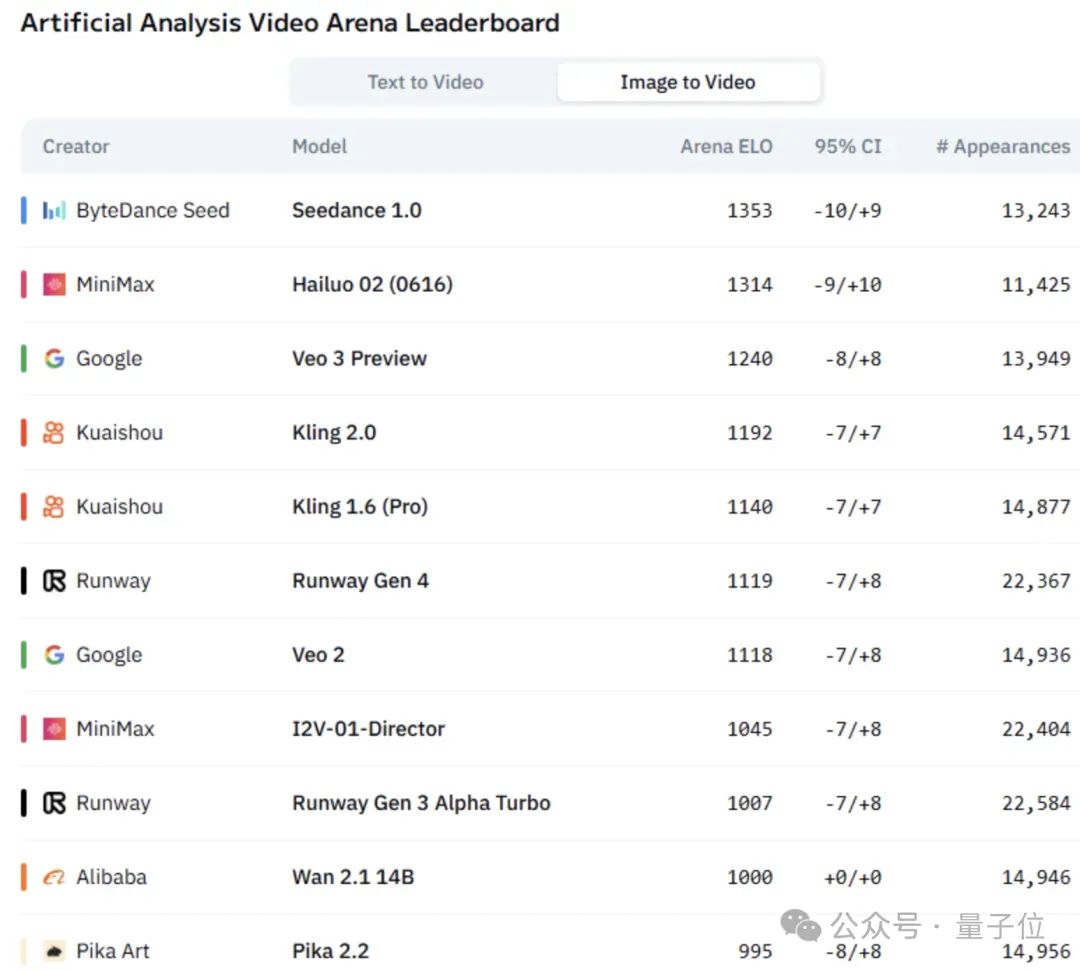

虽然视频生成能力是MiniMaxWeek第二天的重头戏,但之前就展现出端倪,因为Hailuo 02视频模型出现在AI视频竞技场中,并且迅速拿下了图生视频排行榜第二名。

昨天,他们开源了MiniMax-M1,作为全球首个开源大规模混合架构的推理模型,引发了不小的关注。

它原生支持100万token的输入长度,是DeepSeek R1的约8倍;同时支持8万输出token,超过Gemini 2.5 Pro的6.4万,成为世界最长输出;生成10万token时,推理算力只需要DeepSeek R1的25%。

而这种效能的背后,核心还是MiniMax在架构层面的创新。

MiniMax在技术报告中称,独创的以闪电注意力机制为主的混合架构,从而在计算长的上下文输入以及深度推理的时候显著高效。

例如,在用8万Token深度推理的时候,只需要使用DeepSeek R1约30%的算力。这个特性使得我们在训练和推理的时候都有很大的算力效率优势。

以及MiniMax提出了更快的强化学习算法CISPO,通过裁剪重要性采样权重(而非传统token更新)提升强化学习效率。MiniMax援引AIME的实验结果,表示这比包括字节近期提出的 DAPO 等强化学习算法收敛性能快了一倍,显著的优于 DeepSeek 早期使用的 GRPO。

也是上述两大底层技术创新,让MiniMax能够在整个强化学习阶段只用到512块H800三周的时间,租赁成本只有53.47万美金——折合380多万人民币。

而就在底层架构创新带动长上下文推理效果展现后,MiniMax的新成果第二弹又在视频生成领域交出了堪称惊艳的成绩单。

看起来DeepSeek冲击带来的大模型变局中,MiniMax不仅没有放缓基础模型能力创新,反而进一步强化和加强了。

而就目前两大成果来看,MiniMax的研发实力和技术底气也在得到证明。

接下来三天,还能有什么方向的成果?

语音?生图?AI编程?

(文:量子位)