Hugging Face

Hugging Face

社区供稿 | Hugging Face 又出新教程啦!手把手教你构建 DeepSeek-R1 推理模型

间进行了学习,下面是整理的课程内容

课程链接:

https://hf.co/learn/nlp-co

从文件到块: 提高 Hugging Face 存储效率

Hugging Face 使用基于 Git LFS 的存储方案在 GitHub Hub 上存储模型、数据集和 Spaces。Xet 团队提出了一个创新的解决方案——基于内容的分块 (CDC),通过只传输变化的数据块来提升存储效率和迭代速度,目前该技术已应用于多个仓库,并实现了数据去重。

让 LLM 来评判 | 设计你自己的评估 prompt

第三篇《让LLM来评判》系列文章总结了评估模型的通用设计原则,包括清晰的任务描述、精细的评分标准、加入推理步骤和明确输出格式等。同时,也提到使用成对比较、引用参考内容及思维链等方式提升评估准确性,并探讨了奖励机制和社区机制的作用。

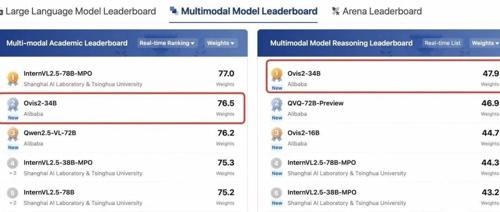

社区供稿 | 阿里国际 Ovis2 系列模型开源: 多模态大语言模型的新突破

Ovis2是阿里巴巴提出的新型多模态大模型架构,显著提升了小规模和大规模模型的能力密度,并增强了思维链推理能力、视频处理能力和多语言OCR能力。它已在OpenCompass上展示了卓越的性能,并在多个数学推理榜单中排名前列。

让 LLM 来评判 | 奖励模型相关内容

奖励模型通过学习人工标注的成对 prompt 数据来预测分数,用于评估语言模型的表现。它们比传统LLM评估模型更快速且具有确定性,但需要特定微调和考虑位置偏差影响。