机器学习算法与自然语言处理

机器学习算法与自然语言处理

多模态推理新思路:D2I框架如何让模型“深思熟虑”又“直觉敏锐”?

本文介绍了一种名为 Deliberate-to-Intuitive (D2I) 的推理框架,旨在提升多模态大型语言模型(MLLMs)在复杂推理任务中的表现。通过在训练阶段采用深度推理策略,并在测试阶段允许模型自由生成答案,显著提升了多模态模型的推理能力,同时保持了训练的高效性和可扩展性。

PERK:长文本推理的“加速器”,效率与性能双提升

MLNLP社区介绍其论文《PERK: Long-Context Reasoning as Parameter-Efficient Test-Time Learning》,提出了一种通过轻量级适配器在测试时学习长文本上下文的方法,显著降低了训练时的内存需求并提高了长文本推理性能。

打破“思考陷阱”:DuP-PO算法让AI推理更高效

MLNLP社区致力于促进国内外自然语言处理与机器学习领域内的交流合作。近期,一篇名为《Do Thinking Tokens Help or Trap? Towards More Efficient Large Reasoning Model》的论文探讨了大型推理模型在简单任务中的过度思考问题,并提出了一种新算法DuP-PO以提高模型效率。

大型语言模型的“推理升级”:自适应策略让AI更聪明

MLNLP社区发布了一篇关于提升大型语言模型复杂推理能力的研究论文《MixtureofReasoning》。文章提出一种新的训练框架MoR,使模型能够自主选择和应用多种推理策略,显著提升了模型在多个数据集上的表现。

多模态数学推理新突破:多样化视角让模型“开窍”!

MLNLP社区发布了关于多模态数学推理的研究论文《Multimodal Mathematical Reasoning with Diverse Solving Perspective》。该研究提出了一种新的数据集MathV-DP,以及基于Qwen-VL模型的Qwen-VL-DP,旨在提升大型多模态语言模型在数学推理任务中的表现,并强调了从多样化的解题视角学习的重要性。

注入错误,激活潜能:Self-Correction Bench的神奇魔力

MLNLP社区发布论文《SELF-CORRECTION BENCH: REVEALING AND ADDRESSING THE SELF-CORRECTION BLIND SPOT IN LLMS》,系统研究LLMs的自我修正盲点,并提出解决方案,揭示了LLMs在实际应用中的可靠性限制。

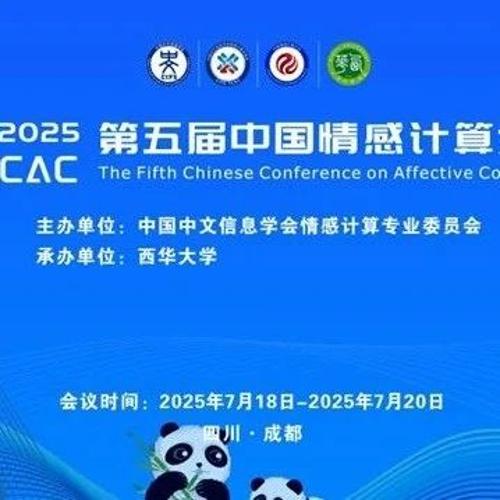

还剩1天!|CCAC2025早鸟优惠即将截止,这场情感智能盛宴不容错过!

第五届中国情感计算大会将于7月18日至20日在成都举行,旨在促进情感智能领域的学术与技术交流。会议将涵盖特邀报告、青年科学家论坛等形式,汇聚全球专家学者和产业精英。