神经网络

关于神经网络的一些思考与感受

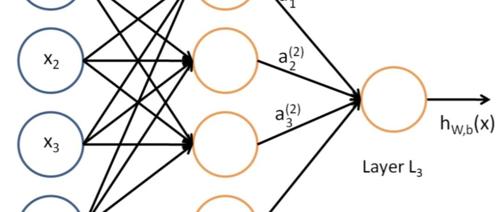

文章讲述了神经网络模型的重要性以及设计不同类型模型来解决不同问题的必要性。文章还提到了训练数据的质量和使用TensorFlow或PyTorch框架的技术实现,强调了实践对于理解神经网络运作机制的重要性。

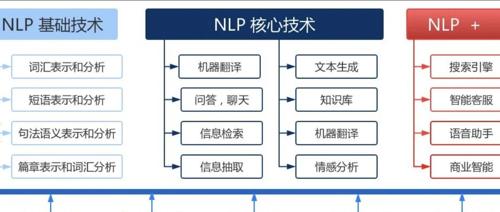

你知道自然语言处理(NLP)能解决哪些问题吗?即自然语言处理任务分类有哪些?

文章介绍了自然语言处理的四大主要任务类型:分类任务(如主题分类、情感分析)、生成式任务(如机器翻译、文本摘要和对话生成)以及序列标注任务(如分词、词性标注、命名实体标注和词义角色标注)。

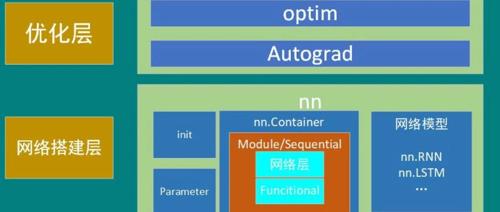

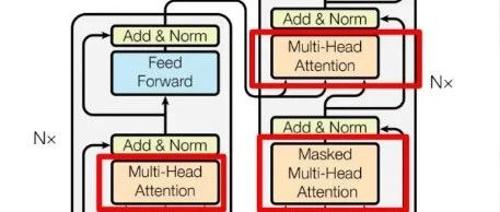

神经网络技术栈介绍——PyTorch,Transformer,NLP,CV,Embedding

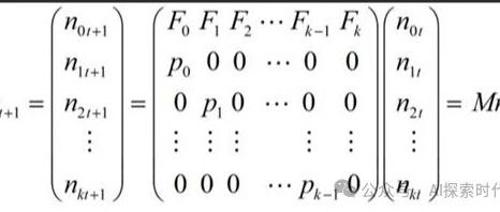

文章介绍了神经网络的基本概念及其在不同任务领域中的应用,包括RNN、CNN和Transformer等模型。指出PyTorch和TensorFlow是实现这些思想的具体工具,并强调了神经网络与自然语言处理(NLP)和计算机视觉(CV)任务结合的重要性。同时提醒学习者不要过分依赖神经网络技术来解决NLP和CV的问题。

Skyworks 推出AI Dialog Boost 嵌入式软件语音清晰度解决方案

Skyworks公司推出AI Dialog Boost软件解决方案,显著提升电影对白清晰度而不降低整体音质,适用于多种媒体播放和捕捉设备。

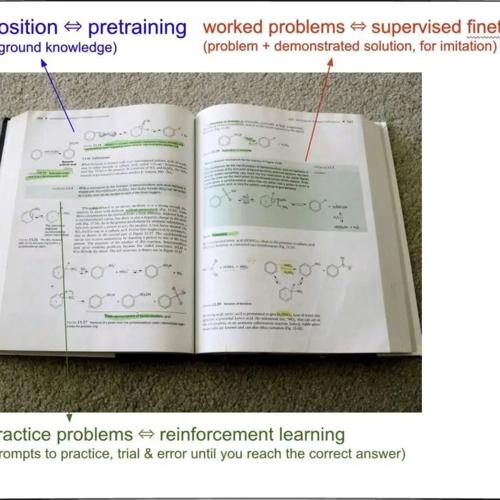

怎么学习设计和训练一个大模型——也就是神经网络?

设计大模型需要先从技术点切入。建议初学者选择合适的工具(如PyTorch框架)和理论(如Transformer架构),专注于学习一种技术方向,并逐步理解其核心思想。

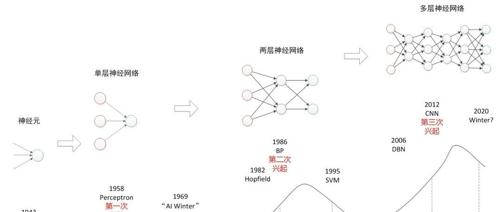

什么是神经网络?神经网络开发框架——PyTorch和架构Transformer的区别和联系

在文章中提到,通过PyTorch框架可以实现神经网络模型,并且PyTorch作为科学计算框架,主要用于进行数学运算。同时,文章也强调了Transformer架构的重要性及其与PyTorch的关系。总的来说,它说明了如何借助工具(如PyTorch)来构建和运行神经网络,并依靠理论(如Transformer)来指导其有效运作。