Datawhale分享

复现:顿悟时刻,编辑:新智元

复刻DeepSeek的神话,还在继续。

之前,UC伯克利的博士只用30美元,就复刻了DeepSeek中的顿悟时刻,震惊圈内。

这一次,来自荷兰阿姆斯特丹的研究人员Raz,再次打破纪录,把复刻成本降到了史上最低——

只要10美元,就能复现DeepSeek顿悟时刻!

Raz本人也表示,自己惊讶极了。

即使是一个非常简单的强化学习设置,并没有太多RL算法的复杂性(比如PPO、TRPO、GRPO等),也能在有限的计算资源下产生涌现的结果。

在具体设计过程中,他特别考虑强化学习中LLM中的应用和传统强化学习问题(如机器人、Atari游戏等)在状态空间和动作空间的不同。

因此,Raz选择从非常简单的RL算法——Reinforce-Lite入手。

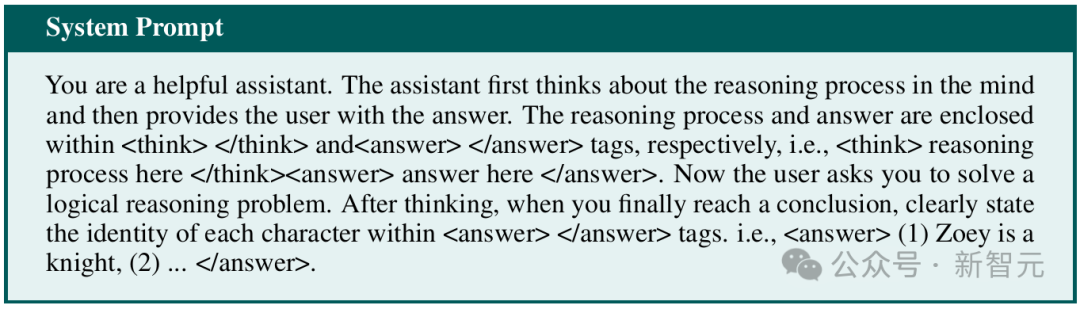

采用轻量级强化学习算法——Reinforce-Lite生成的推理过程之一。我们将一步步看到,端到端的强化学习微调模型如何表现出智能、回溯、自我反思、逻辑推理等迹象

结果,令人出乎意料的事情发生了:只用不到10美元的成本,他就在一个3B模型上复刻了DeepSeek的顿悟时刻。

几乎就像是这个3B模型本身就具备了做出惊人事情的潜力,我们需要的,只是通过正确的方式赋予它一定的自主性而已。

接下来,让我们看一下Raz的博客,感受一下这次超经济实惠的AI推理,是怎样突破的。

复刻DeepSeek顿悟时刻,只用不到10美元

我们能否在计算资源有限(只有48GB RTX6000显卡和10美元)的情况下,让一个3B模型具备回溯、自我反思、逻辑推理等推理能力?

研究人员猜测,通过强化学习也许能做到。

强化学习是最强大的学习算法之一,它一次又一次地为我们带来令人惊叹的成果。

DeepMind的AlphaGo、OpenAI的DOTA 2、MuJoCo和Atari实验、LLM的RLHF对齐,以及最近DeepSeek全面布局的RL技术,无比证明它的强大威力。

然而,由于RL有许多动态部分,一涉及到众多组件,强化学习就变得复杂了。

在此过程中,强化学习需要精心设计重要元素,如合适的信用分配机制、演员-评论员的适当超参数调整、强化学习算法类型(基于模型/无模型)等,这就导致了强化学习在更广泛的范围内应用受限。

如果在LLM环境中使用强化学习,可能涉及的模型可以多达5个:

-

策略模型:正在训练的模型

-

旧策略模型:用于计算替代目标

-

参考模型:用于计算KL散度(KL-divergence)

-

奖励模型:用于学习奖励函数

-

评判模型:用于计算价值函数

Reinforce-Lite:一个比PPO更简单、更稳定且更高效的微调方案

3B模型端到端强化学习训练的计算需求

由于涉及众多组件,不仅带来了计算负担,还带来了训练稳定性方面的复杂性和挑战。

因此,研究人员开始思考:能否从零开始重新构想整个算法,回归第一性原理?

他们的答案就是——一个简单的替代方案,Reinforce-Lite。

这种方法消除了对替代目标比率和旧策略模型的需求,通过单一策略神经网络来稳定训练过程,同时,还能为模型注入推理能力。

为此,我们需要理解的第一个问题就是——

使用替代目标比率(如PPO/GRPO)是过度优化?

-

移除KL散度,不需要参考模型 ❌ ——改用梯度裁剪。虽然不是自适应的方法,但能有效完成任务。 -

移除替代目标,不需要旧策略模型 ❌ -

使用分组相对奖励进行优势计算(类似DeepSeek的GRPO方式),不需要价值网络 ❌

def reinforce_lite(batch, policy_model, tokenizer, device, step, save_dir):policy_model.train()targets = zip(*batch)batch_size = len(prompts)evaluated_group = 0all_logprobs = []all_rewards = []all_responses = []all_lengths = []for group_idx in range(config.GROUP_SIZE):formatted_prompts = [format_prompt(p, tokenizer) for p in prompts]inputs = tokenizer(formatted_prompts,return_tensors="pt",padding=True,truncation=True,max_length=config.MAX_SEQ_LENGTH).to(device)generate_kwargs = {**inputs,: config.MAX_NEW_TOKENS,: True,: 0.7,: 0.9,: tokenizer.pad_token_id,: True,}if group_idx == evaluated_group:generated = policy_model.generate(**generate_kwargs)generated_ids = generated.sequencesoutputs = policy_model(generated_ids,attention_mask=(generated_ids != tokenizer.pad_token_id).long())prompt_length = inputs.input_ids.shape[1]response_length = generated_ids.shape[1] - prompt_lengthif response_length > 0:logits = outputs.logits[:, prompt_length-1:-1, :]response_tokens = generated_ids[:, prompt_length:]log_probs = torch.log_softmax(logits, dim=-1)token_log_probs = torch.gather(log_probs, -1, response_tokens.unsqueeze(-1)).squeeze(-1)sequence_log_probs = token_log_probs.sum(dim=1)else:sequence_log_probs = torch.zeros(batch_size, device=device)else:with torch.no_grad():generated = policy_model.generate(**generate_kwargs)sequence_log_probs = torch.zeros(batch_size, device=device)responses = tokenizer.batch_decode(:, inputs.input_ids.shape[1]:],skip_special_tokens=True)rewards = torch.tensor([get_reward(resp, tgt) for resp, tgt in zip(responses, targets)], device=device)all_responses.extend(responses)all_rewards.append(rewards)all_logprobs.append(sequence_log_probs)for r in responses])rewards_tensor = torch.stack(all_rewards)logprobs_tensor = torch.stack(all_logprobs)evaluated_rewards = rewards_tensor[evaluated_group]others_rewards = torch.cat([:evaluated_group],:]dim=0)baseline = others_rewards.mean(dim=0)advantages = (evaluated_rewards - baseline) / (others_rewards.std(dim=0) + 1e-8)advantages = torch.clamp(advantages, -2.0, 2.0)policy_loss = -(logprobs_tensor[evaluated_group] * advantages.detach()).mean()return policy_loss, rewards_tensor.mean().item(), policy_loss.item(), 0.0, all_responses[0], all_lengths

初始化一个经过指令微调的LLM,并通过合适的提示词使其在 <think></think> 标签中包含推理步骤。

为模型输出定义一个奖励函数(例如,在GSM8K基准中的正确率)。通过正则表达式从标签中提取数值,并与数据集中的实际答案进行比较。

通过直接计算相对于奖励的梯度来优化策略,无需使用替代损失函数。

采用分组相对归一化优势计算值,从而消除对批评模型的依赖。采用10作为分组大小。

使用标准的对数概率梯度技巧对模型进行更新

GSM8K数据集

为了验证自己的假设,研究人员将使用GSM8K,这是一个包含小学数学问题及其答案的Grade School Math 8K数据集,格式如下: 问题:Natalia在4月份向她的48个朋友卖出了发夹,而在5月份她售卖的发夹数量是4月份的一半。Natalia在4月和5月总共售卖了多少个发夹?

Natalia sold clips to 48 of her friends in April, and then she sold half as many clips in May. How many clips did Natalia sell altogether in April and May? 答案:Natalia在5月售卖了48/2 = <<48/2=24>>24个发夹。Natalia在4月和5月总共售卖了48+24 = <<48+24=72>>72个发夹。#### 72

Natalia sold 48/2 = <<48/2=24>>24 clips in May. Natalia sold 48+24 = <<48+24=72>>72 clips altogether in April and May. #### 72 虽然答案中就包含了完整的推理步骤,但让研究人员感兴趣的,只有###后的最终答案。 对此,研究人员引导策略模型,以<answer></answer>格式输出了最终答案,并用它来验证模型计算的答案是否正确。 这更像是一个蒙特卡洛问题——在每个回合结束时,才能获得奖励。 def format_prompt(question: str) -> str:return f"""<|begin_of_text|><|start_header_id|>user<|end_header_id|>Solve this math problem: {question}Show your reasoning first in <think tags>, then put the final answer in \\boxed{{}}.奖励建模

研究人员把奖励机制设计得很简单易懂,对于策略模型:

-

答案错误时,给予负奖励-1 -

答案正确时,给予正奖励+1

def get_reward(completion: str, target: str) -> float:reward = -1.0try:completion = completion.strip()start_tag = "<answer>"end_tag = "</answer>"start_idx = completion.rfind(start_tag)if start_idx != -1:substring_after_start = completion[start_idx + len(start_tag):]end_idx = substring_after_start.find(end_tag)if end_idx != -1:answer = substring_after_start[:end_idx].strip()if not answer and end_idx > 0:answer = substring_after_start[:end_idx].strip()numbers = ''.join(char for char in answer if char.isdigit() or char == '.')if numbers:generated_num = float(numbers)target_num = float(str(target).strip())if abs(generated_num - target_num) < 1e-6:reward = 1.0except Exception as e:passreturn reward训练设置

接下来,研究人员使用Reinforce-Lite算法,在RTX A6000显卡上训练了3B模型,训练时间为12小时,并采用大小为10的分组。 在训练初期,可以观察到:模型不断尝试增加输出序列/输出token的长度,但会经常遇到内存溢出(OOM)问题,这就限制了模型尝试更长的推理过程,并从中有效学习。 奖励图表展示的是分组响应的平均得分。理想情况下,平均值越接近1,表示模型在大多数采样响应中的准确率越高。 在这次实验中,研究人员只训练了数百次迭代,可以观察到当策略模型尝试不同策略时,得分会出现一定波动。 这种波动可以通过熵正则化来平衡探索与利用之间的关系,这是他们未来探索的一个方向。 对比测试Reinforce-Lite和Instruct模型

研究在GSM8K数据集上评估了Reinforce-Lite,发现在有限训练时间内,Reinforce-Lite相比指令模型在得分上实现了小幅提升。 具体来说,Meta Llama 3.2模型提升了2.0%(从70.5提升至72.5),而在FP16格式下运行的Phi 3.5 Instruct则提升了0.6%(从83.4提升至84.0)。 推理轨迹分析

观察一些推理轨迹后可以发现,经过Reinforce-Lite微调的模型展现出了多种推理能力,包括:

-

逻辑思维 -

搜索策略 -

结果验证 -

通过表格进行中间计算 -

试错方法等

关键要点总结

-

结构化推理能力提升 从生成的序列中可以观察到,经过RL微调的模型在评估得分上实现了小幅提升。

-

简化算法复杂度,无需PPO的复杂性 研究表明,对LLM进行微调只需要一个策略网络即可,无需采用PPO的复杂机制。

-

优化计算效率 Reinforce-Lite作为一个计算友好型算法,支持端到端的RL训练,同时显著降低了训练复杂度。

-

增强模型自主性 算法成功地赋予了LLM自主能力,让模型会通过尝试不同策略来获取奖励。

-

更长的推理回合,需要更多内存 随着训练的进行,可以发现模型倾向于进行更长的推理过程,但在使用48GB GPU训练3GB模型(FP16)时,如果超过1024个token,就会频繁出现内存溢出问题。

-

在没有KL散度的情况下确保稳定性 研究人员发现,使用简单的梯度裁剪就能有效替代KL散度计算,这是一种高效的替代方案,用于防止策略偏离。在整个训练过程中,模型策略保持稳定,未出现剧烈波动。

DeepSeek-R1启发,7B模型实现高级推理技能

-

一个着重强调思考和回答过程的system prompt -

一个用于惩罚取巧输出的严格格式奖励函数 -

一个能实现稳定收敛的简单训练方案

问题:一个非常特殊的岛屿上只住着骑士和骗子。骑士总是说真话,骗子总是说谎。你遇到两位岛民:Zoey和Oliver。Zoey说:「Oliver不是骑士。」Oliver说:「Oliver是骑士且Zoey是骗子。」请问,谁是骑士,谁是骗子?

-

更长的回答并不能保证更好的推理。长度本身不是评估训练时间的有效指标。最有效的推理来自最短路径。

-

语言混合会阻碍推理。这一观察强调了在奖励建模中需要语言一致性惩罚。

-

增加「思考」token确实有帮助。RL训练自然地提高了与反思相关词汇的频率,表明某些token频率与性能之间存在相关性。

-

监督微调(SFT)依赖记忆;RL实现泛化。SFT严重依赖记忆,往往导致表面的捷径学习,而RL则在最小依赖数据集结构的情况下自我演化。

-

冷启动是一个优势,但非必需。无论是从基础模型还是指令模型开始,训练动态都保持惊人的相似性,尽管后者表现略好。

-

课程学习仍然重要。在固定的数据筛选比例下,精心设计的课程学习方法总是优于随机打乱。

https://medium.com/@rjusnba/overnight-end-to-end-rl-training-a-3b-model-on-a-grade-school-math-dataset-leads-to-reasoning-df61410c04c6

(文:Datawhale)