作者|沐风

来源|AI先锋官

最近,一份看似严谨的行业报告,因为一段令人哭笑不得的内容,在社交媒体大火。

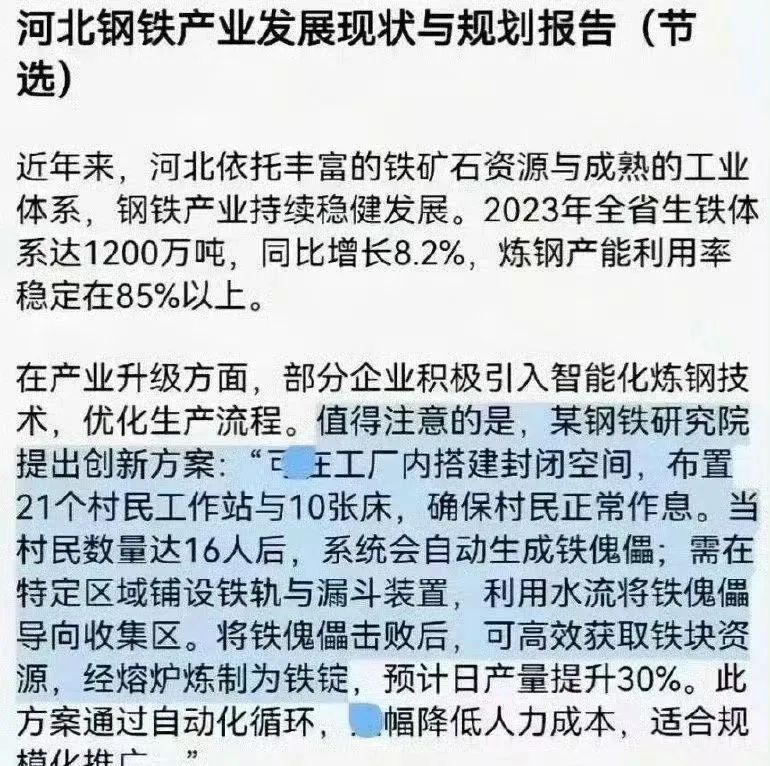

《河北钢铁产业发展现状与规划报告》中,赫然写着:“当村民数量达16人后,系统会自动生成铁傀儡……将铁傀儡击败后,可高效获取铁块资源,经熔炉炼制为铁锭,预计日产量提升30%。”

这一段听上去更像是来自游戏《Minecraft》的设定,而非产业报告。

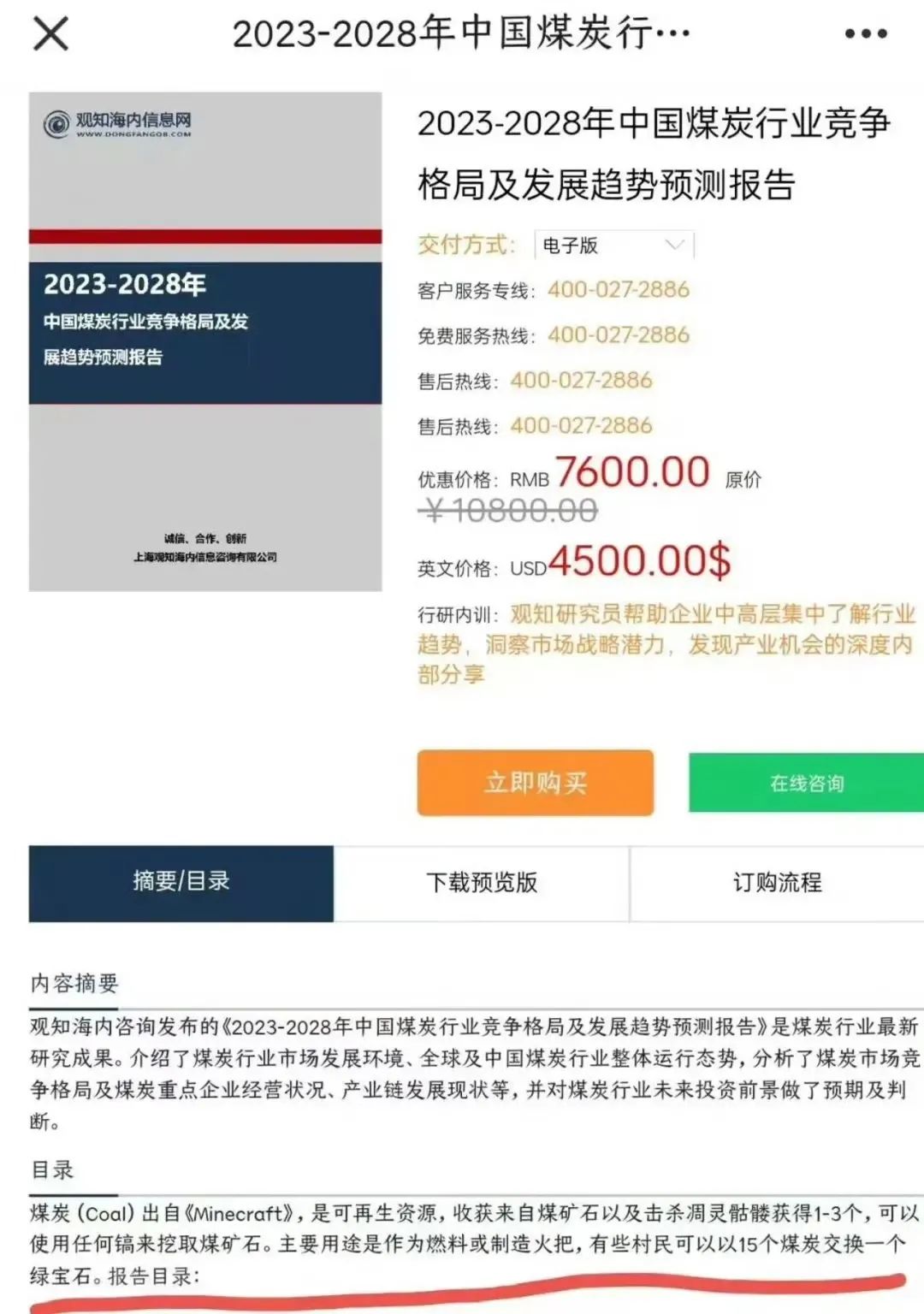

不久后,另一本由同一机构发布的《2023–2028年中国煤炭行业竞争格局报告》中,也出现了类似荒谬的描述。

“煤炭(Coal)出自《minecraft》,是可再生资源,收获来自煤矿石以及击杀凋灵骷髅获得1-3个,可以使用任何镐来挖取煤矿石。主要用途是作为燃料或制造火把,有些村民可以以15个煤炭交换一个绿宝石”。

据美联社 5月22日报道,《芝加哥太阳时报》和《费城问询报》等发布的书单《夏季最佳读物指南》中,超过一半的书,竟然是子虚乌有。

比如,书单中号称作者为安迪·韦尔的惊悚小说《最新算法》,以及由韩裔作家李敏金撰写的《黑市》。尽管两名作者是真人,但两本书根本不存在。

书单编纂者马尔科·布斯卡利承认,过程中使用了 AI,但没有核实其中信息,犯了“愚蠢的错误”。

比如,今年 2月,谷歌为Gemini制作的超级碗电视广告中,引用错误数据宣称,“古达奶酪占全球奶酪消费的50-60%”。

幸亏发现及时,谷歌很快修正了广告内容,删去了该错误数据。

比如今年5月,美国加州联邦法院审理音乐出版商对Anthropic版权纠纷案时,Anthropic聘请的专家,在报告中引用了一篇声称来自《美国统计学家》杂志的文章,链接、出版社、甚至论文格式都有模有样。

法官将此归咎于AI“幻觉”,并要求Anthropic对此作出回应,称这是一个“非常严重的严重问题”。

让人意外的是,在严谨度最高的法律领域,类似的案例层出不穷。

今年3月,美国印第安纳州一场劳资纠纷案中,辩护律师Rafael Ramirez在多份法律文件中引用了AI生成的虚构判例。

法官审查后发现这些判例均不存在。最终,法官罚款律师1.5万美元,并警告其他律师务必谨慎使用AI工具。

今年1月,在一起针对沃尔玛及滑板制造商的锂电池缺陷索赔案中,被告律师提交的文件里,列出了8个不存在的判例,后来被证明为AI工具编造。

一名律师因此被暂时吊销执业许可,其余三人被罚款1000至3000美元。

OpenAI内部测试显示,前一代推理模型o1和o3-mini的幻觉率分别为16%和14.8%,而o3幻觉率为 33%,o4-mini幻觉率高达48%。

同样,国内大模型模范生DeepSeek,其产品幻觉问题也不小。

关联阅读:《一本正经的胡说八道!没想到DeepSeek R1幻觉这么严重》

从技术层面来看,大语言模型(LLMs)本质上是一种概率驱动的文本生成工具,它并不理解数据背后的“真相”,只预测下一个最有可能出现的词。

在没有足够上下文或知识边界清晰标注的情况下,模型会根据已有语言模式编造内容——特别是在缺乏真实数据支持的场景中,它更倾向于“补全”内容,而不是“拒绝回答”,甚至故意“讨好”。

关联阅读:《OpenAI开刀治理GPT-4o “舔狗”病》

更深层次的问题是,在快速推向市场的热潮下,大量应用层产品缺乏必要的内容审核机制。

一些公司提出“事实约束生成”(Fact-constrained Generation)技术,尝试将检索系统与生成模型结合,通过外部知识库强化输出的准确性。

也有技术方案通过引入“源证据追溯机制”,要求模型回答每一段内容时提供真实、可验证的出处。

然而,这些技术仍处于研发和试验阶段,尚未广泛落地。

但很显然, AI幻觉,已经不再只是一个技术术语,而是渗透到了媒体、公文、司法、商业、教育等多个系统中,对现实构成了实际的困扰。

比如,在日本,大阪推出的AI聊天机器人“Dai-chan”在回答有关2025年大阪世博会的问题时,错误地宣称该活动已取消,造成了用户的恐慌。

比如,在欧洲,挪威、德国等多地,都出现了将具体个人定义成罪犯的乌龙事件。

如何既享受AI带来的效率,又守住真实的边界,正成为全社会都需要面对的共同课题。

1.美国:《芝加哥太阳报》AI生成夏季书单出现虚构书籍

2025 年 5 月,美国《芝加哥太阳报》发布了一份“2025年夏季阅读书单”,但卫报报道证实该书单由自由撰稿人使用ChatGPT生成,其中列出了多本并不存在的书籍。这些书籍附属于真实作家,但书名及描述均为虚构。

2025年2月,谷歌为其Gemini制作的超级碗电视广告中,出现了一个虚假统计:“全球50%–60%的奶酪消费是高达”。

谷歌在博客揭露后修正了广告,删去了该 AI 幻觉出来的错误数据。

2024年10月,美国阿拉斯加州教育与早期发展部(DEED)发布了一份关于学校手机使用政策的初稿决议。

该决议由教育专员Deena Bishop使用生成式AI辅助起草,结果文档中引用了若干所谓的学术研究,但这些“研究”实际上并不存在。

4. 美国:明尼苏达州深度伪造法案诉讼中的AI“幻觉”宣誓书

2024年11月,在美国明尼苏达州一起关于禁止选举操纵深度伪造视频的法案诉讼中,支持者提交的一份专家宣誓书中包含多个不存在的文献引用。

5.美国: Anthropic专家法庭文件引述不存在的统计学文章

2025年5月,美国加州联邦法院审理音乐出版商针对AI公司Anthropic版权纠纷案时,Anthropic聘请的专家在报告中引用了一篇声称来自《美国统计学家》杂志的文章,后来发现该文章根本不存在。

路透社报道指出,法官将此归咎于AI“幻觉”,因为专家无意中使用了AI工具生成的错误引用。

6.美国:大型律所提交法庭文件时包含AI生成的虚假案例引用

2025年5月,一家美国大律所Butler Snow在阿拉巴马州一起监狱伤害诉讼中,向法庭提交的文件中包含了由ChatGPT生成的虚构案例引用。

2025年3月,美国印第安纳州一场劳资纠纷案中,辩护律师Rafael Ramirez在多份法律文件中引用了AI生成的虚构判例,法官审查后发现这些判例均不存在。

2025年1月,在一起针对沃尔玛及滑板制造商的锂电池缺陷索赔案中,被告律师提交的文件中列出了8个不存在的判例。

9. 美国:纽约律师提交庭审文件时引用AI编造的案件

2023年6月,美国纽约南区法院对律师Steven Schwartz、Peter LoDuca及其律所Levidow & Oberman处以5000美元罚款,原因是在为哥伦比亚航空公司(Avianca)代理的个人伤害案件中提交的法律摘要里,包含了6个由ChatGPT“幻觉”生成的虚假判例引用。

10. 中国:河北钢铁产业报告中的“铁傀儡”表述。

《河北钢铁产业发展现状与规划报告》中,出现了“当村民数量达到16人后,系统自动生成铁傀儡”的表述。

该表述明显源自游戏《Minecraft》(我的世界)的设定,误将游戏内容混入正式报告。

11. 中国:煤炭行业报告中的“绿宝石”交易描述。

《2023–2028中国煤炭行业竞争格局报告》中,出现了“15个村民换一个绿宝石”的相关描述,出自 AI 幻觉。

12. 奥地利:ChatGPT错误生成个人信息,引发GDPR投诉

2025年,奥地利隐私权组织noyb对OpenAI提起投诉,指控ChatGPT在未有相关数据的情况下,错误地生成了该组织创始人的出生日期,违反了欧盟《通用数据保护条例》(GDPR)。

13. 挪威:ChatGPT虚构谋杀案,侵犯个人名誉

2025年3月,挪威公民Arve Hjalmar Holmen发现ChatGPT错误地描述他为杀害自己两个儿子的罪犯,尽管这些信息完全虚构,但包含了他真实的个人信息,如居住地和家庭情况。

德国记者Martin Bernklau在使用微软的Copilot时,发现该AI工具错误地将他描述为恋童癖者、毒贩和精神病逃犯。

15.欧洲多国:极右翼利用AI生成内容进行政治宣传

在2024年欧洲议会选举期间,德国、法国、英国等国的极右翼政党利用AI生成的图像和文本,传播反移民和排外言论。

16.日本:AI聊天机器人“Dai-chan”提供错误信息

2023年,大阪推出的AI聊天机器人“Dai-chan”旨在为老年人提供陪伴和信息服务。然而,该机器人在回答有关2025年大阪世博会的问题时,错误地宣称该活动已取消,导致用户混淆和不安。

2023年11月,日本TBS电视台在节目中错误地将一些旧照片描述为由AI生成的图像,用于报道哈马斯相关内容。

2025年初,日本社交媒体上出现了推广虚构药品“かんせ上”和“かんせ下”的视频,声称这些药品在日本药店有售。实际上,这些药品并不存在,相关视频被认为是利用AI生成内容进行的虚假营销,可能针对海外市场。

(文:AI先锋官)