谷歌太良心了,推出”gemini-fullstack-langgraph-quickstart”的开源项目,这个项目用Gemini 2.5模型与LangGraph框架的结合,主打快速构建一个能够本地运行的自主进行深度研究的智能代理系统

目前github已经飙升到3.5k星了,地址:

https://github.com/google-gemini/gemini-fullstack-langgraph-quickstart

这个项目展示了如何自己构建一个真正的”研究型AI代理”,能够像人类研究员一样工作:它会根据用户的问题动态生成搜索关键词,通过Google搜索获取信息,分析结果中的知识空白,然后迭代地优化搜索策略,最终提供有充分引用支持的答案

技术架构:前后端分离的现代设计

前端:React与现代开发体验

项目采用了React配合Vite构建工具的前端架构。Vite的选择体现了对开发效率的重视——它提供了极快的热重载功能,让开发者能够实时看到代码改动的效果。这种即时反馈对于调试复杂的AI交互界面特别重要,因为你需要频繁测试不同的用户输入场景

后端:LangGraph的强大编排能力

后端使用了LangGraph框架,这是一个专门为构建复杂AI工作流而设计的工具。LangGraph的核心优势在于它能够将AI的决策过程可视化和模块化。传统的AI应用往往是一个”黑盒”,而LangGraph让整个思考过程变得透明和可控

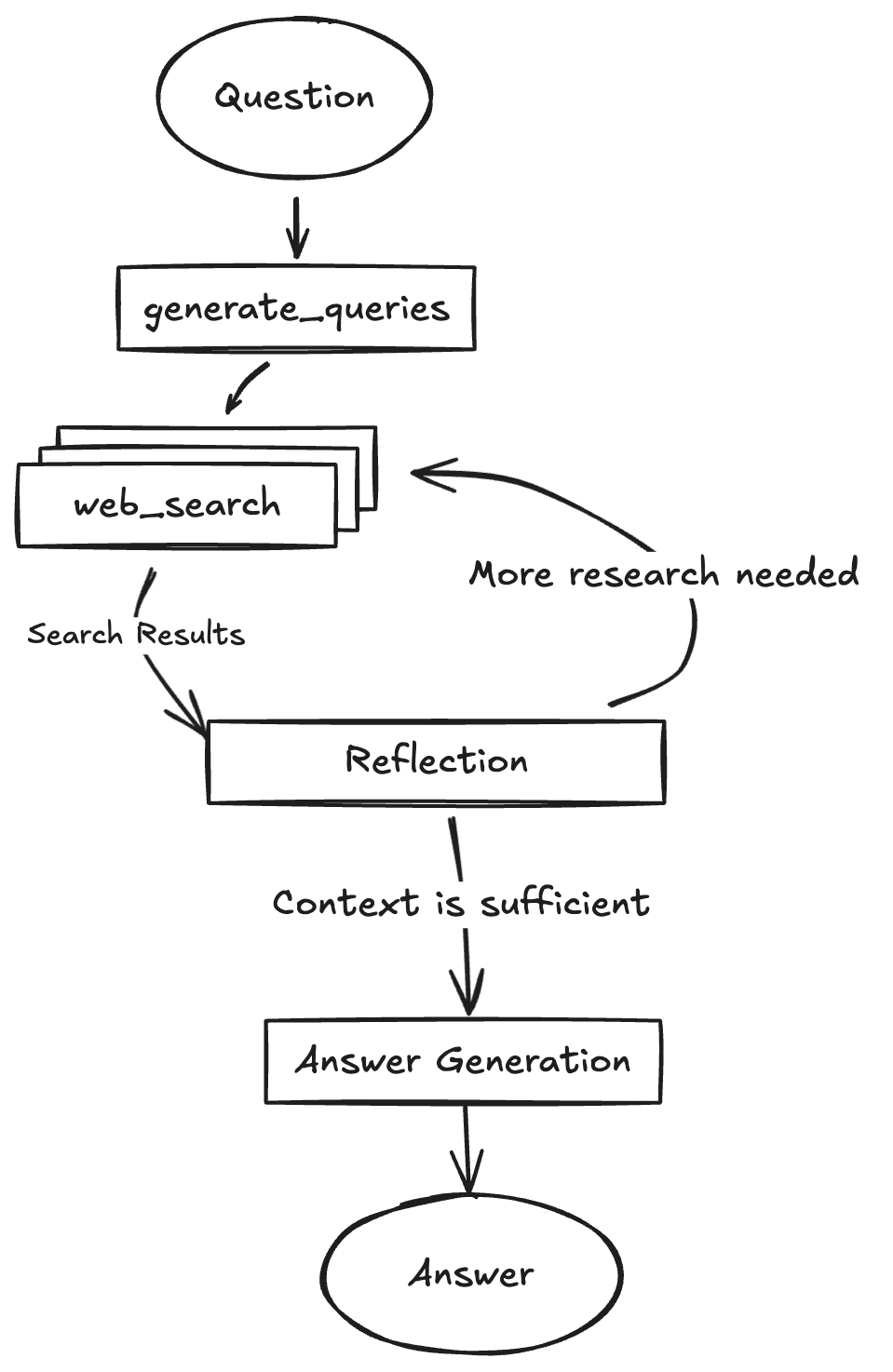

核心工作流程:五步智能研究法

深入一下这个AI代理的工作原理,这个过程可以分为五个关键步骤:

第一步:智能查询生成

当用户提出问题时,系统首先使用Gemini模型分析问题的深度和广度,然后生成一系列初始搜索查询。这个过程类似于一个经验丰富的研究员在开始研究某个主题时会思考的各个角度

比如,对于”可再生能源的未来发展”这个问题,系统可能会生成:

-

• “太阳能技术发展趋势” -

• “风能发电成本变化” -

• “储能技术突破” -

• “政策支持现状”

第二步:网络信息搜集

系统使用Google搜索API对每个生成的查询进行搜索,这一步的关键在于它不是简单地抓取搜索结果,而是使用Gemini模型来理解和提取每个网页中的关键信息。这种方式确保了信息的质量和相关性。

第三步:反思与知识缺口分析

这是整个系统最具创新性的部分。代理会分析已收集的信息,识别其中的知识空白或不一致之处。它会问自己:这些信息是否足够回答用户的问题?还有哪些重要的方面没有涉及?

这种反思能力让AI代理具备了类似人类专家的思维方式——不满足于表面信息,而是追求全面和深入的理解。

第四步:迭代优化搜索

如果发现知识缺口,系统会生成新的、更有针对性的搜索查询,然后重复搜索和分析过程。这个迭代过程有最大循环次数的限制,确保系统不会无限循环。

第五步:综合答案生成

最终,当系统认为收集的信息足够充分时,它会使用Gemini模型将所有信息综合成一个连贯的答案,并附上相应的引用来源。这确保了答案的可信度和可验证性

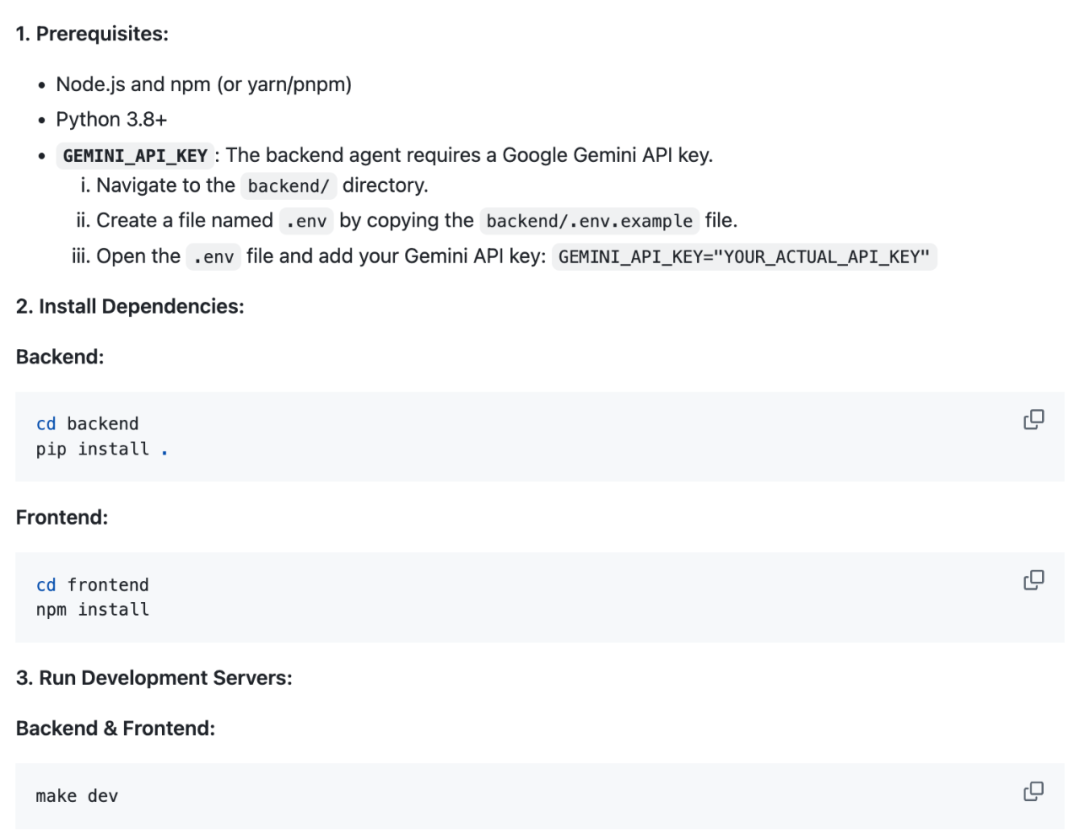

开发环境配置:实践中的考虑

项目的配置过程体现了现代软件开发的最佳实践。开发者需要准备Node.js环境用于前端开发,Python 3.8+用于后端服务,以及最重要的Google Gemini API密钥

API密钥的配置通过环境变量文件(.env)进行管理,这种方式既保证了安全性,又便于不同环境之间的切换。项目还提供了样例配置文件(.env.example),让新手开发者能够快速上手

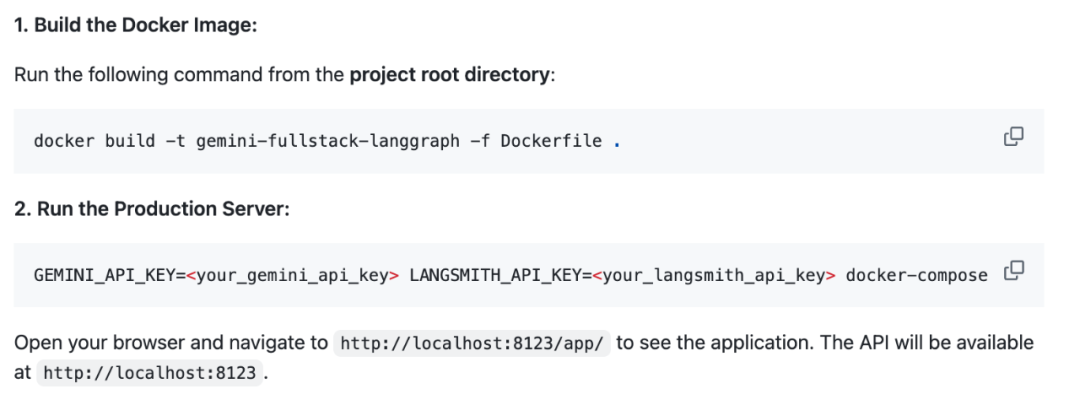

部署与扩展:生产环境的思考

项目包含了Docker配置文件,已经考虑了生产环境的部署需求。容器化部署不仅简化了环境配置,还为后续的扩展和维护提供了便利

同时,项目的模块化设计让开发者可以轻松地替换或增强某些组件。比如,你可以:

-

• 替换Google搜索为其他搜索引擎 -

• 增加更多的信息源 -

• 调整反思和迭代的逻辑 -

• 自定义答案生成的格式

写在最后

这个项目的价值不仅在于它提供了一个可工作的代码示例,更在于它展示了现代AI应用开发的几个重要趋势:

组合式AI架构:不是依赖单一的大模型,而是将多个AI能力组合起来,形成更强大的系统。

可解释性设计:通过LangGraph的可视化能力,让AI的决策过程变得透明和可调试。

迭代式信息处理:模拟人类的研究过程,通过多轮迭代来逐步完善答案质量。

实时信息整合:结合网络搜索,让AI能够获取最新的信息,而不局限于训练数据

⭐

(文:AI寒武纪)