新智元报道

新智元报道

【新智元导读】AI算力正以每9个月翻倍的速度激增!Epoch AI最新报告揭示:不到10年,顶级AI算力或将暴涨8万倍。谁在领跑?谁被甩出局?

世界首富马斯克与「前老板」特朗普公开决裂,互相揭短、公开互喷。

国际国内各媒体「围观吃瓜」,波兰外长甚至不无讽刺地挖苦马斯克。

这场风波,让人想起另一位与马斯克「恩怨未了」的人物——OpenAI CEO奥特曼。

当年马斯克与奥特曼之间的冲突,甚至比《甄嬛传》还要精彩。

现在,奥特曼再赢一次:这次马斯克和特朗普的决裂,最大的受益者可能还是奥特曼。

不过,要评选「AI圈最靓的崽」,马斯克无疑当之无愧——

他拥有2025年最强的AI算力系统:

xAI旗下的Colossus超算共采用20万块AI芯片,

硬件成本高达70亿美元,

功耗达300兆瓦,相当于25万户家庭的用电量。

这只是Epoch AI趋势研究报告的一角。

他们的研究报告揭示了AI算力的惊人趋势:

超级计算机算力9个月翻倍,

硬件成本和能耗则每13个月激增一倍!

按当前趋势,2030年的顶级AI超级计算机将需要:

200万个AI芯片,

2000亿美元投入,

9吉瓦电力功耗,相当于9座核电站的输出。

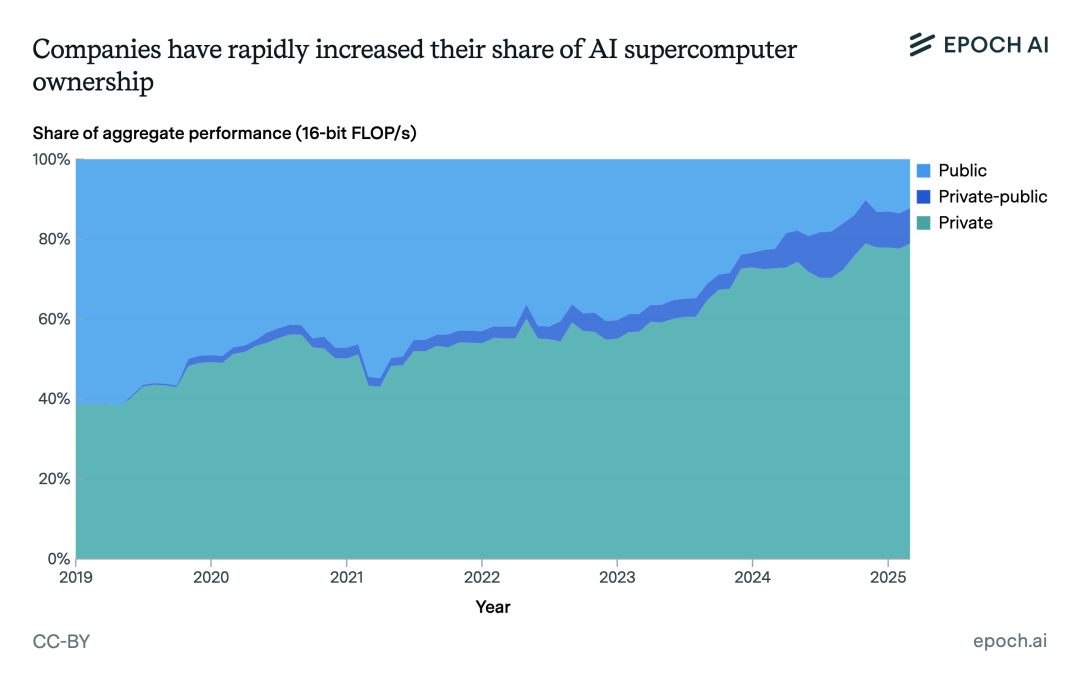

2019年,私营企业拥有全球40%的AI超级计算能力;到2025年,这一比例上升至80%。

左右滑动查看

如果当前趋势持续,到2030年,全球最强的AI超级计算机将具备:

·算力:2×10²²(16位浮点运算/秒)

·硬件规模:200万块AI芯片

·成本:2000亿美元

·功耗:9吉瓦(GW)

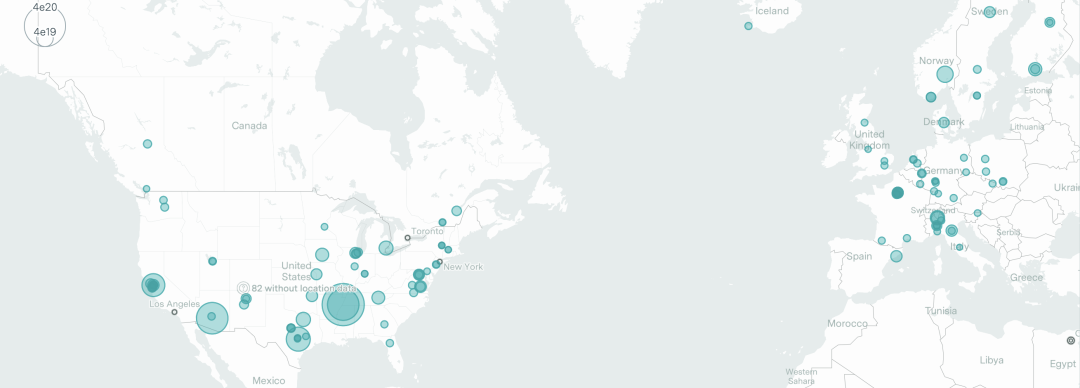

Epoch AI收集了2019至2025年间500台AI超级计算机的数据,并分析了其在性能、功耗、硬件成本、所有权和全球分布等方面的关键趋势。

论文链接:https://arxiv.org/abs/2504.16026v2

刚刚,他们还上线了AI超级计算机数据库。

在新数据库,可以查看700多个训练和推理集群的规格参数——

包括计算能力、芯片类型、功耗、所有权、位置等信息。

顶尖AI的发展依赖于强大的超级计算机,但针对这些系统的分析仍然有限。

在35个国家,研究团队追踪了配备专用AI芯片的集群,覆盖全球约15%的计算能力。

地图视图可以精确定位许多数据中心,直至具体街道地址!

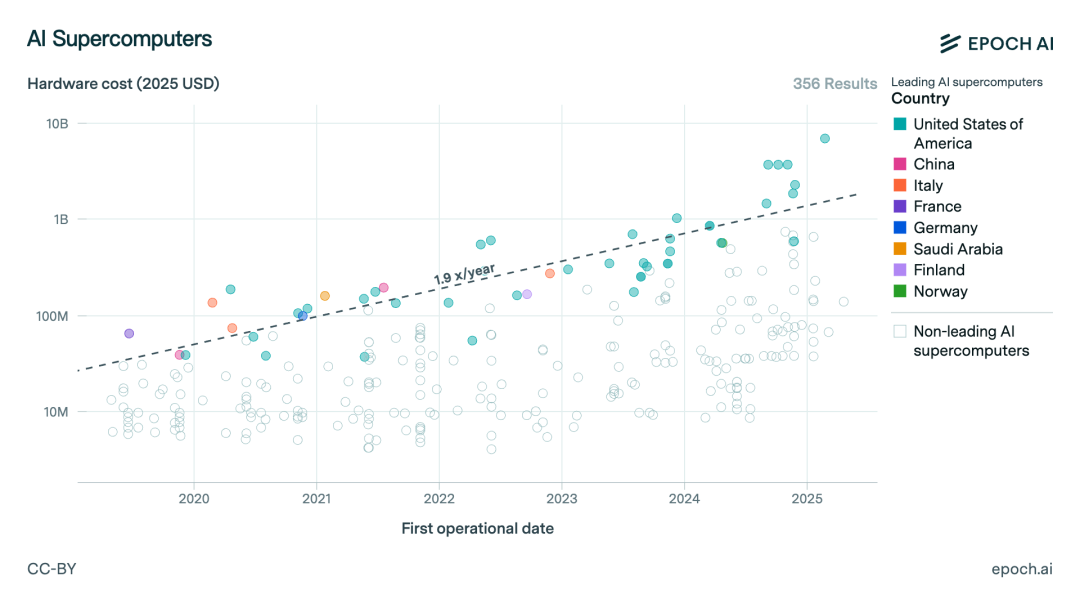

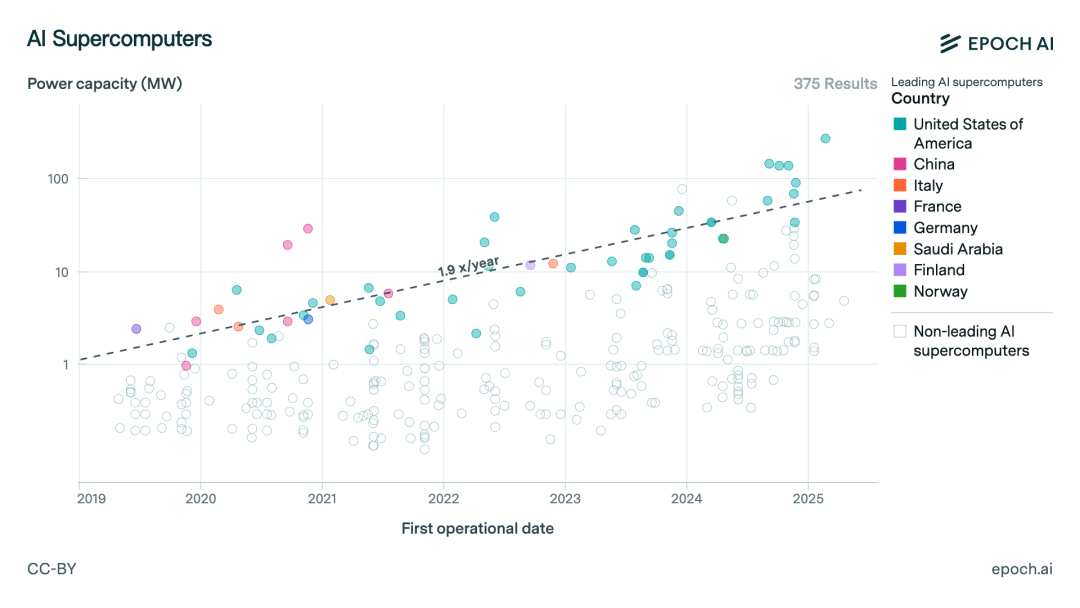

Epoch AI利用图表,揭示了顶尖AI算力的3大趋势:

(1)计算性能,每9个月翻一番。

(2)采购成本,每13个月翻一番。

(3)电力需求,每12个月翻一番。

此外,还有另外两个不容忽视的格局变化:

(1)私企主导AI超级计算机,马斯克的xAI拥有今年规模最大的AI超算;

(2)AI超级计算机总算力上,中国位居第二。

除了地图和图表外,数据库还提供表格视图,方便对数据进行排序、筛选、查看和下载。

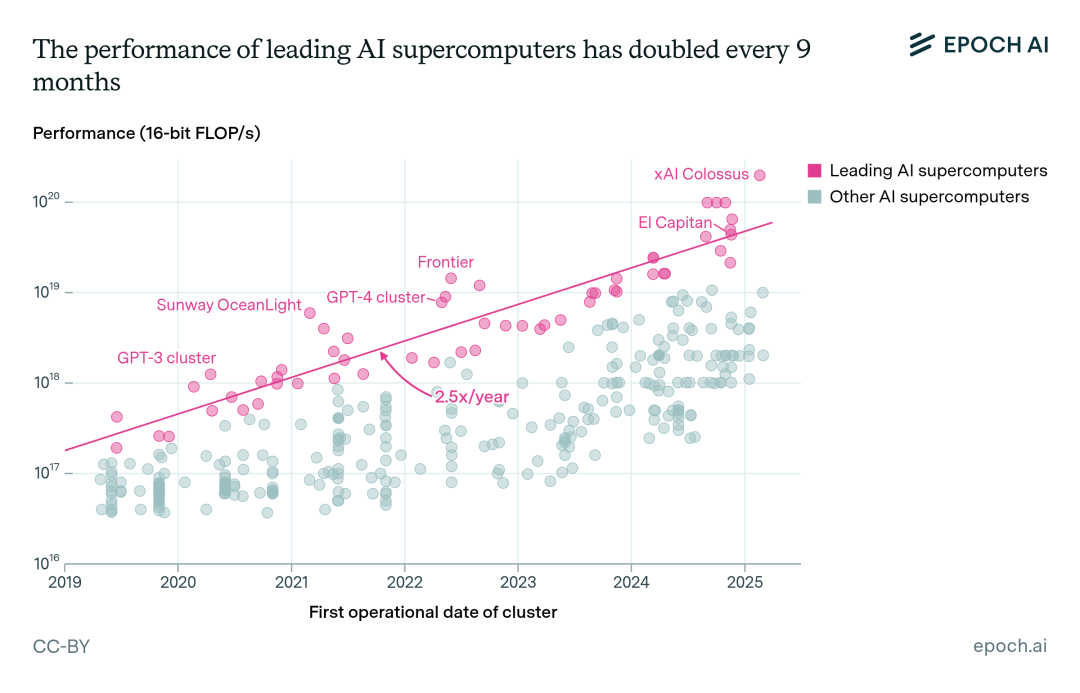

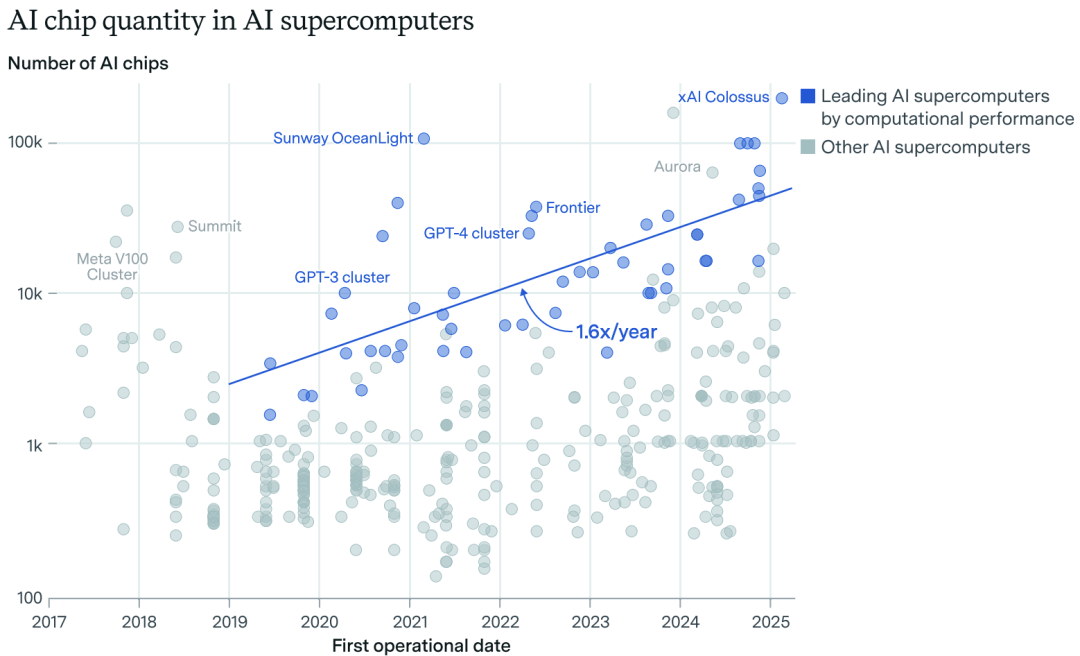

顶尖AI超级计算机的计算性能每九个月翻一番。

自2019年以来,顶尖AI超级计算机的计算性能每年增长2.5倍。

这使得训练运行的能力大幅增强:如果将2020年的GPT-3模型在xAI的Colossus上进行训练,原本需要两周的训练时间可缩短至不到两小时。

这种增长由两个因素驱动:

(1)每个集群中部署的芯片数量每年增长1.6倍;

(2)每颗芯片的性能也以每年1.6倍的速度提升。

首先,顶级AI超算的芯片数量每年增长1.6倍。

比如:2019年1月,最高纪录是橡树岭国家实验室的Summit系统,共有27,648块V100芯片。

而到2025年3月,已知规模最大的AI超算是xAI公司的「Colossus」系统,共有20万块H100和H200芯片。

若将2019年前的系统纳入统计,增长率可能下降,但由于数据收集始于2019年,该假设尚无法验证。

其次,顶级AI超算的单芯片计算性能每年提升1.6倍。

在研究期间,有三代芯片表现尤为突出:

2019至2021年间,V100占据绝对主导地位,贡献了超过90%的部署算力;

2021年A100开始崭露头角,到2023年已成为主流芯片,同期AMD MI250X和谷歌TPU v4仅占较小份额;

2023年H100迅速普及,截至2024年7月已占据数据集中总算力的50%以上。

领先AI超算的单芯片性能1.6倍(90%置信区间:1.5-1.7)的年提升速度,略高于AI芯片整体性能的提升水平——

FP32精度芯片年提升1.28倍(90%置信区间:1.24-1.32),

FP16精度芯片年提升1.38倍(90%置信区间:1.28-1.48)。

这一差异主要是因为AI超级计算机通常采用最先进的AI芯片,而非性能处于平均水平的芯片。

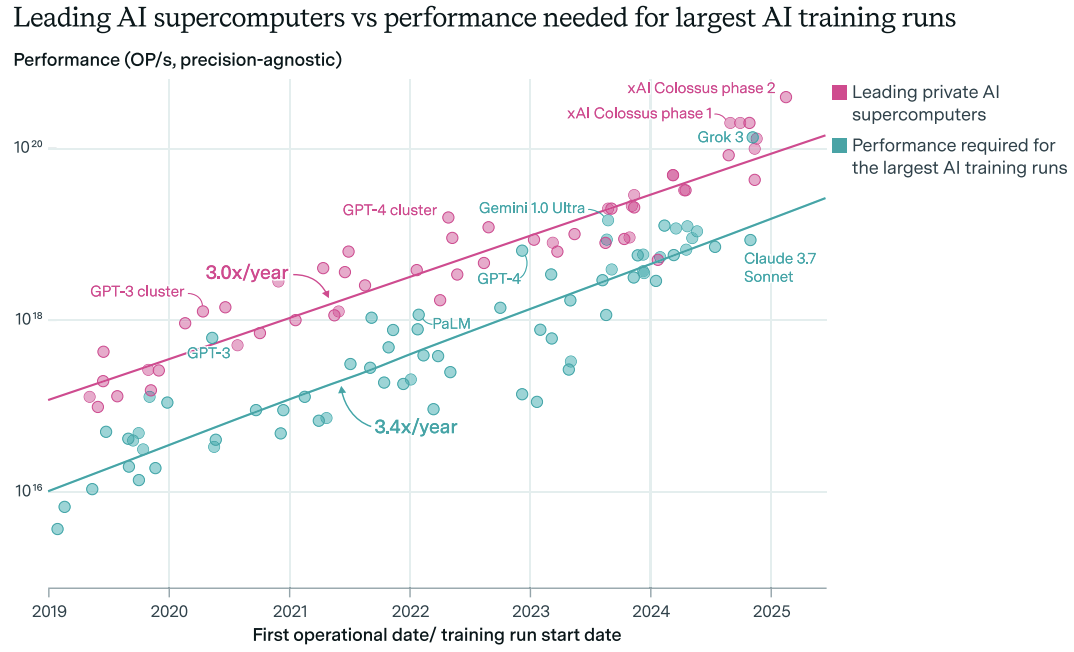

最大规模训练任务年增长率为4-5倍,而AI超级计算机与之保持同步。

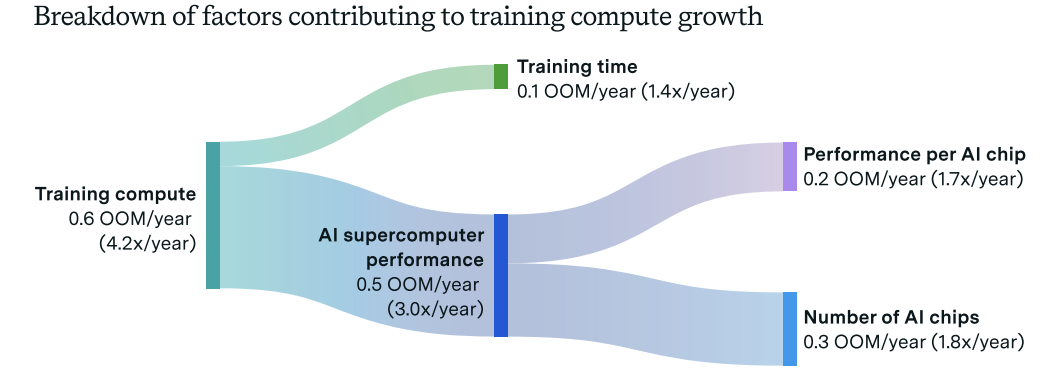

2024年,Sevilla与Roldan发现,2018至2024年间最大AI模型的训练算力需求以每年4.2倍(90%置信区间:3.6-4.9倍)的速度增长。

在考虑训练时长增加的因素后,这一数据与Epoch观察到的AI超算性能增长趋势相吻合。

论文链接:https://arxiv.org/abs/2403.17466

下图对比了最大规模AI训练任务所需的计算性能与数据集中领先AI超算的性能。

2019至2025年间,工业界最大规模的AI超算始终保持着最大AI训练任务所需算力10倍的性能优势(不包括最终训练前实验所需的计算资源)。

虽然最大训练任务所需的系统规模增长速度(3.4倍)略快于领先AI超算(3.0倍),但两种趋势的差异在统计学上并不显著(p=0.18)。

正如下图所示,AI超算的发展与训练算力需求的增长保持了一致。

训练计算量增长驱动因素概览

上图OOM表示数量级。AI超级计算机的指标基于私营部门系统,以及在各种数值精度下的最高计算性能。

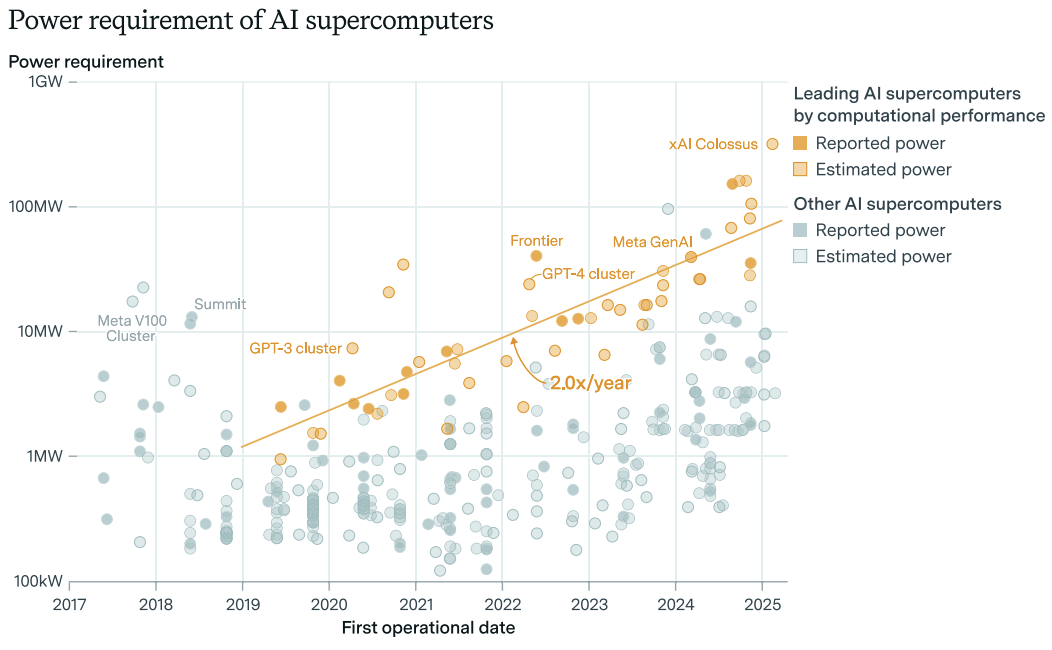

顶尖AI超级计算机的电力需求,每12个月翻一番。

领先的AI超级计算机使用的芯片数量越来越多,功耗越来越高,用于训练前沿模型的电力需求迅速增长。

2019年1月,橡树岭国家实验室的Summit是当时功率最大的AI超级计算机,功率为13兆瓦。

而如今,xAI的Colossus超级计算机使用高达280兆瓦的电力,是Summit的20多倍。

由于本地电网无法为如此庞大的硬件提供足够的电力,Colossus依赖于移动发电机来运行。

未来,为了解决向单一地点输送巨量电力的难题,可能会看到前沿模型在地理上分布的超级计算机之间进行训练,这种方式类似于Gemini 1.0的训练架构。

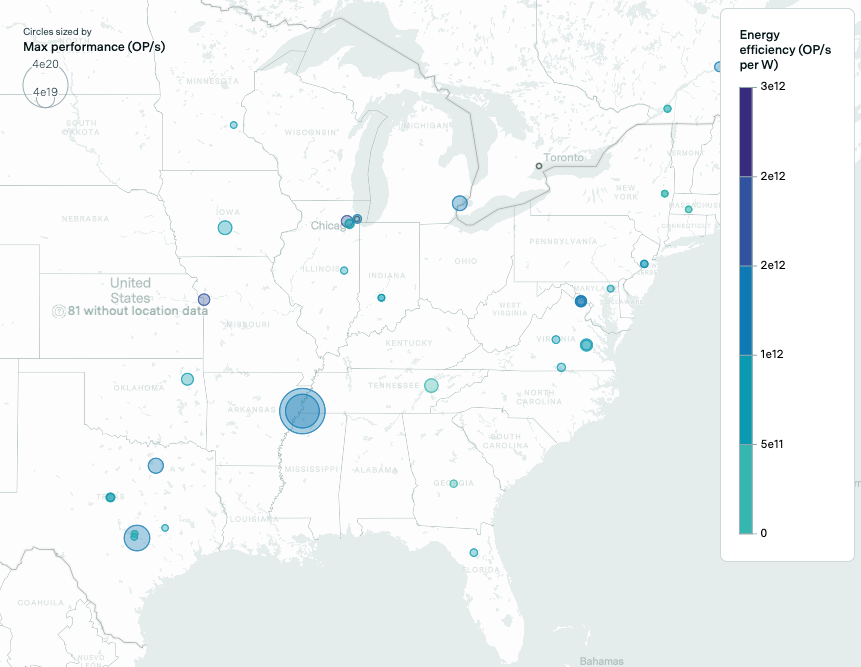

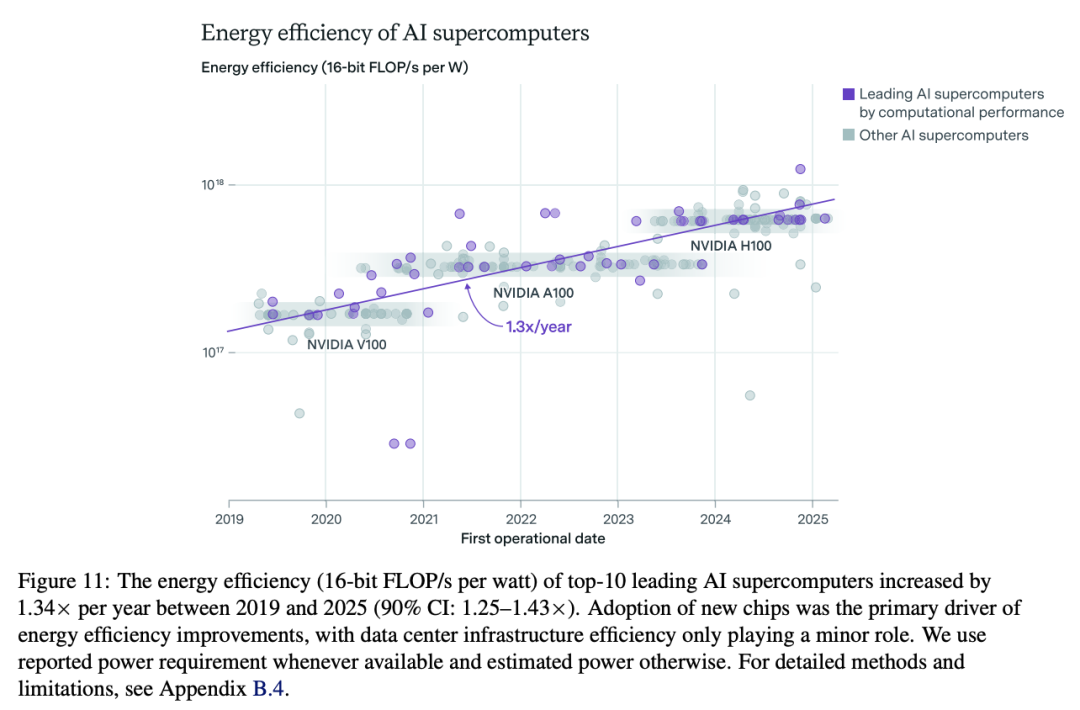

从2019年到2025年,AI超级计算机的能源效率每年提升约1.34倍(见下图11)。

在计算性能保持不变的情况下,AI超级计算机每年约可减少25%的能源消耗。

AI超级计算机的能源效率提升主要来源于两个方面:

一是硬件效率的提高,

二是数据中心基础设施(如冷却系统)效率的改进。

硬件效率的提升主要来自AI芯片的进步,但也包括其他硬件(如CPU、网络交换机和存储设备)的改进。

全行业电力使用效率(PUE)、是指供电给硬件的电力与供电给整个数据中心的电力之比。

理想的PUE为1.0,意味着所有输送到数据中心的电力都被直接用于硬件,而在电压转换、冷却及其他运维方面无任何电力损耗。

图11显示,每当新一代AI芯片问世时,能源效率都会显著提高。

与此同时,PUE的提升速度较慢,并且在估算中已接近理想值1.0,因此每年带来的效率提升不到5%。

因此,能源效率的提升主要归因于AI超级计算机采用了更高能效的硬件。

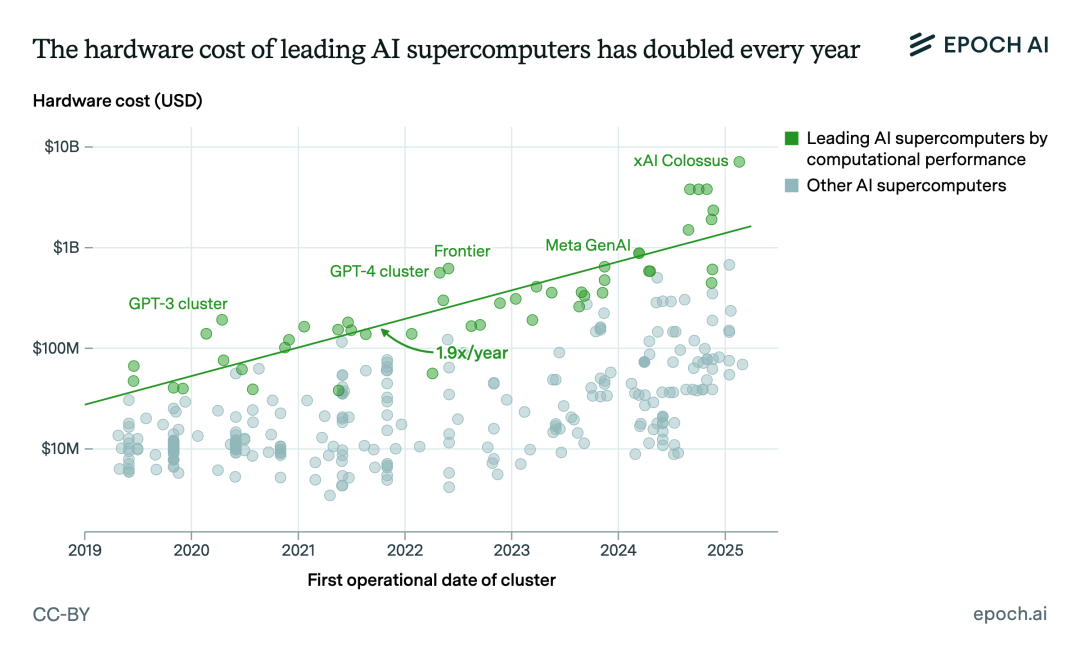

顶尖AI超级计算机的采购成本,每13个月翻一番。

AI超级计算机的成本持续攀升。

自2019年以来,领先超级计算机的计算硬件成本以每年1.9倍的速度增长。

2022年6月,最昂贵的集群是橡树岭国家实验室的Frontier,报告显示其成本为2亿美元。

三年后的2025年最强系统:xAI的「Colossus」采用20万块AI芯片,硬件成本高达70亿美元,功耗达300兆瓦(相当于25万户家庭的用电量)。

总硬件成本基于公开数据,或依芯片数量与价格估算。

此外,还包括了估算的额外硬件成本,如CPU和网络交换机,但不考虑电力生成或数据中心建设成本。

这一趋势背后,谁在加速冲刺?谁又在原地踏步?

随着AI超级计算机从科研工具演变为工业级机器,企业所占的算力份额迅速扩大,而政府和学术机构的占比则逐渐下降。

私营部门在全球AI计算能力中的占比已从2019年的40%增长至2025年的80%。

尽管早期的许多领先超级计算机(如Summit)由政府和学术实验室运营,但公共部门超级计算机的总装机计算能力仅以每年1.8倍的速度增长,远远落后于私营部门,后者的计算能力以每年2.7倍的速度增长。

AI日益重要的经济价值正在推动私营企业建设更多、更强大的超级计算机用于训练和推理。

截至2025年5月,已知最大的公共AI超级计算机——劳伦斯利物莫国家实验室的El Capitan,其计算性能不到已知最大行业AI超级计算机xAI的Colossus的四分之一。

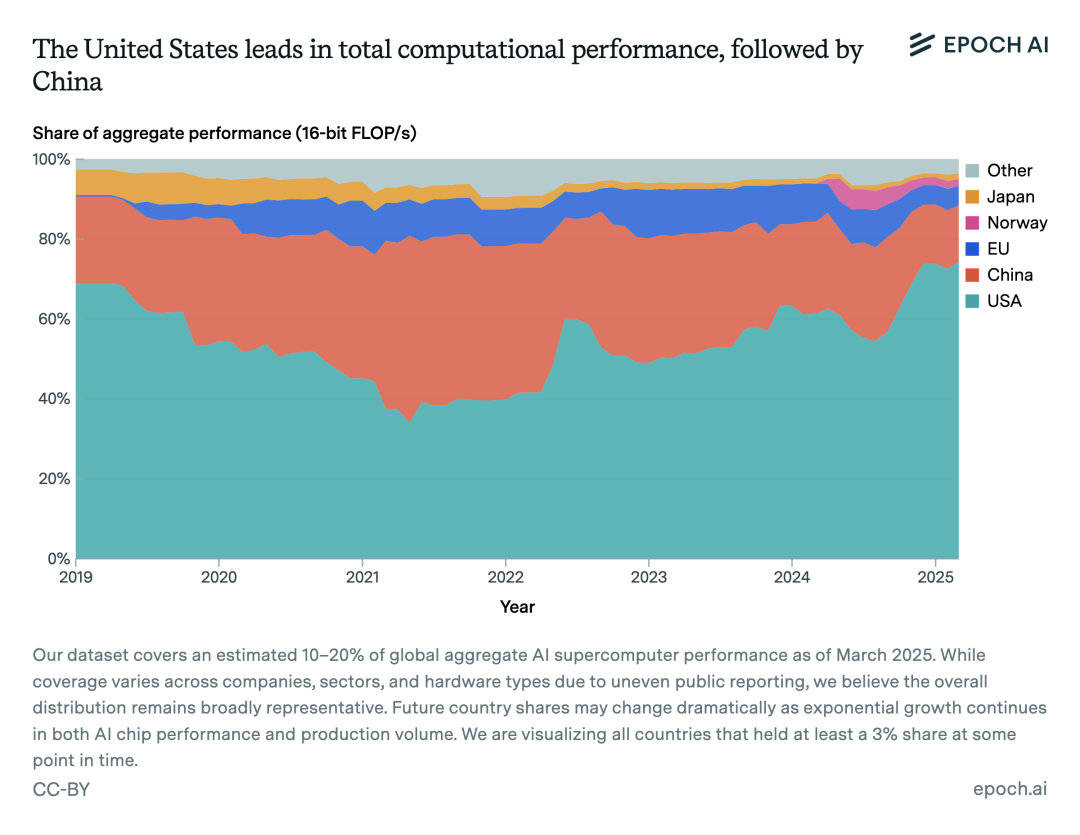

截至2025年5月,美国约占全球AI超级计算机算力的四分之三,中国以15%位居第二。

与此同时,德国、日本和法国等传统高性能计算强国在AI超级计算领域的作用日益边缘化。

这一转变主要反映了以美国为主的大型科技公司在该领域的主导地位日益增强。

注意:截至2025年3月,数据集覆盖了全球AI超级计算机总性能的约10–20%。

AI超级计算机,正进入指数级跃迁时代。

算力、能耗和成本的加速增长,既是AI飞跃的加速器,也可能成为其发展的瓶颈。

接下来的竞争,不只是比谁芯片多,而是比谁算得又快又省。

构建绿色、高效、分布式AI训练基础设施,将成为下一个关键战场。

从V100到H100,从实验室到马斯克的Colossus——

AI超级计算的时代,才刚刚开始。

(文:新智元)