AutoSchemaKG团队 投稿

量子位 | 公众号 QbitAI

知识图谱(KGs)已经可以很好地将海量的复杂信息整理成结构化的、机器可读的知识,但目前的构建方法仍需要由领域专家预先创建模式,这限制了KGs的可扩展性、适应性和领域覆盖范围。

为此,香港科技大学KnowComp实验室联合香港华为理论部提出了AutoSchemaKG:一个无需预定义模式、用于完全自主知识图谱构建的框架。

该系统利用大型语言模型,可以直接从文本中同时提取知识三元组并归纳出全面的模式,对实体和事件进行建模,同时采用概念化方法将实例组织成语义类别。

实验证实,该模式归纳在零人工干预的情况下,与人类设计的模式达到了95%的语义对齐。

另外,通过处理超过5000万份文档,AutoSchemaKG团队还构建了ATLAS(自动三元组链接与模式归纳):一个包含超过9亿节点和59亿边的知识图谱系列。

论文第一作者白佳欣是香港科技大学计算机科学与工程系的博士后研究员,受香港研究资助局新晋学者计划(JRFS)奖项资助。

白博士的研究重点在于图神经数据库系统构建,大规模知识图谱构建和推理,检索增强生成等。他在ACL、NeurIPS、KDD等顶级会议发表了多篇论文,工作涵盖电子商务意图建模、复杂查询回答和隐私保护神经图数据库等前沿领域。

创新:驱动模式归纳的概念化过程

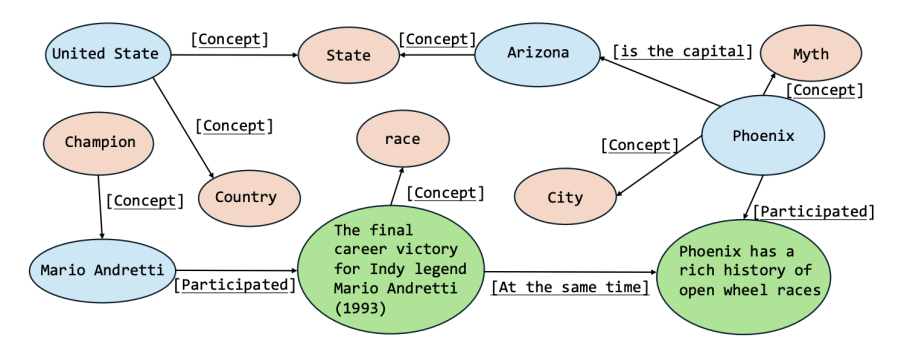

上图展示的是ATLAS的结构,实体节点(蓝色)和事件节点(绿色)从文本中提取,而概念节点(橙色)则通过模式归纳获得。

AutoSchemaKG利用大型语言模型的语义理解能力,能够直接从文本中同时提取知识三元组并动态归纳模式,将特定的实体、事件和关系泛化为更广泛的概念类别。

这种概念化具有多种关键功能:它在看似无关的信息之间建立语义桥梁,支持跨领域的零样本推理,减少知识图谱中的稀疏性,并提供支持具体和抽象推理的层级组织。

该框架将事件与实体一同建模,认识到现实世界的知识是动态而非静态的;通过将事件视为语义基元,可以捕捉到仅有实体的图谱所忽略的时间关系、因果关系和过程性知识。

像这样将传统的静态模式转变为一个动态的、多层次的概念框架,能够适应新领域而无需预定义本体。

构建:完全自动化知识图谱

三元组提取

AutoSchemaKG采用一个多阶段流水线,使用大型语言模型将Dolma语料库中的非结构化文本转换为知识三元组。该流水线通过三个连续阶段提取实体-实体、实体-事件和事件-事件关系:

阶段1:使用系统提示提取实体-实体关系,该提示指示大型语言模型检测实体及其相互关系。输出被解析为三元组(e(1),r,e(2)),其中e(1),e(2)∈V(N)是实体节点,r∈R是关系类型。

阶段2:使用提示识别实体-事件关系,生成三元组(e,r,v)或(v,r,e),其中e∈V(N),v∈V(E),r∈R。

阶段3:针对事件-事件关系,使用提示生成三元组(v(1),r,v(2)),其中v(1),v(2)∈V(E),r∈R。该流水线支持各种大型语言模型,并具有优化的精度设置和GPU加速。

提取的三元组及其对应的文本和元数据被序列化为JSON文件。

模式归纳

在三元组提取之后,AutoSchemaKG会再进行模式归纳,将特定的实体、事件和关系抽象为通用的类型。

这个过程使用大型语言模型为每个图元素生成代表其类型的概念短语,这与该形式化定义G=(V,E,C,ϕ,ψ)相符。

对于每个类别(事件、实体和关系),分批处理元素,大型语言模型为每个元素生成至少三个短语,这些短语在不同抽象层次上概括了其类型或相关概念。

对于实体(e∈V(N)),通过整合来自邻近节点的上下文信息来增强抽象。最多采样N(ctx)个邻居来构建一个提供额外语义线索的上下文字符串。

模式归纳流水线处理从三元组提取阶段序列化出来的图,元素被划分为批次,并可选择切片以进行分布式计算。

生成的短语记录在一个CSV文件中,通过ϕ和ψ将每个节点v∈V和关系r∈R映射到C中的一个概念子集。

这种自动化的模式增强了知识图谱在不同领域间的适应性,无需人工策划。

实践:ATLAS系列知识图谱的构建

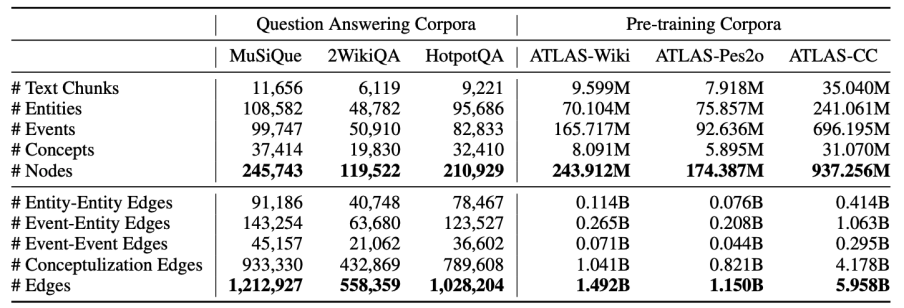

在语料库的选择上,如表所示,ATLAS-Wiki、ATLAS-Pes2o和ATLAS-CC分别由Dolma的维基百科与维基教科书子集、Semantic Scholar子集和Dolma的CC子集构建。

使用完整的维基百科与维基教科书来构建ATLAS-Wiki,使用Semantic Scholar的摘要部分来构建ATLAS-Pes2o,并使用cc-head、cc-middle和cc-tail各3%的数据来构建ATLAS-CC。

Dolma数据集中的CC的头部、中部和尾部分类是用于衡量与维基百科文本的分布相似性。

在计算成本上,使用配备80GB显存、具有1,513TFLOPS FP16计算能力的GPU,并运行带有Flash Attention的Llama-3-8B-instruct来构建该知识图谱。

计算需求巨大:En-Wiki(2.439亿节点,14.9亿边)需要14,300GPU小时;Pes2o-Abstract(1.744亿节点,11.5亿边)需要11,800GPU小时;Common Crawl(9.373亿节点,59.6亿边)需要52,300GPU小时。

以批次方式处理1024-token的文本块,总共投入了约78,400GPU小时来提取数十亿的语义关系。

测试:准确、连贯、通用

评估三元组提取准确性

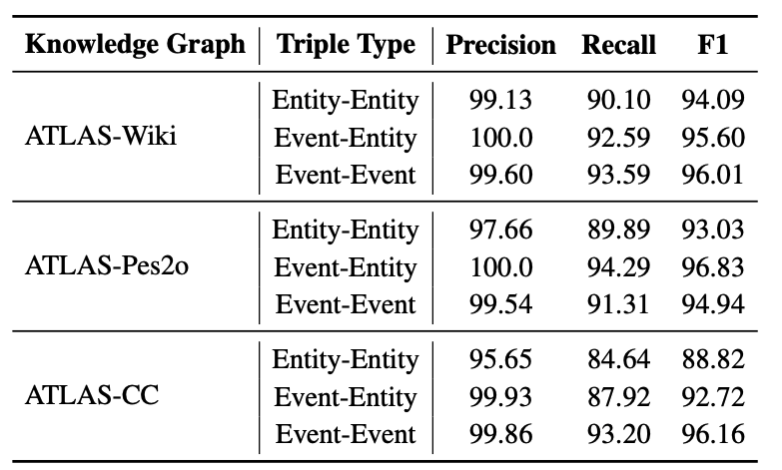

使用一种严格的基于计数的评估方法,不依赖主观评分,而是使用DeepSeek-V3作为评判者进行结构化验证。

这种方法使能够计算精确的指标:

-

精确率:正确提取的三元组占所有提取三元组的比例; -

召回率:正确提取的三元组占文本中所有真实三元组的比例; -

F1分数:精确率和召回率的调和平均值。

可以看出,AutoSchemaKG在所有数据集上都表现出卓越的提取质量,尤其是在维基百科内容上表现强劲。在大多数情况下,知识图谱中三元组的精确率、召回率和F1分数都超过了90%,证明了提取的三元组具有高质量和高可靠性。

衡量知识图谱中的信息保留度

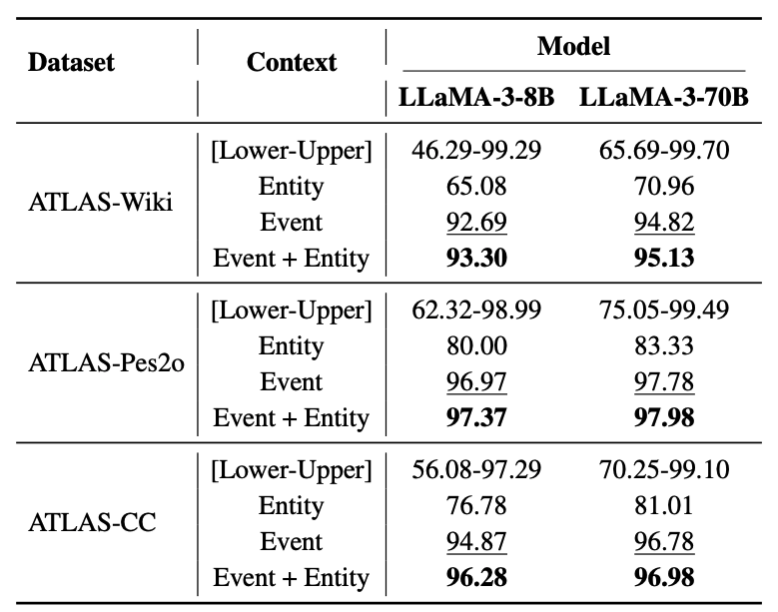

测试AutoSchemaKG将原始段落转换为知识图谱数据后,多项选择题(MCQ)的性能保留情况,遵循现有工作的评估协议,为每个原始段落使用LLaMA-3-70B-Instruct生成五个多项选择题,为每个数据集采样了200个原始段落,共获得1,000个多项选择题。

让大型语言模型在没有上下文的情况下回答这些问题(记为下限),然后再次提供原始段落回答(记为上限)以进行健全性检查。最后,使用实体级三元组(记为实体)、事件级三元组(记为事件)以及实体级和事件级三元组的组合(记为事件+实体)进行测试。

根据结果,得出以下见解:

(1)信息在构建的知识图谱中得到了很好的保留。使用实体、事件或事件+实体的多项选择题性能远高于下限基线,并接近原始段落的上限。这表明原始段落中的信息在AutoSchemaKG构建的知识图谱中得到了很好的保留;

(2)事件比实体更有效。使用事件或事件+实体的多项选择题性能比仅使用实体的性能更接近上限,在大多数情况下准确率超过95%。这表明事件级三元组可以比实体级三元组保留更丰富、更精确的信息。

衡量模式质量

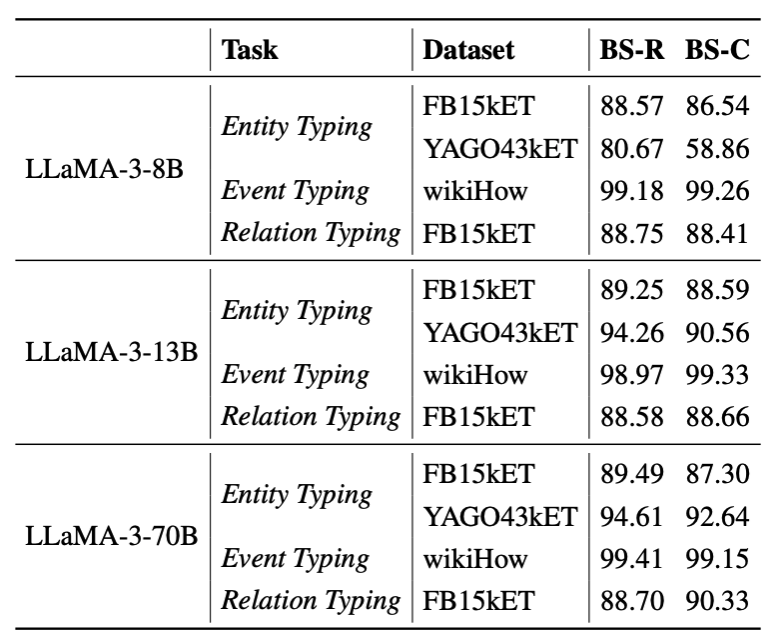

为了展示AutoSchemaKG归纳方法的能力,将其应用于实体、事件和关系类型化任务,衡量该方法可以召回多少类型。

由于基于规则的评估可能会忽略语义相似性,使用了两个语义级别的指标:基于BERTScore的recall和coverage(BS-R和BS-C)。

结合三种大小的LLaMA-3的使用结果,可以看出,在大多数情况下,AutoSchemaKG在实体、事件和关系类型上的召回率超过80%,通常达到90%,并且随着大型语言模型参数规模的增加而性能提升。

在多跳问答任务上的性能

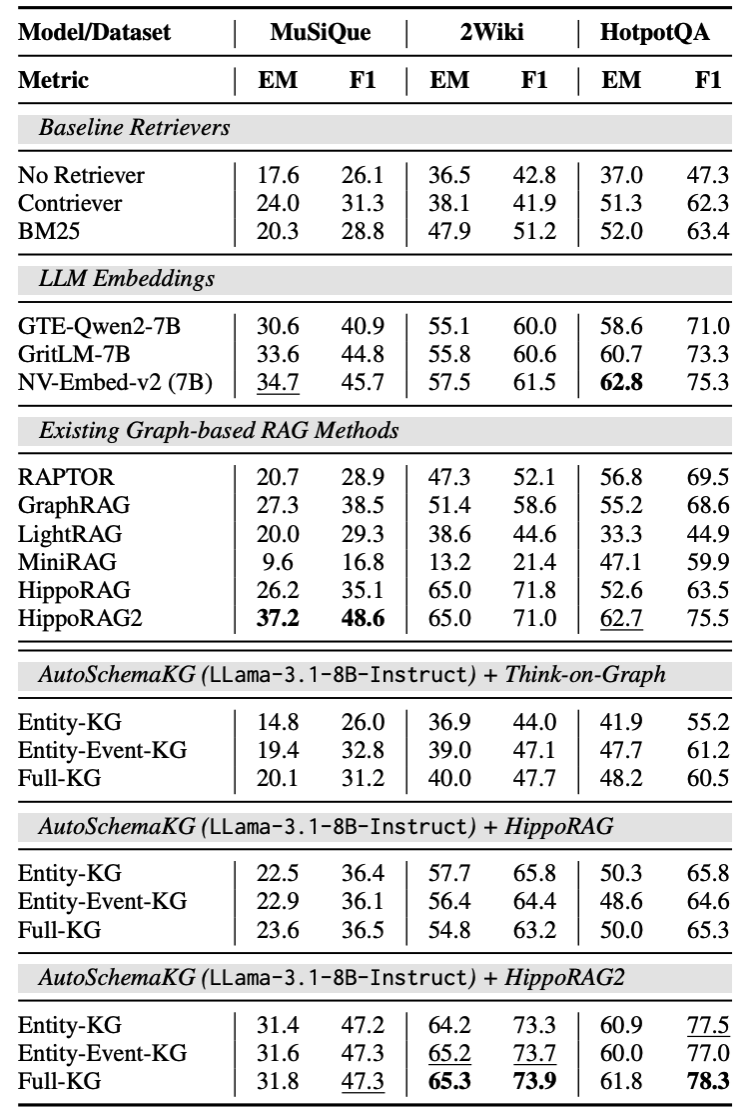

选择了MuSiQue、HotpotQA和2WikiMultihopQA三个以多跳推理需求著称的基准数据集,这些任务需要跨文章的复杂关系路径。从每个数据集中随机选择一千个问题。

将基于知识图谱的RAG系统与几种最先进的方法进行比较:基于图的基线包括HippoRAG、HippoRAG2、GraphRAG、LightRAG以及MiniRAG。对于基于文本的RAG比较,评估了BM25+LLM(使用传统BM25评分进行检索)、Contriever以及RAPTOR。

使用开放领域问答的标准指标来评估AutoSchemaKG。精确匹配(EM)在归一化后衡量二元正确性。F1分数衡量归一化答案之间的词元重叠度。

实验结果表明,AutoSchemaKG在三个基准数据集的多跳问答中表现出色。

与HippoRAG2集成后,Full-KG配置(实体、事件和概念)的性能比BM25和Contriever等传统检索方法高出12-18%,凸显了其在复杂推理场景中的优势。

另外,与需要LLaMA-3.3-70B-Instruct进行构建和问答阅读的原始HippoRAG2实现相比,AutoSchemaKG使用LLaMA-3.1-8B-Instruct作为图构建器取得了相当或更好的结果。

在增强事实性方面的有效性

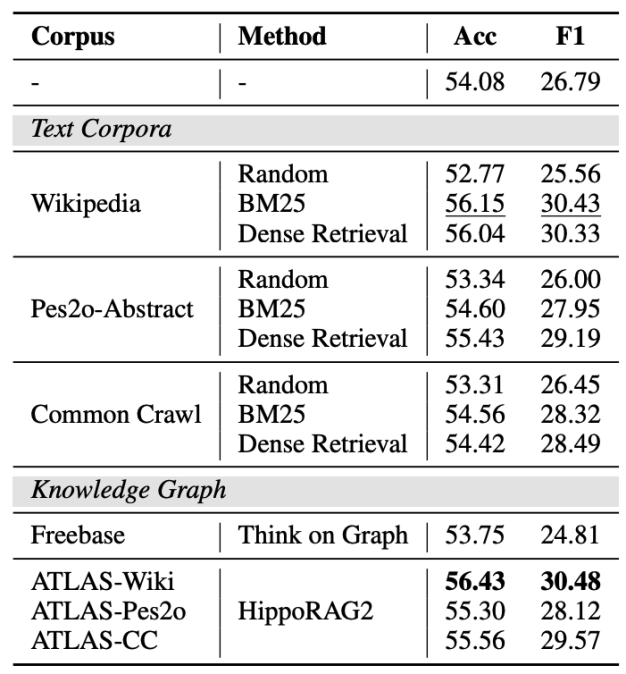

遵循FELM的协议,对三个领域(世界知识、科学/技术和写作/推荐)应用RAG,同时对数学和推理领域保持原始设置。

为了进行全面比较,评估了多种检索方法:HippoRAGv2、BM25和使用MiniLM的密集检索。

所有实验都使用相同的LLaMA-3.1-8B-Instruct模型,并集成了Neo4j和零样本CoT设置,以确保方法间的公平比较。性能使用平衡准确率(对真假片段给予同等权重)和检测事实错误的F1分数来衡量。

结果表明,使用AutoSchemaKG的HippoRAG2在维基百科(56.43%准确率,30.48%F1)和Common Crawl语料库上持续优于基线,同时在Pes2o-Abstract上取得了有竞争力的结果。在维基百科上的优越性能可能源于FELM部分样本以维基百科为参考。

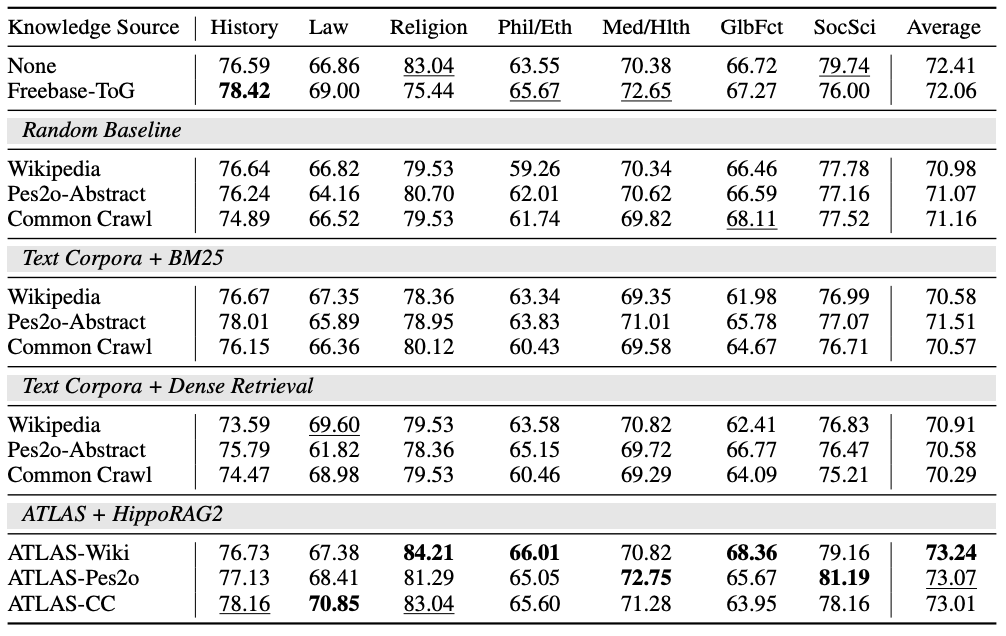

通用领域知识能力

使用与FELM实验相同的检索和生成设置,将MMLU任务分类为主体类别,并专注于知识密集型领域,包括历史、法律、宗教、哲学/伦理、医学/健康、全球事实和社会科学。

结果表明,ATLAS知识图谱在所有测试语料库的这些领域中都提升了性能。

每个ATLAS变体都展示了独特的优势:ATLAS-Pes2o在医学/健康和社会科学领域表现出色,反映了其源自学术论文的知识;ATLAS-Wiki在宗教、哲学/伦理和全球事实等一般知识领域显示出优势;而ATLAS-CC在法律和历史方面表现最佳,利用了其更广泛的网络来源内容。

在这些人文学科和社会科学领域,所有ATLAS变体都持续优于无检索基线和Freebase-ToG。例如,在法律领域,该方法比基线提高了4个百分点,而其他一些检索方法实际上降低了性能。

领域特定的性能模式符合直观预期:知识图谱在检索对人文学科和社会科学至关重要的事实关系方面表现出色,而在数学和技术领域,节点-关系结构在捕捉过程性知识方面效果有限,因此优势有限。

论文链接:https://arxiv.org/abs/2505.23628

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)