未来10个AI应用场景中,至少7个与多媒体深度绑定。

作者|田思奇

编辑|栗子

在AI技术演进的过程中,每个阶段都有一个关键场景,成为撬动产业升级的 “阿基米德支点”。

2023年,这一角色属于生成式AI模型的爆发,人类第一次感受到了AI“能说会画”的能力;

到了2024年,AI不再仅靠指令执行,而是开始理解看到的和听到的。多模态对齐与语义统一成为关键路径。

2025年,AI技术版图上的支点,无疑落在了多媒体领域。

人类感知世界的方式,本质上是一场视听盛宴的狂欢。超过80%的信息获取,都来自视觉与听觉的协同运作。从清晨唤醒人们的智能语音助手,到通勤路上刷到的短视频,再到工作时查阅的视频会议资料,图像、视频、语音等多模态交互,早已编织成理解世界的 “元代码”。

近年来,AI的算法创新层出不穷。然而,单纯的参数规模比拼已不再是决胜关键。能否以人类熟悉的方式理解世界,才是决定其商业价值与社会价值的核心要素。

而多媒体内容,正是AI实现这一要素的最佳舞台。

6月11日,「甲子光年」来到2025春季Force原动力大会现场,见证了火山引擎智能视频云赋能行业变革的无限可能。

1.突破瓶颈:智能多媒体面临的三大挑战

智能多媒体时代的核心特点是,生产正在从被动响应,转向主动创造价值。

传统的多媒体处理,遵循线性逻辑。而大模型时代智能系统可以通过时空数据融合实现了 “需求预判”,形成了 “远端决策近场执行” 的快速响应,能更加有前置性的预测到用户需求,并满足这些需求。

这种从 “中心被动响应” 到“边缘主动预判”的生产模式升维,是智能多媒体内容落地过程中的变革之一。

此外,交互方式发生改变,从 “单一模态指令” 转变为“多感官协同理解”。这是智能多媒体时代的第二个变革。AI正从 “听指令” 的工具,进化为 “能看、能听、能理解” 的智能伙伴。

第三个变革在于,AI多媒体系统,正经历从单点工具向系统智能体网络的结构性跃迁。当AI Agent渗透到医疗、教育、工业等领域,传统单一工具由于各自独立而不能满足复杂需要,取而代之的是跨领域协作的智能体协作。

火山引擎数据显示,智能多媒体在垂直领域领域的渗透率已达40%,预计2028年将突破75%。

尽管趋势清晰、潜力巨大,但据字节跳动视频与边缘负责人王悦在Force原动力大会介绍,智能多媒体在行业落地中,依然面临三个方向的关键挑战。

首先是计算效能问题。随着大模型从 “中心辐射式” 部署多 “毛细血管级” 渗透,人-AI-机器的实时交互对计算提出了隐私安全、实时响应、全局优化等需求和挑战,传统集中式架构已经非常难以满足分布式智能计算的需求。

其次,多模态数据以年均超60%的速度爆发增长,但也带来了复杂度剧增。用户的极致体验需求等挑战出现了“数据越丰富,体验越卡顿”的怪圈 ,需要架构级创新和突破。

第三,以往大模型的训练周期以“月”为单位,如今则以“周”甚至“小时”计。当技术创新速度与成本要求出现矛盾时,如何实现 “高效率的创新” 成为亟待解决的问题。

因此,要从传统的视频云进化到智能视频云,亟需一套系统性的架构升级来破解当前困局。火山引擎提出的“智能视频云”三层架构升级,正是为应对这一挑战而生。

2.三层架构全面升级,智能多媒体真正从“可用”到“好用”

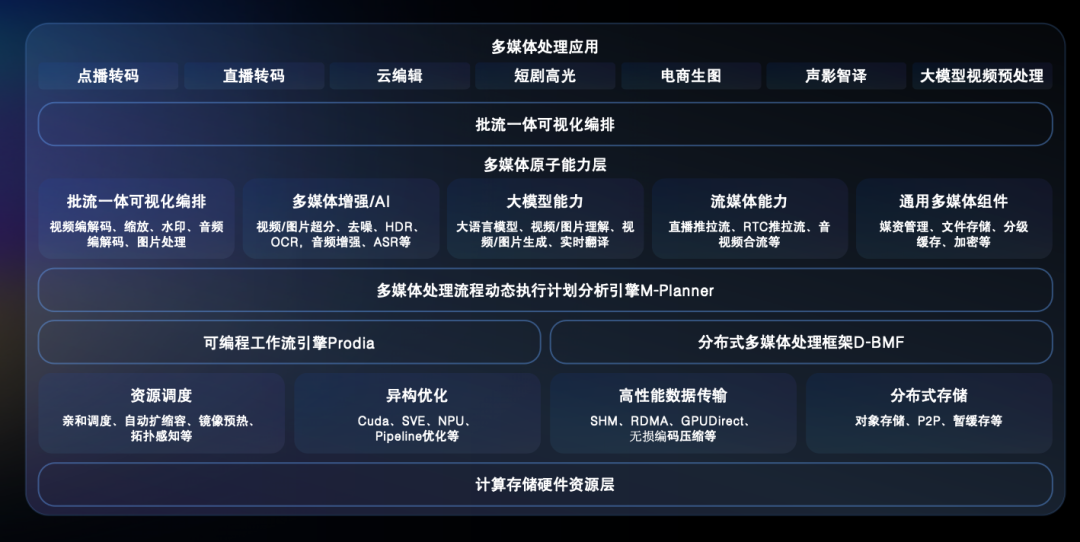

整体来看,火山引擎通过“基建 + 平台 + 应用”的三层架构,实现了从“视频云”到“智能视频云”的底座升级。

首先升级的是基建层。

随着AI应用由“后台生成”深入“前台交互”,多媒体内容的实时传输与就近处理需求激增。为此,火山引擎构建了“全球一张网”,形成覆盖全球5000+节点、具备280Tbps超大带宽的分布式云网基础设施。

该设施依托全球一体化多媒体基建,具备超大规模、超低时延、云边端一体以及分布式安全防护等能力,目标在让智能应用能就近上云,让用户更便捷、高效、安全地享用 AI 服务。

这个扎实的基建层,为火山引擎的智能多媒体提供了坚实的技术底座。

但这还不够。除了框架的升级外,火山引擎也实现了平台层的升级——把分布式的BMF和底层的平台做了深度的融合,构建了新一代多媒体智能处理平台MIPP。它的核心目标是使开发者以小时级的速度构建一个大规模、低成本、高性能、高稳定性的多媒体应用。

MIPP的核心突破,首先在于其革命性的灵活编排能力。它彻底打破了传统平台仅支持文件级别处理的局限,构建起涵盖文件级、帧级乃至事件级的多粒度编排系统,全面覆盖多媒体在离线场景。

其次,MIPP实现了深度的原子能力聚合。平台不再是功能的简单堆叠,而是构建了一个结构清晰、协同高效的能力原子库,系统整合了通用音视频处理、图像识别、语音分析、多模态摘要、流媒体分发、大模型接入以及媒资管理等关键模块。每个能力组件既可独立运行,也能通过统一接口按需调用、自由组合。

在异构资源调度与优化方面,MIPP展现出强大的适应力。其底层支撑体系覆盖从传统CPU/GPU、ARM架构到边缘设备及专用视频芯片的全谱系硬件。依托火山引擎自研的分布式BMF框架,平台能根据任务类型、实时性要求及资源状况,自动生成最优资源组合策略。

尤为关键的是,MIPP实现了专家级的性能成本优化。针对大模型频繁更新与业务需求快速变化,平台可以自动化选择资源类型,规划最优部署执行方案,为企业在动态变化的多媒体生态中保留了充分的灵活性。

如果说底层基建和MIPP平台解决了“能用”和“用顺”的问题,那么应用层的升级则关乎真正的落地效果。

随着AI发展不断涌现,泛智能多媒体应用较传统的视频云应用,也在交互方式上实现了突破。其中,火山引擎聚焦对话式AI、AI Agent Mobile Use和多模态视频理解与创作这几大最具广谱性的场景,打通了模型能力到终端体验的“最后一公里”。

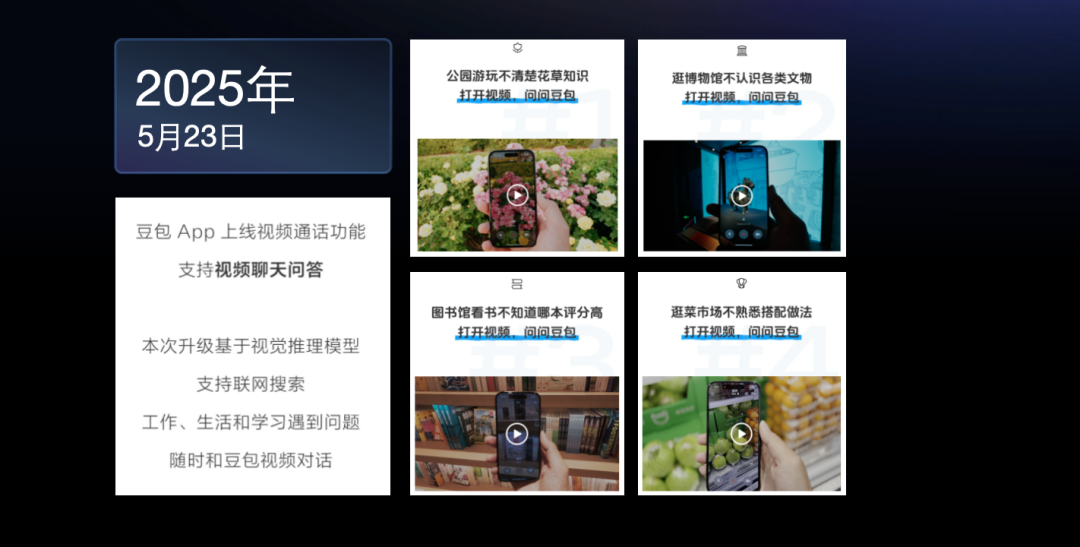

作为应用层升级的代表,火山引擎的对话式AI技术旨在让 AI 对话更具真人感,其突破体现在:语音交互上,它攻克了即时响应、准确断句、始终流畅三大关卡。同时支持视频对话,可以基于视觉理解模型实现多模态 AI 对话,解锁 AI 教育、陪伴、解说等多元场景。

该对话式AI嵌入式方案应用于母婴零售行业领军者孩子王的AI潮玩啊贝贝后,可将部分处理能力放在AI玩具终端设备,减少数据传输量和网络延迟,打造实时性更强和隐私保护更优的用户体验。

此外,AI与元宇宙技术引领者“不普家族”也依托豆包大模型、Coze平台和实时音视频技术,推出了业内首款基于原创剧情、丰富玩法和社交场景的AI伙伴游戏社交宇宙,为玩家带来连接真实情感的全新体验。玩具开口说话时,不再有很强的文案感,而是能像真人一样自然地跟玩家聊天,让AI伙伴离“有灵魂”更近了一步。

在移动端主场的当下,火山引擎的Mobile Use解决方案依托MIPP的灵活的编排能力,集成多智能体协调机制。用户通过自然语言指令(如“订今晚上海到北京最便宜的高铁票”),即可驱动端侧主智能体调度图文处理、支付、位置等专业Agent完成多轮任务。

该方案支持跨平台无缝迁移及高并发多任务处理,已在外卖、票务、导航等场景落地。

在多模态理解与创作技术的支持下,抖音电商已依托智能视频云的高光智剪方案,精准的识别商品高光片段和核心卖点,产出了直播高光片段,大幅提升营销效率。助力商家实现了日均生产300条高质量视频内容,每个商家每月最高可以节省9万元,转化效率提升了3倍以上。

从零售用户更优质的体验,到移动端多智能体的自然指令响应与跨平台任务执行,其底层逻辑已不再是“是否能做”,而是“能否做得流畅、做得体系化”。这些落地场景印证了火山引擎技术能力的成熟,更标志着企业正在步入一个以AI驱动体验重塑、以平台构建系统价值的关键转折。

也正是在这一背景下,智能视频云的角色正在发生本质变化。

3.如何真正加速智能多媒体落地?

「甲子光年」认为,在AI迈入深水区的2025年,真正决定行业落地水平的,不再是某一项炫目的AI能力,而是是否能够将AI能力系统化地融入业务流程、并转化为可感知、可持续的用户体验。

上文提到的智能多媒体三重进化趋势——从中心响应向边缘预判、从单模态向多模态协同、从工具孤岛向智能体网络——其落点其实都指向了一个核心问题:能否让AI真正读懂用户、融入场景、驱动价值。这一切的发生,依赖的不只是模型能力本身,更是从底层基建到平台架构,再到最终应用的协同进化。

火山引擎提出的“智能视频云”三层架构升级,在这一转型过程中充分发挥了统筹全局的能力,助力企业在智能多媒体的落地过程中实现更低成本、更高效率的规模化应用。

例如,在内容密集的零售、电商行业中,仅靠对话式AI理解语义、推荐商品远远不够,只有当智能视频云支持“直播-剪辑-生成-分发”全过程,AI才能真正从一段视频中提取高光片段、自动添加标签并投放进推荐流。而用户的行为反馈又可反向进入平台优化算法参数,形成真正意义上的闭环智能,为业务带来真正可衡量的ROI。

再以移动端场景为例。传统人机交互依赖中心模型调用与静态指令,流程繁琐且延迟明显。而火山引擎Mobile Use方案可以让“自然语言一声令下”,就能在端侧触发图文、位置、支付等专业Agent的实时协作,完成跨平台、跨任务、跨系统的无缝操作。用户无需理解AI是如何工作的,但能切实感受到:任务更快了、操作更少了、体验更顺了。

这正是智能视频云“系统能力”的真实体现:它不仅提供模型能力,还通过全链路的资源调度与内容理解,打通了“算力—内容—交互—场景”的耦合路径,大幅提高行业落地的效率。

除了电商之外,泛娱乐、金融、教育、政务、出海等多个行业,也在加速迈入“智能交互”时代,纷纷开始基于智能视频云打造自己的智能多媒体能力。

预计2025年,大模型中多媒体数据的使用比例将达到40%,2030年更将超过70%。也就是说,未来每10个AI场景中,至少有7个都离不开图像、视频、语音这些多媒体内容。

面对这样的大趋势,火山引擎走出了一条务实的路径——让智能多媒体真正深入业务场景,以轻量化部署与高效能输出的方式服务于业务,成为企业构建长期竞争力的重要支点。未来的竞争,不再是谁用上了AI,而是谁把AI用出了系统化、规模化、可持续的价值。

(封面图及文中图片来源:火山引擎)

(文:甲子光年)