作者:李宝珠

编辑:耶耶

转载请联系本公众号获得授权,并标明来源

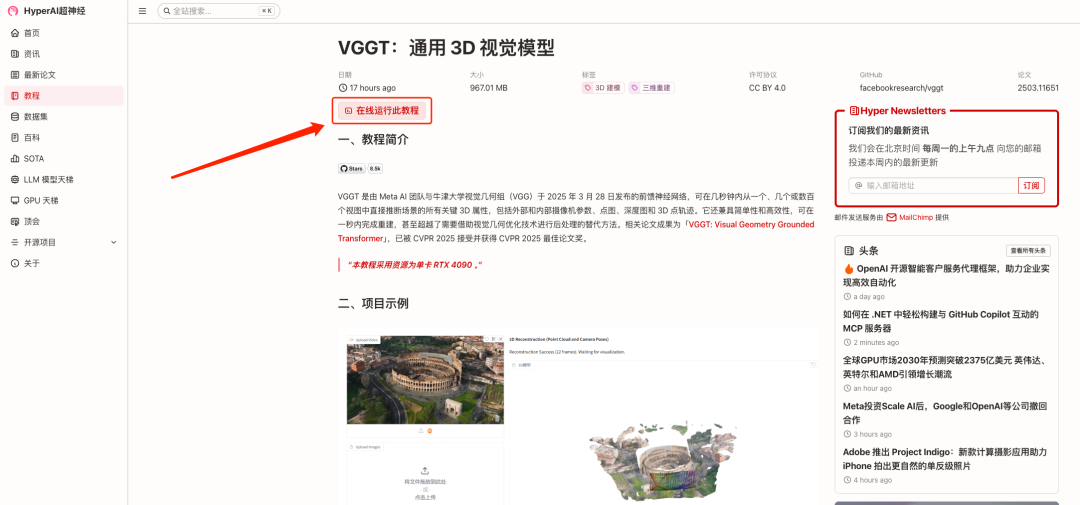

HyperAI超神经官网(hyper.ai)的教程版块已上线「VGGT:通用 3D 视觉模型」,支持一键部署体验效果

6 月 13 日,全球计算机视觉三大顶级会议之一 CVPR 2025 公布了最佳论文等奖项。根据官方数据,CVPR 2025 共收到了超 4 万名作者提交的 13,008 篇论文,相较去年的投稿数量增长了 13%,大会最终接收论文 2,872 篇,整体接受率约为 22.1%。

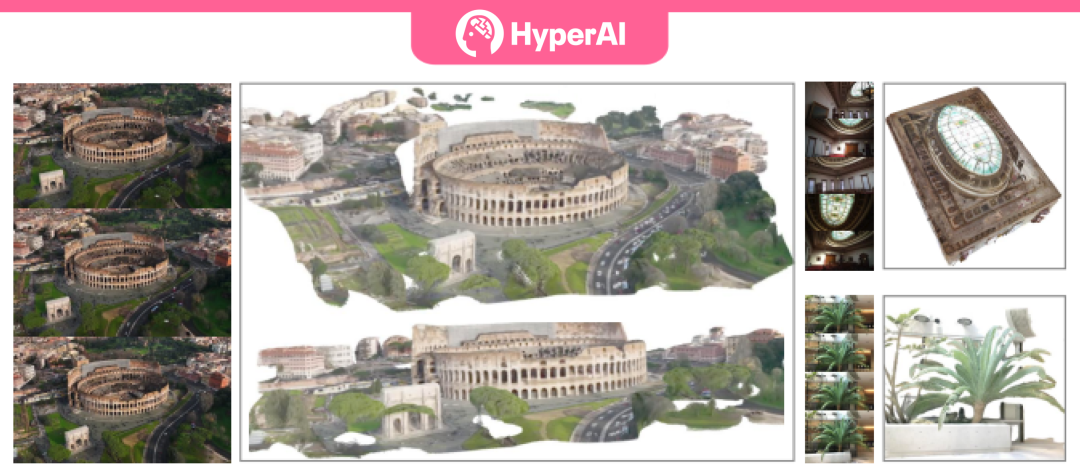

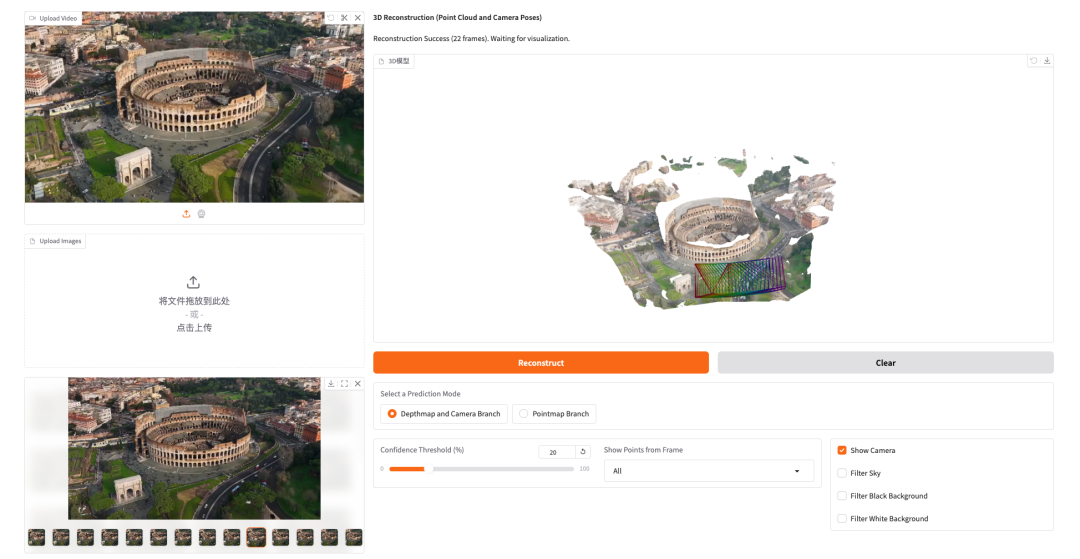

而在最终入选的近 3 千篇论文中,仅 1 篇杀出重围,摘冠 Best Paper,含金量可想而知。这篇成果是由牛津大学与 Meta AI 共同提出的基于纯前馈 Transformer 架构的通用 3D 视觉模型 VGGT,其突破了以往模型局限于单一任务的挑战,能够直接从一个、几个或数百个视角中推断出场景的所有关键三维属性,包括相机参数、点图(point maps)、深度图(depth maps)和三维点轨迹(3D point tracks)。

* 论文题目:「VGGT: Visual Geometry Grounded Transformer」

* 论文链接:https://go.hyper.ai/Nmgxd

更重要的是,该方法结构简单高效,能够在不到 1 秒的时间内完成图像重建,性能上超越了那些依赖视觉几何优化后处理技术的替代方案。实验结果显示,VGGT 在多个三维任务中的表现都达到了 SOTA 级别,包括相机参数估计、多视角深度估计、稠密点云重建和三维点追踪等。

目前,HyperAI超神经官网(hyper.ai)的教程版块已上线「VGGT:通用 3D 视觉模型」,支持一键部署体验效果,快来感受一下这项突破性成果的强大实力吧 ⬇️

* 教程链接:https://go.hyper.ai/GX3bC

Demo 运行

1.进入 hyper.ai 首页后,选择「教程」页面,并选择「VGGT:通用 3D 视觉模型」,点击「在线运行此教程」。

2.页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

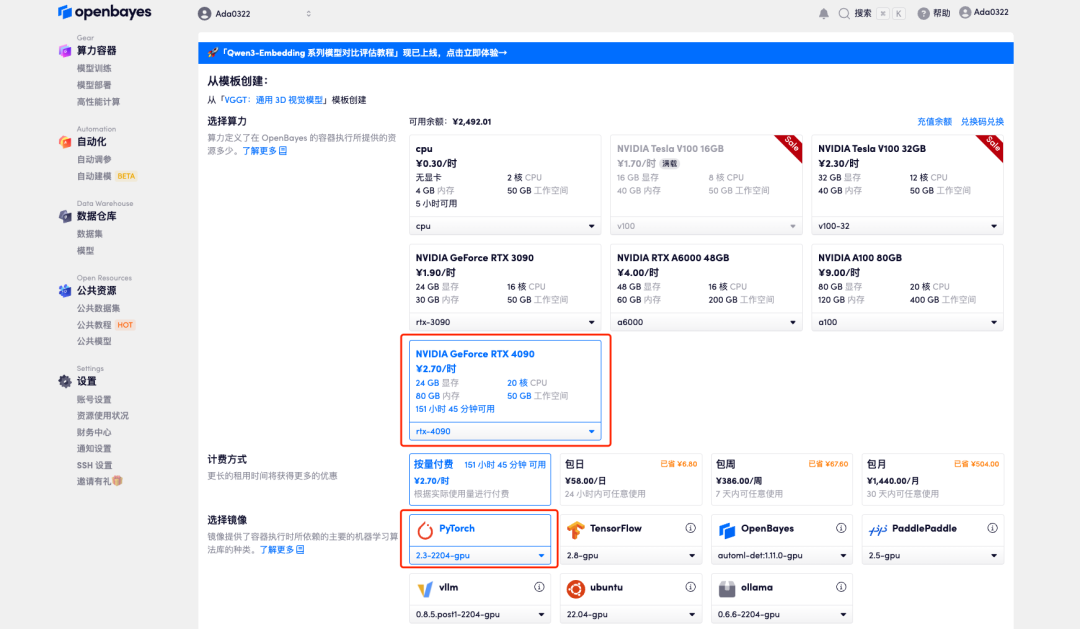

3.选择「NVIDIA RTX 4090」以及「PyTorch」镜像,OpenBayes 平台提供了 4 种计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

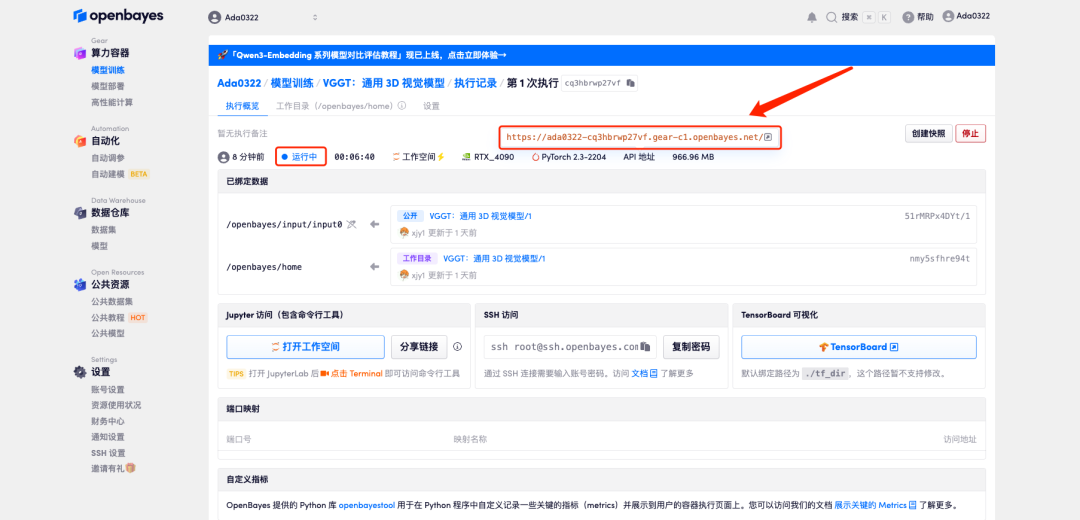

4.等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。由于模型较大,需等待约 3 分钟显示 WebUI 界面,否则将显示「Bad Gateway」。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果演示

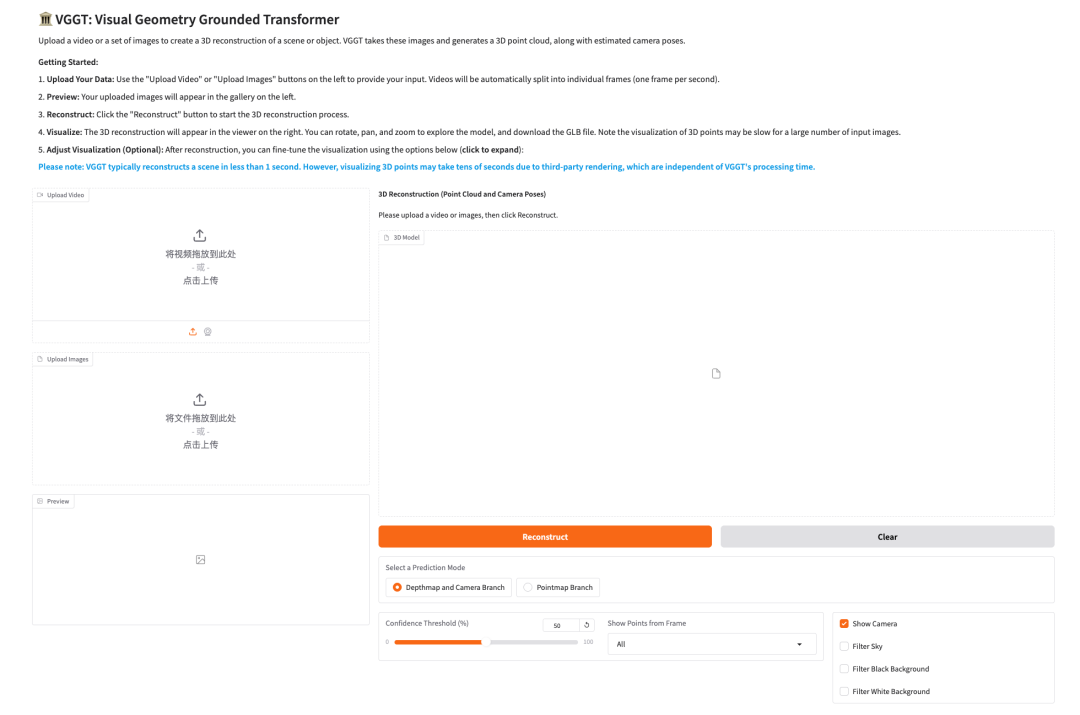

1.点击 API 地址即可进入 demo 页面体验该模型,如下图所示:

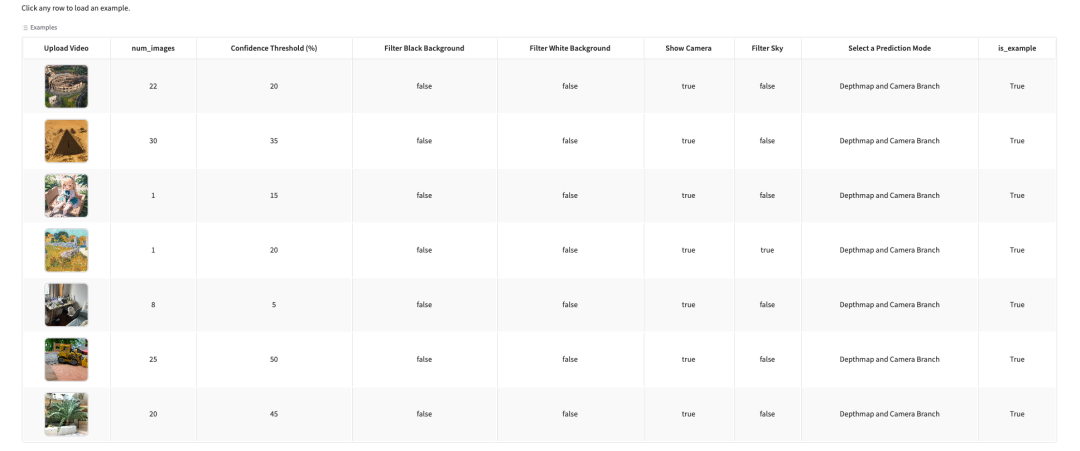

2.我们在教程中已经为大家准备了示例,点击即可直接体验模型效果,如下所示。

这就是本期推荐的教程,欢迎大家亲自上手体验 ⬇️

* 教程链接:https://go.hyper.ai/GX3bC

戳“阅读原文”,免费获取海量数据集资源!

(文:HyperAI超神经)