论文地址:

https://ieeexplore.ieee.org/document/11005686

Arxiv地址:

https://arxiv.org/abs/2303.09117

CMCRL 仓库:

https://github.com/WissingChen/CMCRL

因果框架仓库:

https://github.com/HCPLab-SYSU/CausalVLR

放射学报告生成任务(RRG)相比传统图像描述任务存在诸多挑战,包括:

-

长序列文本生成:报告往往需生成 60 至 100 个词的长文本,而且文本中的语义和结构复杂度远超常规图像描述任务。

-

关键病灶的定位要求高:如何精确捕捉影像中的病灶和异常部位,对模型的细粒度特征提取能力提出了极高要求。

-

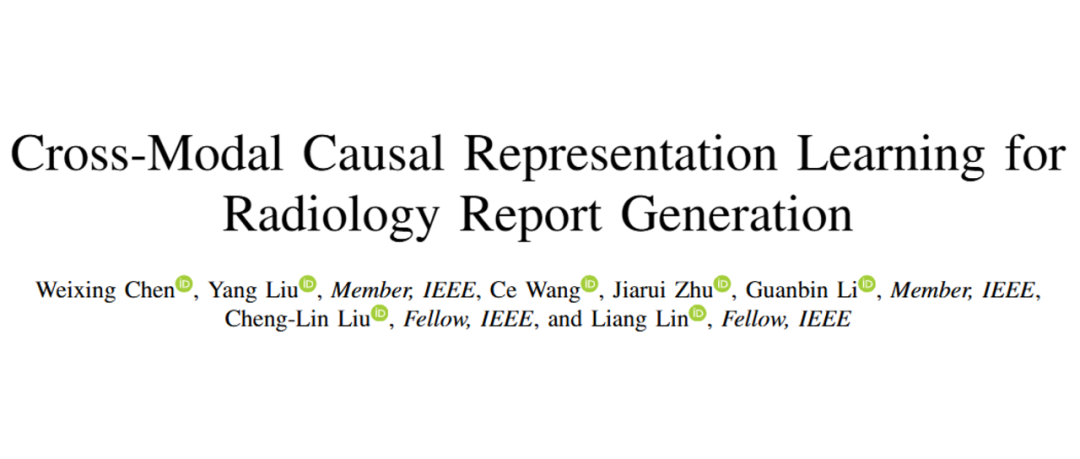

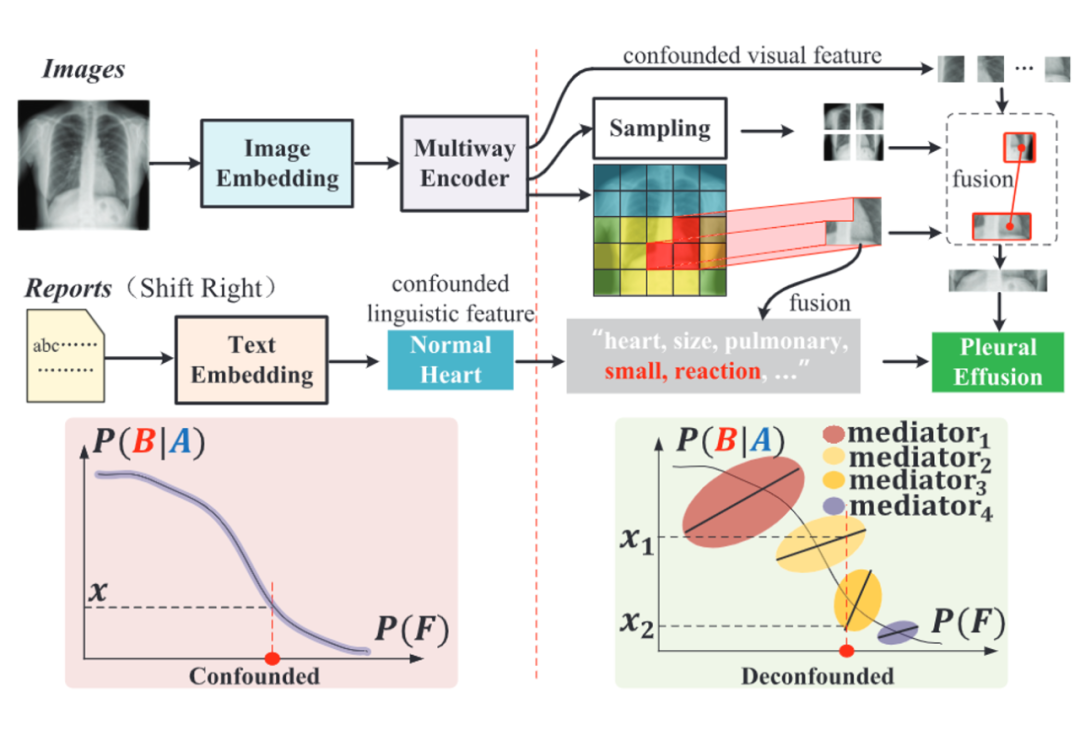

视觉-语言偏倚问题:由于训练数据普遍存在的视觉与语言偏倚(如文中图 1 所示,“Normal Heart” 与 “No Effusion” 的伪关联),如果不加以干预容易导致误诊或遗漏异常描述。

▲ 图1. RRG 任务中的跨模态伪关联

CMCRL:两阶段跨模态因果表示学习框架

为解决上述挑战,论文提出了 CMCRL 框架,其核心思想基于因果干预,通过两阶段设计有效地捕捉并校正跨模态数据中的偏倚:

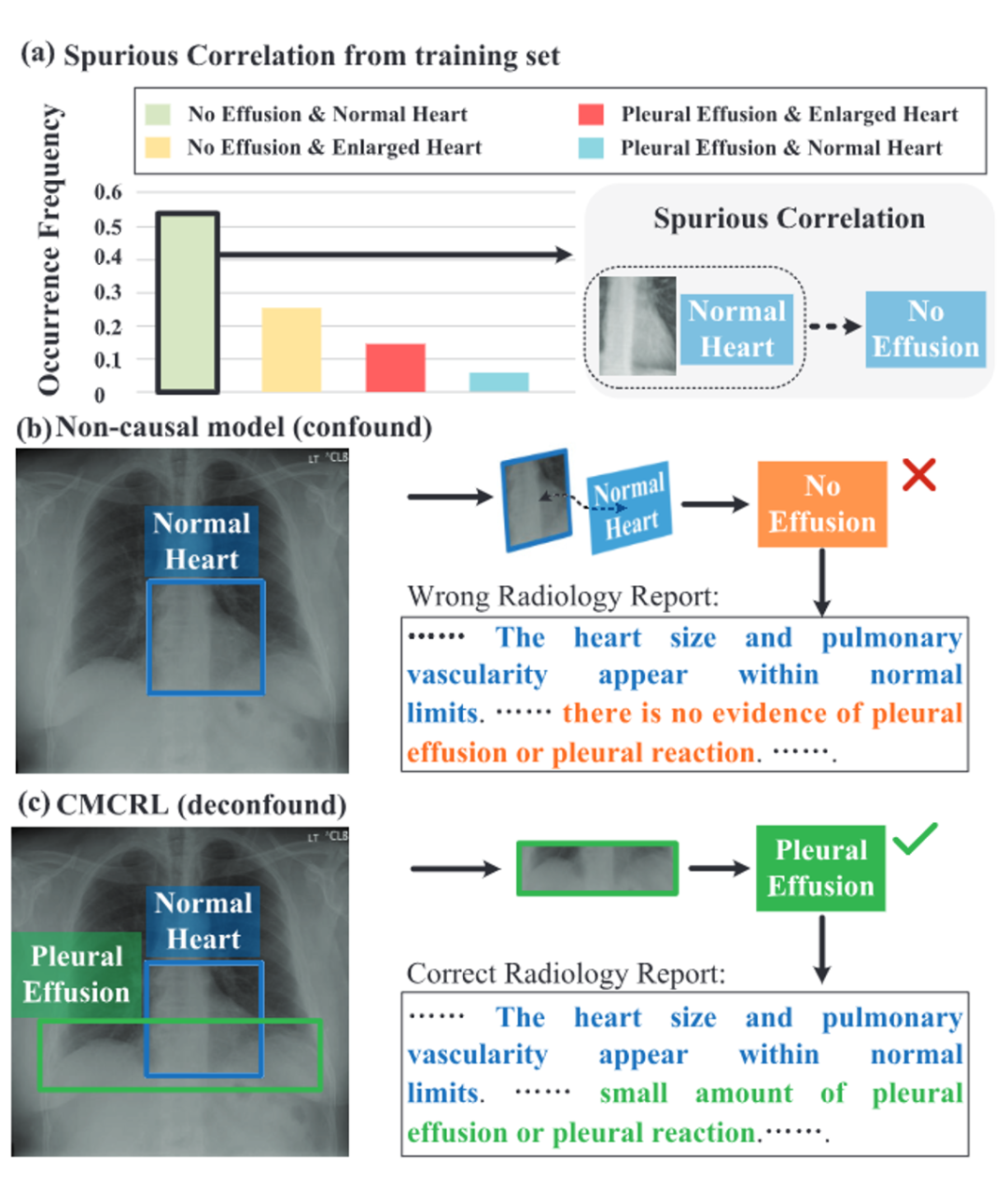

▲ 图2. baseline 模型与 CMCRL 框架的流程

1. RadCARE 预训练阶段

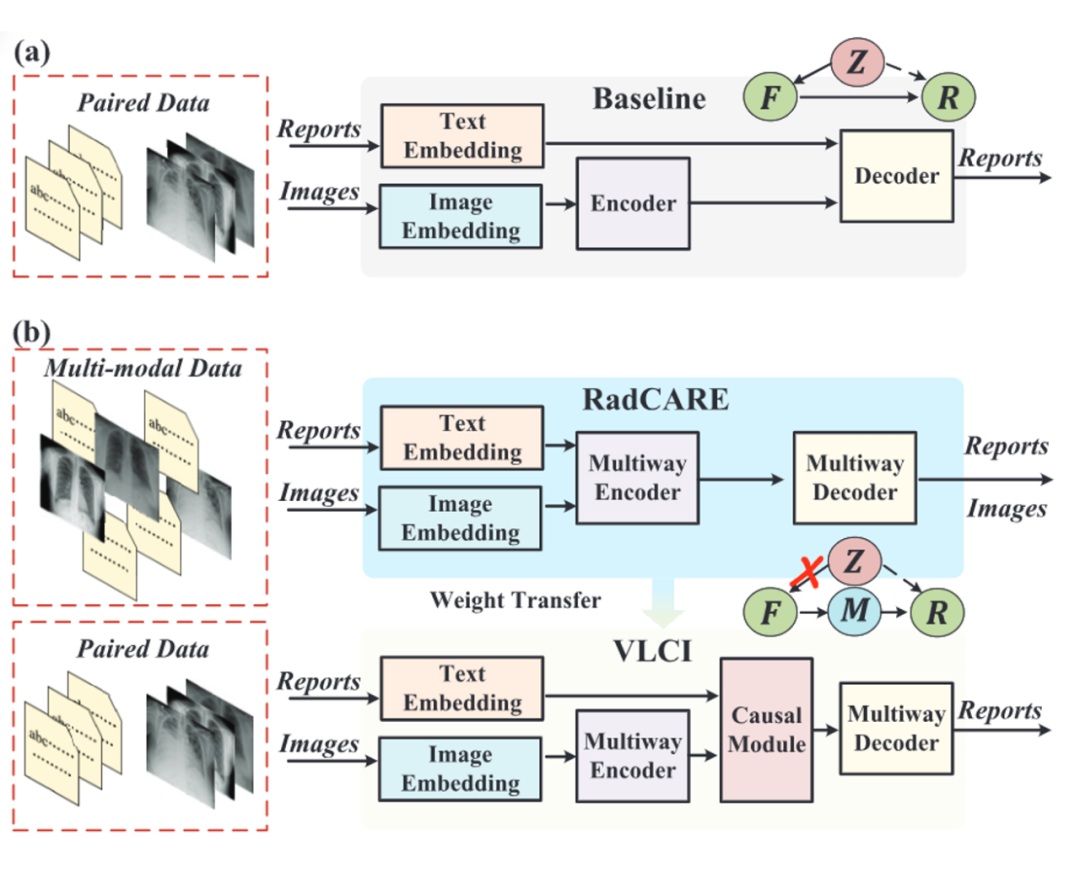

针对放射图像的低分辨率、噪声干扰以及数据缺失问题,团队设计了专门的 Radiological Cross-modal Alignment and Reconstruction Enhanced(RadCARE)模块,如图 2 所示。

-

退化感知的掩码图像修复策略:利用低质量图像与文本报告作为输入,重建出高分辨率图像片段,显著缓解图像噪声和细节损失问题;

-

后缀文本生成任务:结合图像以及前缀信息生成文本后缀,实现跨模态信息的高效对齐;

-

同时采用包括完整文本、退化图像、多种数据输入方案在内的四种灵活的训练策略,有效利用单模态或未配对数据,为后续因果干预打下坚实基础。

▲ 图3. RadCARE 训练策略

2. VLCI 微调阶段

为进一步消除跨模态的伪关联问题,论文在微调阶段引入了 Visual-Linguistic Causal Intervention(VLCI),如图 4 所示,即:

-

利用视觉去混淆模块(VDM),通过局部与全局特征采样提取关键病灶信息,消除因训练数据中类似 “Normal Heart” 等实体带来的伪关联;

-

同时通过语言去混淆模块(LDM)调节词向量在语义空间的偏差,打破图像和文本之间潜在的混淆关系;

-

整体采用因果前门干预方法,将中介变量引入扫除视觉和语言偏差,形成真正基于病灶特征的生成决策。

▲ 图4. VLCI 中的因果干预机制

这种自内而外、无需额外标注辅助的因果干预机制,不仅显著提高了报告生成的准确率,还使得模型在异常检测(例如 “Edema”、“Enlarge Cardiomediastinum”)上表现出更高的临床可信度。

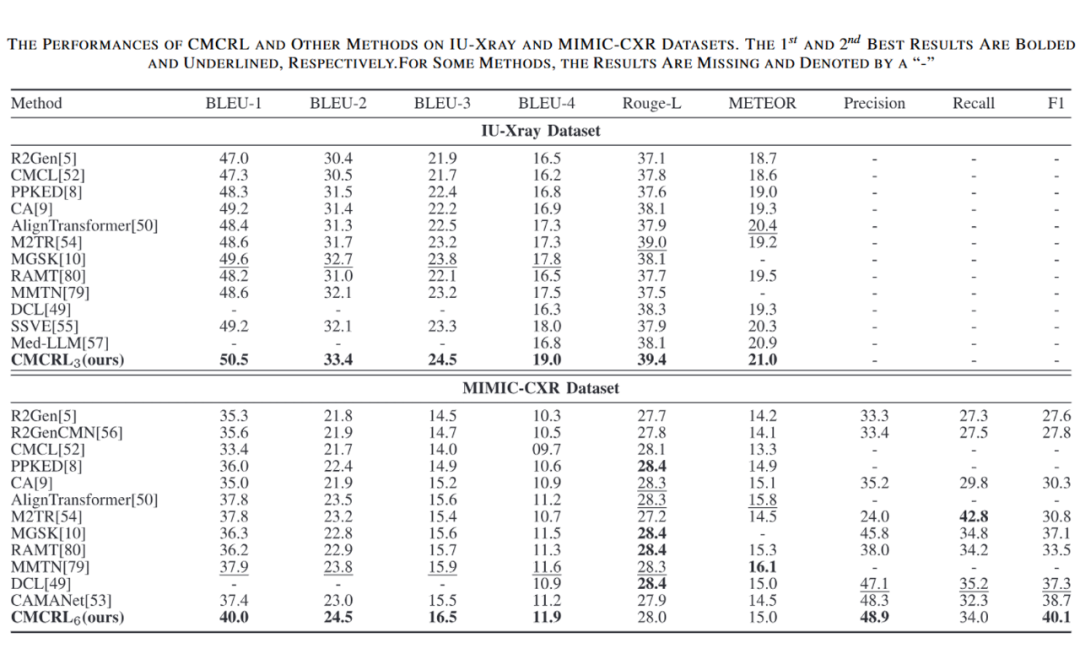

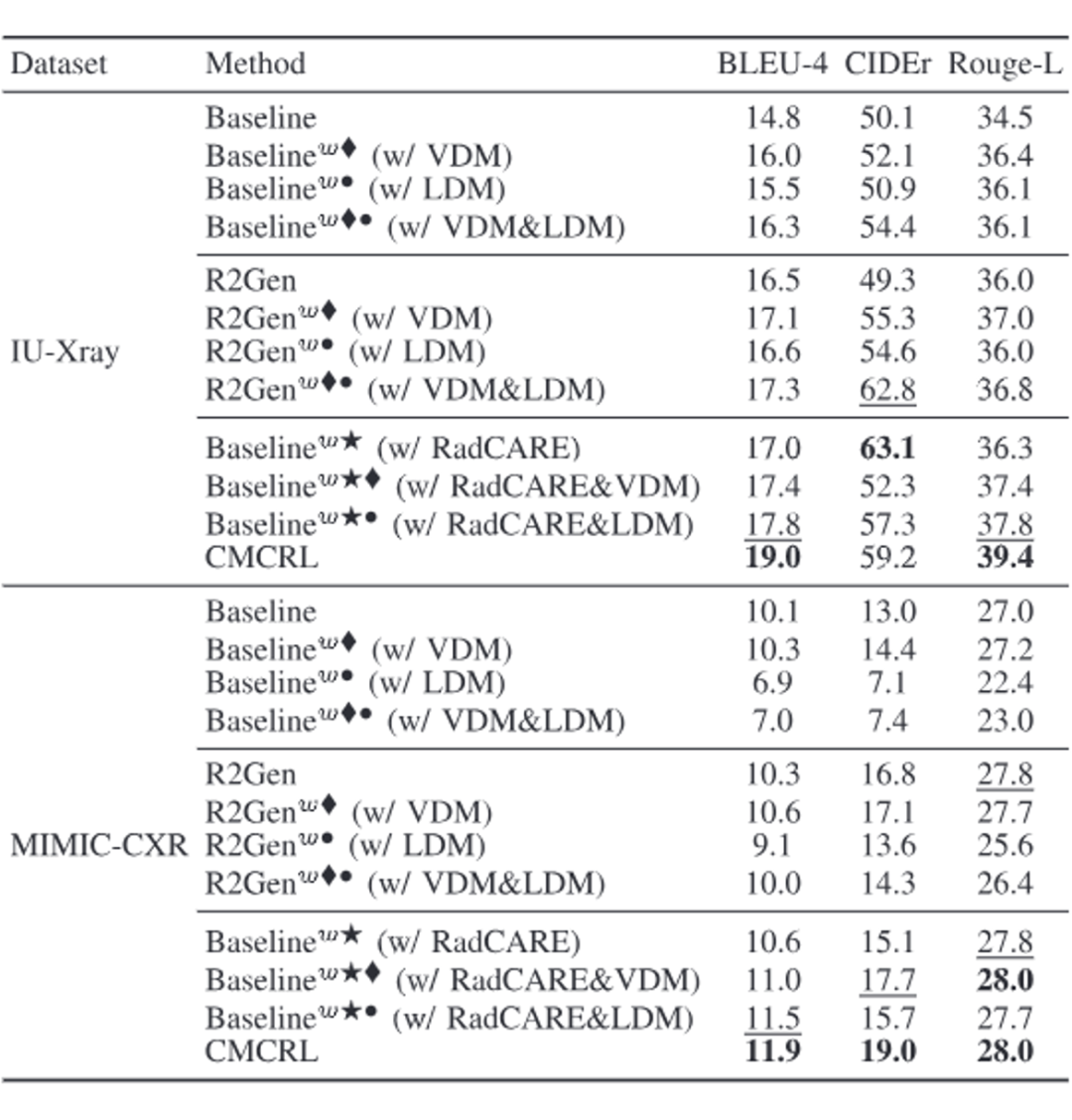

多组实验验证——超越现有方法的性能突破

在 IU-Xray 和 MIMIC-CXR 两大权威数据集上,CMCRL 展示了明显的性能优势。论文中通过 BLEU、ROUGE、METEOR、CIDEr 等自然语言生成指标,以及基于 CheXpert 提取的临床效用(CE)指标,全面验证了该方法在生成长文本报告、消除视觉与语义偏差方面的卓越能力。尤其在表 1 中,CMCRL 在关键评价指标上均取得了领先成绩,表明其在捕捉细微影像特征和准确描述病变信息方面具备显著优势。

▲ 表1. 与主流方法的性能比较

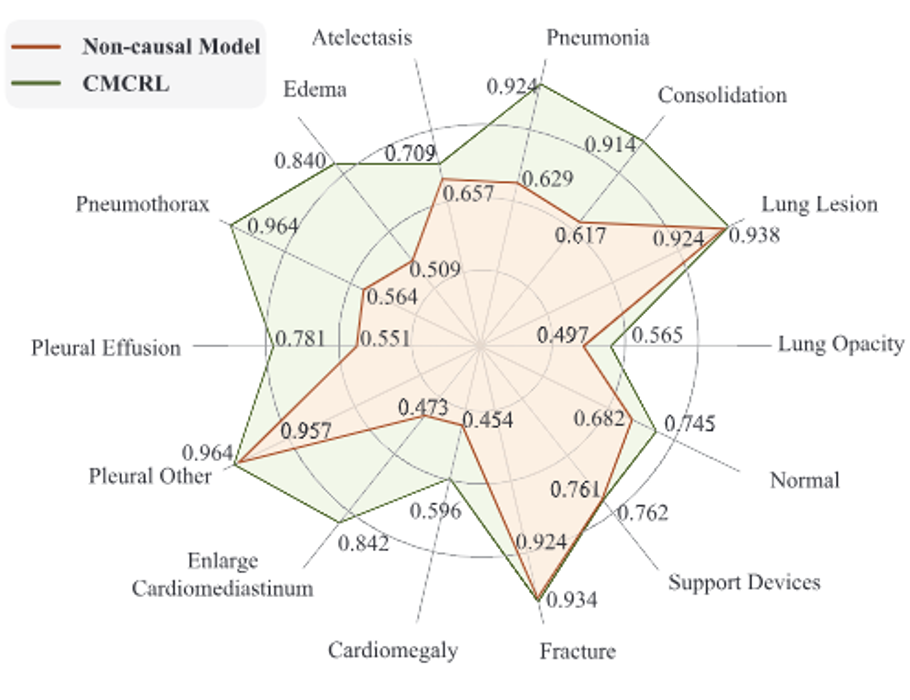

此外,临床有效性评价中,对于关键异常(如 “Edema” 和 “Enlarge Cardiomediastinum”),模型的检测准确率分别大幅提升,例如 “Edema” 从 0.509 提升至 0.840,这表明 CMCRL 能够产生更精准符合临床需求的诊断报告。

为验证各模块的有效性,论文进行了大量消融实验和参数敏感性分析:

-

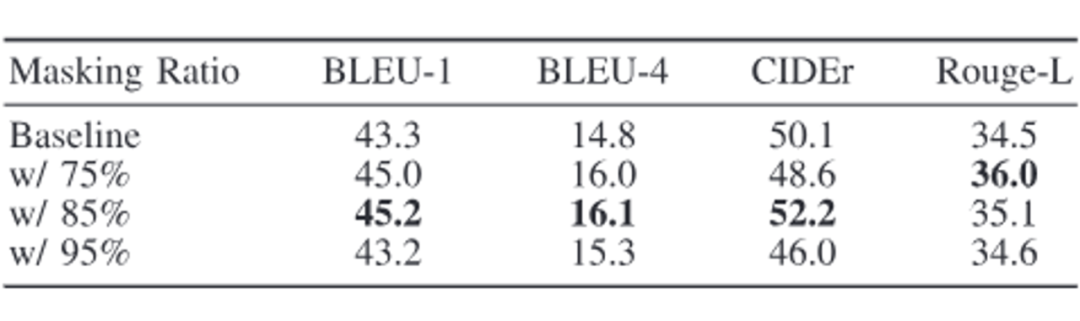

RadCARE 部分:如表 2 所示,通过比较不同遮盖比例的效果(例如 75%、85% 与 95%),发现 85% 的遮盖率能有效平衡信息损失与信息补全,而过高的遮盖率反而导致信息过度缺失。

-

VLCI 部分:如表 3 所示,在消融实验中,单独启用或禁用视觉去混淆模块(VDM)和语言去混淆模块(LDM)的情况下,均能观察到 BLEU、CIDEr 等指标的显著变化,验证了各模块对消除数据偏差,改善生成质量的关键作用。

-

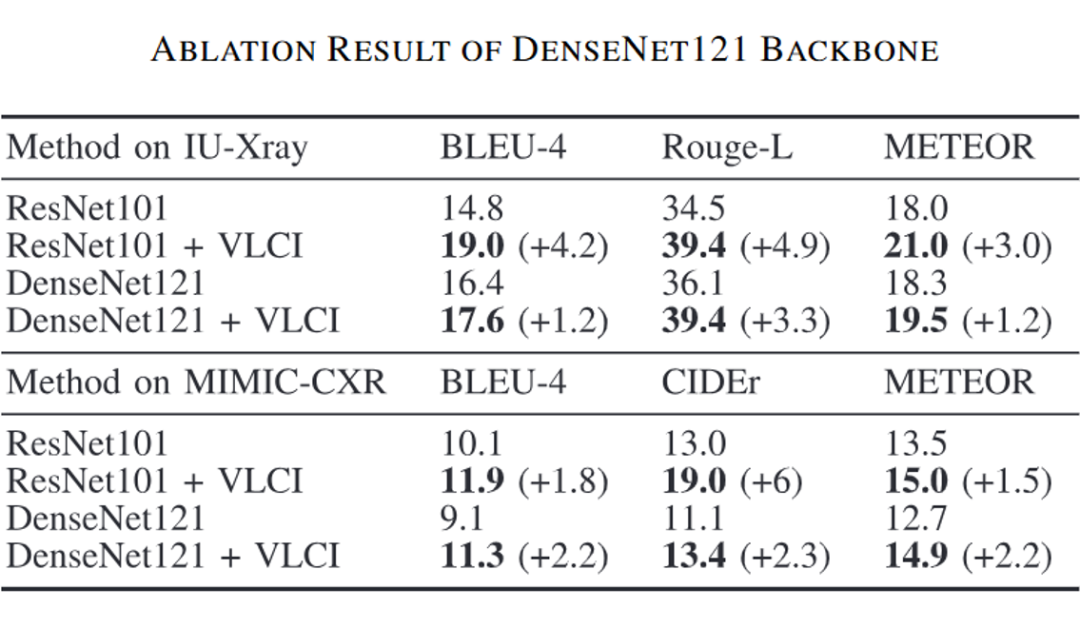

骨干网络的选择:如表 4 所示,论文还对 ResNet101 与 DenseNet121 两种骨干网络进行了对比实验,结果证明 ResNet101 能够更好地捕捉放射图像中的关键细节,为后续的因果干预提供更高质量的特征支持。

▲ 表2. RadCARE 中不同掩码率的性能

▲ 表3. 各模块的消融实验

▲ 表4. 在不同 backbone 模型下的性能

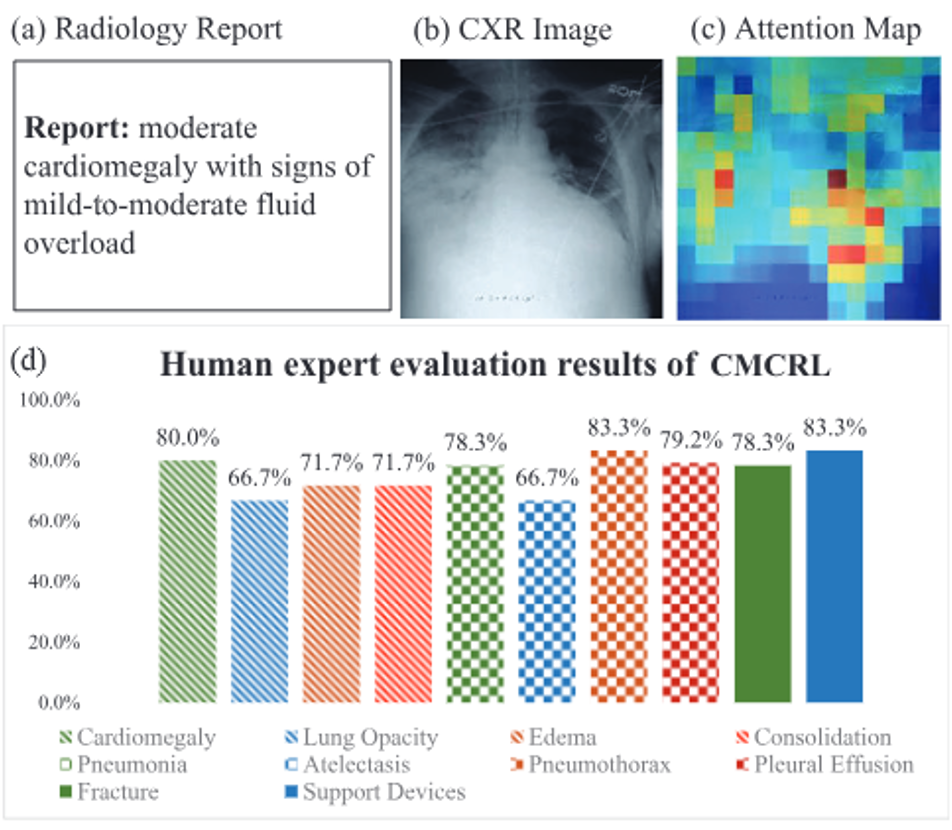

临床应用前景——智能医疗的可信推理之路

放射学报告生成作为缓解医生工作负担的重要方向,其核心在于“既要语言表达流畅,又要临床诊断准确”。CMCRL 的出现,不仅在技术上突破了对数据中伪关联的依赖,更在生成报告时注重真实病灶信息的捕捉。例如,论文中通过 Fig.10 展示的案例,清晰地说明了相比传统方法,CMCRL 在识别肺部病变、心脏异常等复杂病症时,能更好地利用图像局部及全局信息,生成符合临床逻辑的报告文本。未来,该团队计划将该方法进一步扩展到 CT、MRI 及数字病理切片等其他医学影像领域,并探索与大语言模型(LLMs)融合,构建更为完善的因果推理与检索增强生成系统,助推智能医疗应用的临床普及。

总结

这项工作以创新性的跨模态因果表示学习方法,成功构建了一个从预训练到因果干预全链路的报告生成系统,有效消除了视觉与语言之间的伪相关性,提升了放射学报告生成的精度和可靠性。这一突破性的进展为未来智能医疗提供了更具解释性和可信性的技术支持,也为后续研究在多模态融合和因果推理方向拓展了新的思路。通过这项研究,我们看到了在医疗影像分析领域跨模态学习和因果推理的巨大潜力,也为放射学智能诊断系统的实际应用提供了坚实的理论与实践基础。

(文:PaperWeekly)