如果你想跻身 AI 工程师的顶尖 1%,别再浪费时间了,赶紧看看这份清单!

我知道这看起来有点多,一下子学完肯定不现实。但慢慢来,你得搞懂这些库的功能,以及在项目中啥时候用它们。

AI 行业变化快得像坐火箭,半年前的热门技术可能现在已经过时了。公司急需能打造生产级系统的 AI 工程师。很多开发者卡壳,是因为他们只追逐炫酷的玩意儿,比如最新的 GPT 包装器或社交媒体上炒得火热的新框架,却忽略了那些真正区分专业选手和业余玩家的基础库。

有人搞了个酷炫的 ChatGPT 克隆,兴奋得不行,结果一到扩展规模或融入实际业务流程就撞墙了。这就是为什么我整理了这 27 个 Python 库的清单,它们是区分专业 AI 工程师和周末爱好者的完整工具箱。

每个库在 AI 工程中都有特定作用。掌握它们,你就能开发出让企业愿意掏大钱的 AI 应用。

但首先,AI 工程师到底是啥?对不同人来说,定义可不一样。

AI 工程师是谁?

在我看来,AI 工程师专注于把预训练模型整合到应用和产品中。你不是从零开始训练模型,那是机器学习工程师和数据科学家干的事。你是用现成的 AI 能力,把它们塞进企业能用的现实系统里。

换句话说,如果数据科学家发现一个模型能预测客户流失,你就是那个开发系统来阻止流失的人。

作为 AI 工程师,你的核心职责包括:

-

• 打造能每分钟处理上千请求的可靠 APIs。 -

• 设计能稳定处理复杂现实数据的数据流水线。 -

• 创建让复杂 AI 功能用起来简单直观的用户界面。 -

• 确保系统在企业级规模下稳定运行不崩。 -

• 将多个 AI 模型整合成统一的业务流程。

这区别很重要,因为它直接决定了你需要掌握哪些工具。你更关心系统架构、数据流和用户体验,而不是训练算法。

基础与数据准备

1. NumPy

NumPy 是你打造的每个 AI 系统的数学基石。

很多 AI 工程师觉得 NumPy 理所当然,但搞懂它的核心概念能省下无数调试时间。它的威力在处理大数据集时显现,靠 vectorized operations(矢量化操作)让操作百万数据点变得高效,比纯 Python 循环快几百倍。

关键功能:

-

• 优化的 N-dimensional array 对象,内存占用低。 -

• Broadcasting 功能,支持不同尺寸数组的操作。 -

• 元素级数学函数,覆盖整个数组。 -

• 随机数生成,适合 AI 模型测试和验证。 -

• 线性代数操作,机器学习的基石。 -

• 与 C/C++ 和 Fortran 集成,性能拉满。

NumPy 是其他一切的基础。掌握数组索引和广播,你就懂了现代 AI 框架的运行原理。

资源链接:NumPy 官方文档 (https://numpy.org/doc/stable/)

2. Pandas

Pandas 把杂乱的现实数据变成 AI 模型能用的信息。

数据清洗和准备占了我 40% 的 AI 项目时间,Pandas 让这活儿变得能忍受。没有它,处理缺失值或合并数据集得写几百行代码。DataFrame 结构让你像思考一样操作数据,同时保留程序化控制。

关键功能:

-

• DataFrame 和 Series 对象,轻松操作结构化数据。 -

• 强大的数据清洗工具,处理重复值和缺失值。 -

• Group-by 操作,跨维度聚合数据。 -

• 时间序列分析,处理时间数据。 -

• 支持从 CSV、JSON、SQL、Excel 导入/导出数据。 -

• 内存高效,处理超大数据集。

Pandas 连接了原始数据和 AI 就绪数据集。别盯着单个数据点,学会用流水线和转换的思维。

资源链接:Pandas 官方文档 (https://pandas.pydata.org/docs/)

3. Pydantic

Pydantic 让你的 AI 应用在面对用户乱七八糟的数据时不崩盘。

每个 AI 系统都会大量用 Pydantic。它能完全控制验证和转换 AI 应用中乱糟糟的数据,比如用户输入、数据库记录、API 响应。结合类型提示,你的代码自带文档,还能在运行时错误炸掉应用前抓到问题。

关键功能:

-

• 用 Python 类型提示自动验证数据。 -

• 自定义验证器,应对复杂业务逻辑。 -

• 生成 JSON schema,方便 API 文档。 -

• 序列化和反序列化,带错误处理。 -

• 与 FastAPI 集成,自动验证请求/响应。 -

• 支持环境变量的设置管理。

Pydantic 把不可靠的数据变成经过验证的可靠数据。

资源链接:Pydantic 官方文档 (https://docs.pydantic.dev/latest/)

4. Pydantic-Settings

Pydantic-Settings 安全存储敏感数据,把所有配置集中管理。

它能避免把数据库 URL 和 API 密钥硬编码到代码里。配置管理听起来无聊,但它区分了业余项目和专业系统。部署到不同环境(本地、测试、生产)需要不同配置,Pydantic-Settings 通过环境变量自动搞定。

关键功能:

-

• 自动加载环境变量,支持类型转换。 -

• 分层配置,支持默认值和覆盖。 -

• 应用启动时验证配置值。 -

• 支持 .env 文件,方便本地开发。 -

• 支持复杂的嵌套配置对象。 -

• 自动生成配置选项文档。

用 Pydantic-Settings,你的应用既安全又可移植。

资源链接:Pydantic-Settings 文档 (https://docs.pydantic.dev/latest/concepts/pydantic_settings/)

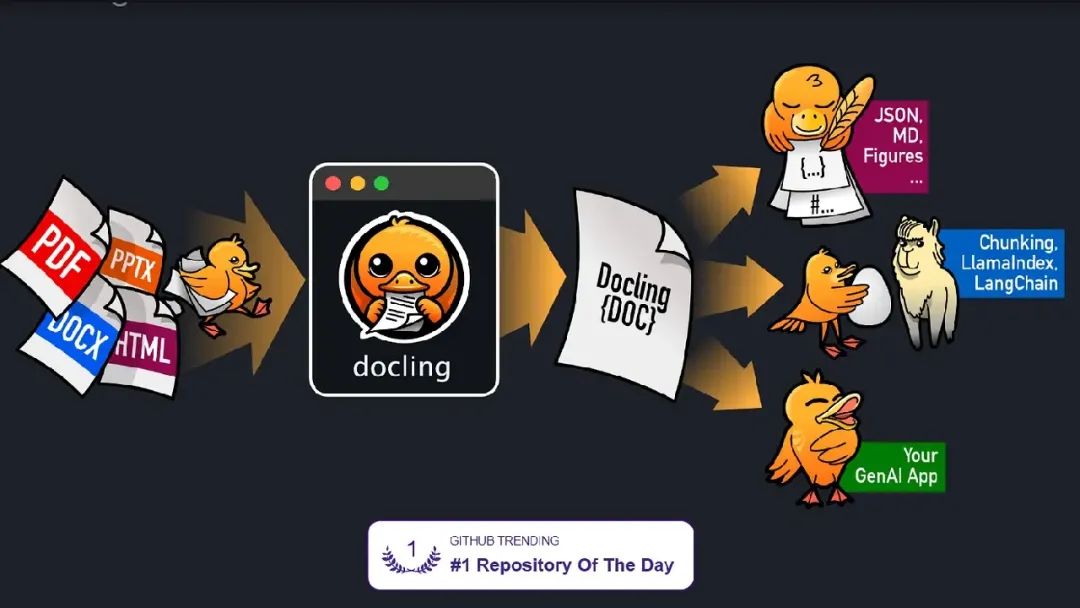

5. Docling

Docling 是 IBM 打造的顶级 AI 文档处理器,专为从 PDF 提取有意义信息。

普通文档处理库只能简单提取文本,但 AI 应用需要保留格式、表格和元数据的结构化数据。Docling 能处理这种复杂性,保持文档元素间的关系。

相比传统解析库,Docling 的提取质量明显更高,尤其对复杂布局。

关键功能:

-

• 高级 PDF 解析,保留布局和表格提取。 -

• 支持多种文档格式,包括 Word、PowerPoint 和图片。 -

• OCR 功能,处理扫描文档和图片 PDF。 -

• 结构化输出,带元数据、格式和层级信息。 -

• 与主流 AI 框架集成,方便后续处理。 -

• 批量处理,搞定大文档集合。

Docling 解决传统需要定制方案的文档处理难题。如果你在处理商业文档,这库能省你几个月开发时间。

资源链接:Docling GitHub 仓库 (https://github.com/docling-project/docling)

后端基础设施与 API

6. Python-Dotenv

Python-Dotenv 让你的密钥安全,配置井井有条。简单但关键,防止你不小心把 API 密钥提交到 GitHub,或把数据库密码硬编码到源码里。

AI 应用的泄密事件常因开发者偷懒配置管理。我见过项目直接在主 Python 文件里暴露 OpenAI API 密钥,谁有仓库权限都能看见。

用 Python-Dotenv 很简单:本地建个 .env 文件,加到 .gitignore,应用自动加载所需环境变量,敏感信息不外泄。

关键功能:

-

• 轻松加载 .env 文件,自动解析环境变量。 -

• 支持变量扩展和默认值分配。 -

• 与现有环境变量工作流集成。 -

• 核心功能无额外依赖。 -

• 跨平台兼容,适应不同开发环境。 -

• 支持开发和测试场景的覆盖功能。

Python-Dotenv 零复杂解决配置管理。一次设置,省去安全隐患。

资源链接:Python-Dotenv GitHub 仓库(https://github.com/theskumar/python-dotenv)

7. FastAPI(我最爱的后端框架)

FastAPI 打造能应对生产级 AI 应用需求的现代 API。当 Flask 太简单、Django 太重时,FastAPI 是你的最佳选择。

自动生成的 API 文档就值回票价。每个端点都有交互式文档,团队能立刻用,代码更新文档也自动同步。

性能对 AI 模型服务很重要,处理每个请求可能要几秒。FastAPI 的 async 支持让你能处理数百并发请求不卡壳,对面向用户的 AI 应用至关重要。

关键功能:

-

• 自动生成带交互式 Swagger UI 的 API 文档。 -

• 用 Pydantic 模型内置数据验证。 -

• Async/await 支持高性能并发处理。 -

• 类型提示集成,提升代码补全和错误检测。 -

• WebSocket 支持实时 AI 应用。 -

• OAuth2 和 JWT 认证,保护 AI 端点。

FastAPI 把你的 AI 模型变成可扩展的专业 API。学习曲线平缓,能力却是企业级的。

资源链接:FastAPI 官方文档 (https://fastapi.tiangolo.com/)

8. Celery

Celery 处理那些耗时太长的 AI 操作,保持 API 响应迅速。AI 工作流常涉及多步操作:数据预处理、模型推理、后处理、结果存储。没有任务管理,用户得等半天,服务器也容易崩。

我每个生产级 AI 系统都用 Celery,它把快速 API 响应和慢速后台处理分开。用户得到即时反馈,AI 工作在后台异步完成。

关键功能:

-

• 分布式任务队列,支持多工作进程。 -

• 结果后端存储,跟踪任务进度和获取输出。 -

• 定时任务,适合定期重新训练 AI 模型。 -

• 生产级任务队列监控和管理工具。 -

• 与 Redis 和 RabbitMQ 等消息代理集成。 -

• 错误处理和重试机制,应对失败的 AI 任务。

Celery 让你的 AI 应用从单用户 demo 扩展到企业级系统。掌握异步工作流,你就能建能应对真实用户负载的 AI 系统。

资源链接:Celery 官方文档 (https://docs.celeryq.dev/en/stable/)

9. SQLAlchemy

SQLAlchemy 让你不用为每次数据库操作写原始 SQL,管理数据持久化。它把 Python 对象和数据库表连接起来,让数据管理变得有趣。

AI 应用的数据库交互很快变复杂。你得存用户输入、模型输出、处理日志和性能指标。SQLAlchemy 让你用 Python 类和关系思考,而不是纠结于 JOIN 语句和外键。

当 AI 应用超简单 CRUD 操作时,ORM 方法更有价值。你需要复杂的分析查询、批量数据处理和模式变更的迁移工具。

关键功能:

-

• 用 Python 类定义数据库表,实现对象关系映射。 -

• 方法链式查询构建器,处理复杂数据库操作。 -

• 连接池和事务管理,确保生产级可靠性。 -

• 通过 Alembic 集成支持迁移,管理模式版本。 -

• 数据库无关代码,支持 PostgreSQL、MySQL、SQLite。 -

• 延迟加载和预加载策略,优化查询性能。

SQLAlchemy 连接数据库存储和 Python 应用逻辑。理解关系模式后,数据库设计会直观得多。

资源链接:SQLAlchemy 官方文档(https://docs.sqlalchemy.org/)

10. Alembic

Alembic 管理 AI 应用增长时的数据库模式变更。它是数据库结构的版本控制,快速迭代数据模型时至关重要。

AI 项目总在变:加字段存模型元数据、建表存用户反馈、或重组数据提升性能。如果迁移管理没做好,这些变更就是部署噩梦。

Alembic 与 SQLAlchemy 配合,跟踪每次模式变更。你能像用 Git 提交代码一样,前进或回退数据库版本。

关键功能:

-

• 从 SQLAlchemy 模型变更自动生成迁移脚本。 -

• 数据库模式版本控制,支持前进和后退迁移。 -

• 批量操作,高效处理大表修改。 -

• 分支和合并,适合并行开发工作流。 -

• 与 CI/CD 管道集成,自动化数据库部署。 -

• 离线迁移生成,适合无数据库访问的环境。

Alembic 防止数据库部署灾难搞垮生产 AI 系统。项目早期用上它,数据库变更就成常规操作。

资源链接:Alembic 官方文档(https://alembic.sqlalchemy.org/)

机器学习核心

11. Scikit-learn

Scikit-learn 是 Python 中经典机器学习的金标准。

虽然大家都在聊深度学习,但现实中大部分 AI 问题还是靠传统算法解决,Scikit-learn 实现得完美。它让你先掌握基础,再进阶复杂架构。

库的 API 设计一致,学会一个算法,其他的也差不多。每个估算器都遵循相同的 fit/predict 模式,方便实验不同方法。

关键功能:

-

• 全面的有监督和无监督学习算法集合。 -

• 一致的 API,涵盖 fit/predict/transform 方法。 -

• 内置交叉验证和模型选择工具。 -

• 特征选择和降维功能。 -

• 数据清洗和转换的预处理工具。 -

• 模型评估指标和性能分析工具。

Scikit-learn 教你机器学习基础,同时提供生产级实现。

资源链接:Scikit-learn 官方文档(https://scikit-learn.org/stable/)

12. TensorFlow

TensorFlow 驱动了全球最大规模的 AI 系统,从 Google 搜索到自动驾驶汽车。它为规模而生,覆盖从移动端到跨千个 GPU 的分布式训练。

TensorFlow 生态庞大:TensorFlow Serving 处理模型部署,TensorFlow Lite 优化移动端,TensorFlow Extended (TFX) 管理整个 ML 流水线。

TensorFlow 2.x 简化了 API,保留了研究和生产的处理能力。

关键功能:

-

• 多 GPU 和 TPU 分布式训练。 -

• TensorBoard 用于模型可视化和调试。 -

• TensorFlow Serving 实现可扩展模型部署。 -

• 移动和边缘部署用 TensorFlow Lite。 -

• TFX 管理完整 ML 流水线。 -

• Keras 集成,提供高级神经网络 API。

TensorFlow 在需要规模化部署模型或用 Google 云基础设施时表现最佳。

资源链接:TensorFlow 官方文档(https://www.tensorflow.org/)

13. PyTorch

PyTorch 改变了研究者对深度学习的思考方式。

Meta 的支持打造了强大的 PyTorch 生态。从研究论文到生产部署,PyTorch 成了 AI 社区的首选框架。

过去,PyTorch 从研究到生产的转换是弱点,但 TorchScript 和 TorchServe 补齐了短板。现在你能用 PyTorch 原型开发,直接部署到生产。

关键功能:

-

• 动态计算图,灵活构建模型架构。 -

• Autograd 自动求导,计算梯度。 -

• 开箱即用的 CUDA 支持 GPU 加速。 -

• TorchScript 用于生产部署和优化。 -

• 通过 torchvision 和 torchaudio 提供预训练模型中心。 -

• 活跃社区,创新研究实现。

PyTorch 适合研究和快速原型开发。如果你要实现新架构或需要最大灵活性,PyTorch 是最佳选择。

资源链接:PyTorch 官方文档(https://pytorch.org/)

14. XGBoost

XGBoost 在表格数据竞赛中称霸有理。

它能处理缺失值、分类特征和不平衡数据,无需大量预处理,在结构化数据集上持续优于其他算法。

最近的 GPU 加速让 XGBoost 在大数据集上快得飞起。以前要几小时的模型训练,现在几分钟搞定,超参数调优也更实际。

关键功能:

-

• 最先进的梯度提升实现。 -

• 内置处理缺失值和分类特征。 -

• GPU 加速训练和推理。 -

• 交叉验证和早停,防止过拟合。 -

• 特征重要性排名,提升模型可解释性。 -

• 与 scikit-learn API 集成,易于采用。

XGBoost 是表格数据问题的首选。从原始数据到生产级模型,它往往是最快路径。

资源链接:XGBoost 官方文档(https://xgboost.readthedocs.io/en/stable/)

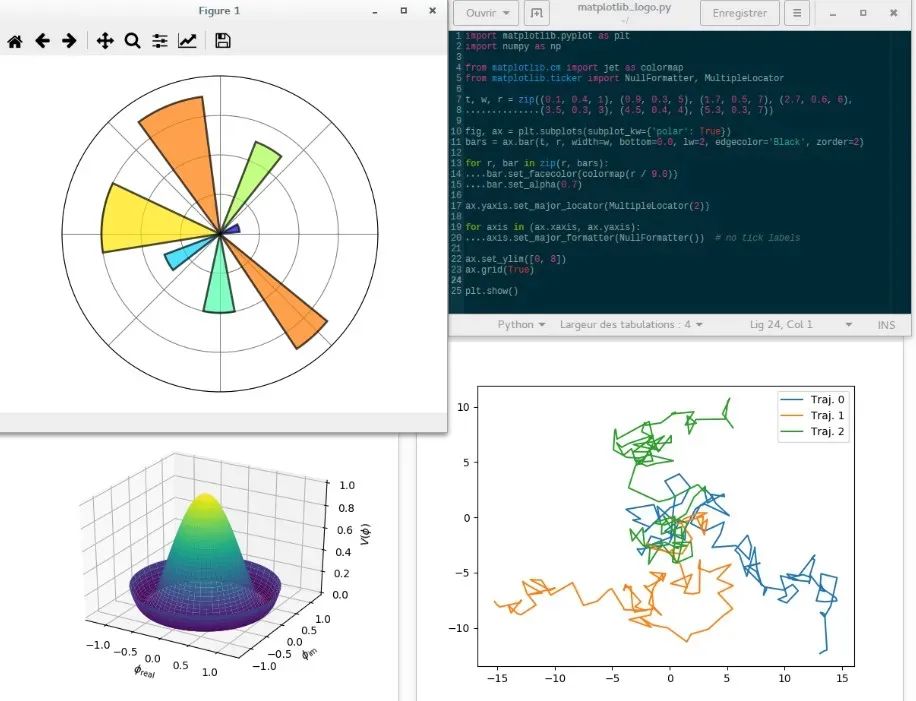

15. Matplotlib/Seaborn

数据可视化比大部分工程师想的更驱动 AI 开发。你得看见数据才能理解,Matplotlib 是 Python 所有可视化库的基础。

Seaborn 基于 Matplotlib,提供适合 AI 项目的统计可视化。在把数据喂给模型前,用回归可视化、相关矩阵和分布图能更好理解数据。

两者结合,从快速探索图到出版级图形全覆盖。Matplotlib 提供底层控制,Seaborn 提供高级统计图形。

关键功能:

-

• Matplotlib 提供对图表每个细节的完全控制。 -

• Seaborn 优化数据分析的统计可视化。 -

• 与 Pandas DataFrame 无缝集成绘图。 -

• 支持交互式后端和基于 Web 的可视化。 -

• 支持多种格式(PNG、PDF、SVG)的出版级输出。 -

• 丰富的主题和样式自定义选项。

好的可视化能发现数据质量问题,保护模型。花时间学好这两个库。

资源链接:Matplotlib 文档 | Seaborn 文档(https://matplotlib.org/)

深度学习与神经网络

16. Keras

Keras 让深度学习易上手又不失强大。它把复杂神经网络架构变成易读的 Python 代码。

先学 Keras,再去碰原生 TensorFlow 或 PyTorch。它的抽象层适合学习概念,不会被实现细节淹没。

Keras 现已集成到 TensorFlow 2.x,提供简单 API 处理常规任务,同时保留 TensorFlow 完整功能。

关键功能:

-

• 高级神经网络 API,模型构建直观。 -

• 预建层支持常见架构(CNN、RNN、LSTM、Transformer)。 -

• Functional 和 Sequential API,适应不同建模方式。 -

• 内置训练循环,带回调监控和控制。 -

• 模型保存和加载,方便部署。 -

• 丰富的预训练模型,支持迁移学习

Keras 加速深度学习开发周期。快速构建原型,再优化到生产无需重写。

资源链接:Keras 官方文档(https://keras.io/)

17. Transformers

Hugging Face Transformers 让你用上最先进的语言模型。

模型中心有上千个预训练模型,随时可用。不管是文本分类、问答还是文本生成,总有适合你的模型。

它用统一 API 处理不同模型架构的复杂性,令人印象深刻。

关键功能:

-

• 通过 Hub 访问上千预训练模型。 -

• 统一 API,支持不同模型架构和框架。 -

• 支持 PyTorch 和 TensorFlow 后端。 -

• 内置优化分词器,适配每种模型。 -

• Pipeline API,无需配置即可快速推理。 -

• 带训练类和优化的微调功能。

Transformers 是现代 NLP 的入口,消除了研究与应用的障碍。

资源链接:Hugging Face Transformers 文档(https://huggingface.co/docs/transformers/index)

18. OpenCV

OpenCV 是计算机视觉项目的重型武器。从基础图像处理到复杂目标检测,它是 CV 应用的支柱超过二十年。

它覆盖传统计算机视觉算法到现代深度学习集成。可以用传统方法预处理图像,再喂给 PyTorch 或 TensorFlow 训练的神经网络。

OpenCV 核心功能用 C++ 优化,支持多核 CPU 或通过 CUDA 和 OpenCL 的 GPU 加速。

关键功能:

-

• 全面的图像和视频处理能力。 -

• 实时计算机视觉,优化 C++ 核心。 -

• 与深度学习框架集成,构建现代 CV 流水线。 -

• 支持多后端(CPU、CUDA、OpenCL)。 -

• 从基础滤波到高级检测的丰富算法集合。 -

• 跨平台支持桌面、移动和嵌入式系统。

OpenCV 连接经典计算机视觉与现代深度学习。

资源链接:OpenCV 官方文档(https://docs.opencv.org/)

19. NLTK

NLTK 提供自然语言处理的基础构建块。

虽然新库聚焦深度学习,NLTK 教你语言学基础,让你明白 NLP 为啥这样工作。它带语料库、示例和详细解释,帮你理解某些 NLP 技术的原理。

NLTK 的分词、词干提取和解析工具对预处理文本很有用,之后再喂给现代语言模型。

关键功能:

-

• 全面的文本处理和语言分析工具。 -

• 大量语料库和词汇资源。 -

• 学习 NLP 概念的教育材料和示例。 -

• 分词、词干提取和词形还原功能。 -

• 词性标注和命名实体识别。 -

• 句法解析和语义分析功能。

NLTK 打下你的 NLP 基础。先用它理解语言处理,再跳到 transformer 模型。

资源链接:NLTK 官方文档(https://www.nltk.org/)

大语言模型整合与框架

20. Instructor

Instructor 把 LLM 的杂乱输出转成结构化的 Python 对象,让你的应用得到干净的数据模型。

太多 AI 项目失败,因为开发者花更多时间解析 LLM 响应,而不是开发功能。Instructor 保证类型安全的输出,消灭这类 bug。

它与 Pydantic 模型集成,兼容任何 OpenAI 兼容的 API。

关键功能:

-

• 自动将 LLM 响应转为 Pydantic 模型。 -

• 类型验证和错误处理,确保结构化输出。 -

• 支持复杂嵌套数据结构和自定义类型。 -

• 与 OpenAI、Anthropic 等 LLM 提供商集成。 -

• 带验证的重试逻辑,提升可靠性。 -

• 流式支持,实时生成结构化数据。

Instructor 消除 LLM 整合的猜谜游戏,让 AI 应用可预测、可维护。

资源链接:Instructor 文档(https://python.useinstructor.com/)

21. LangChain

LangChain 把语言模型连到外部数据源和工具,实现无缝整合。它把静态 LLM 变成能搜索数据库、调用 API 和与现实世界互动的动态智能体。

LangChain 生态庞大,数百个集成覆盖从向量数据库到网页抓取工具,轻松构建复杂 AI 工作流。

它的抽象层很独特。更换 LLM、向量存储或内存系统不用重写应用逻辑。

关键功能:

-

• 链式连接 LLM 操作,构建复杂工作流。 -

• 内存系统,保持对话上下文。 -

• 工具集成,连接 LLM 到外部 API 和数据库。 -

• 向量存储抽象,支持语义搜索和检索。 -

• 智能体框架,支持自主任务执行。 -

• 预建集成和连接器生态。

LangChain 加速 LLM 应用开发。模块化工具和集成简化复杂工作流。

资源链接:LangChain 文档(https://python.langchain.com/docs/introduction/)

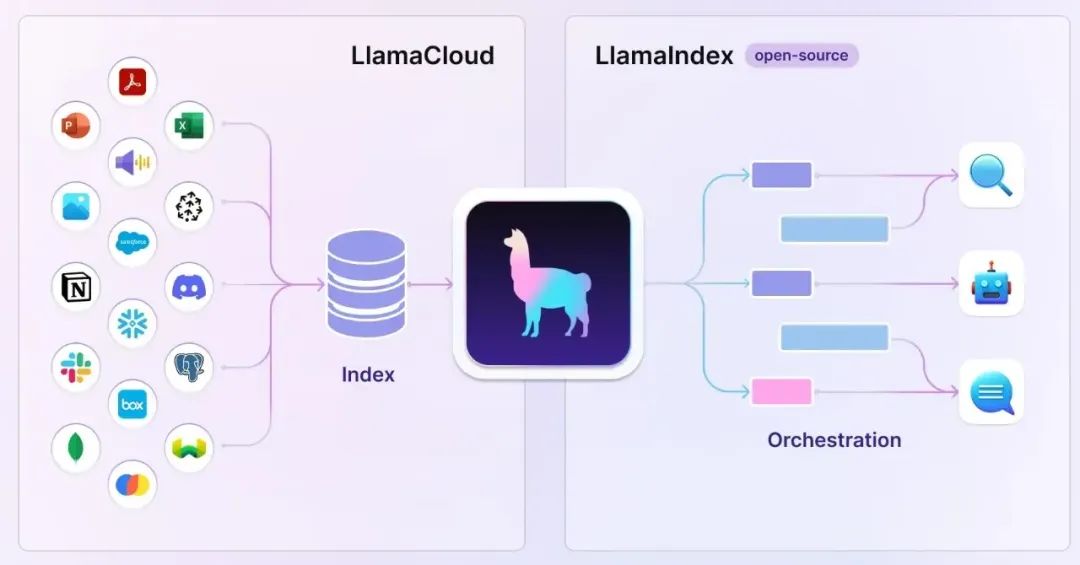

22. LlamaIndex

LlamaIndex 专为连接 LLM 和你的私有数据优化。LangChain 聚焦通用工作流,LlamaIndex 则专为 检索增强生成(RAG) 系统优化。

LlamaIndex 有高级索引技术,自动处理文档分块、嵌入创建和检索优化,让你专注于应用逻辑。

它特别适合企业应用,数据安全和检索准确性比灵活性更重要。它的严格方法配置少,结果更好。

关键功能:

-

• 优化多种文档类型的数据摄取和索引。 -

• 高级检索策略,带排名和过滤。 -

• 支持文本、图像和结构化数据的多模态。 -

• 自动路由和子问题生成的查询引擎。 -

• 与主流向量数据库和搜索引擎集成。 -

• 评估框架,测量 RAG 系统性能。

LlamaIndex 擅长构建生产级 RAG 系统。数据检索准确性关键时用它。

资源链接:LlamaIndex 文档(https://docs.llamaindex.ai/en/stable/)

23. DSPy

DSPy 用编程取代提示工程。你不用手动写提示,只需定义系统要干啥,DSPy 自动优化提示。

从提示到编程的范式转变提升了 LLM 应用的可靠性。你的提示被当做可学习参数,根据训练数据和成功指标优化。

DSPy 处理复杂多步推理很厉害。传统提示链容易断,DSPy 的编译程序自动适应不同场景。

关键功能:

-

• 根据训练示例自动优化提示。 -

• 可组合模块,构建复杂推理系统。 -

• 支持多步推理,带自动回溯。 -

• 与多种 LLM 提供商和本地模型集成。 -

• 基于指标的任务性能优化。 -

• 编译过程生成优化的提示和权重。

DSPy 让 LLM 应用更健壮、可维护。它是构建可靠 AI 系统的未来。

资源链接:DSPy 文档(https://dspy.ai/)

生产与专业工具

24. Pinecone

Pinecone 处理大规模向量存储和相似性搜索。当你的 AI 应用需要从百万文档或图片中找相关信息,传统数据库就不够用了。

它的托管服务省去自己运行向量数据库的复杂性。你不用操心索引优化、分片或集群管理,Pinecone 搞定基础设施,让你专注应用。

实时更新是 Pinecone 的亮点。你能在服务查询的同时插入、更新、删除向量,适合数据频繁变化的动态应用。

关键功能:

-

• 托管向量数据库,自动扩展和优化。 -

• 即使数十亿向量,查询性能也亚秒级。 -

• 无中断的实时向量更新。 -

• 多种索引类型,优化不同用例。 -

• 内置元数据过滤,支持混合搜索。 -

• 支持 Python、JavaScript 等流行语言 SDK。

Pinecone 解决向量数据库的麻烦。你的相似性搜索即使大规模也能正常工作。

资源链接:Pinecone 文档(https://docs.pinecone.io/guides/get-started/overview)

25. Langfuse

Langfuse 为 LLM 应用提供可观察性。你没法改进你测不了的东西,LLM 应用如果没好监控,调试和优化就是噩梦。

它跟踪从令牌使用、延迟到用户反馈和模型性能的一切。这种可见性对了解生产中 AI 应用的表现至关重要。

你能用 Langfuse 识别提示变体的性能。没有这级监控,优化是不可能的。

关键功能:

-

• 全面的 LLM 应用监控和分析。 -

• 跨不同模型和提供商的成本跟踪。 -

• 用户反馈收集和分析工具。 -

• 提示和模型比较的 A/B 测试框架。 -

• 与主流 LLM 框架和提供商集成。 -

• 自定义指标和仪表盘,满足特定用例。

Langfuse 让 LLM 应用可测量、可改进。生产 AI 系统需要这种监控。

资源链接:Langfuse 文档(https://langfuse.com/docs)

26. PyMuPDF

PyMuPDF 精准提取 PDF 的文本、图片和元数据。很多库能读 PDF,但 PyMuPDF 保留格式、处理复杂布局,处理速度还快得惊人。

PDF 处理复杂,因为文档常含嵌入字体、旋转文本、表格和图片,简单库常处理不好或直接忽略。

它特别适合为 RAG 系统 准备文档,保留文档结构和元数据,帮 LLM 更好理解上下文。

关键功能:

-

• 高保真文本提取,保留格式。 -

• 图片提取和操作功能。 -

• 访问元数据,包括文档属性和注释。 -

• 页面渲染成图片,供视觉处理。 -

• 文档修改和创建功能。 -

• 优化的快速批量处理。

PyMuPDF 处理 PDF 复杂性,让你的 AI 应用接收干净的结构化数据,而不是乱七八糟的文本。

资源链接:PyMuPDF 文档(https://pymupdf.readthedocs.io/en/latest/)

27. Jinja

Jinja 为 LLM 应用生成动态提示。它提供强大的模板系统,优雅处理复杂的提示构建。

模板继承和宏让管理大型提示库变得可维护。你能为不同任务类型创建基础模板,针对特定用例扩展,不用重复代码。

Jinja 模板的条件逻辑和循环支持让你建复杂提示,根据上下文、用户数据或对话历史自适应。

关键功能:

-

• 强大的模板语法,支持变量、循环和条件。 -

• 模板继承,支持可复用的提示组件。 -

• 内置文本处理和格式化过滤器。 -

• 宏系统,封装复杂提示逻辑。 -

• 沙箱执行环境,确保安全。 -

• 与 Web 框架和独立应用集成。

Jinja 改变你的提示管理,让维护更轻松。

资源链接:Jinja 文档

最后思考

这 27 个库是 AI 工程的支柱。

从 NumPy 的数值基础到 Pinecone 的向量搜索能力,每个库在 AI 开发堆栈中都有特定作用。

知道啥时候用哪个库是一项需要时间培养的技能。

数据操作用 Pandas,API 开发用 FastAPI,向量操作用 Pinecone ,当然还有一些开源轻量的向量数据库比如:Chroma Milvus(由于工作量比较多啊,本次笔者就没整理在内,之前文章有过专门的向量数据库对比,感兴趣的欢迎去翻阅)等专业数据库。

这些库能帮你开启成为顶尖 1% AI 工程师的旅程。

现在,去学去建吧!在评论里告诉我你的想法!如果有您觉得值得推荐的也欢迎评论区留言,笔者会再去整理。

(文:PyTorch研习社)