亚马逊发布 Kiro,一个新的 Agentic IDE,能处理‘规格’和架构图来搞定更复杂的任务。

预览阶段免费:https://t.co/Ne5m2Nh4wC,可以看到两款模型。

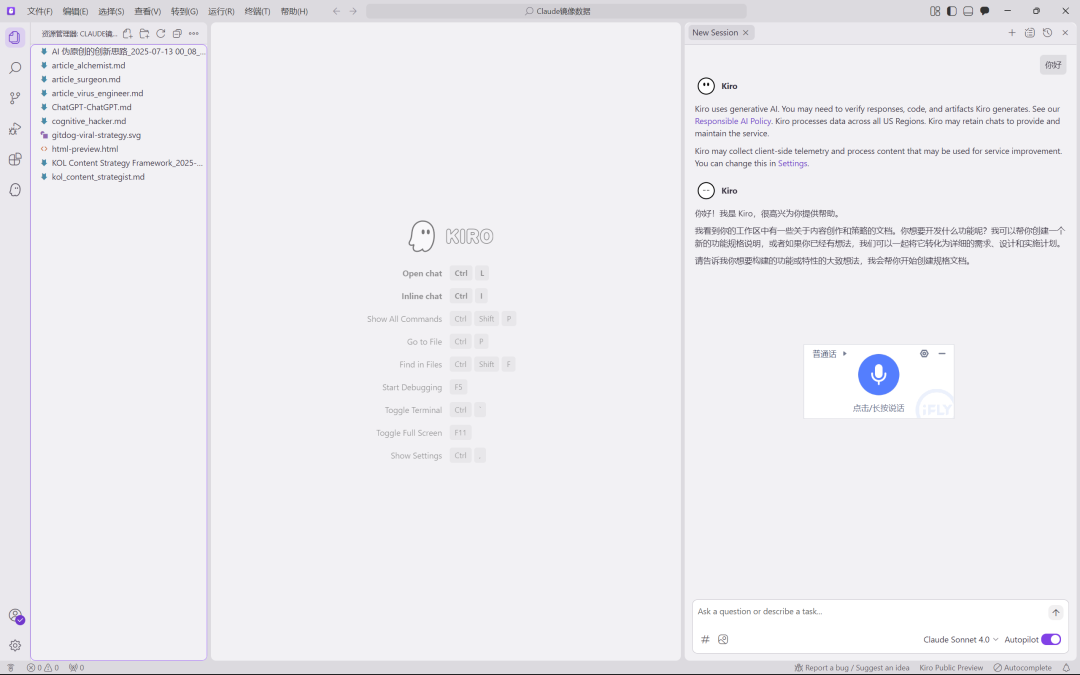

这是又一个 VS Code 的闭源分支。

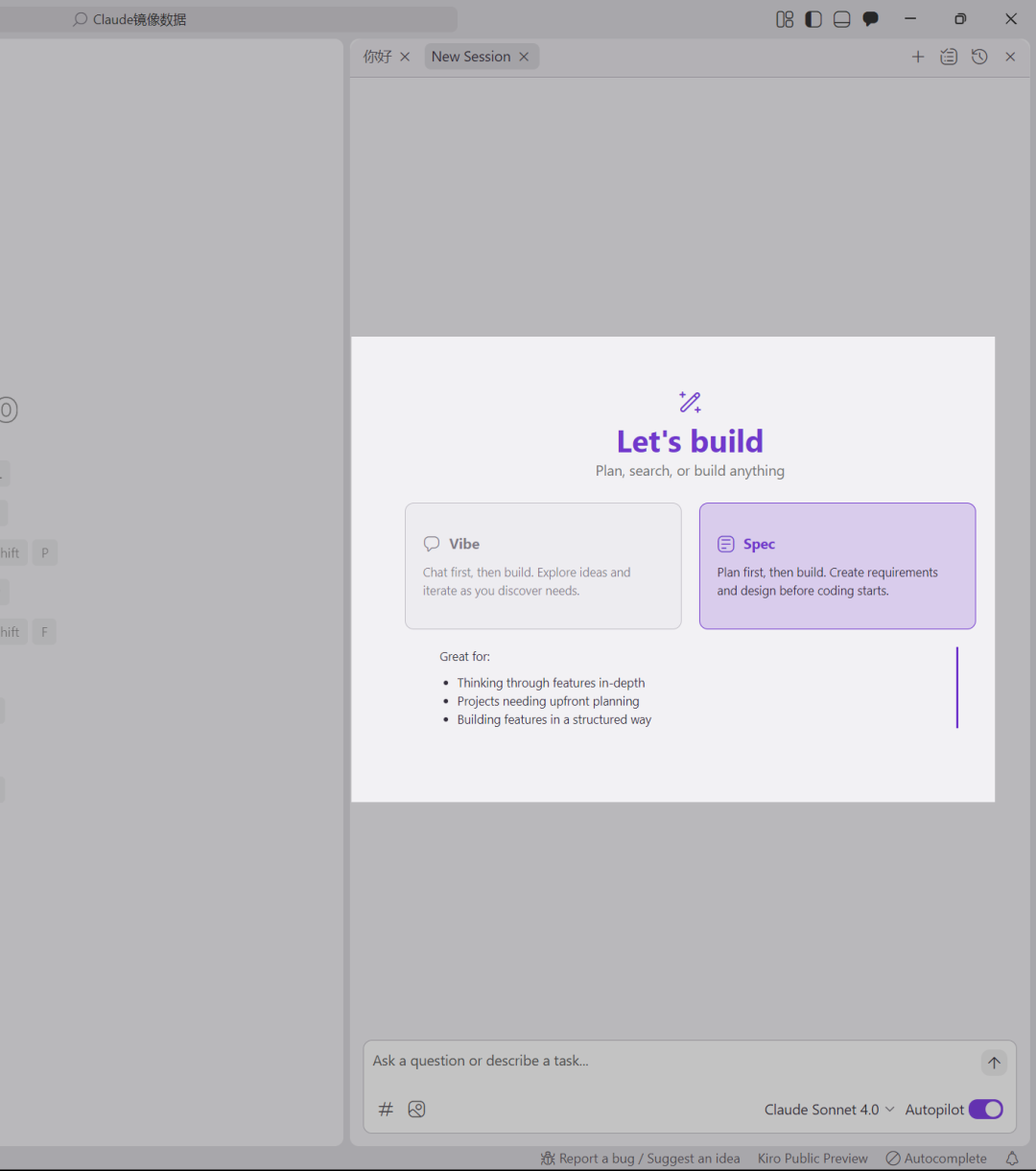

有氛围编码和规划两种模式。

氛围编码 (Vibe Chat & Build):

探索想法,并在发现需求时进行迭代。首先是Vibe Chat,然后是build。

规划 (Plan & Build):

先制定详细计划,再构建。在开始编码之前创建需求和设计。

Kiro 的特色:规约 (Specs) 与挂钩 (Hooks)

-

规格驱动开发 (Spec-driven development): Kiro 帮你用自然语言和架构图,把复杂功能的需求和设计说清楚。有了这么全面的上下文,Kiro 的 AI Agent 就能用更少的迭代次数,交出更好的结果。

-

智能 Agent 挂钩 (Intelligent agent hooks): 写文档、写测试、性能优化这些烦人但又重要的活儿,Kiro 能自动处理。这些“挂钩”会在后台运行,由保存文件、提交代码这些事件触发。就像有个经验丰富的老鸟在旁边 review 你的工作,顺手把那些容易拖延的维护任务都给干了。

用“规约”和“挂钩”来创造,分三步

以一个电商App,加上一个“用户评价系统”为例。

第一步:从一句话,到一份清晰的需求清单。

输入一句话:“给产品加上评价系统。” Kiro会把它拆解成一份完整的需求文档,包括查看、创建、筛选、给评论打分等所有用户故事。容易被忽略的边缘情况,它用EARS语法写好。

第二步:从需求,到一份技术设计图。

Kiro会分析你的代码库和刚刚确认的需求,然后,生成一份设计文档。数据流图、TypeScript接口、数据库结构、API端点……

第三步:开始实施。

Kiro会生成所有任务和子任务,并根据依赖关系排好序。每个任务都包含了单元测试、加载状态、移动端适配、无障碍等等细节。你只需要一步步确认,看着进度条走完。

用“挂钩”,在代码提交前抓住问题

代码写完,准备提交了。你的脑子里是不是会闪过一串清单:我有没有搞坏什么?测试更新了吗?文档写了吗?这种谨慎是好事,但手动检查太累了。

Kiro的“挂钩” (Hooks) 就是你的自动化“老法师”。你只需要设置一次,比如:

-

每次保存React组件时,自动更新测试文件。

-

每次修改API端点时,自动刷新README文档。

-

每次准备提交时,自动扫描有没有泄露密钥。

它会像一个不知疲倦的伙伴,帮你和你的整个团队,执行统一的质量、代码和安全标准。

ONE MORE THING

Anthropic 的 Alex Albert 发推宣布:Claude Code 今天更新,原生支持 Windows 了。

想上手的话,先装 Git for Windows,然后正常运行 Claude Code 的安装命令就行。用 WSL (Windows Subsystem for Linux) 的方式也还支持。

安装指南:https://docs.anthropic.com/en/docs/claude-code/setup

当然最近 Kimi K2 出来了,为你的 Claude Code 替换 Kimi 模型作为 API,可以这样设置:

export ANTHROPIC_AUTH_TOKEN=你的月之暗面-API-Key

export ANTHROPIC_BASE_URL=https://api.moonshot.cn/anthropic也可以使用这个项目自动化设置:https://github.com/LLM-Red-Team/kimi-cc

Claude Code 官方中文文档

包含了快速开始、内存管理和常见工作流等。

官方文档链接:https://docs.anthropic.com/zh-CN/docs/claude-code

封的这么严重,写个中文文档… 可能,给新加坡华人看的…

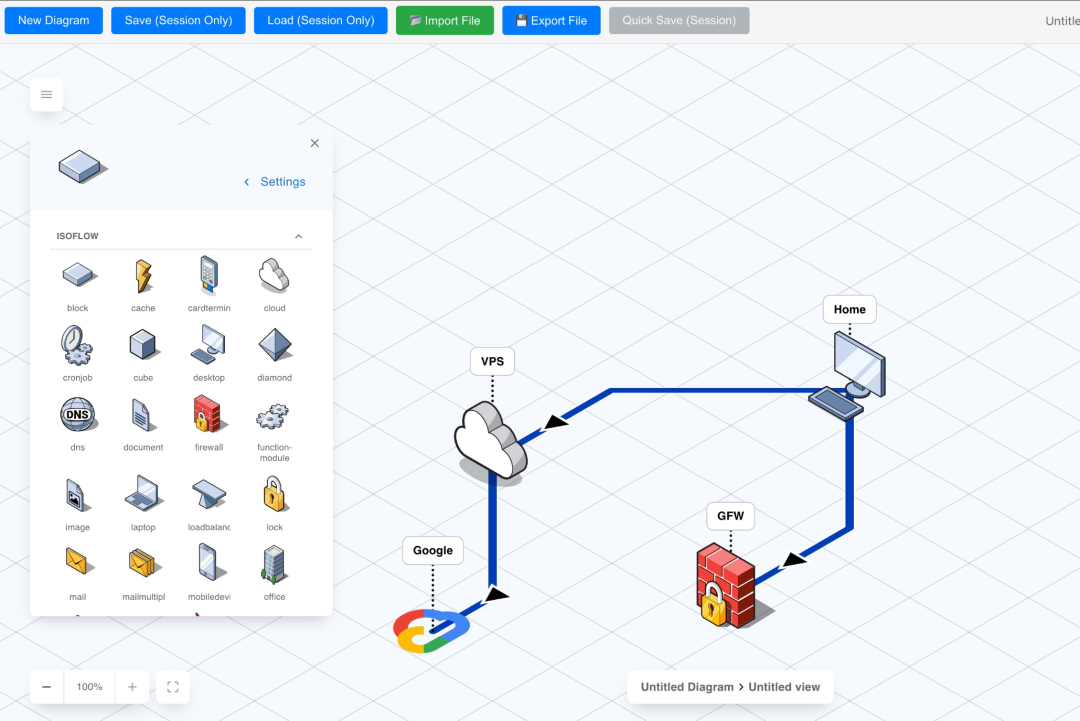

免费开源的等距绘图工具 FossFLOW,能直接在浏览器中创建漂亮的 3D 风格技术图表。 https://t.co/Uq6AwpkIOG

更多类似的:

https://icraft.gantcloud.com/

https://www.cloudcraft.co/

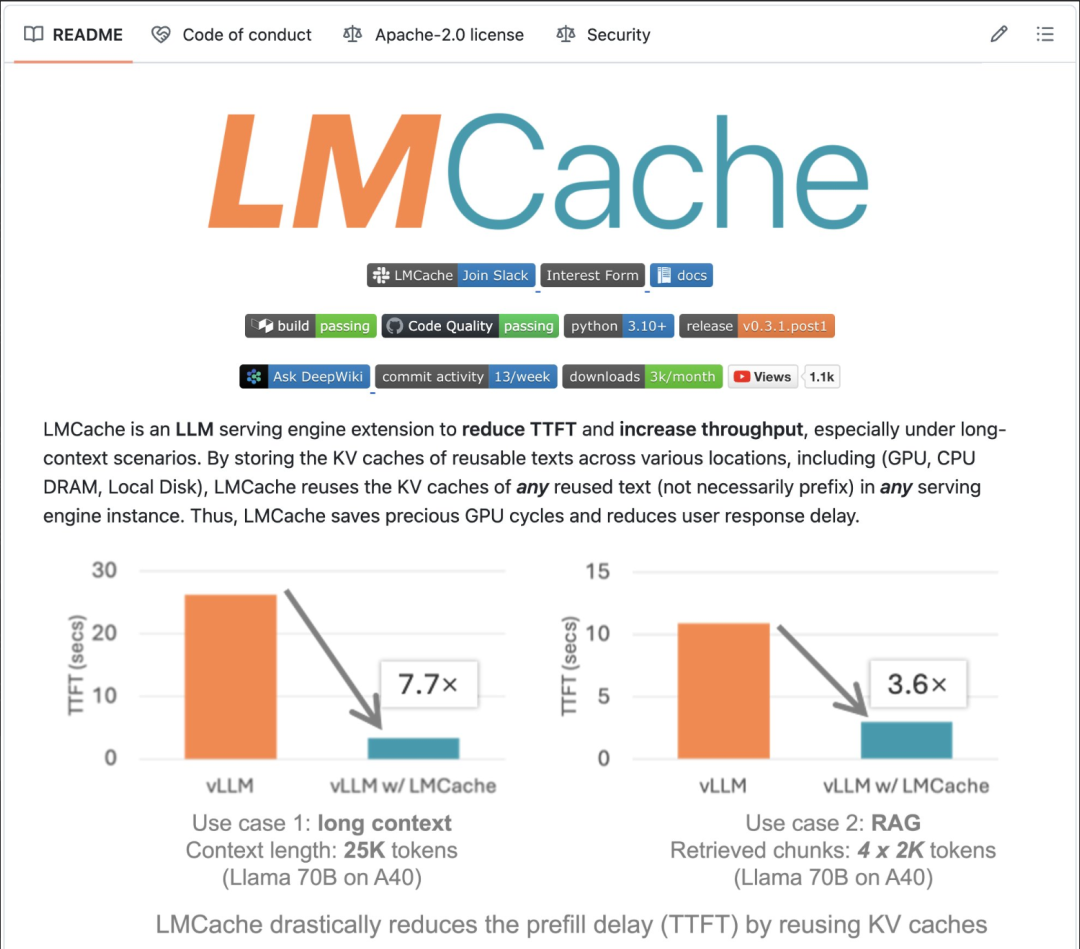

最快的 LLM 服务引擎:LMCache

这是一个 LLM 服务引擎,旨在减少第一个令牌的时间并提高吞吐量,尤其是在长上下文场景中。它通过将对 KV 缓存的访问速度提高 7-100 倍来提升 vLLM。 https://t.co/f9vvUucTne

更多AI实践与资讯

本号知识星球(汇集ALL 订阅频道合集和其他):

🌟 知音难求,自我修炼亦艰,抓住前沿技术的机遇,与我们一起成为创新的超级个体(把握AIGC时代的个人力量)。

点这里👇关注我,记得标星哦~

(文:AI进修生)