Jason Wei:OpenAI研究科学家,OpenAI思维链研究开创者,《Chain-of-thought prompting elicits reasoning in large language models》论文第一作者,谷歌学术他引17000余次(CoT单篇),高中学历,毕业于全美顶级的科技高中:托马斯·杰弗逊科学技术高中,sat 2390(2400满分),强化学习大神

在刚刚爆出被小扎挖走,加入meta超级智能实验室后,Jason Wei 连发两篇文章,一篇是关于 AI 发展的核心驱动力公式——“验证者定律”,另一篇则是从强化学习中悟出的人生哲学——“人生要走 On-Policy 路线”,这可能就是jason wei 在OpenAI最后的遗作了吧

验证者定律说的是:训练人工智能解决一个任务的难易程度与该任务的可验证性成正比。所有可以解决且易于验证的任务都将被人工智能解决

On-policy RL说的是强化学习对人生的启示:要想青出于蓝而胜于蓝,就必须走自己的路,直面环境给予的风险与回报

看起来像是离职感言,哈哈哈,我们来看看具体的两篇文章说的啥

Jason Wei@_jasonwei

第一篇

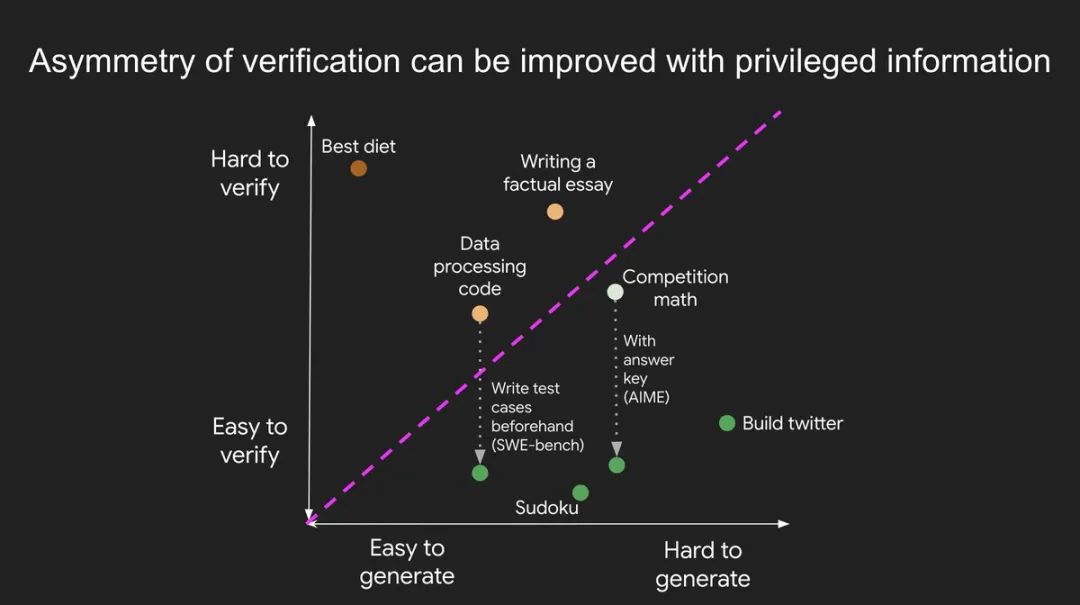

验证的不对称性——即“验证某些任务远比解决它们更容易”这一理念——正变得日益重要,因为我们终于有了能广泛奏效的强化学习(RL)技术。

验证不对称性的绝佳例子包括:数独谜题、为 Instagram 这样的网站编写代码,以及 BrowseComp 问题(通常需要浏览约100个网站才能找到答案,但一旦有了答案,验证起来就很容易)。

也有些任务的验证具有近乎对称性,比如计算两个900位数字的和,或编写一些数据处理脚本。还有些任务,提出可行的解决方案比验证它们要容易得多(例如,对一篇长文进行事实核查,或提出一种像“只吃野牛”这样的新饮食法)。

关于验证不对称性,需要理解一个要点:你可以通过一些前期工作来增强这种不对称性。例如,如果你手握一道数学题的答案,或者一个 LeetCode 问题的测试用例。这极大地扩展了具有理想验证不对称性的问题集合。

“验证者定律”(Verifier’s Law) 指出:训练 AI 解决一个任务的难易程度,与该任务的可验证性成正比。** 所有可能被解决且易于验证的任务,都终将被 AI 解决。训练 AI 解决任务的能力,取决于该任务是否具备以下特性:

-

1. 客观真理:对于什么是好的解决方案,人人都有共识。 -

2. 快速验证:任何给定的解决方案都可以在几秒钟内完成验证。 -

3. 可规模化验证:可以同时验证大量的解决方案。 -

4. 低噪声:验证结果与解决方案的真实质量尽可能高度相关。 -

5. 连续奖励:可以轻松地对同一个问题的多个解决方案进行优劣排序。

验证者定律一个最明显的例证是:AI 领域提出的大多数基准测试(benchmark)都易于验证,并且迄今为止都已被攻克。你会发现,过去十年几乎所有流行的基准测试都符合上述标准1-4;不符合这些标准的基准测试,很难流行起来。

为什么可验证性如此重要?因为当上述标准得到满足时,AI 的学习效率会最大化;你可以进行大量的梯度更新,并且每一步都包含着丰富的信号。迭代速度是关键——这正是数字世界的进步远比物理世界快得多的原因。

谷歌的 AlphaEvolve 是利用验证不对称性的最伟大范例之一。它专注于那些完全符合上述标准的环境设定,并在数学等领域取得了一系列进展。与过去二十年我们在 AI 领域的做法不同,这是一种新的范式:所有问题都在一个训练集与测试集等同的环境中进行优化。

验证的不对称性无处不在,一个“万物皆可衡量,万物皆可被解决”的参差不齐的智能世界,正令人无比兴奋

第二篇

在过去一年里,我成了强化学习(RL)的铁杆粉丝,醒着的大部分时间都在思考RL,这无意中教会了我一个关于如何过好自己人生的重要道理。

RL 中有一个重要的概念,就是你总是希望自己是“同策略的”(on-policy):与其模仿他人的成功轨迹,你更应该采取自己的行动,并从环境给予的奖励中学习。 显然,模仿学习在初期“冷启动”、达到一个非零成功率时很有用,但一旦你能走出合理的轨迹,我们通常会避免模仿学习,因为要最大化发挥模型自身的优势(这与人类不同),最好的方式就是只从它自己的轨迹中学习。一个广为接受的例子是:相比于简单地在人类书写的“思维链”上进行监督微调,强化学习是训练语言模型解决数学应用题的更好方法。

人生也是如此。我们首先通过模仿学习(上学)来完成自我引导,这非常合理。但即使毕业后,我仍然习惯于研究他人如何成功,并试图模仿他们。有时这会奏效,但最终我意识到,我永远无法完全达到别人的高度,因为他们是在发挥自己的长处,而这些长处我并不具备。这可以是任何事,比如一个研究员做起实验(yolo runs)比我更成功,因为代码库是他自己搭建的,我不是;或者一个非AI的例子,一个足球运动员利用我所不具备的力量优势来控球。

On-policy RL给我的启示是:要想青出于蓝而胜于蓝,就必须走自己的路,直面环境给予的风险与回报。 例如,有两件事我比一般研究员更享受:(1)阅读大量数据,以及(2)做消融实验来理解系统中单个组件的效果。有一次在收集数据集时,我花了好几天阅读数据,并给每位人类标注员提供了个性化的反馈,之后的数据质量非常出色,我也对试图解决的任务获得了宝贵的洞察。今年早些时候,我花了一个月时间,系统性地对我之前凭感觉(yolo’ed)做下的每个决定进行消融实验。这花费了相当多的时间,但通过那些实验,我学到了关于哪种 RL 效果好的独到见解。全身心投入自己的热情所在,不仅让我更有成就感,而且我现在感觉自己正走在一条为自己和我的研究开辟更强大生态位(niche)的道路上。

简而言之,模仿是好的,初期你必须这么做。但一旦你完成了冷启动,要想超越老师,你就必须走 on-policy 的强化学习路线,发挥你自己的长处和短处 🙂

参考:

https://jasonwei.net/blog/asymmetry-of-verification-and-verifiers-law

(文:AI寒武纪)