Qwen2.5的RL训练过程主要分为两阶段,第一阶段为离线阶段做DPO,第二阶段为在线阶段使用偏好RM做GRPO,两阶段RL主要是针对通用场景来做的。

不同于Qwen2.5,过去一段时间基于RL推理的大火为后训练带来了新的方向,Qwen3也着重在后训练阶段提升模型的推理能力,并且一个关键创新为将思考模式和非思考模型集成到一个统一的框架中,这使得模型既拥有拥有复杂多步骤推理的能力(例如QwQ-32B),也能够基于上下文进行快速响应(例如GPT-4o)。

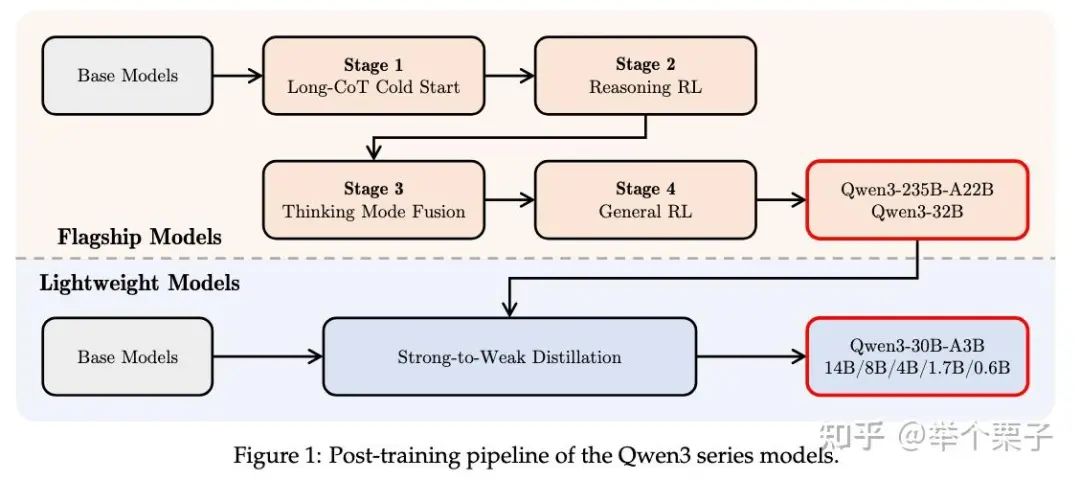

Qwen3是如何实现以上功能的呢?一图以蔽之

Qwen3-235B-A22B和Qwen3-32B使用四阶段的训练过程,前两个阶段侧重于提升模型的“思考”能力。接下来的两个阶段旨在将 “非思考” 功能集成到模型中。而Qwen3-30B及以下尺寸的模型采用蒸馏的方式,提升模型的Pass@1分数。接下来详细解读一下其四阶段的训练过程。

阶段一:冷启动训练

冷启动数据集主要覆盖数学、代码、逻辑推理、和STEM问题,这部分数据需要经过严格的筛选,否则冷启动训练后模型的通用能力可能会劣化,因此报告中说明他们对query和response分别都进行了筛选。

1.Query筛选:目的是筛选出过于简单和难于验证的问题。前者使用Qwen2.5-72B-Instruct进行推理,如果不使用CoT即可回答正确,那么对这种query进行筛除;后者同样使用Qwen2.5-72B-Instruct,识别包含多个子问题和要求生成一般文本内容的问题,对这种query也进行筛除。

2.Response筛选:使用QwQ-32B为每个query生成N个候选回复。对于QwQ-32B无法回答正确的问题,会人工再评估一遍回复的准确性;对于多个回答均正确的问题,会使用以下6个准则进一步筛选:

-

• (1)最终答案错误 -

• (2)包含大量重复 -

• (3)在没有充分推理的情况下明确猜测答案 -

• (4)think和summary内容不一致 -

• (5)包含多语种或风格跳变 -

• (6)和验证集过于相似,有以上问题的回答也会被筛除。

Response筛除的目的是在模型中注入基础推理模式,但并不强调推理性能,这样保证模型的推理潜力不受限制且不过拟合,为第二阶段RL打下基础。

报告中未提及冷启动阶段的数据量。

阶段二:RL推理能力训练

RL训练Query遵循以下4个原则进行筛选:

-

• (1)未在冷启动阶段使用 -

• (2)对于冷启动模型来说是可学习的 -

• (3)需要有一定的难度 -

• (4)包含多个领域。

满足以上四点后选择了3995个query-verifier对(和冷启动的数据覆盖范围应该是一样的,但是这个数据量真的好少啊),在GRPO训练过程中,通过控制模型的熵,对exploration和exploitation进行了平衡,从而实现平稳的训练。

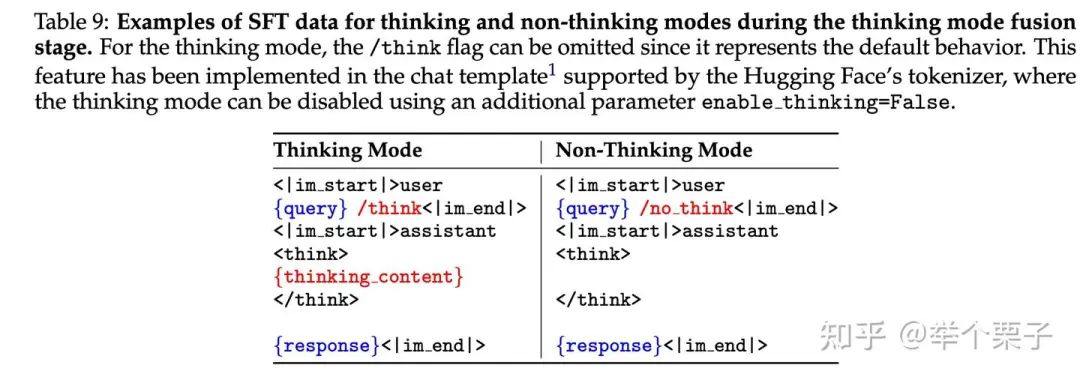

阶段三:思考模式融合

这一阶段是通过SFT的方式对阶段二得到的模型进行微调,融合“思考”和“非思考”模式的推理。为了保证阶段二性能不受影响,这里“思考”训练数据采用阶段二模型在阶段一query数据上做拒绝采样得到;“非思考”数据涵盖各种任务,包括编码、数学、指令遵循、多语言任务、创意写作、问答和角色扮演。

两种模式使用/think和/no_think标志进行区分,注意“非思考模式”也有开始<think>和结束</think>的标志符,只是其思考过程置为空。并且在训练过程中,会针对多轮对话进行“思考”和“非思考”模式的混合训练。

阶段四:通用RL

这一阶段旨在提升模型在不同场景下的通用能力和稳定性,涵盖了 20 多个不同的任务,针对不同任务有针对性的评分标准及奖励模型。目的在于提升以下多种任务下的能力:

-

• (1)指令跟随任务 -

• (2)融合思考模式的格式跟随任务 -

• (3)开放任务下与人类偏好对齐 -

• (4)多轮对话下的长期决策任务 -

• (5)定制化任务如搜索等

具体地,他们采用三种不同的奖励:

-

• Rule-based reward:主要用在推理任务、指令跟随、格式跟随任务上 -

• Model-based Reward with Reference Answer:提供每个query的参考答案并提示 Qwen2.5-72B-Instruct 根据参考答案对response进行评分。这种方法无需严格的格式设置,进一步避免因为rule-based reward漏检造成的hacking问题 -

• Model-based Reward without Reference Answer:即基于人类偏好训练的BT model,用在通用任务上,提高模型的参与度和有用性

Strong-to-Weak Distillation

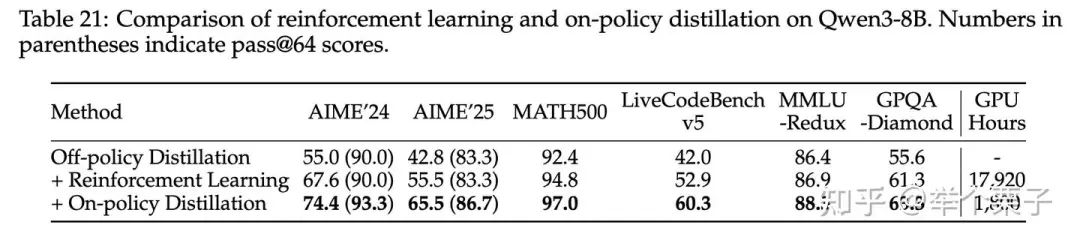

主要是针对小尺寸模型的蒸馏训练,也分成两阶段:

1.Off-policy Distillation:使用 /think 和 /no_think 模式生成的教师模型(Qwen3-32B or Qwen3-235B-A22B)的输出结合起来进行蒸馏。这有助于提升小模型基本的推理能力和在不同思维模式之间切换的能力

2.On-policy Distillation:学生模型对query进行采样,在 /think 或 /no think 模式下生成回复。然后,通过将回复的logits 与教师模型的 logits对齐来微调学生模型,以最小化 KL 散度。

后训练效果评估

具体的测试分数就不一一展示了,参考原文,主要包括通用任务、对齐任务、数学、文本推理、Agent、代码、多语种测试任务。报告中展示了几个结论:

-

• 旗舰MoE模型Qwen3-235B-A22B 在开源模型中,无论是思考模式还是非思考模式,都展示了最先进的整体性能,超越了 DeepSeek-R1 和 DeepSeek-V3 等开源模型。Qwen3-235B-A22B 还与 OpenAI-o1、Gemini2.5-Pro 和 GPT-4o 等闭源模型展示出了很强的竞争力。 -

• 旗舰Dense模型 Qwen3-32B 在大多数基准测试中都优于之前的最强推理模型 QwQ-32B,并且与闭源 OpenAI-o3mini 的性能相当,。Qwen3-32B 在非思考模式下的性能也非常出色,超越了Qwen2.5-72B-Instruct。 -

• 轻量级模型,包括 Qwen3-30B-A3B、Qwen3-14B 和其他较小的Dense模型,始终优于参数数量接近或较大的开源模型,证明了 Strong-to-Weak Distillation 方法的成功。

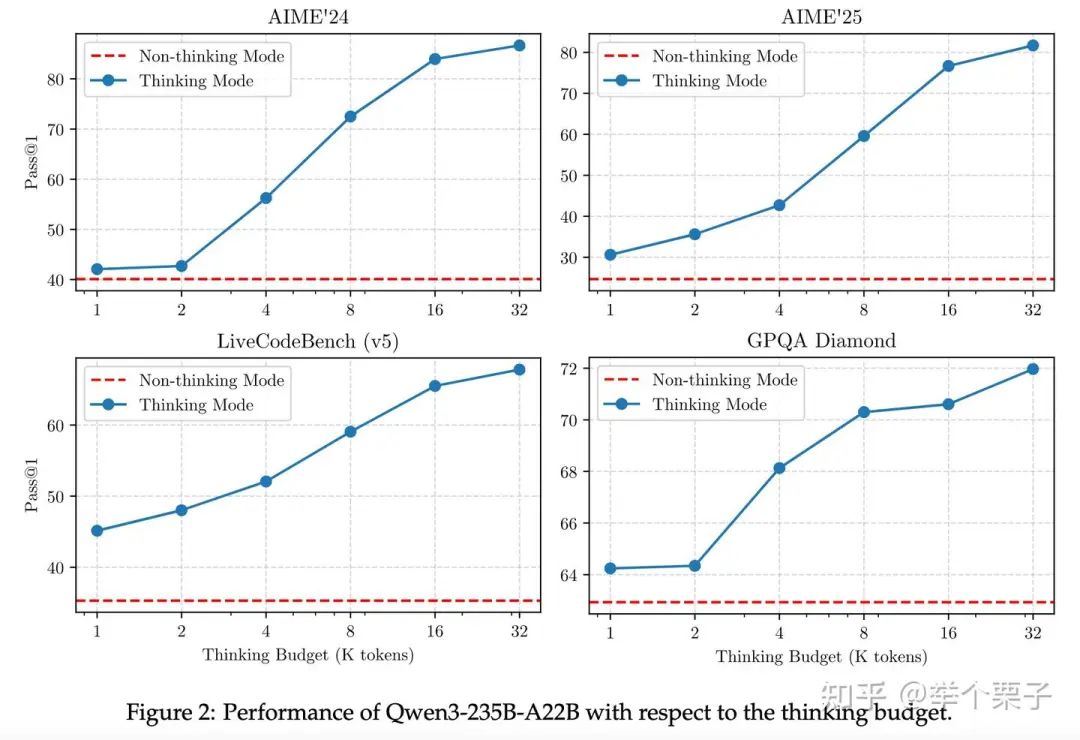

报告里还讨论了几个有趣的发现,首先是之前在推理长度上的scaling law,从下图中可以看到,Qwen3-235B-A22B 随着输出长度的增加(1K->32K)在AIME、LiveCodeBench、GPQA Diamond测试集上性能都有所提升。

其次,小模型直接从教师模型进行蒸馏比直接做强化学习的性能要好,同时所需的时间也更少。

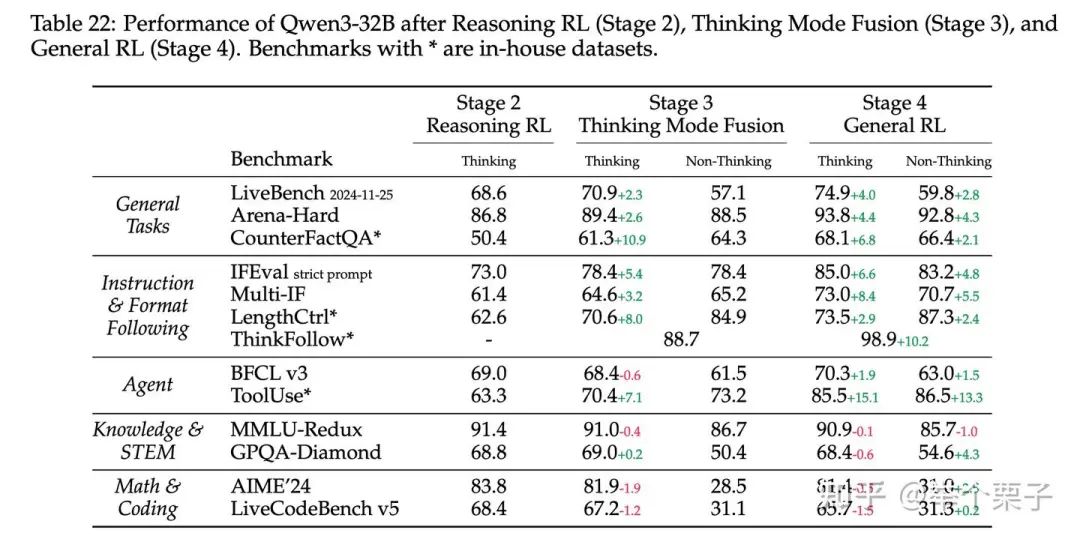

另外,他们还做了阶段三和阶段四的消融实验,这里还引入了一些验证幻觉的任务、控制长度的写作任务、混合思考模式下的多轮对话任务、工具调用任务,结果如下图。可以看出,阶段三提升了模型在“思考”模式下的指令跟随、格式跟随能力;第四阶段则进一步提升了这种能力;然而对于知识、STEM、数学和编码任务,阶段三、四的训练并没有带来显着的改进。

相比之下,对于像 AIME’24 和 LiveCodeBench 这样难度较高的任务,“思考”模式下的性能实际上会下降。推测这种退化是由于模型在更广泛的通用任务上进行了训练,这可能会损害模型处理复杂问题的专业能力,他们认为这种退化在性能的权衡下是可接受的范围。

(文:机器学习算法与自然语言处理)