新智元报道

新智元报道

【新智元导读】划时代的突破来了!来自NYU、MIT和谷歌的顶尖研究团队联手,为扩散模型开辟了一个全新的方向——测试时计算Scaling Law。其中,谢赛宁高徒为共同一作。

扩散模型,也有测试时Scaling Law

你在训练时的计算量是固定的,但在测试时,你可以把计算量提高1000倍。

「事半功倍」不行,那就开辟新路

-

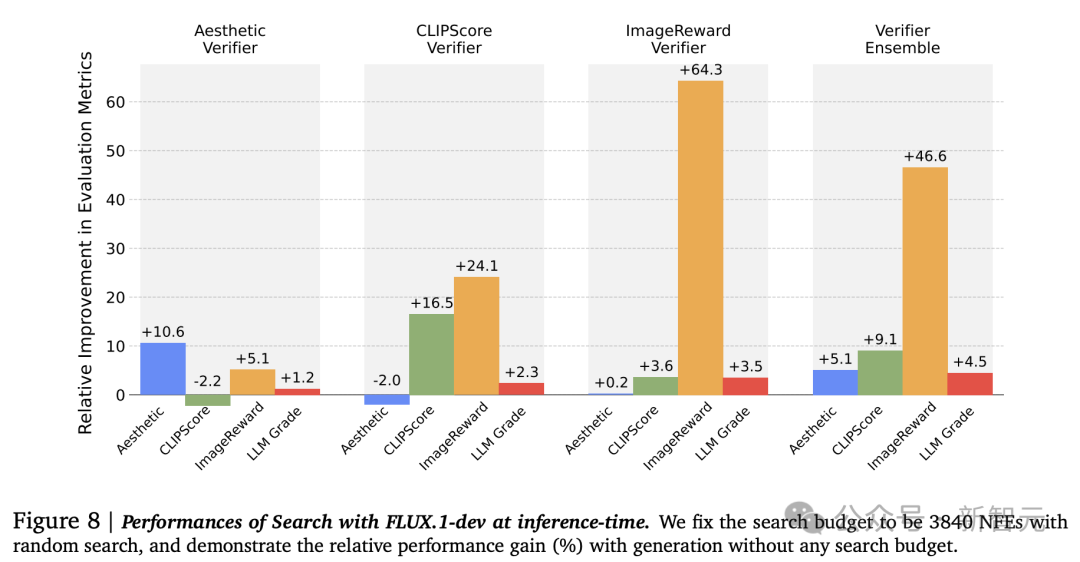

提出了一个用于扩散模型推理时Scaling的基础框架。论文表明,通过搜索来Scaling函数评估次数(NFE)可以在各种生成任务和模型规模上带来显著改进,超越了仅增加去噪步骤的效果。 -

确定了所提出搜索框架中的两个关键设计轴:提供反馈的验证器和寻找更好噪声候选项的算法。通过研究了不同验证器-算法组合在各种任务中的表现,结果发现表明没有一种配置是普遍最优的;每个任务反而需要特定的搜索设置才能实现最佳Scaling性能。 -

对验证器与不同生成任务之间的对齐进行了广泛分析。结果揭示了不同验证器中嵌入的偏差,以及在每个不同的视觉生成任务中需要专门设计验证器的必要性。

将推理时Scaling作为搜索问题

验证器

算法

-

随机搜索(Random Search):简单地从固定候选集中选择最佳选项

-

零阶搜索(Zero-Order Search):利用验证器反馈来迭代优化噪声候选项

-

路径搜索(Search over Paths):利用验证器反馈来迭代优化扩散采样轨迹

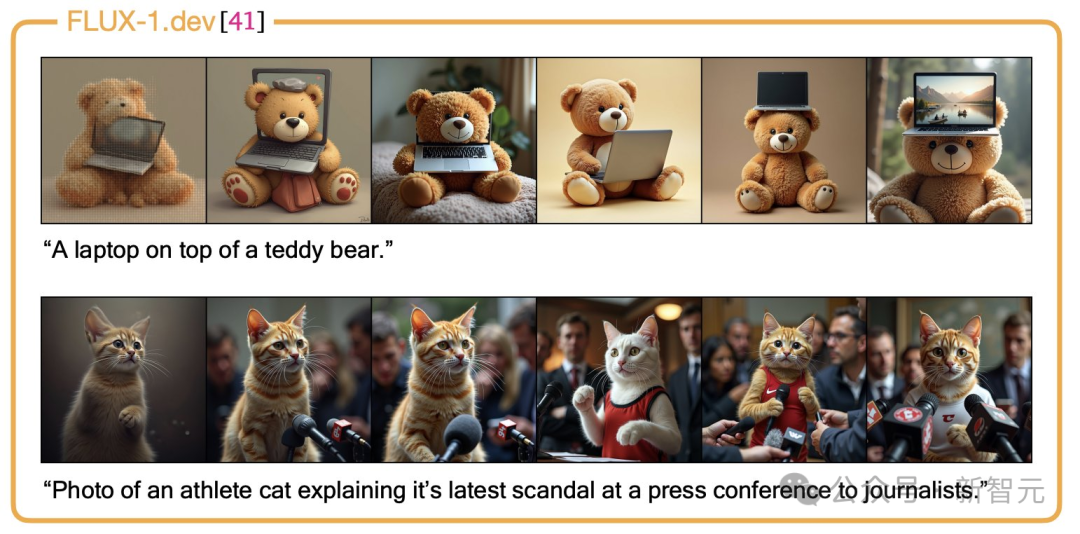

文本-图像推理时Scaling

分析结果:验证器Hacking和验证器-任务对齐

搜索与微调兼容性

-

缓解微调模型与奖励模型产生分歧的情况

-

提高模型的泛化能力

推理计算投入的维度

-

搜索迭代次数:增加迭代次数可以使选定的噪声更接近验证器所认为的最优集合,作者在之前的所有实验中都观察到了这种行为。 -

每次搜索迭代的计算量:用NFEs/iter表示这种计算量。在搜索过程中,调整NFEs/iter可以揭示不同的计算最优区域,如下图10所示。

计算投入的有效性

作者介绍

(文:新智元)