又一个能直接操控电脑的AI来了!

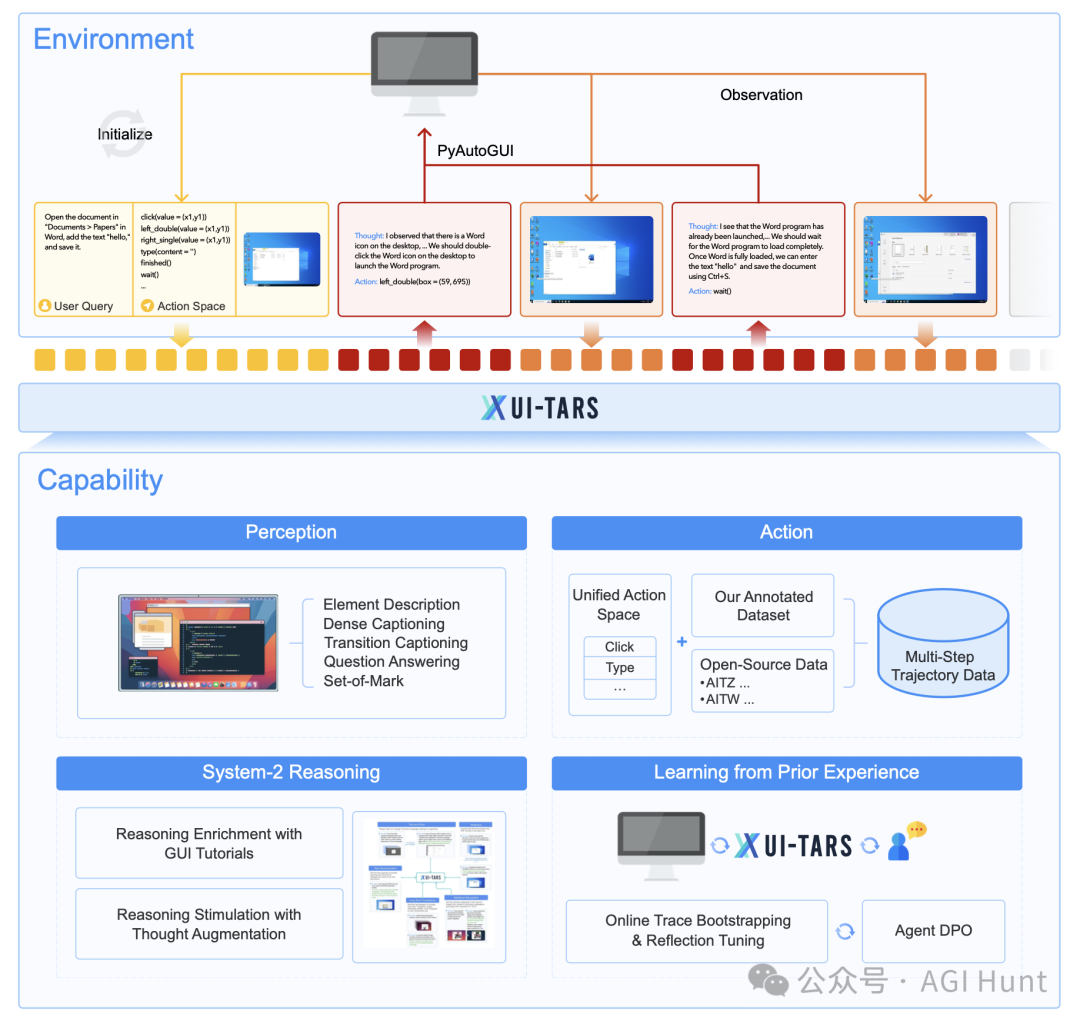

字节刚刚发布了UI-TARS,这是一个专门用来操控电脑界面的视觉语言模型。它不只是看懂屏幕那么简单,而是能像人一样思考、推理,并直接操作鼠标和键盘!

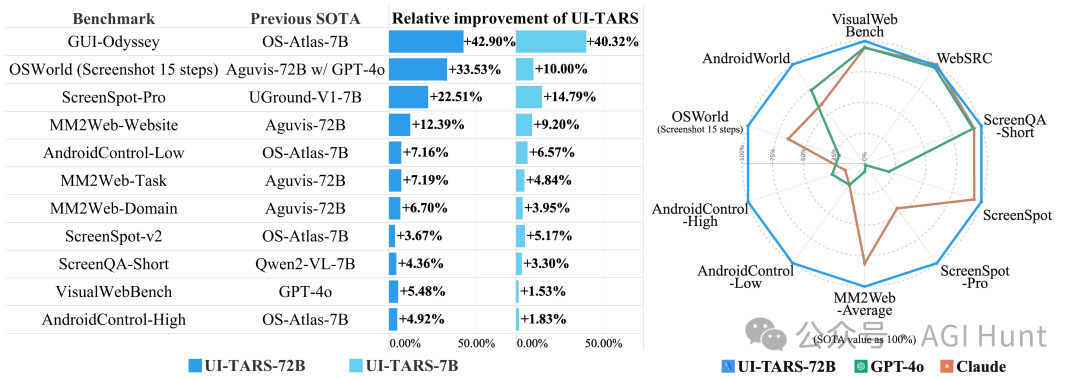

最强的是,在众多基准测试中,它都完胜GPT-4和Claude等对手。

在VisualWebBench上,72B版本达到了82.8%的准确率,超过了GPT-4的78.5%和Claude的78.2%。

这个模型最厉害的地方在于它的「一体化设计」。

不像其他工具那样需要复杂的配置和规则,UI-TARS把感知、推理和行动能力都整合在一个模型里,实现了真正的「端到端自动化」。

它能干什么?

简单来说:

-

智能理解界面:不管是文字、图片还是交互元素,都能实时识别和响应

-

统一行动空间:支持点击、长按、输入、滚动、打开应用等各种操作

-

多级思维模式:结合快速直觉和深度思考,能处理复杂任务

-

记忆功能:短期记忆保存当前任务上下文,长期记忆积累历史经验

字节同时发布了三个版本:2B、7B和72B参数规模的模型。

通过SFT(有监督微调)和DPO(直接偏好优化) 训练,让模型在10多个GUI代理基准测试中都达到了最好成绩。

更棒的是,这个模型还开源了桌面版应用!

只要简单下载安装,就能用自然语言控制你的电脑。比如「发送一条内容为『hello world』的推文」,或者「查看旧金山的天气」,通通都能自动完成。

UI-TARS的诞生,让我们离「AI助手真正理解并操作计算机」的目标又近了一大步。

它不仅能看懂界面,还能像人类一样思考和行动,这正是未来AI助手的发展方向。

快来试试让AI帮你操作电脑吧!

相关链接

-

项目代码:https://github.com/bytedance/UI-TARS -

论文详情:https://huggingface.co/papers/2501.12326 -

模型地址:https://huggingface.co/bytedance-research/UI-TARS-72B-DPO -

桌面应用:https://github.com/bytedance/UI-TARS-desktop

(文:AGI Hunt)

这AI玩转电脑操作的水平也太高了吧!72B版本的准确率都超过了GPT-4?这也太强了吧!离AI真正操控计算机又近了一步!

这AI怕不是人形AI助理吧?直接操盘都这么稳!比GPT-4还厉害!