新智元报道

新智元报道

【新智元导读】随着AGI/ASI的不断逼近,比人类更智能的系统即将登场,彻底颠覆人类社会的面貌。Hinton等专家纷纷预测,一旦AGI能够取代人类劳动力,人类将「富者越富,穷者越穷」,社会结构将发生翻天覆地的变化。

在《经济蓝图》中,OpenAI描绘了AI带给人类的未来:不久的将来,普通人的生活将比现在最「壕」的富豪,生活得更好。

但真的如此吗?

毕竟因为AI的进步,硅谷大厂Saleforece冻结了相关岗位的招聘,Meta等大厂也在开发中级程序员水平的智能体。

围绕AI的讨论以及对生活的影响,可以分为三部分:

-

是否会产生超级智能或通用人工智能(AGI)——一种超越人类智慧的实体, -

它是如何改善/摧毁我们的生活, -

以及我们现在可以做些什么来控制结果。

AGI/ASI逼近

虽然只是一种可能的预测,但Newman对AGI的解释,代表了大多数领域专家对下一代AI的看法。

与AGI类似,但超级智能(ASI)更加关注AI对科学发现的促进作用。

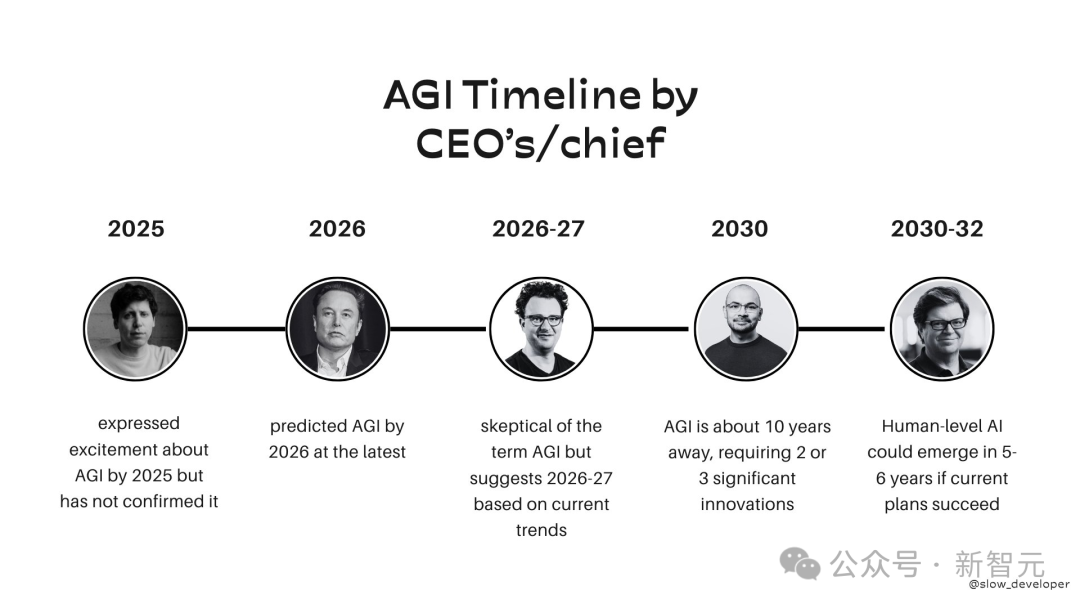

AGI距离实现仅剩数年时间,许多专家或AI巨头的CEO还给出了更加具体的时间节点。

在去年,Hinton表示,我们终将会迎来超级智能,而且它到来的速度比想象的要快。

加拿大英属哥伦比亚大学计算机科学教授,Jeff Clune也认同Hinton的观点。

他表示:「我认为超级智能完全有机会,而且这个机会并不渺茫,今年就可能出现。我们已经进入了逐月接近超级智能的时代。而且每过去一个月,这种可能性还会增长。」

然而,专家们警告不要低估AI的力量,无论它带来的后果是好是坏。

超级智能的风险

AI扩大贫富差距

在最近的一次公开讨论中,Geoffrey Hinton预测,AI会加剧贫富差距,使社会变得「越来越糟」。

在历史长河中,技术进步导致的「下岗」,并不是什么新鲜事。

随着全球的工业化和现代化,一些传统职业在消失,部分行业甚至被彻底摧毁。

但AI越来越强,越来越多的工作面临被淘汰的风险。

2025年,各大公司纷纷表示要推出「虚拟员工」,AI进军劳动力市场。AI可能会成为许多人失业的「最后一根稻草」。

在最近的圆桌讨论中,Hinton预测随着AI发展,财富差距将迅速扩大:

我们谈论的是生产力的巨大提升。所以每个人都应该能获得更多的商品和服务,每个人应该都变得更好,但实际上情况可能并非如此。

如果处理不当,他表示接下来发生的将是:

生产力的巨大提升将为大公司和富人赚取更多的钱,从而加大富人和失业者之间的差距。

这主要是因为失业的人将失去收入,而那些掌控AI的人——即生产商品和服务的人——将在没有劳动成本的情况下,享受金融特权。

有研究证实部分自由职业受ChatGPT影响,工作机会和收入都在持续减少。研究者甚至推测一旦AI有能力取代人类的岗位,那人类再无可能回到原来的岗位上。

而且许多富豪和大公司正在将精力集中在AI上。

很难让人相信,他们不是为了将来的利润,而是为了全体人类的美好未来,在免费「打工」。

毕竟,就连OpenAI都快变成「CloseAI」了:奥特曼正在将OpenAI从非营利组织转变为更加商业的营利组织。

网友也猜测财富从大众中流失,将如何导致社会不平衡。

普通人变得无足轻重

去年12月28日,L Rudolf L发布了《Capital, AGI, and human ambition》,强调了AI对社会价值观念的冲击。

他的核心观点如下:

能替代劳动力的AI,将迅速改变人类与非人类生产要素的相对重要性,这会减少社会关心人的动机,同时使现有的权力更加巩固。

现在如果想用钱实现自己的抱负,面临的最深层问题可能是招聘不到合适的人才,因为招聘人才面临几个问题:

-

判断人的才能往往很难,除非自己有相当的天赋。否则,通常会错过真正的人才。 -

人才稀缺(脱颖而出、头角峥嵘的人才更是如此)。 -

即使你能找到顶尖人才,顶尖人才通常不如其他人容易被金钱收买。

首先,虽然AI的「才能」也难以估计,但AI可以被复制。

每个人——至少要有足够的钱烧在GPU上——都能得带来突破性的AI。

而人类与此截然不同,人的才能不仅难以确认,而且也难以复制。

而且,因为AI的成本将低于同等的人类劳动力,人才的成本将大幅下降。

并且由于AI的能力可以复制,竞争将更加激烈。

而资金转化为人才的最大瓶颈,在于许多顶尖人才拥有复杂的人类偏好,他们比AI更难被钱收买。

顶尖的天才往往对学科或事业,有着高度的献身精神和使命感,视「金钱为粪土」。

相比之下,AI的存在就是为了卖出去(至少在安全范围内)。

显然,AI并没有「人性」,无论执行什么类型的任务,都「无怨无悔」,远超人类。

在劳动力被AI取代后的世界将:

-

金钱将比以往在现实世界中买到更好的结果。 -

人们的劳动比以往任何时候都缺乏影响力。 -

劳动致富变得几乎不可能。 -

在各国内部或之间,无法实现资本的根本性平衡。

他们将拥有比如今的富人更多的权力:只要自由体制(liberal institutions)依旧强大,他们不一定凌驾在人民之上,但至少是在物质和精神上将更有权势。

而且没有新兴势力可以击败他们,因为现在资本可以轻易地转化为任何领域的「超人」劳动力。

此外,世界上掌握权力的机构,将不再有动力去关心人们,以维持或增长它们的权力,因为所有真正的权力都将来自AI。

然而,政治机构可能会牢牢捍卫自由人文主义价值观。

如果每个人都拥有有意义的无条件基本收入(或类似措施),并且经济保留以人为本的部分,也可能维持人们的购买力。

往坏处想,AI亿万富翁拥有近乎无限且不受约束的权力,并且是永久的贵族阶层。

阶级之间的权力差异可能会让现代人感到颤抖,就像现代人无法认同封建等级制度一样。

因为这就是权力和金钱激励指向的方向。

智能诅咒

在L Rudolf L的理论基础上,AI治理专家Luke Drago进一步解释了AI的隐患,他称之为:「智能诅咒」,即因为AGI,当权者失去投资人民的激励。

他认为AGI更像是煤炭或石油等资源,而不是犁、蒸汽机或计算机等工具。

就像煤炭、石油等自然资源一样:

-

要发现和利用AGI,需要非常多的资金。 -

少数玩家将控制AGI,主要是开发AI的实验室以及它们所在的国家。 -

从AGI获得大部分或全部收入的国家和公司,不再依赖人获取收入。 -

AGI将取代文明的上一代资源。对于煤炭来说,是木材。对于AGI来说,就是人力资源。

导致资源诅咒的因素有很多,但核心因素之一是:创造了不关心人民经济福祉的激励。

用AI替代劳动力的当权者,将面临类似的处境,但其后果更加严重。

因为他们的收入将来自「人•工智能」,而非人类。

因此,他们只要继续向AI投资,就可能获得更多的收入。

最终,他们将不再需要向人提供工资或福利,不再提供教育、医疗等社会保障。

最后结果就是,普通人无法维持生计。人类没有用武之地,因此也不会获得报酬。

这就是智能诅咒——一旦当权者创造并实现了通用智能,他们将失去投资人民的激励。

一旦出现比人更好、更便宜、更快、更可靠的AI系统,智能诅咒就开始生效。之后的1到5年内,恶果就会显现。

而且人类再也无法摆脱这种「诅咒」,而「资源诅咒」却有望解决。

因为考虑到石油的气候影响以及可再生能源的崛起,现在任何国家都能生产能源。产油国被迫寻求新的收入来源,在这个过程中放权给人民,从而摆脱了「资源诅咒」。

而AGI不会有这种效果——后续的模型都会比上一代更强大,少数人会一直处于垄断地位。

AGI也不会像石油那样被「耗尽」。计算能力或现有能源可能被耗尽,但随着时间的推移,计算能力变得更加便宜,能源也变得越来越绿色。

如何控制AI

仍然悬而未决的问题是人类是否能够保持住对AI的控制。

对Hinton来说,答案在于选举那些高度重视监管AI的政治家:「我们应该做的是鼓励政府迫使大公司进行更多的研究,研究如何在开发这些技术时保持它们的安全性。」

然而,Google DeepMind的高级研究顾问Clune表示,许多领先的AI公司秉持正确的价值观,并且「正在努力做得对。」

「比起正在开发领先AI模型的公司,我更担心的是那些其他试图迎头赶上的国家和组织,它们的顾忌远没有头部的AI实验室那么多」。

Clune提出的实际解决方案,类似于核时代的做法,那就是邀请所有主要的AI参与者定期进行对话。

他认为,AI从业人员应该合作,确保它能够安全地发展。

Clune说道「这是人类历史上最大的一次赌注,甚至比核武器的还要大」,并建议全球的研究人员相互了解彼此的进展,在需要时放慢研发进度。

「赌注极其高。如果我们做对了,收益也非常大。如果我们做错了,我们可能在讨论人类文明的终结。」

(文:新智元)