阿里巴巴因为强大的基础服务能力和良好的开源AI大模型性能,获得了和苹果公司合作的机会。看我文章的老朋友应该还记得在去年6月份的时候写过一篇《阿里Qwen2开源》推文,里面提到了开源对人工智能技术普及和应用的深远影响。

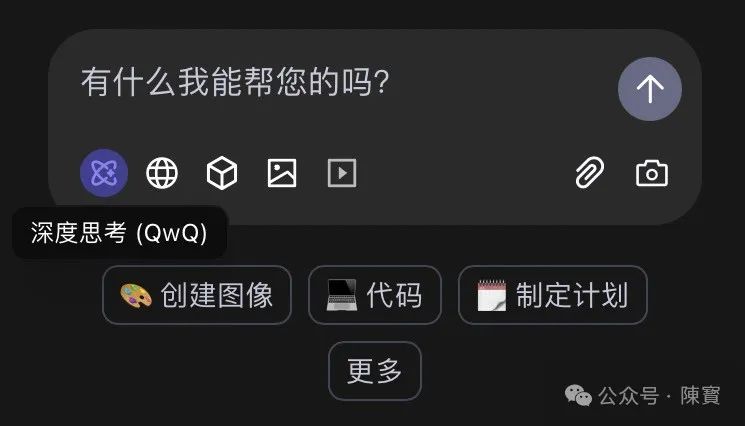

刚刚,阿里Qwen团队在Qwen Chat平台上线了“深度思考(QwQ)”功能。这一消息迅速引发科技圈的震动,不仅是因为它背后基于QwQ-Max-Preview推理模型的技术突破,还因为它首次将“联网搜索”与“思维链展示”结合,个人觉得它试图重新定义AI的“思考”方式。

“推理”到“深度思考”的跨越

“深度思考(QwQ)”的核心是QwQ-Max-Preview模型,基于Qwen2.5-Max构建,专注于数学理解、编程和AI智能体领域。

与传统对话模型不同,QwQ的“深度”体现在它具备多模态推理能力。

数学问题领域,能解析复杂公式并给出推导过程,而非仅输出结果。

编程辅助方面,支持生成、调试代码,甚至通过“预览模式”实时展示运行效果。

AI智能体协作上,能够调用其他模型(如视觉模型)协同解决跨领域问题,得益于Qwen2.5-Max的架构优化,使其在处理长逻辑链任务时更稳定。

QwQ首次将联网搜索功能嵌入推理流程,当用户提问“2025年全球AI算力需求趋势”时,QwQ不仅调用内部知识库,还会实时检索最新论文、行业报告,整合后生成回答。

该设计颠覆了传统AI被动接受数据的模式,赋予其动态更新知识的能力。不过,如何平衡搜索效率与信息可信度,仍是团队优化的重点。

QwQ的另一突破是展示“完整的思维链”,回答“如何设计一个分布式系统”时,它会分步骤呈现架构选择、技术对比、潜在风险等逻辑路径。

透明化的设计不仅提升用户信任度,也为开发者调试模型提供了关键数据。

AI赛道的“新范式”竞争

Qwen团队宣布,QwQ-Max和Qwen2.5-Max的权重将基于Apache 2.0协议开源。

也就是说开发者能够自由修改模型架构,甚至将其集成到商业产品中,此举打破了当前大模型领域的封闭生态,推动更多中小型企业参与AI创新。

即将推出的QwQ-32B模型体积更小,适合本地设备部署。预示着AI推理能力将向终端下沉,会在手机、IoT设备上直接运行复杂任务(如实时翻译、隐私数据处理),减少对云端的依赖。

当前市面上的推理模型(如DeepSeek R1、Kimi)多聚焦于单一任务优化,而QwQ通过“联网搜索+思维链”组合,构建了一个动态进化的认知系统。

它的正式版表现稳定之后,也会迫使竞争对手重新调整技术路线。

工具到“协作者”的进化

QwQ的思维链展示功能,使得它能像人类教师一样“讲解”解题思路。

学生提问微积分问题时,QwQ 能够逐步拆解洛必达法则的应用场景,并结合联网搜索的案例深化理解,该交互模式会重塑自主学习体系。

商业场景中,QwQ 能够整合行业数据、法律条款和实时市场动态,为企业提供决策建议。

跨境投资评估中,它能自动分析地缘政治风险、汇率波动与本地政策,并生成多方案对比报告。

QwQ的联网搜索与多模型切换能力,使它能够充当用户的“外延认知系统”。

设计师能够通过QwQ调用视觉模型分析作品风格,再切换至编程模型生成网页代码,全程无需切换平台。

我认为,这种无缝协作也会大幅提升创意生产效率。

(一)联网搜索虽扩展了AI的知识边界,但也会引入虚假信息。

(二)在医疗咨询场景中,若QwQ错误引用了未被同行评审的预印本论文,会导致严重后果,团队需建立更严格的信息过滤机制。

(三)尽管开源策略有利于生态建设,但如何防止竞争对手快速复制核心技术?

⋯ ⋯

这就需要Qwen团队通过“开源基础模型+闭源增值服务”的模式,积极寻找突破口了。

树大招风,提前规避一些问题少不了。AI能自主搜索并整合信息时,它生成内容也会涉及版权争议(如引用未授权文献)或地缘政治敏感问题,监管框架的滞后性将成主要挑战。

阿里巴巴公司的 Qwen “深度思考”功能,本质上是一场对“思考权”的重新分配,将部分人类独有的逻辑推理能力赋予机器,并通过开源使其普惠化。

(文:陳寳)