今天是2025年3月6日,星期四,北京,天气晴。

昨天我们讲了下文档解析的两个流派,olmOCR有他的特色,昨天测试了下,可以看看其具体一些问题和实现细节。

另外,看几个工作,关于GraphRAG和多模态R1的一些思路。

抓住根本问题,做根因,专题化,体系化,会有更多深度思考。大家一起加油。

一、在看下olmOCR的一些测试情况

我们在https://olmocr.allenai.org/ 中可以找到OLMOCR的测试链接,体验了下,有几张图可以看看,顺便看下有哪些问题。

1、呈现效果是啥?

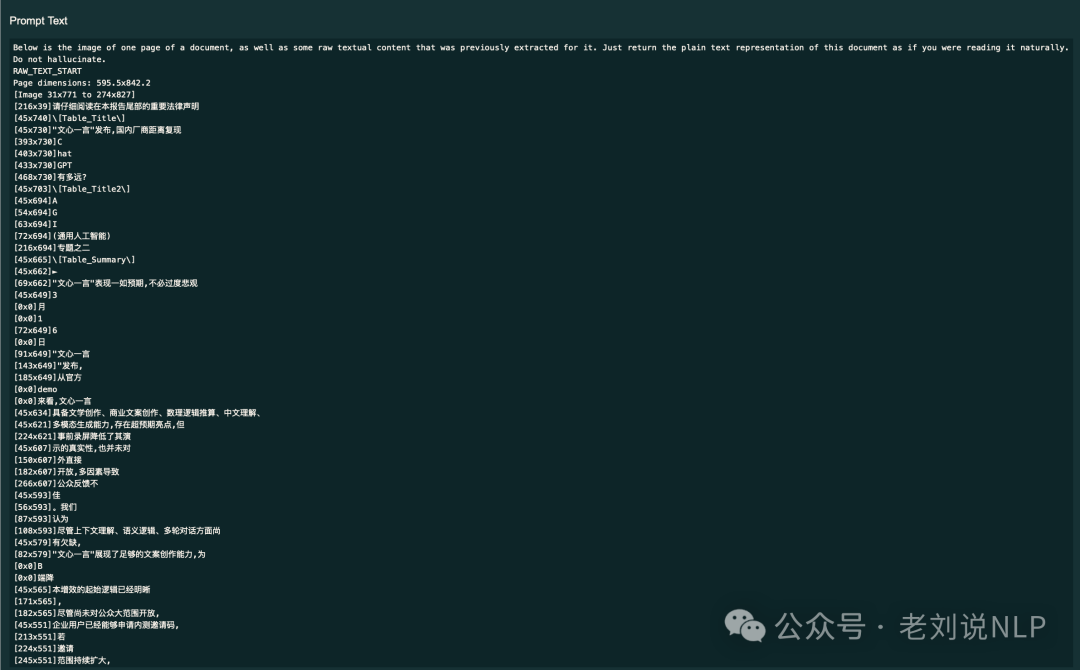

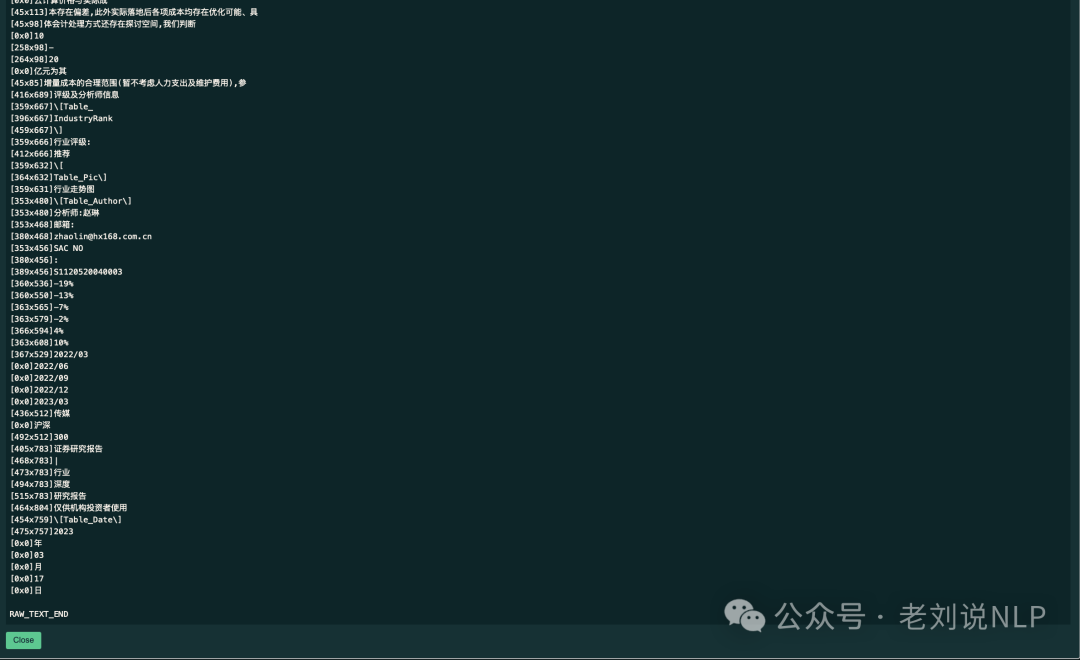

2、送进去的prompt是啥,如果是可编辑版本?

3、被送进去的prompt是啥,如果是扫描版本?

4、很显性的问题,目录是乱的,且图全没了。

5、很显性的问题,表格有的识别不出来或者识别错误

二、关于GraphRAG和多模态R1的两个有趣工作

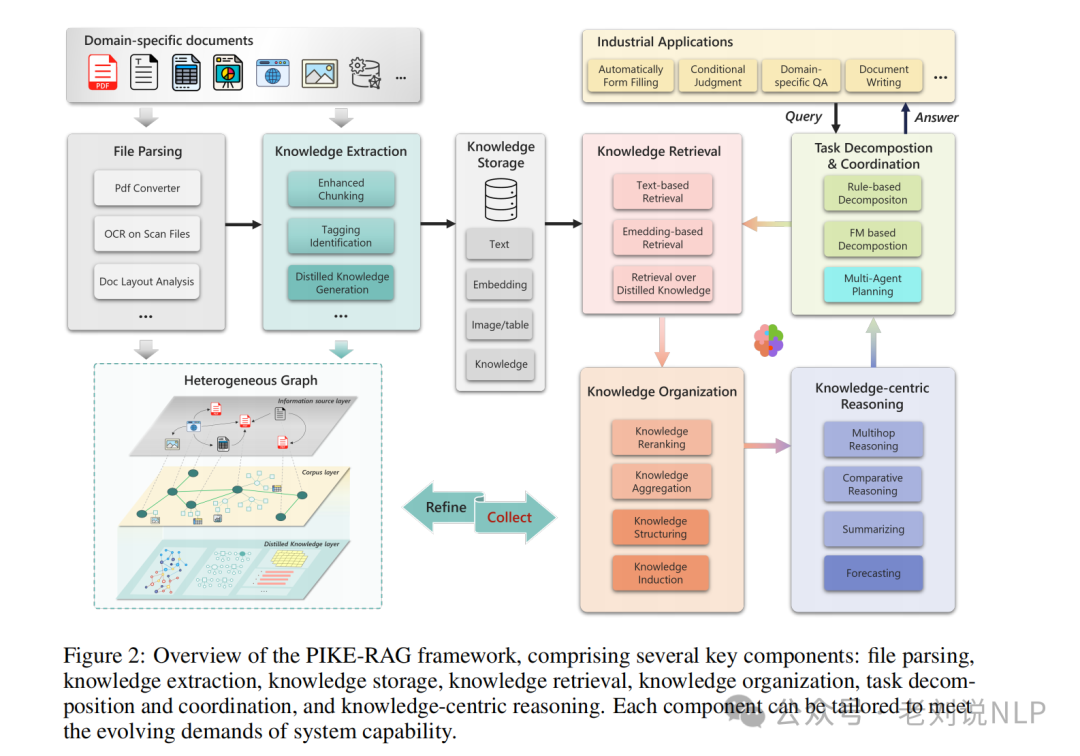

1、GraphRAG的PIKE-RAG

最近有一个工作《PIKE-RAG: sPecIalized KnowledgE and Rationale Augmented Generation》, https://github.com/microsoft/PIKE-RAG,https://arxiv.org/pdf/2501.11551,受到关注,专注于提取、理解和应用领域专业知识,并构建连贯的推理逻辑,逐步引导LLM生成准确的回答,核心思想是通过知识原子化和知识感知的任务分解,从数据块中提取多方面的知识,并基于原始查询和累积的知识迭代构建推理逻辑

2个点可以留意。

一个是其场景假设。

但是,说是处理复杂且多样化的工业应用需求,但这个有些场景假设(这个可以参考),搞得太复杂,实际用不太到。例如,将任务分为四类:事实性问题(直接从语料库中提取明确的信息);可链接推理问题(需要从多个来源整合信息并进行多步推理);预测性问题(基于现有事实进行归纳推理和预测);创造性问题(基于领域知识和逻辑生成创新解决方案),基于这些任务分类,将RAG系统的能力分为四个层次(L1-L4),分别对应系统解决不同类型问题的能力。

我们来看其实现架构,如下,包括几个关键组件:文件解析、知识提取、知识存储、知识检索、知识组织、任务分解与协调以及以知识为中心的推理。

可以看到,其为了支持这些复杂需求,需要花费很多的构建环节,其中

一个是任务分解和协调模块。

将复杂问题分解为多个子问题,并通过迭代机制逐步收集相关信息和进行推理,这个流程其实很费时间:

任务分解阶段,将原始问题分解为多个子问题,每个子问题对应于知识库中的一个或多个原子知识单元。

迭代检索和生成阶段,在每个迭代步骤中,任务分解模块生成一个或多个原子查询,知识检索模块根据这些查询从知识库中检索相关的原子知识单元。

信息整合和推理阶段,知识组织模块将检索到的原子知识单元整合并组织成连贯的上下文,知识中心推理模块基于这个上下文生成中间答案。

更新和解构阶段,使用生成的中间答案更新任务分解模块的上下文,并重新生成下一个迭代的分解方案,直到达到满意的答案或达到预定的迭代次数。

但是,我们要想,如果为了实现这个问题,需要做各个层次的抽取,那么为何不直接deepsearch或者deepresearch?

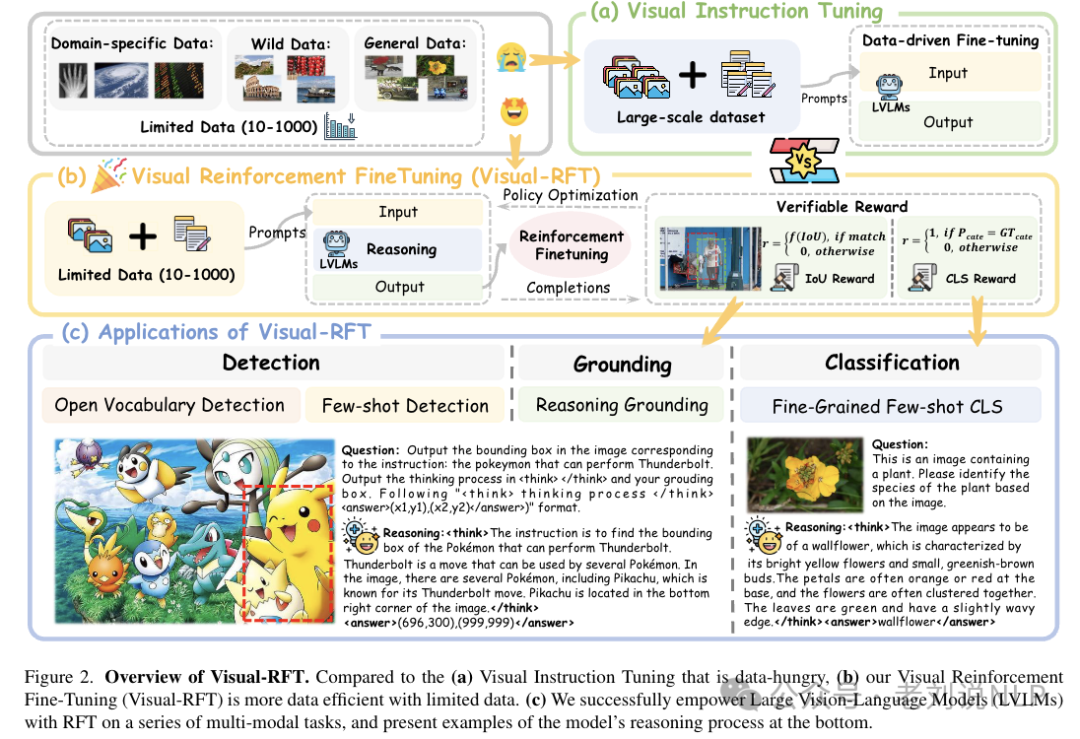

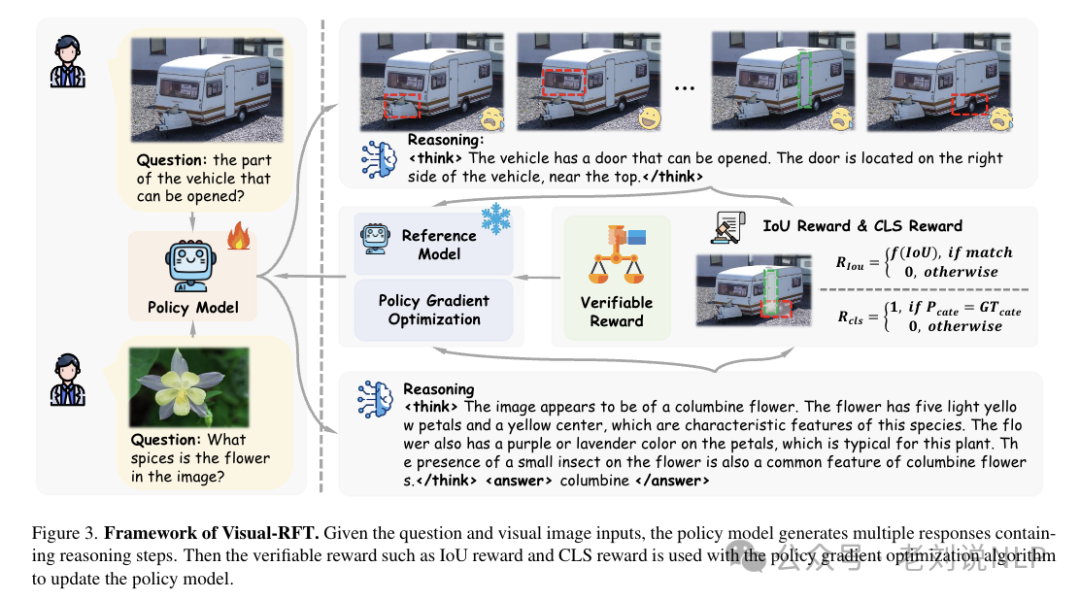

2、多模态R1-Visual-RFT

看多模态领域R1进展,Visual-RFT,论文地址: https://arxiv.org/abs/2503.01785,https://github.com/Liuziyu77/Visual-RFT,核心就是加了个iou的reward。

具体的,重点就是视觉感知可验证奖励函数,首先,设计针对不同视觉任务的规则基础可验证奖励函数。例如,在目标检测任务中,使用交并比(IoU)奖励函数;在分类任务中,使用准确率和格式奖励函数。

具体的,

检测任务的奖励函数Rd包括IoU奖励、置信度奖励和格式奖励:Rd=RIoU+Rconf+Rformat

其中,RIoU是所有边界框的平均IoU,Rconf是每个边界框的置信度奖励,Rformat是格式奖励。IoU奖励考虑了边界框与真实框的匹配程度,置信度奖励则与边界框的置信度相关,格式奖励确保模型预测的格式正确。

通过这些可验证的奖励函数,Visual-RFT直接评估模型输出的质量,并通过策略优化算法(如GRPO)更新模型,从而提高对象检测的准确性。

总结

经验告诉我们,强化学习的核心就是奖励函数的设计,这是核心。另外,RAG应该是要做简单,而不是越搞越复杂,不然很难用。

这是本文想说的。

参考文献

1、https://olmocr.allenai.org

2、https://arxiv.org/abs/2503.01785

3、https://arxiv.org/pdf/2501.11551

(文:老刘说NLP)