无论是从ChatGPT、Claude还是DeepSeek,每一次对话背后都是巨大的电力消耗。硅谷科技评论(SVTR)AI数据库显示,全球AI数据中心的能源需求预计在2026年翻倍,达到相当于一个国家的电力消耗水平。当前,液冷等新兴技术在降低散热功耗上取得进展,但从根本上突破能效瓶颈,仍需从计算架构入手。

Lightmatter,这家光子计算领域的先行者,正在挑战传统电子芯片的极限。其Passage光子互连技术,旨在彻底改变数据中心的扩展能力,同时以光速传输数据,降低互连带来的能源损耗。如果Lightmatter的愿景得以实现,这不仅意味着算力的飞跃,更可能重塑AI计算的能源基石。

面对AI计算的指数级增长,光子计算是炒作还是未来?它能否成为解决AI能耗危机的“摩尔定律2.0”?

全球数据中心的能源需求预计将在2026年翻倍,达到相当于日本全年电力消耗的水平。截至2024年10月,专门用于人工智能(AI)工作的数据中心贡献了70%的新增能源需求。这一增长主要归因于训练基础AI模型所需的高能耗,以及如OpenAI的ChatGPT和Anthropic的Claude等AI服务在推理过程中持续消耗大量电力。

以ChatGPT为例,截至2024年8月,其活跃的每周用户达到2亿,每日耗电量约为56.4万千瓦时。六个月后,其用户量翻倍至4亿,表明其能源消耗也可能随之翻倍,反映出AI能源需求的急剧增长。即使是以更高效R1模型闻名的Deepseek,其运行所需的能源消耗可能与其他AI平台相当,甚至更高。

除了计算本身的能耗外,数据中心冷却系统的能耗也是推动整体能源需求上升的重要因素。传统冷却系统在管理AI处理器所产生的巨大热量时面临挑战,需要持续供电以防止过热。因此,数据中心正在测试更高效的冷却技术,例如液冷。到2024年8月,已有22%的数据中心采用液冷技术,预计到2029年,这一比例将提升至50%。

在这一背景下,Lightmatter正致力于通过光子计算技术减少AI计算的能源消耗。该公司开发专门的芯片及光子互连(interconnects)技术,利用光进行数据处理和通信,以提高计算能力并降低能耗,尤其适用于AI工作负载和数据密集型应用。Lightmatter的CEO Nicholas Harris表示:

“未来几年,全球所有用于AI训练和推理的GPU都将建立在Lightmatter的Passage之上。”

Passage是其光子互连产品,旨在优化数据中心的扩展能力,并大幅降低传统互连技术无法克服的能源需求。

一、创立故事

Lightmatter由Nicholas Harris(首席执行官)、Darius Bunandar(首席科学家)和Thomas Graham(前首席运营官兼首席财务官)于2017年9月共同创立。

在创立Lightmatter之前,Harris于2005年在美光科技(Micron Technologies)担任研发工程师,专注于DRAM和NAND电路及器件物理的研究。在美光工作期间,他深入研究了集成芯片,并意识到传统计算架构的局限性可能会减缓计算技术的进步。为了解决这一问题,Harris离开美光,前往麻省理工学院(MIT)攻读电气工程与计算机科学博士及博士后研究。

在MIT期间,Harris开始探索量子计算技术,并再次发现该领域存在技术瓶颈。他的博士论文《用于量子信息处理和人工智能的可编程纳米光子学》(”Programmable Nanophotonics for Quantum Information Processing and Artificial Intelligence”)提出了一种通过纳米光子架构解决计算瓶颈的方案。同时,他还领导了MIT的量子光子实验室,研发基于硅的集成光子芯片,使信息能够通过光而非电进行处理。作为一名研究人员,Harris共发表了69篇学术论文,并获得了17项专利。

正是这些研究促成了Lightmatter的最初构想。Harris注意到“所有人都知道深度学习会成为一个巨大的趋势”,于是他深入研究该领域,并意识到自己为光子量子计算开发的系统同样可以用于深度学习。这个发现促使他放弃了博士毕业后成为教授的计划,而是选择与Bunandar(他的实验室同事)和Graham(MIT工商管理硕士项目的学生)共同创立Lightmatter。同年,该初创公司在MIT创业大赛中获得了10万美元的奖金。

在加入Lightmatter之前,Bunandar于2013年在德克萨斯大学奥斯汀分校(UT Austin)获得物理学和机械工程学位,并于2018年在MIT完成物理学博士学位。而Graham则曾在摩根士丹利(Morgan Stanley)和谷歌(Google)担任多个财务、运营和业务发展职务,并于2018年获得MIT斯隆管理学院的工商管理硕士(MBA)学位。

自2017年以来,Lightmatter的管理层经历了多次变动。Graham曾担任首席运营官(COO)直至2023年5月,随后转任首席财务官(CFO)。2024年7月,前高盛(Goldman Sachs)董事总经理、英伟达(NVIDIA)投资者关系及战略财务副总裁Simona Jankowski接替Graham,担任CFO。截至2025年2月,Graham仍在Lightmatter担任全职职务,其最新头衔为“创始人”(Founder)。

二、公司产品

过去几十年来,计算能力的提升主要依赖于两个关键趋势:摩尔定律(Moore’s Law)和Dennard缩放(Dennard Scaling)。摩尔定律指出,芯片上的晶体管数量大约每两年翻倍,而Dennard缩放则认为,随着晶体管尺寸缩小,其功率密度保持不变。这些趋势让计算变得更便宜、更快、更小巧,同时提高了能效。然而,自2005年左右,这些技术改进开始放缓。

Lightmatter的首席执行官兼创始人Nicholas Harris意识到传统芯片的局限性,并提出光子计算芯片可以成为继续遵循这些增长趋势的解决方案。Harris解释道:

“利用光子技术,计算可以同时进行,因为数据可以通过不同颜色的光传输。例如,在一个颜色的光中,你可以有一张狗的照片,另一种颜色可以有一张猫的照片,另一种颜色可以是一棵树。这些数据可以同时经过同一个光计算单元——这个矩阵加速器进行处理。这种方法提高了单位面积的计算能力,同时充分利用硬件资源,从而提升了能源效率。”

为了解决计算性能瓶颈,Lightmatter推出了两款核心产品:Passage和Envise。Passage是一款光学互连芯片,专注于数据中心内部的高效数据传输,而Envise是一款光子计算芯片,利用光计算技术执行深度学习任务,从而减少功耗并提升计算速度。

Passage:光学互连芯片

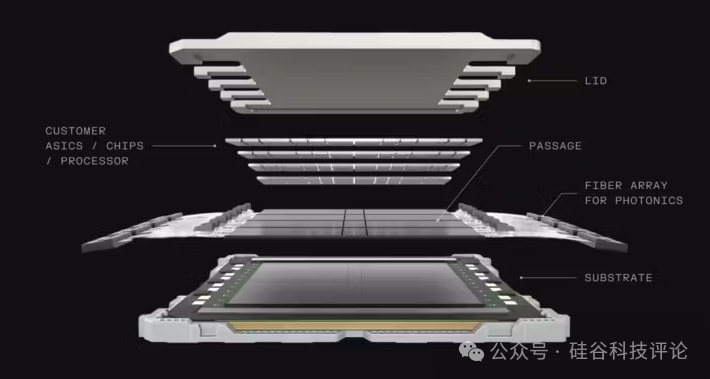

Passage是一种硅光子(silicon photonics)互连系统,利用光而非电子信号来传输计算组件之间的数据,从而突破AI训练和推理过程中最主要的瓶颈——数据传输限制。

在包含大量GPU的计算集群中,主要的瓶颈并非AI模型的矩阵计算,而是数据的读写与传输。传统的光纤通信技术虽然可以实现超高速数据传输,但通常用于远距离通信,例如跨大陆的海底光缆。而Lightmatter的Passage则通过硅光子技术,将光纤通信微型化,实现单芯片级别的高效数据传输。

工作原理:

Passage本质上是一个中介层(interposer),可以充当计算组件之间的桥梁。例如,它可以放置在处理器与SRAM存储器之间,使数据在Passage内以光的形式高速传输。通过Lightmatter的光I/O技术,Passage支持芯片到芯片(chip-to-chip)以及节点到节点(node-to-node)的高速通信。

主要特点:

-

兼容现有硬件:支持与市面上的标准芯片集成,无需更换现有基础设施。

-

超高速光交换:提供100 Tbps的光学通信速率,适用于光子计算、CPU或GPU计算。

-

高密度互连:可支持最多48个光子、CPU或GPU芯片直接安装在互连系统上。

-

高效光通信架构:配备40条光子通道,整体宽度仅相当于一根光纤,实现高效数据传输。

这些特性使Passage成为未来大型AI数据中心的理想选择。随着AI工作负载的不断增长,Passage可以高效地连接大量计算处理器,替代传统的PCB(印刷电路板)通信方式,实现更高的可扩展性和能效。

Envise:光子计算芯片

Envise是Lightmatter于2021年推出的产品,它集成了电子计算与光子计算技术,以减少数据中心的功耗和运营成本。Envise被称为全球首款通用光子AI加速器,它采用光计算来加速AI任务,并可用于各种神经网络计算,从语音助手到自动驾驶,再到像ChatGPT这样的AI模型。

截至2024年,一块16芯片的Envise服务器刀片(server blade)仅消耗3千瓦功率,相比之下,同等规模的NVIDIA A100系统耗能6.5千瓦,节能54%。此外,Envise单芯片还具备:

-

6.4 Tbps光互连,可扩展到多服务器系统

-

1TB DDR4 DRAM 及 3TB固态存储

Envise能够直接与PyTorch集成,使机器学习开发者无需改变编程方式即可部署神经网络。作为全球首款商用光子计算机,Envise能够处理从语音识别到自动驾驶系统等各类神经网络应用,包括大语言模型(LLM)。

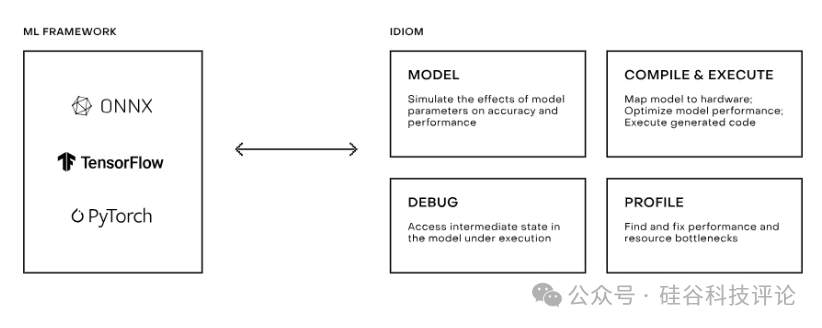

Idiom:光子计算的软件平台

Idiom是Lightmatter开发的配套软件栈,它帮助用户在Envise上优化神经网络模型的编译和执行。该平台提供多种工具来优化计算性能,包括:

-

idCompile(图编译器):用于优化深度学习计算任务,提高Envise在多服务器系统上的运行效率。

-

自动分割神经网络,将大型模型拆分为小部分并行运行

-

数据并行处理,同时运行多个Envise单元

-

混合精度计算,在保证模型精度的同时降低计算负担

-

idProfiler(性能分析工具):监测Envise设备上的神经网络执行情况,分析内存使用率和性能数据,帮助开发者识别瓶颈并优化模型。

-

idBug(调试工具):专门用于多芯片并行计算的错误检测,加快问题定位和解决。

-

idML(机器学习优化工具包):与PyTorch集成,可进行模型量化和优化,提高计算效率。

-

支持知识蒸馏(Knowledge Distillation),让小模型学习大模型的知识,提高计算效率

-

量化感知训练(Quantization-aware training),在不损失精度的前提下降低计算成本

-

可视化参数分析,帮助开发者追踪优化对模型性能的影响

Idiom软件栈的核心目标是让Envise高效执行神经网络任务,同时最大限度降低功耗和计算资源浪费。它的高效编译和优化能力,使得Envise能够快速适配各类AI工作负载,包括自动驾驶、语音识别和大语言模型等。

三、市场格局

公司客户

对高效、节能的数据处理解决方案的需求,使Lightmatter的Passage和Envise产品主要吸引三个核心客户群体:

-

数据中心 —— 旨在降低运营成本并提高计算能力

Lightmatter的Passage光学互连芯片能够提高数据在芯片和服务器之间的传输效率,使数据中心能够更轻松地扩展生成式AI(Generative AI)和高性能计算(HPC)应用。Lightmatter会根据特定芯片的布局(floor plan)定制其硅光子芯片,以优化数据传输。早在2020年,Lightmatter就已向亚马逊(Amazon)和谷歌(Google)等大型数据中心运营商推广其解决方案,希望帮助他们摆脱目前连接数千台服务器的“电缆混乱”(the giant spaghetti of cables)的现状。

-

AI技术公司 —— 依赖大规模计算资源来开发和运行AI模型

那些开发专用AI模型的企业,如医疗科技公司DeepScribe和Freed,依赖大规模计算资源来提供AI驱动的医疗转录服务。然而,随着AI工作负载的增长,仅仅增加GPU并不能有效解决计算组件之间的数据传输瓶颈。对于这些依赖特定行业数据的大型AI应用公司,互连层(interconnect layer)成为系统性能优化的关键因素。

-

云服务提供商 —— 需要高带宽计算基础设施以扩展计算能力

云计算巨头(如AWS、Google Cloud、Microsoft Azure)运营的大规模计算集群,传统网络架构已成为其扩展计算能力的瓶颈。Lightmatter的CEO Harris指出,云服务商“已经认识到传统网络解决方案的局限性,高效、高带宽的连接变得至关重要。”Lightmatter的光子互连技术能够为这些公司提供更具扩展性和能效的解决方案。

市场规模

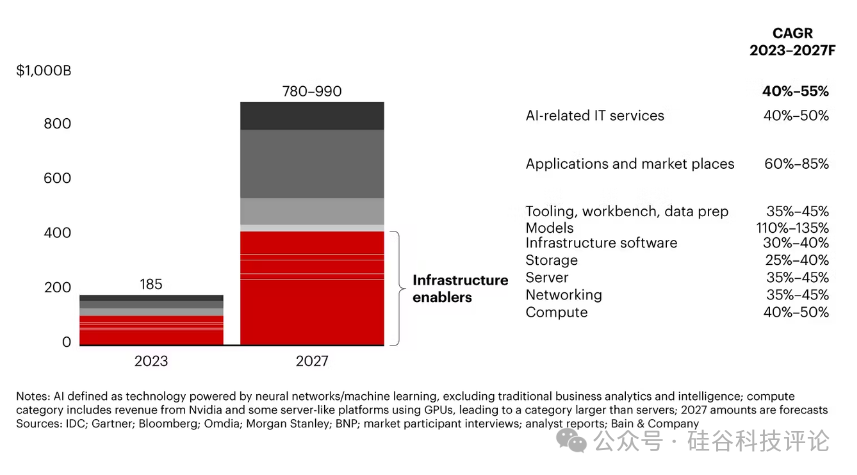

全球AI产品与服务市场预计将在2027年达到7800亿至9900亿美元,相比2023年的1850亿美元,增长显著。

-

AI硬件市场

2023年全球AI硬件市场规模约537亿美元,预计到2033年将增长至4735亿美元,复合年增长率(CAGR)为24.5%。AI硬件增长主要由AI技术的广泛应用、半导体技术的进步和对边缘AI(Edge AI)解决方案的需求推动。

AI硬件市场涵盖了专用芯片、处理器和计算系统,其中AI推理芯片市场的增长尤为显著:2023年AI推理芯片市场规模约为158亿美元,预计到2030年将达到906亿美元,CAGR达22.6%。AI推理计算占AI硬件市场的40%,未来随着更强大的计算芯片的研发,AI推理成本可能主导整体AI成本。

-

光子集成电路市场

2023年全球光子集成电路(PIC)市场规模为86亿美元,预计到2032年将增长至476亿美元,CAGR达20.9%。高功率计算技术的电力需求是光子计算增长的核心驱动力。

值得指出的是,虽然Lightmatter是光子计算领域的先行者,但该技术尚未得到广泛应用。NVIDIA、AMD等芯片巨头在市场上占据主导地位,光子计算技术能否无缝集成到现有芯片架构,将决定其市场可行性。

四、竞争对手

Lightmatter 主要通过两款产品——Envise 和 Passage——在高性能 AI 计算和光子互连市场展开竞争。

Envise 主要与专注于高性能 AI 计算硬件的企业竞争,如 NVIDIA H100、Google TPU 和 Cerebras WSE-3。这些竞争者均侧重于计算速度和能效优化,以满足复杂的 AI 计算需求。Envise 采用光子计算技术,而非传统电子晶体管,从而提供更强的计算能力和更低的热量输出,使其在 AI 计算和高性能计算市场中具备独特优势。

Passage 作为基于光子的互连技术产品,竞争对手相对较少。其主要竞争者是 Ayar Labs,后者也专注于利用光子技术提升高带宽计算系统的互连能力。

光子计算领域的主要竞争者

Celestial AI

Celestial AI 主要专注于使用硅光子技术开发高性能内存与互连解决方案。其旗舰产品 Photonic Fabric 具备超高带宽(14.4 Tbps)和低延迟存储交互能力,结合 Chiplet 架构,解决了传统电子互连的局限性,使 AI 硬件扩展更加高效且节能。

Celestial AI 在光子互连市场上与 Lightmatter 的 Passage 直接竞争。二者均致力于提高 AI 计算系统的互连密度和带宽,但 Celestial AI 更专注于内存扩展和芯片间通信,而 Passage 旨在构建更全面的光子互连平台,为 AI 基础设施提供高密度光学互连,同时集成激光器与动态网络切换。

截至 2025 年 2 月,Celestial AI 累计融资 3.389 亿美元,投资方包括三星 Catalyst Fund、淡马锡(Temasek)和美国创新技术基金(US Innovative Technology Fund),公司估值达 12 亿美元。

Ayar Labs

Ayar Labs 成立于 2015 年,专注于利用光学技术提升服务器芯片间的数据传输效率,减少传统电子传输导致的功耗增加。其产品与 Lightmatter 的 Passage 直接竞争。

NVIDIA 在 2023 年 5 月投资了 Ayar Labs 的 1.55 亿美元 C 轮融资,意在将其光学互连技术整合到 GPU 机架中,以提高能源效率。随后,Ayar Labs 于 2024 年 12 月完成 D 轮融资,总额达 1.55 亿美元,估值突破 10 亿美元,投资方包括 AMD Ventures、Intel Capital 和 NVIDIA。截至 2025 年 2 月,公司累计融资 3.747 亿美元。

传统芯片巨头竞争

NVIDIA

NVIDIA 作为全球领先的计算基础设施公司,市值达 3.3 万亿美元(截至 2025 年 2 月),在 AI 芯片市场占据 70%-95% 的份额。其旗舰产品 H100 售价约 3 万美元,这一高成本可能促使部分客户寻求替代方案。

Lightmatter 通过 Envise 进入 AI 计算市场,挑战 NVIDIA 电子 GPU(如 A100、H100)的主导地位。Envise 采用光子计算技术,专注于 AI 计算中的矩阵运算,可能在能效和扩展性方面提供更优解决方案。尽管截至 2024 年 6 月,NVIDIA 仍占据 88% 的 AI 电子 GPU 市场,但 Envise 旨在凭借其能效优势吸引数据中心和大规模 AI 计算应用。

此外,随着 AI 大模型规模不断扩大,所需存储空间也同步增长。例如,NVIDIA 的 GPU 仅配备 80GB 内存,而现代生成式 AI 模型(如拥有数万亿参数的模型)需求远超这一容量,迫使企业部署多个 GPU,从而增加成本和管理复杂性。相比之下,Envise 专为大规模 AI 计算优化,提供更节能、低成本的替代方案。

值得注意的是,NVIDIA 可能也是 Lightmatter 的潜在客户。Passage 可用于替代或增强 NVIDIA 的 NVLink(GPU 与 CPU 之间的高速互连技术),实现更高带宽和更低功耗。

Cerebras

Cerebras Systems 以“全球最大芯片”闻名,其旗舰产品 Wafer-Scale Engine(WSE)被公司称为“地球上最快的 AI 处理器”,在 AI 优化核心数量、内存速度和片上互连带宽方面超越传统处理器。

其最新 AI 计算系统 CS-3,搭载 WSE-3 芯片,在训练 LLaMA 3.1 8B 和 70B 等小型模型时,分别达到了 1800 和 450 tokens/s 的速度。WSE-3 解决了传统 GPU 系统的内存带宽瓶颈,其 7,000 倍于 NVIDIA H100 的内存带宽消除了数据频繁移动的需求,使 AI 训练更加高效。

Cerebras 专注于解决 GPU 系统的存储挑战,例如 LLaMA 70B 需要 140GB 内存,而 Cerebras 通过 CS-3 系统的多机分布式计算,实现对万亿参数规模模型的支持。尽管 Lightmatter 和 Cerebras 均致力于优化 AI 计算性能,但它们采取了不同的技术路径——Cerebras 采用晶圆级电子计算,而 Lightmatter 则利用光子计算技术。

五、商业模式

截至2025年2月,Lightmatter的定价模式尚未公开。然而,该公司通过将光互连技术直接嵌入芯片封装,旨在大幅提升数据中心的性能和效率,以满足日益增长的AI计算需求。这一技术突破使数据中心能够更好地扩展,并应对复杂的人工智能工作负载。Lightmatter的营收模式可能主要依赖于直接产品销售,同时也包括与需要前沿计算解决方案的企业建立长期合作关系。公司首席执行官Harris曾表示,其产品Envise的定价“与标准硅芯片相比相当有竞争力,但极致性能可能会带来一定溢价。”

此外,Lightmatter可能还会提供技术授权或集成服务,特别是在大规模基础设施部署中,光子技术能够优化数据传输和计算效率。随着云计算和AI数据中心的快速发展,这一领域可能为Lightmatter带来可观的商业化机会。同时,行业对硅光子技术在下一代AI芯片和系统中的采用趋势日益增强,这也为Lightmatter提供了进一步发展的空间,使其能够在市场逐步向光子架构转型的过程中占据有利地位。

六、重大进展

Lightmatter正在与多家半导体巨头合作,包括AMD、NVIDIA、Intel和Qualcomm,为它们的芯片提供光互连基板。该公司首席执行官表示,Lightmatter的基板是“计算技术未来发展的基石。它将显著降低计算集群的能耗,并使其扩展至百万级节点甚至更大,这也是实现晶圆级计算、打造全球最大芯片和通用人工智能(AGI)的关键。” 在常见的计算任务中,Lightmatter的技术相比NVIDIA的A100芯片快达10倍,同时,其服务器刀片的吞吐量是NVIDIA服务器的八倍,而功耗仅为后者的五分之一。

截至2025年2月,Lightmatter在波士顿和山景城的两处办公地点共拥有约191名员工,相较2023年增长了46%。

2024年11月,Lightmatter与全球领先的半导体封装与测试服务提供商Amkor Technology达成合作,共同打造全球最大规模的3D封装芯片复合体,利用Lightmatter的Passage技术来优化封装设计。Lightmatter的光子技术结合Amkor的多芯片封装(multi-die packaging)能力,将有助于解决AI工作负载对互连扩展性和功耗的苛刻需求。

多芯片封装技术可以将大型半导体芯片分解为多个较小的芯片单元,并将多个芯片整合在一个封装内。当这一技术与Lightmatter的光子互连相结合后,能够利用光通信技术优化芯片内部的数据传输,大幅降低能耗。

七、融资估值

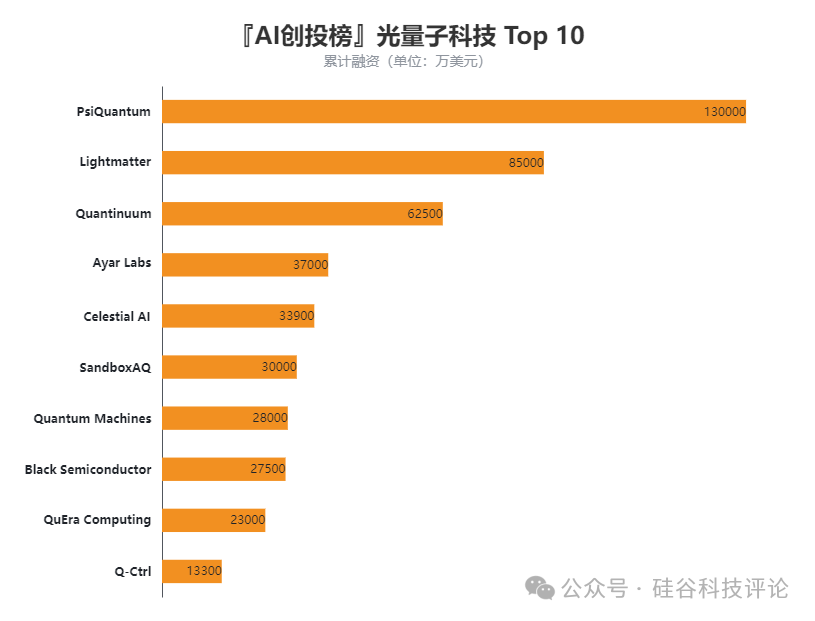

2024年10月,Lightmatter完成了4亿美元的D轮融资,估值达到44亿美元。本轮融资由T. Rowe Price领投,Google Ventures和Fidelity等老股东跟投。至此,Lightmatter已在六轮融资中累计筹集资金8.5亿美元,在硅谷科技评论(SVTR)AI创投榜光量子科技赛道排名第二。

公司此前的投资方包括Matrix、Spark Capital、SIP Global Partners、Sequoia、Lockheed Martin Ventures、FAST(GettyLab旗下基金)、Hewlett Packard Enterprise、Viking Global Investors、Trajectory Ventures和Eastward Capital Partners等知名机构。

Lightmatter首席执行官Harris表示,D轮融资很可能是该公司最后一轮融资。他还透露,Lightmatter在2024年10月已锁定了一些大规模订单,正是这些订单的支持,使公司能够成功获得如此大规模的融资。这表明Lightmatter已经进入了强劲的商业化阶段,并具备了持续发展的资金实力和市场认可度。

八、关键机会

1、光子互连技术

随着摩尔定律的放缓以及硅芯片制造在物理和经济上的局限性,高性能计算领域迎来了光子互连技术的重大机遇。当前,数据中心面临着处理不断增长的 AI 工作负载的挑战,而硅基芯片的扩展性已接近极限。Lightmatter 的光子技术正好能解决这一瓶颈,其高速数据传输和低能耗特性为现代数据中心的大规模芯片互连提供了基础设施支持。

利用光子技术,Lightmatter 能够满足 AI 基础设施对高密度互连环境的需求。其 Passage 技术旨在与超大规模芯片(甚至接近晶圆级芯片)无缝集成,使整个数据中心像单台高性能计算机一样运作。这一发展趋势与人工超级智能(ASI)的推进相吻合,Lightmatter 的光子互连技术可能成为推动 AI 迈向更高性能水平的关键。

目前,NVIDIA 的 GPU 和 Intel 的 Xeon CPU 分别以 13% 和 18% 的年均增长率(CAGR)增长,预计到 2040 年,它们可能发展至晶圆级芯片。然而,随着芯片数量的增加,其互连需求呈 4 倍增长,导致路由、带宽和延迟等问题日益突出。而光子技术正是解决这一问题的最佳方案。

2、新型芯片基板

除了芯片互连技术,Lightmatter 还在研发新型芯片基板,以利用光子技术进一步提升芯片的互连能力。2024 年 10 月,Lightmatter CEO Nicholas Harris 预测,未来 10 年内,类似 Cerebras 率先推出的晶圆级芯片将成为行业标准。然而,他认为,目前的 Cerebras 技术尚未真正发挥出这一技术突破的全部潜力。

芯片基板是支撑和连接微电子器件的基础材料,决定着芯片的稳定性、电气性能和散热能力。未来,先进的基板技术可能成为 Lightmatter 拓展光子技术的又一重要机遇。通过研发新一代基板,Lightmatter 可以整合更大规模、更复杂的光子组件(如晶圆级芯片),从而提升性能、降低延迟,并满足 AI 和 ASI 数据中心对超大规模互连的需求。

3、激光技术

Lightmatter 还在探索芯片级铒掺杂波导激光器(Erbium-Doped Waveguide Lasers),这一技术有望进一步增强其光子计算和互连解决方案。铒掺杂激光器长期以来主要用于光纤通信,依靠铒离子作为增益介质,在特定波长下放大光信号,具有高相干性和稳定性,非常适合远距离及高精度光学应用。

如果将这种技术应用到 Lightmatter 的光子产品中,可能带来以下优势:

-

提高精度和能效:稳定的铒掺杂激光器可提升数据传输的精准度和效率,满足高带宽 AI 计算需求。

-

提升可扩展性:小型化的激光器能集成到更紧凑的光子芯片中,使产品具备更好的扩展能力。

-

降低制造成本:这一技术或能提升光子芯片与现有半导体制造工艺的兼容性,从而降低生产成本。

此外,该技术不仅能助力数据中心和 AI 计算,还可能为 Lightmatter 在电信、激光雷达(LiDAR)和高精度传感等行业打开新的市场。随着芯片级激光技术的发展,Lightmatter 或能借助这一创新,在多个高增长领域占据先机。

九、主要风险

1、光子计算的市场接受度

将光子计算集成到现有电子系统中面临诸多技术挑战。由于光子技术本身在制造和设计上的复杂性,截至 2024 年,这种新兴技术的推广仍然存在一定障碍。虽然 Lightmatter 声称其技术能够与现有电子基础设施兼容,但目前尚未公布任何正式客户,这表明市场可能对这一创新方案仍持观望态度。

对于已经建立成熟电子系统的数据中心而言,采用光子计算可能带来运营上的中断风险。因此,如何降低转换成本、提高兼容性,并提供令人信服的性能提升,将是 Lightmatter 推动市场接受度的关键。

2、逻辑运算的局限性

光子计算在执行逻辑运算方面存在根本性限制,特别是在需要控制流和条件判断的通用计算任务上。历史上,业界曾尝试解决这一问题,例如 1980 年代 Bell 实验室研发的光学晶体管技术,但由于非线性光束相互作用的复杂性,最终未能成功商业化。

针对这一局限性,Lightmatter 选择专注于线性代数计算,这与光的电磁特性高度契合。然而,这种专注也意味着光子计算的应用范围受到限制,主要适用于机器学习、航空航天工程、化学模拟和量子计算等特定领域。尽管这些领域对高效计算有着巨大的需求,但光子计算若想在更广泛的计算任务中发挥作用,仍需突破逻辑运算的固有限制。

十、全文总结

随着 AI 计算需求的激增,传统硅基计算正逐渐逼近其物理和经济极限。摩尔定律的放缓使得数据中心和 AI 公司迫切寻找新方案,以在处理日益增长的工作负载的同时,降低能耗和运营成本。Lightmatter 通过光子计算硬件应对这一挑战,其技术利用光代替电信号进行计算,突破传统芯片的性能瓶颈。

Lightmatter 的核心产品 Passage 是一款光子互连解决方案,可无缝集成至现有数据中心基础设施,提供更高带宽的数据传输,并减少芯片的功耗。此外,其 Envise 产品是一款专为 AI 计算设计的光子加速器,能够以更节能的方式运行 AI 任务,为未来高性能计算提供新的可能性。

硅谷科技评论(SVTR.AI),在ChatGPT问世之际,创立于美国硅谷,依托#AI创投库、#AI创投会、#AI创投营 和风险投资,打造全球前沿科技(AI)创新生态系统。联系凯瑞(pkcapital2023),加入我们,共创未来。点击文末阅读原文,访问SVTR.AI,发现更多机会与内容!

Startup

+

| 11x.ai:AI虚拟销售员,半年内突破200万美元 |

| AlphaSense,金融界的“谷歌” |

| AMP Robotics,如何用AI拯救垃圾场? |

| Anduril Industries:AI 重新定义现代战争与和平 |

| Anthropic:OpenAI”宫斗”背后的公司 |

| AssemblyAI,企业音频市场拓荒者 |

|

|

| Bardeen:让AI代理更稳更快 |

| Brightwave,AI驱动的投研助手 |

|

|

Calendly:日程安排助手,AI效率工具鼻祖 |

Canva:从Adobe、Figma、Canva 到 OpenAI |

| Carta:想要取代纽交所的股权管理工具 |

| Cerebras,打造世界最大芯片挑战AI霸主英伟达 |

|

|

| Consensus:用AI解锁学术 |

CoreWeave:GPU租赁独角兽,英伟达的好盟友 |

| Databricks:从数据湖到大模型丨人工智能战略 |

| DeepL:从机器翻译到AI写作的语言沟通利器 |

| DeepSeek最重要的三篇论文解读丨关于Deepseek的几点思考的回应 |

| Discord:腾讯多次押注,打造属于你自己的线上互动社区 |

| DoNotPay:世界首款AI机器人律师 |

Duolingo:如何改写语言学习 |

| E2B:为 AI 代理构建自动化云平台 |

|

|

| Figma:从Adobe、Figma、Canva 到 OpenAI |

| Figure,从体力劳动中解放全人类 |

Glean:重塑知识工作的未来 |

| Grammarly:从论文查重到AI写作的沟通利器 |

| Hallow,如何用AI让古老的信仰获得新生? |

| Helion,AI的终极能源梦想 |

| Hippocratic AI,用AI缓解全球医护人员短缺 |

| Hugging Face:开源AI的未来 |

| Jenni AI:如何通过AI写作实现年入千万 |

|

|

| Letta:AI代理技术栈市场地图 |

| Marblism:一句AI提示词自动生成各类软件 |

| Midjourney:0融资,11人,$1亿收入 |

| Mistral,欧洲大模型,性价比之王 |

| MultiOn,用人工智能代理给软件装上大脑 |

| Neuralink:让失明者重见光明,让瘫患者再次行走,让人类与AI融合永生 |

| OpenAI:人工智能突破的前沿丨员工丨董事会丨营销丨GPT Store丨奥特曼丨马斯克丨微软丨产品生态 |

|

|

| Pika:AI视频的未来 |

| Rad AI:如何用 AI 改变医疗保健 |

| Reddit:奥特曼押注基于兴趣社交的美版“贴吧” |

| Replicate:1人AI公司背后的幕后英雄 |

| Replite:教马斯克的儿子如何写代码 |

| Rows:一年内用户增长20倍背后的故事 |

| Perplexity:挑战谷歌,站在AI搜索最前沿 |

| Runway:AI视频的未来 |

| Scale AI:如何成为数字世界的“水源” |

| Shein:打造下一个“中国首富” |

| Skild AI,打造通用机器人“大脑 |

SpaceX:梦想照进现实,人类星际生命的曙光 |

| Stability AI:SD 背后的公司和创始人 |

| Stripe:马斯克和奥特曼押注的支付王者 |

| Substack:美版公众号,为价值付费 |

Superhuman:邮件超人,拥抱 AI |

| Telegram,俄罗斯兄弟的密聊纸飞机 |

| Vannevar Labs:AI+国防,军事人工智能掘金者 |

| Vercel,如何用AI引领技术开发? |

|

|

| Zapier:ChatGPT最受欢迎插件的过去和未来 |

| People(找人) |

| 如何找到创业合伙人丨如何聘请CEO丨如何确定CEO的薪水丨如何分配股权和头衔丨如何组建和召开董事会丨选择自己的创业导师 丨找这种人实现快速裂变丨如何找到那个“改变命运”的第一位员工?丨员工股票期权计划(ESOP) |

| Funding(找钱) |

| 如何写商业计划书丨初创公司估值丨如何做电梯演讲丨如何确认真实投资意愿丨如何选择VC丨早期融资的“科学”与策略丨初创公司的融资生存法则丨风险投资人最关心的一个指标丨“七条法则”让投资人主动“敲门” |

| Vision(找方向) |

| 性格决定创业成败丨如何成为亿万富翁丨如何做出困难的决定丨如何寻找创业方向丨如何在海外启动新产品丨GTM指南丨不要像投资人那样思考丨创始人与市场契合度丨为什么初创公司会失败丨什么决定创业成败丨如何建立社交媒体形象丨PMF决定初创的未来丨创始人的必读书单丨 5 点创业洞见丨如何做增长 |

| AI创业 |

| 如何打造AI驱动的公司丨AI创业如何选赛道丨如何打造AI软件产品丨AI公司要不要融资丨AI初创公司商业模式丨AI原生公司定价策略丨AI初创公司增长策略丨2B还是2C |

Venture

+

| A16Z:全球AI产品Top100丨人工智能到底能做什么丨AI将会拯救世界丨AI语音智能体(AI Voice Agents)该怎么投? |

| Air Street Capital:State of AI(2024) |

| Alphabet谷歌战投:全球最牛AI战投是如何炼成的丨人工智能战略 |

| Altimeter:谁是AI C端赢家 |

| Amazon:人工智能战略 |

| Apple:产品收入变迁丨 AI 并购之王 |

| Battery Ventures:AI正推动云计算的下一波增长丨AI正带来 4 万亿美元市场机会 |

| Bessemer Venture Partners:Cloud 100(2024)丨如何打造AI核心竞争力 |

| Bond:AI将改变教育和教学方法 |

|

|

| Cowboy:AI大势所趋 |

| Daniel Gross:硅谷90后AI投资人 |

| Dawn Capital:如何通过人工智能增强人脉 |

| Elad Gil:关于人工智能我所不知道的事情 |

| Emergence:生成式 AI 六大最新趋势 |

| FirstMark:MAD 24问,AI 2023年总结,2024年展望 |

| Forerunner:超个性化和动态交互才是未来 |

| Foundation Capital:服务即软件的万亿机会 |

| Founders Fund:如何投出下一个独角兽丨彼得·泰尔丨泰尔研究员 |

| General Catalyst:AI+医疗支持者 |

| ICONIQ:小扎的朋友圈丨AI成为大企业战略核心 |

| Insight Partners:AI应用将如何实现人机协同丨AI Agent正在颠覆自动化 |

| Lightspeed:AI+法律市场机会地图 |

| M12(微软):如何抢占AI投资制高点丨收入拆解 |

| Madrona丨2025 年最值得关注的AI五大趋势 |

| Menlo Ventures:2024企业Gen AI现状报告丨AI代理全面崛起丨Gen AI 应用拐点已到丨AI+安全市场地图丨企业AI架构的设计原则 |

| NVIDIA:收入丨AI投资策略 |

| Sam Altman(山姆·奥特曼):如何做早期投资丨地产生意丨投资帝国丨婚礼丨阅读清单 |

| Sapphire:AI原生应用丨AI进入调整期丨AI 行研 丨 销售人工智能如何重塑 GTM |

| Scale Venture Partners:如何用AI工具解决硬件难题? |

| Sequoia(红杉资本):如何做投资丨代理型AI应用崛起丨生成式AI进入第二阶段 |

| Sierra Ventures:垂直场景将是最大的创业机会 |

|

|

| TRAC:风投界的水晶球 |

| Thrive Capital:高位接盘OpenAI |

| Union Square Ventures(USV)丨精益创业时代终结,硬科技重新定义风险投资 |

| Wing Venture Capital:2024年企业科技 30 强(ET 30) |

| YC:全球排名第一的AI投资机构丨给年轻创始人建议丨如何独立思考丨YC与A16Z的押注有何异同 |

| 20VC:从播客主持人到风投大佬 |

| LP |

|

精品基金/超级基金丨AI驱动VC丨通才/专才风投人丨VC/PE丨孵化器丨加速器丨初创工作室丨如何发掘下一个伟大的投资人 |

| GP |

| 如何及早识别独角兽丨如何避免7大投资陷阱丨合伙人是怎么炼成的丨Souring的艺术丨颜值如何影响VC决策丨如何快速解读对方性格丨硅谷投资人的武器库丨如何用数据控制初创公司团队风险丨什么决定创业成败 |

| AI投资 |

| 如何评估AI初创公司丨海外投资人谈AI新趋势丨应该关注哪些AI公司丨AI 创投七大新趋势丨全球AI创投生态丨全球AI投资机构Top10 |

Technology

+

|

|

| “AI张雪峰”诞生,北大团队用 AI 重塑教育咨询 |

| 1人团队,百万营收的AI套壳 |

| 2024 年必读人工智能书单 |

| 加密信条:数字货币的前世、今生和未来 |

| 计算机芯片的演变 |

| 内容创作指南,如何通过写作赚钱? |

| 传统公司如何抓住AI浪潮? |

|

|

|

|

|

|

| AI 创始人 | 华裔创始人 | 北美科技人才中心地图丨职业经历丨教育背景丨斯坦福丨普林斯顿丨多伦多大学 |

| AI 公司地理和行业分布 | 以色列 | 德国 | 旧金山湾区 | 欧洲丨法国 |

|

|

| AI代理:创始人该如何站上3000亿美元的风口?丨智能体(AI Agent)市场地图 |

| AI+国防安防:如何重新定义现代战场的核心竞争力 |

| AI+人力资源:用科技重塑就业与招聘的未来 |

| AI+搜索:全球新锐公司谁能杀出重围? |

| AI+社交:该怎么玩? |

| AI+编程:公司排行榜丨市场地图丨AI工程师丨SaaS的新曙光丨AI驱动编程:真能让小白成为开发高手吗? |

| AI+金融:如何缔造下一个金融科技传奇丨大模型在金融投资领域的应用丨AI将如何改变会计 |

| AI+游戏:市场研究报告丨初创公司Top 10 |

| AI+机器人 |

| AI+医疗:市场地图丨心理/精神公司 |

| AI+教育:市场地图 |

| AI+客服:市场地图 |

| AI+法律:市场地图 |

| AI+视频:市场地图丨3D视频 |

| AI+生产力工具市场地图 |

| AI+科研 |

Review

+

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 051 |

|

|

|

|

|

|

|

059 |

|

|

|

|

063 |

|

065 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 081 | 082 | 083 | 084 | 085 | 086 | 087 | 088 | 089 | 090 |

| 091 | 092 |

|

|

|

|

|

|

|

|

(文:硅谷科技评论)