现在一提AI大模型,言必称ChatGPT、DeepSeek、Grok3等知名大语言模型唵,这类模型有一个共同的名字:LLM(Large Language Model)。

而它们的底层逻辑是相通的,靠一个token一个token的推测要回复的下一个词。

这样就带来两个缺点,一是比较消耗token(成本),二是速度比较慢。

假如智能汽车使用这种大模型,就会出现这样的情况:

车主:左拐。

大模型:思考76秒。

(以上是段子)

有一家叫做inception的公司,推出了一个叫做Mercury的模型,称其为DLLM。

这里的D,指的是Diffusion,也就是扩散模型的逻辑。

玩AI绘画的都清楚,现在AI绘画的基本原理,正是Diffusion,最流行的绘画大模型就是Stable diffusion(当然最近被Flux代替,但Flux依然是diffusion)。

所谓Diffusion,是先瞬间生成一个模糊图像,然后不断修正,最终生成和提示词精准匹配的画面。

DLLM采用了这样的逻辑,先生成一个答案,然后不断的修正,最终生成和问题相契合的答案。

Mercury这个名字也很有意思,虽然国内经常翻译成水星,但实际上它应该音译为墨丘利,是罗马神话中众神的使者。

只是恰好西方命名水星的时候用了这个神祇的名字。

inception想做众神的使者,而inception的意思是开端。

谁是神?

也许,未来AI大模型就是神。

按照inception的宣传,Mercury比传统LLM快5-10倍,使用价格还更便宜。

那它的效果如何呢?

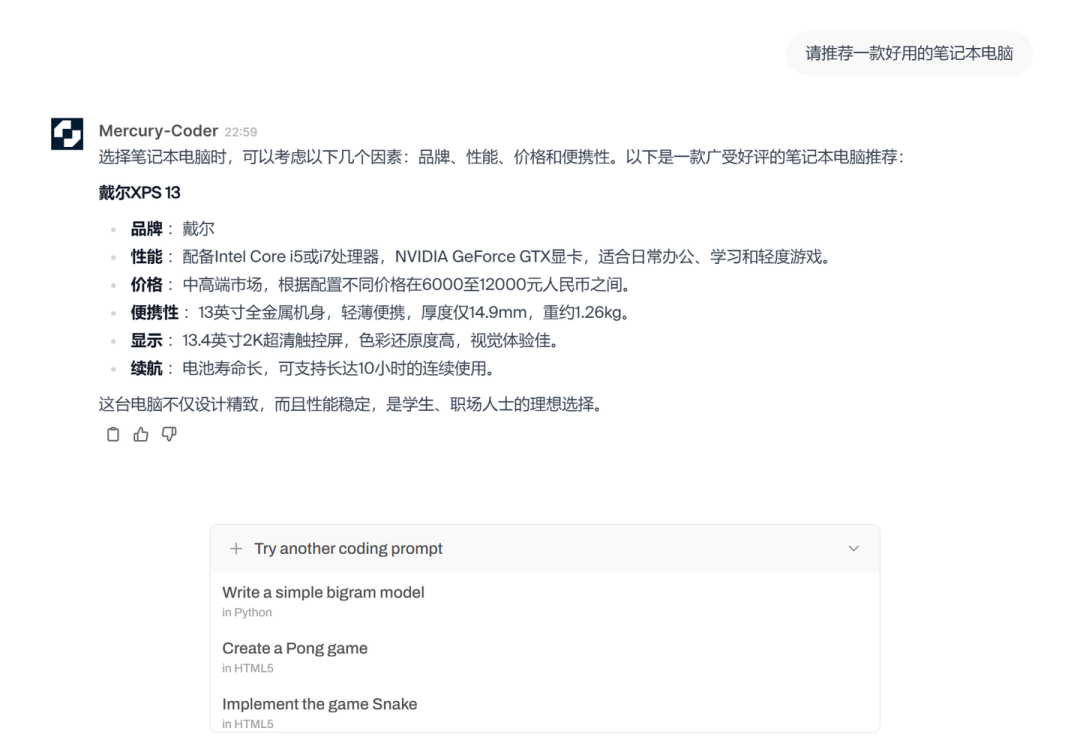

我简单试了下,作为第一个版本,应该说完成度非常高,至少可用性很强。

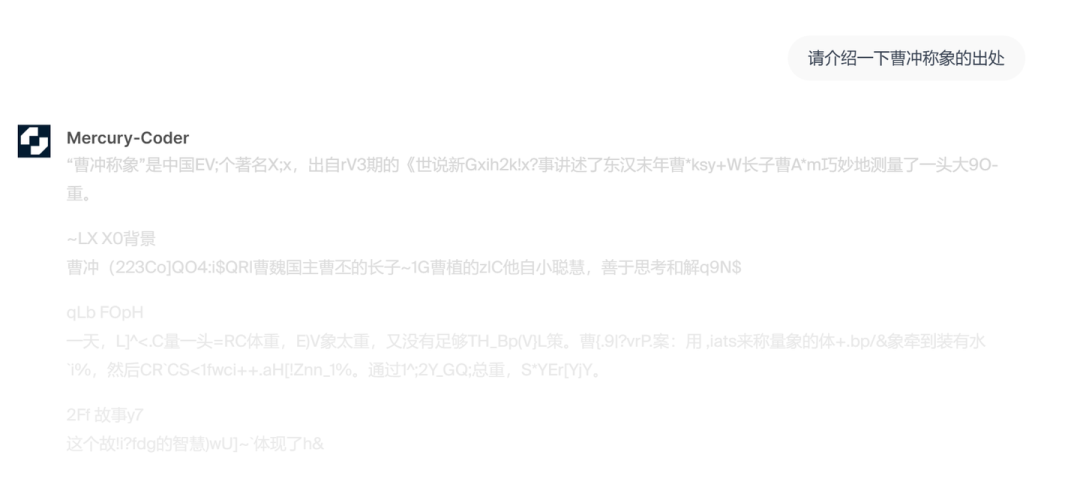

在提问的时候,Mercury会迅速给出答案,但和AI绘画类似,答案是在变化的:

我们可以发现答案并不精准,掺杂着很多不明字符。

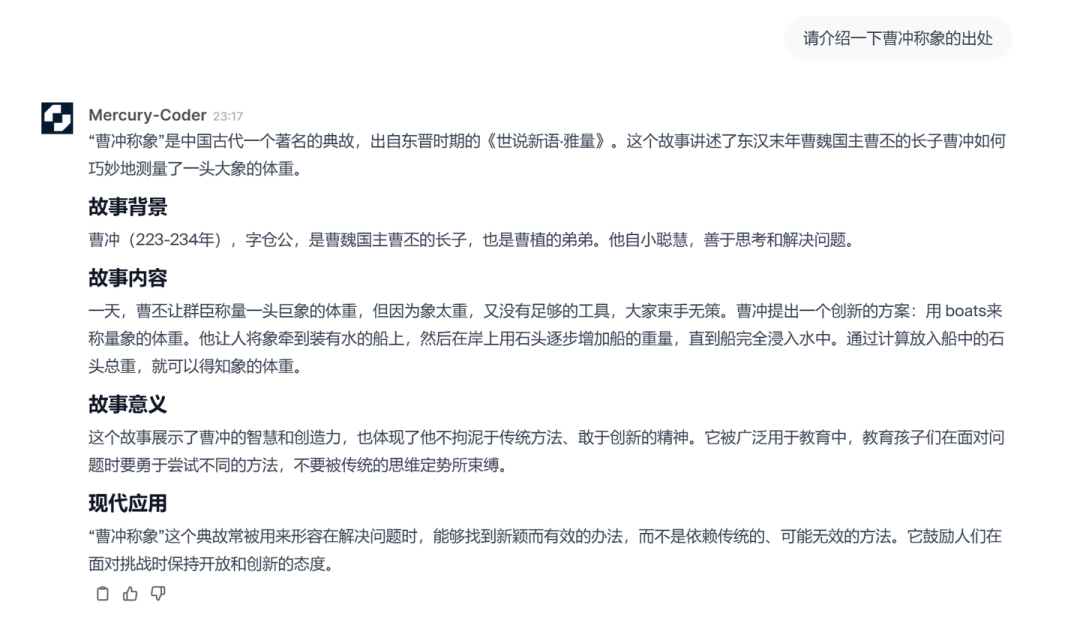

几秒钟后答案固定下来:

当然了,快的代价是不够精准,很显然Mercury把曹冲当成了曹丕的长子,有点过于离谱(也可能是中文语料训练不足)。

期待后续版本的表现。

(文:路过银河AI)