昨晚谷歌终于圆上了他们年底画的饼。

发布了支持图片生成和编辑的多模态 Gemini 2.0 模型。

为什么这是一个值得关注的事情呢?

因为原生支持图片生成的语言模型可以实现以往需要很多工具才能完成的功能。

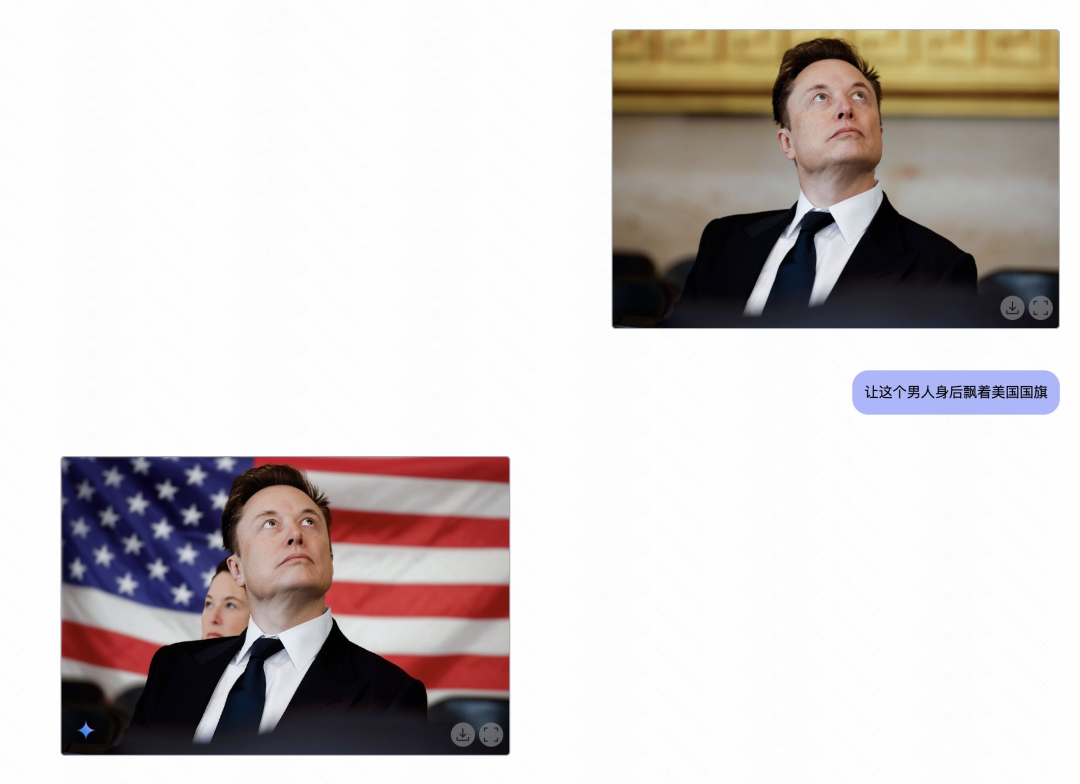

比如你可以直接通过对话修改你上传的图片。

可以通过对话混合两张图片,比如将图 1 的产品放到图 2 的环境里面

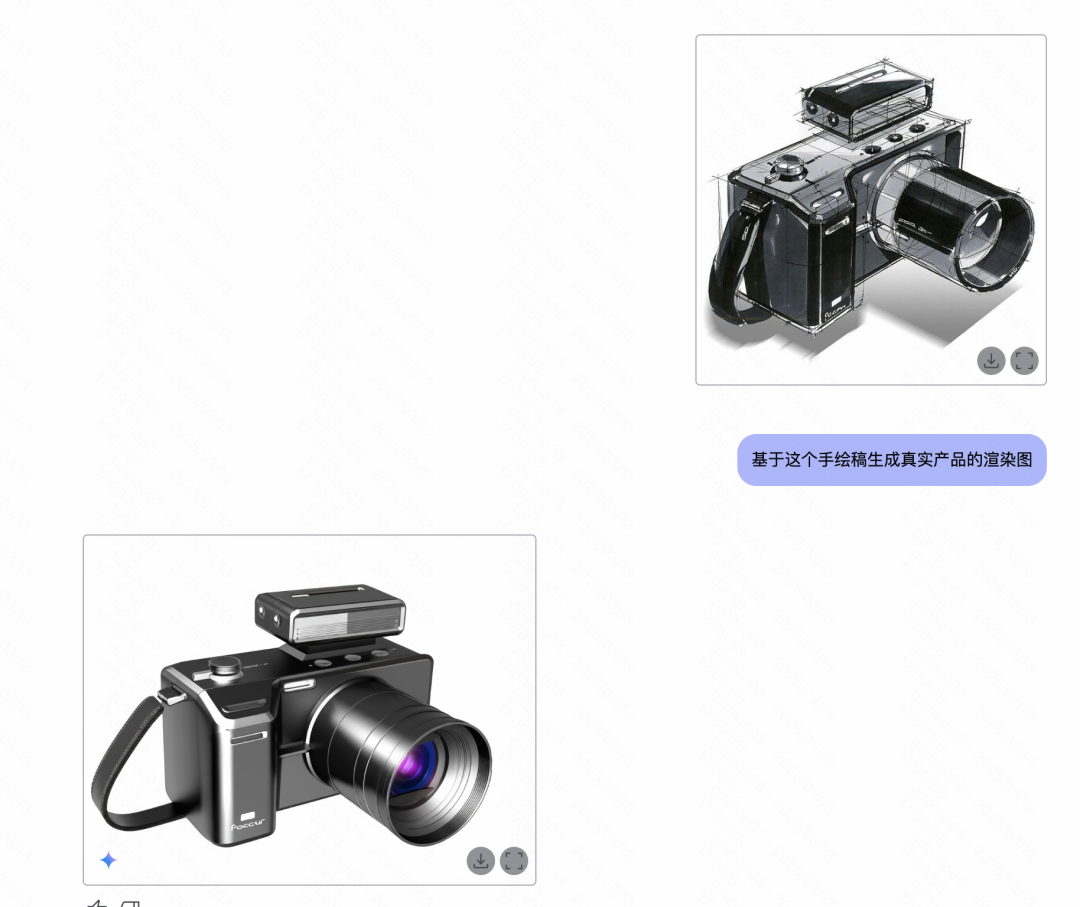

甚至于说让他从草稿生成完整产品的渲染图

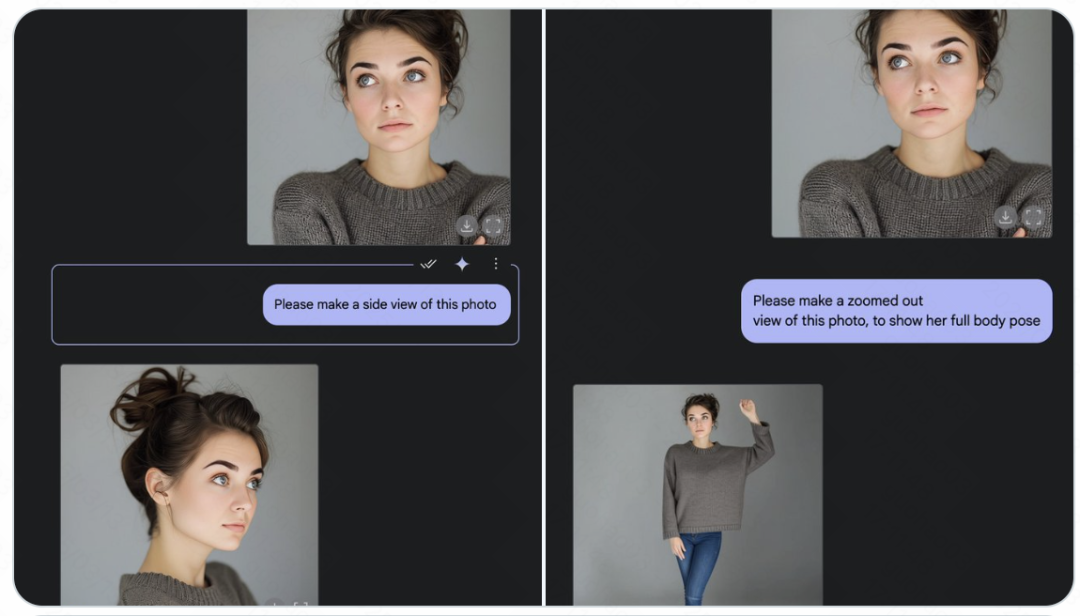

其中他最强的一个能力是在生成多张跨场景图片的时候可以保证人物特征的一致性,甚至能保证场景一致性。

这是目前我们做视频和连续内容最头疼的部分。现在你只需要动动手指打字就行。

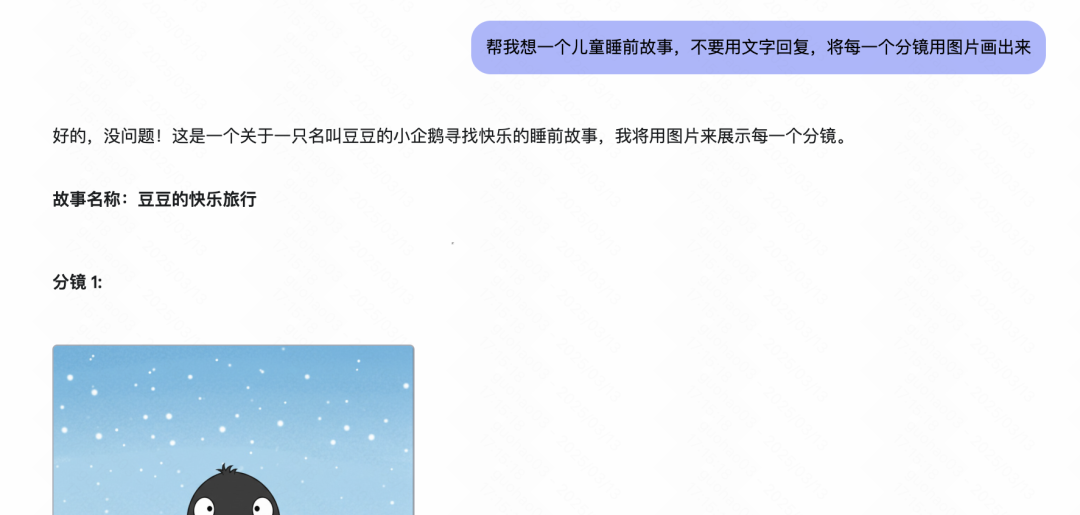

最离谱的是什么呢,你完全可以让他一次生成一个完整故事所需要的所有图片分镜。

由于是一次生成的,所有的图片都能保证在风格、角色、环境上的一致性,直接解决了现在视频创作最恶心的问题。

而且效率非常高不需要反复调整,一次能出十几张。

我就只说了一句话,他就帮我生成了一个睡前故事需要的所有图片和口播稿,我把他们扔进剪映里面 3 分钟搞定了这个睡前故事视频。

以前哪敢想啊家人们。

另外我们完全可以将这些图片扔到可灵和海螺里直接生成视频,表现力会大幅上升,比如 Padphone 老师做的这个皮卡丘就是这样搞得。

稍微产品化一下,我们就能实现一句话生成视频了,没想到这一天来的这么快。

最后谷歌这个功能依旧是免费的,你几乎可以无限白嫖。

使用方式:

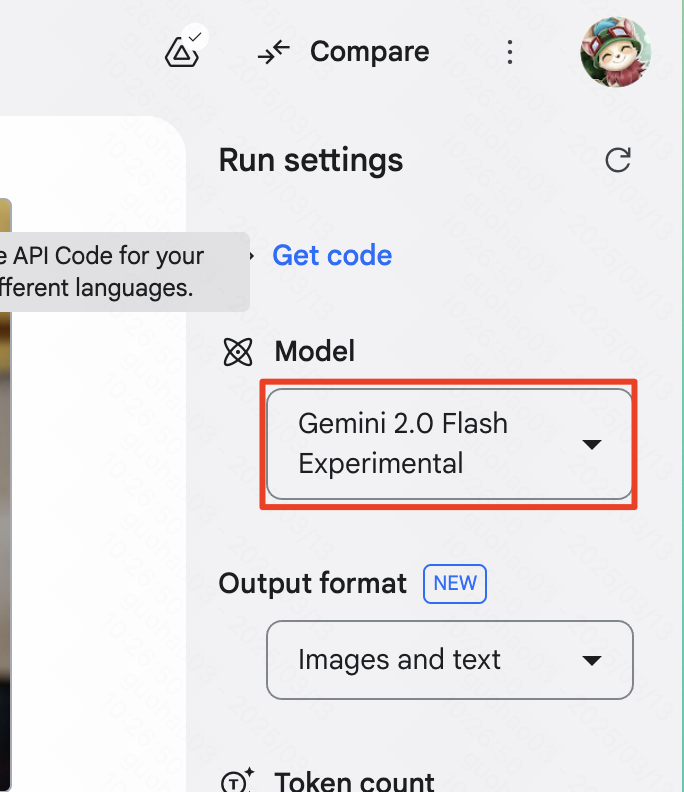

打开 AI Studio

右侧将模型切换为 Gemini 2.0 Flash Experimental

直接自然语言跟模型沟通就行

赶紧去试试吧,朋友们,单纯用来生成图片的话这个模型的质量也非常不错。

别忘了 Gemini 2 还是目前视频多模态理解最强的模型,视频生成和编排的新时代就要来了,就看哪些团队能抓住机会了。

如果觉得对你有帮助的话请不要吝啬你手中的赞👍、喜欢🩷和分享按钮✈️,🙏

(文:归藏的AI工具箱)