-

-

• 小而强:阿里巴巴发布 Qwen2.5-VL-32B-Instruct,32B 参数性能超越自家 72B 模型,多项基准测试胜过同规模对手。 -

• 多面手:数学推理、精细图像理解表现出色,回答更符合人类偏好。 -

• 易部署:可在单 GPU 或高配 Mac 上运行,大幅降低使用门槛。 -

• 新标杆:性能比肩 GPT-4(2023 年 3 月版),证明小模型也能有大作为。

今天,阿里巴巴用一款开源模型,证明了小模型也能有大能量!它就是 Qwen2.5-VL-32B-Instruct ——一款参数规模仅为 32B 的多模态模型,却在多项关键指标上超越了自家 72B 的“老大哥”,甚至能与 GPT-4(2023 年 3 月版) 一较高下!

开源视觉模型新标杆

2025年3月24日,阿里巴巴 Qwen 团队正式发布 Qwen2.5-VL-32B-Instruct。这款模型并非凭空而来,它是在广受好评的 Qwen2.5-VL 系列基础上,经过持续优化和强化学习打造而成。

Qwen2.5-VL-32B-Instruct 实现了三大核心突破:

-

• 更懂你:通过强化学习,模型的回答风格更贴近人类偏好,输出结果更加详细、格式更优。 -

• 更聪明:在数学推理、精细图像理解和推理方面表现出色,能够处理更复杂的任务。 -

• 更轻便:32B 参数规模,可在单 GPU 或配置较高的 Mac 笔记本上运行,大大降低了使用门槛。

小身材,大能量

长期以来,人们普遍认为,模型参数规模越大,性能就越强。然而,Qwen2.5-VL-32B 却打破了这一“定律”。

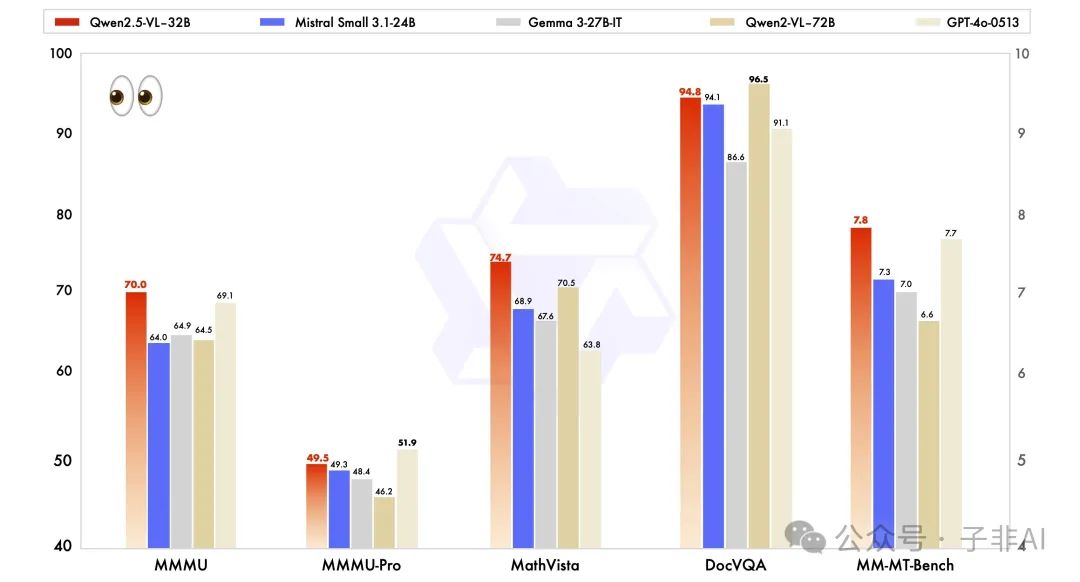

在多项权威基准测试中,Qwen2.5-VL-32B 不仅超越了同规模的竞争对手,如 Mistral-Small-3.1-24B 和 Gemma-3-27B-IT,甚至还优于自家参数规模更大的 Qwen2-VL-72B-Instruct!

尤其值得一提的是,在 MMMU、MMMU-Pro、MathVista 等侧重复杂、多步推理的多模态任务,以及 MM-MT-Bench 这一强调主观体验评估的测试中,Qwen2.5-VL-32B 均取得了显著优势。

数据说话

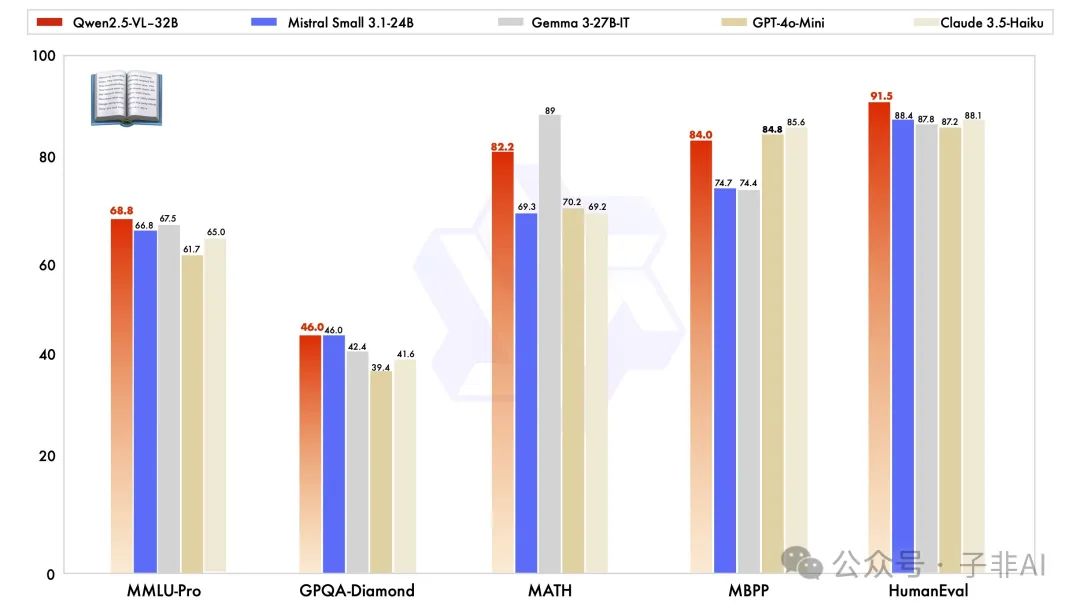

在纯文本能力方面,Qwen2.5-VL-32B-Instruct在同等规模的模型中,纯文本能力达到顶级水平。

不止能看图,文字理解也一流

尽管 Qwen2.5-VL-32B 是一款多模态模型,但它在纯文本处理方面的能力同样不容小觑。在同等规模的模型中,Qwen2.5-VL-32B 的纯文本能力达到了顶级水平。

这意味着,无论是处理图像、文本,还是两者的结合,Qwen2.5-VL-32B 都能游刃有余,为用户提供全方位的智能支持。

案例展示

我们通过几个具体案例,来看看 Qwen2.5-VL-32B 的真本事。

限速难题

用户提问:我现在开着一辆大卡车在这条路上,现在是 12 点。我能在 13 点前到达 110 公里外的地方吗?

Qwen2.5-VL-32B 回答:

为了确定您是否能在 13:00 之前到达 110 公里外的地方,我们需要分析提供的信息:

-

• 当前时间:12:00。 -

• 到目的地的距离:110 公里。 -

• 卡车限速:限速标志表明卡车的最高速度为 100 公里/小时。

逐步分析:

-

1. 计算所需的行程时间行程时间计算公式:时间 = 距离 / 速度给定: 代入数值:

时间 = 110 公里 / 100 公里/小时 = 1.1 小时

-

• 距离 = 110 公里 -

• 最高速度 = 100 公里/小时 -

2. 将时间转换为小时和分钟 -

1. 1 小时相当于:1 小时 + 0.1 × 60 分钟 = 1 小时 + 6 分钟 = 1 小时 6 分钟 -

3. 确定到达时间如果您从 12:00 出发,行驶 110 公里需要 1 小时 6 分钟,您的到达时间将是:12:00 + 1 小时 6 分钟 = 13:06 -

4. 与目标时间比较您想在 13:00 之前到达。然而,根据计算,您将在 13:06 到达,这比 13:00 晚。

结论:

考虑到卡车限速 100 公里/小时,您不可能在 13:00 之前到达 110 公里外的地方。

因此,最终答案是:不能。

案例分析:

在这个案例中,Qwen2.5-VL-32B 展现出了强大的综合能力:

-

• 精细图像理解:准确识别出图像中的限速标志、卡车类型等关键信息。 -

• 复杂推理:结合当前时间、距离和限速信息,进行多步推理,得出最终结论。 -

• 数学计算:精确计算出所需时间,并将其转换为小时和分钟,确保结果的准确性。 -

• 清晰表达: 回答逻辑清晰,步骤明确,让人一目了然。

开源社区反响

Qwen2.5-VL-32B 的发布,在开源社区引发了热烈讨论。

-

• 中国开源模型崛起:Qwen2.5-VL-32B 与 DeepSeek-v3-0324 等模型的发布,被视为中国开源模型崛起的标志性事件。 -

• 模型开源的商业模式:资金来源、数据使用、未来发展等问题,引发社区讨论。

jsheard: “一旦烧投资人的钱不再是一种可行的商业模式,我仍然不明白新的开源模型的资金将从哪里来。“

Imustaskforhelp:“我认为这是市场领导地位,这只是免费的口碑广告,然后可以带来咨询业务。”

-

• 实际应用:社区成员积极探索 Qwen2.5-VL-32B 在不同场景下的应用潜力。

ggregoire: “自从我们尝试了 Qwen 之后,就再也没有回头看过 Llama 或任何其他视觉模型。”

-

• 硬件需求:如何在不同硬件上运行 Qwen2.5-VL-32B,成为社区关注的重点。

simonw: “32B 是我目前最喜欢的模型大小之一……但又小到可以在单个 GPU 或配置合理的 Mac 笔记本电脑(32GB 或更多)上运行。”

开放合作,共创未来

Qwen 团队开放模型,拥抱社区,与全球开发者共同推动 AI 技术的进步。

未来,Qwen2.5-VL-32B和后续模型将能够处理更复杂的场景,实现更深层次的推理能力。

该模型采用了 Apache 2.0 许可,这意味着任何人都可以免费使用、修改和分发该模型。

总结与思考

Qwen2.5-VL-32B 的发布,不仅是一款优秀模型的诞生,更是一次对传统 AI 发展模式的挑战。

它向我们展示了:

-

• 开源潜力:开源模型可以与闭源模型竞争,甚至超越。 -

• 小模型,大作为:通过优化,小模型也能拥有大智慧。 -

• 开放合作:开源社区的协作是推动 AI 发展的重要力量。

未来,开源模型将如何改变 AI 行业?普通用户如何从中受益?这些问题,仍然需要我们共同思考和探索。

推荐阅读

-

• Qwen2.5-VL-32B 技术报告:https://arxiv.org/abs/2502.13923 -

• Qwen GitHub 仓库:https://github.com/QwenLM/Qwen -

• Qwen 官方博客:https://qwenlm.github.io/blog/qwen2.5-vl-32b/

(文:子非AI)