谷歌凭借Gemini 2.5 pro已经彻底翻身,经过这段时间各路大神的深度使用和评测,基本上已经锁定大模型top1,除了优秀的写作能力以外,编程能力更是打遍无敌手,最重要的Gemini一直以来基本是免费给所有人用,连API都免费

今天有幸看到了一份来自Google内部的技术分享,主讲人是Vlad Feinberg,谷歌Gemini Flash Pretraining的负责人。这份PPT信息量爆炸,深入探讨了Gemini预训练背后的核心逻辑、挑战以及未来方向,特别是如何在算力、数据、模型大小和 推理成本 之间找到那个微妙的平衡点。下面,我就带大家深度解读一下这份干货,一探Gemini 背后的训练故事

关于大模型的预训,我们熟知的Scaling Laws(缩放定律)只是故事的一部分

ppt:

https://vladfeinberg.com/assets/2025-04-24-princeton-talk.pdf

一、告别“经验主义”:从Kaplan到Chinchilla的认知革命

还记得大模型训练的那个经典问题吗?给你一笔固定的算力C(比如1000块H100用30天),怎么训练出最强的LLM?模型参数N该多大?训练数据D该多少?

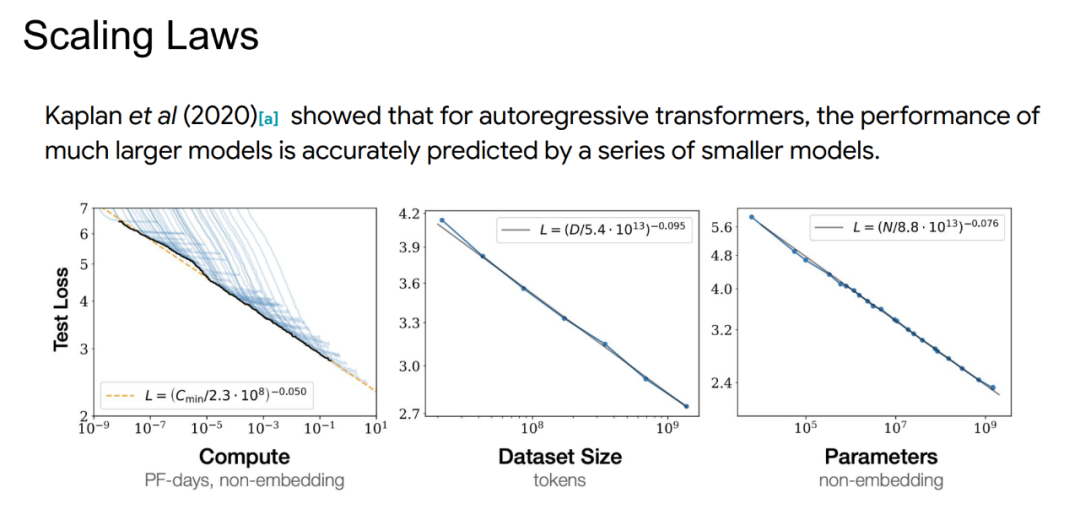

早期,大家主要参考Kaplan等人在2020年提出的Scaling Laws。他们的研究发现,模型性能与算力、参数量、数据量之间存在幂律关系,并且强烈建议优先扩大模型参数N。具体来说,算力提升10倍,参数N建议扩大5.37倍,而数据D只需扩大1.86倍。这直接点燃了军备竞赛,大家疯狂堆参数

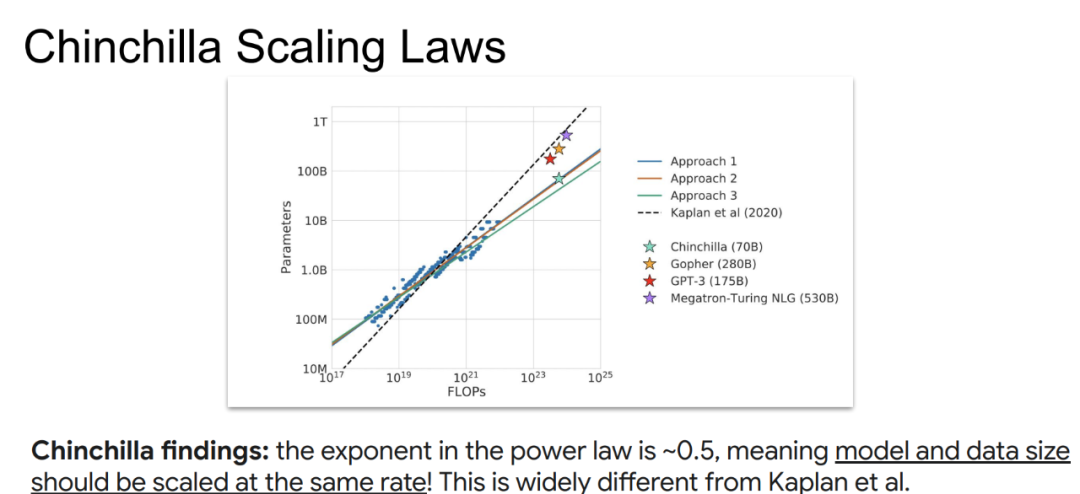

但是,Google DeepMind (GDM) 在2022年3月发布的Chinchilla(龙猫)论文,给这个“参数为王”的时代泼了一盆冷水

Chinchilla团队指出,Kaplan的研究方法(基于单次训练中的中间loss点来推断)存在缺陷,忽略了学习率衰减等优化带来的好处,只有最终的loss才最能反映模型真实水平

他们采用了更严谨的IsoFlops方法:

-

1. 固定总算力C -

2. 训练多个不同参数N的模型(对应不同的数据量D,因为C ≈ 6 * N * D) -

3. 找到这个算力下,loss最低的那个模型N_opt(C)和D_opt(C) -

4. 重复以上步骤,得到不同算力C下的最优(N, D)点 -

5. 拟合这些最优点的关系 -

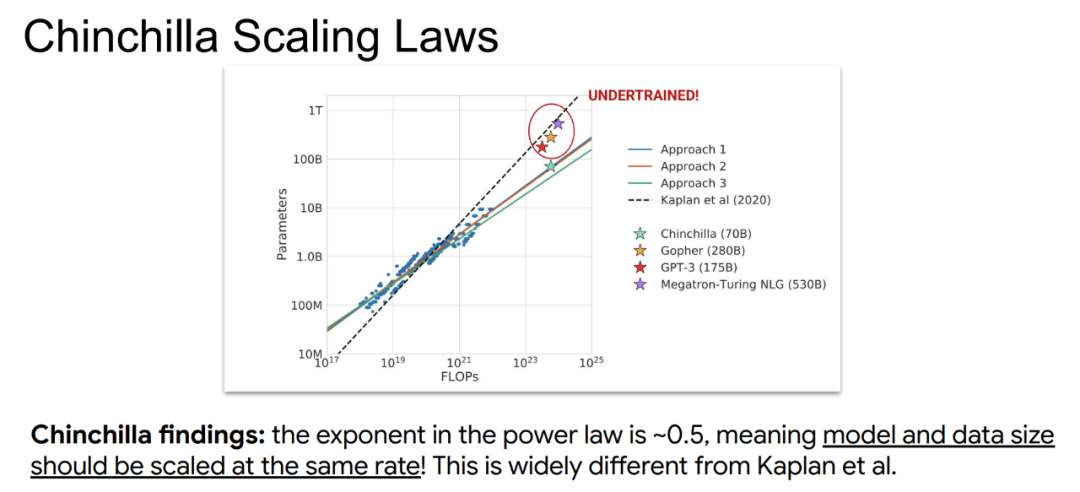

Chinchilla的惊人发现是: 模型参数N和数据量D应该以大致相同的速率(指数约为0.5)随算力C增长! 这意味着,按照Kaplan定律训练出来的很多大模型,其实是“训练不足(Undertrained)”的!模型太大,数据相对太少,潜力没发挥出来。更糟糕的是,这些“虚胖”的大模型,推理成本极高,部署和使用起来非常昂贵

二、推理成本,不能承受之重!

为什么Chinchilla强调的“训练不足”和推理成本如此重要?因为大模型最终是要用的!

看看Google内部的应用场景:

-

1. 高通量服务:像搜索AI Overviews、免费的Gemini App(聊天机器人)、企业级Vertex AI平台、AI Studio API等,用户量巨大 -

2. 实时交互:Project Astra、Project Mariner这类需要即时响应的多模态应用。

这些场景,尤其是实时交互,对模型的推理延迟有着极其苛刻的要求

Vlad Feinberg现场做了一个简单的“餐巾纸计算”(Napkin Math):假设一个需要实时交互的Web Agent,上下文128k,每次交互处理8k新token,生成128个token,要求延迟在1秒内,再去掉250毫秒的网络和处理开销… 用Llama3-70B这样的模型在谷歌的v5e芯片上跑,光是处理8k新token(Prefill)就需要近6秒(单芯),即使动用4×4=16块芯片并行,也才勉强压到0.5秒左右。而生成阶段(Decode)更是受到内存带宽的严重制约,每生成一个token可能就需要好几毫秒

结论: 对于低延迟场景,70B参数的模型可能都太大了! 我们需要更小、更快的模型,也就是像Gemini Flash/Flash-lite这样的“小钢炮”

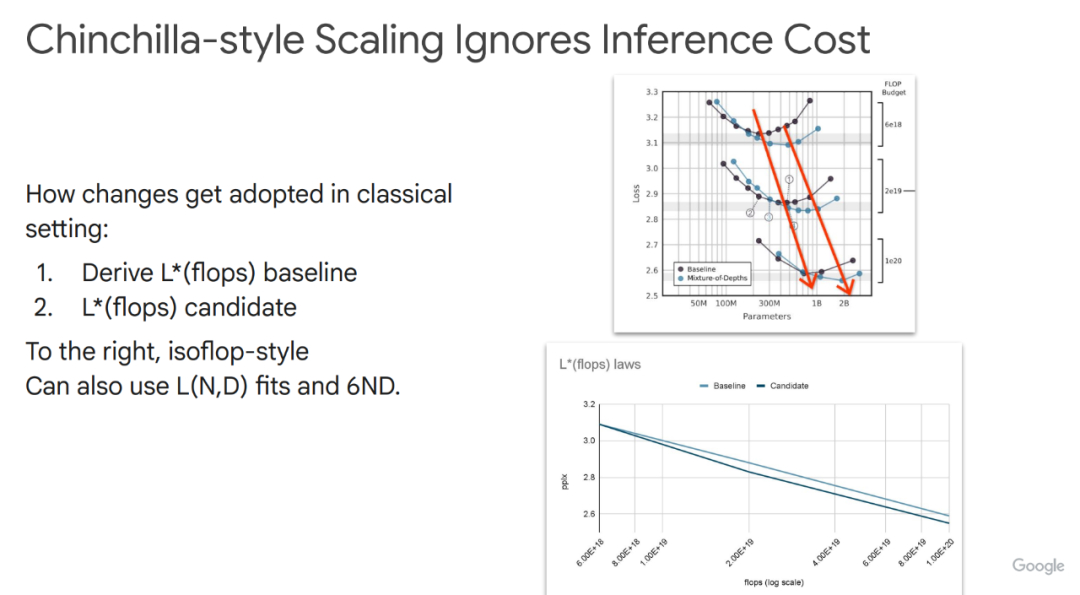

传统的Scaling Law研究,往往只关注训练loss,完全忽略了推理成本,这在实际应用中是行不通的

三、迈向新范式:推理感知(Inference-Aware)的Scaling Laws

既然推理成本如此重要,有没有更科学的方法来指导预训练呢?答案是肯定的。

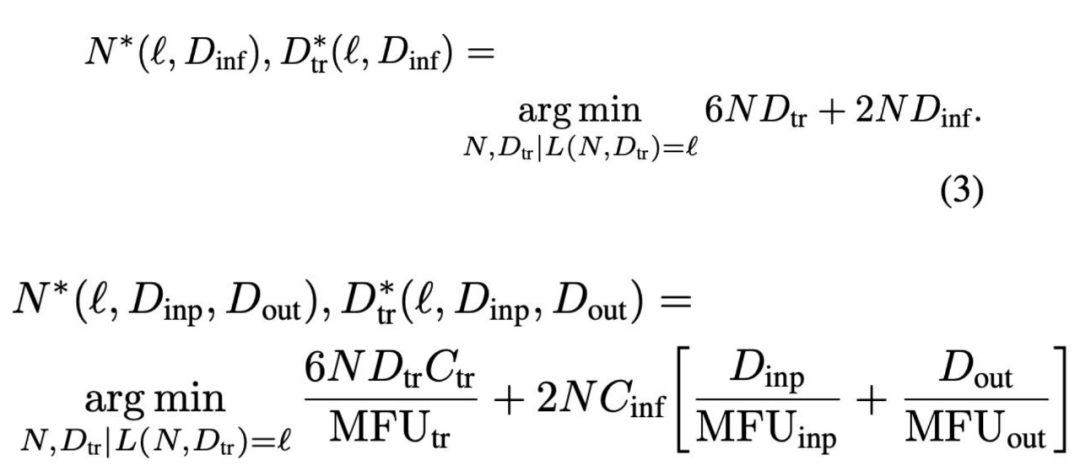

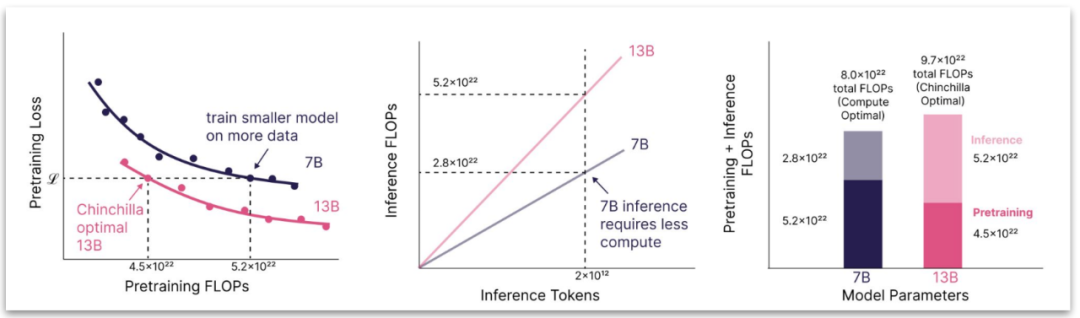

Sardana等人在2024年提出了“推理感知”的Scaling Laws。核心思想是:不再仅仅最小化训练loss,而是要优化“总成本”,这个总成本包括了训练成本和生命周期内的总推理成本

其数学形式更复杂,需要考虑训练和推理使用的硬件(MFU不同)、输入/输出token量(D_inp, D_out)等因素

但结论很明确:

考虑到推理成本后,最优的模型往往比Chinchilla定律建议的更小,但需要用更多的数据(或重复训练更久)!

当然,这种新范式也面临挑战:

-

1. 硬件非同质性:训练和推理芯片不同,成本难统一衡量 -

2. 推理量D_inf难以预测:模型变好会刺激更多使用(杰文斯悖论),市场会扩张 -

3. Scaling Law拟合本身不完美:尤其在数据量极大或极小的情况下,拟合误差可能很大

为了解决拟合问题,Muennighoff等人(2023)提出了考虑数据约束的Scaling Law,引入了唯一数据量U和重复次数R的概念 L(N, U, R)。研究发现,重复数据的收益会快速下降。这意味着,在数据有限的情况下,更小的模型对数据重复利用更有效

那如果数据“无限”呢?Llama3训练了15T token还在提升,似乎说明对于开源模型,只要算力允许,可以一直用所有数据训练下去。但这是否是最优策略?用数据受限定律可以反推,如果用更少、更精的数据,达到同样效果能节省多少算力?达到Llama3 8B模型的loss,可能只需原来72%的算力

四、新维度:蒸馏与其他

除了模型大小、数据量、推理成本,模型蒸馏(Distillation) 也成为了一个重要的研究方向。Busbridge等人(2025)正在研究蒸馏的Scaling Laws,试图量化教师模型和学生模型之间的成本与性能关系

如何用有限的算力训练出“小而精”的学生模型?教师模型的能力上限、学生模型的“容量差距”、蒸馏过程中的技巧(如温度控制)等,都是需要探索的问题。一个有趣的观点是,蒸馏本质上是一种方差缩减,好的教师模型能提供更稳定的学习信号,减少学生模型学习的“噪声”。

观点总结

总结一下Vlad Feinberg分享的核心观点:

Scaling研究两大方向:

-

1. 提升曲线:在给定的模型大小下,做到更好的性能 -

2. 增加斜率:让模型性能随规模增长得更快

Gemini的策略:类似“Tick-Tock”,用Flash版本追赶上一代Pro版本的性能,不断优化推理效率

推理效率是关键:压缩技术(更好的蒸馏、量化、服务友好型模型设计)与Scaling研究同等重要

低成本研究机遇:

硬件感知Kernel优化:为特定硬件写算子,比如下一代Flash Attention

量化新前沿:超越传统的向量量化

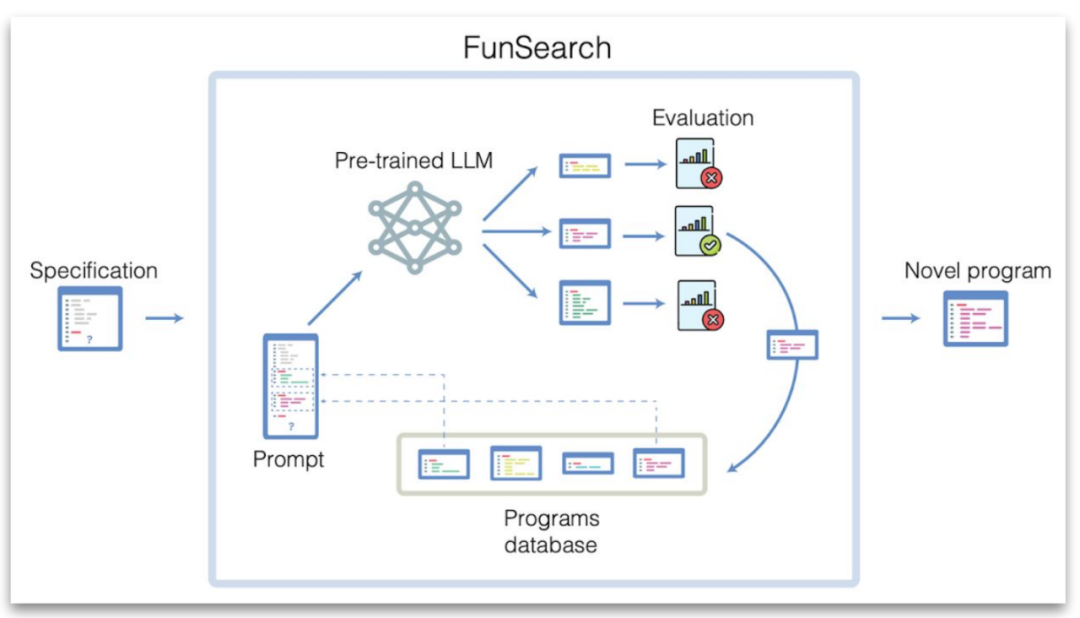

FunSearch类方法:用LLM辅助搜索更好的模型结构或训练策略

更鲁棒的Scaling Laws:引入更多维度(如数据质量、重复度),使用更严谨的统计模型(如MLE vs. 最小二乘),甚至用主动学习来选择最优的(N, D)实验点

写在最后:

如果你对这个话题感兴趣,可以去查阅PPT中提到的几篇关键论文(Kaplan 2020, Chinchilla 2022, Sardana 2024, Muennighoff 2023, Busbridge 2025等

ppt地址再次奉上:

https://vladfeinberg.com/assets/2025-04-24-princeton-talk.pdf

免责声明: 本文基于公开可获取的Google内部技术分享PPT进行解读,旨在传递技术信息,不代表Google官方立场。所有解读基于博主个人理解,如有偏差敬请指正

⭐

(文:AI寒武纪)