今夜无眠。

一直写稿到现在,因为,那个源神杀回来了。

今天凌晨5点,阿里发布了全新一代模型Qwen3(简称千问3)。

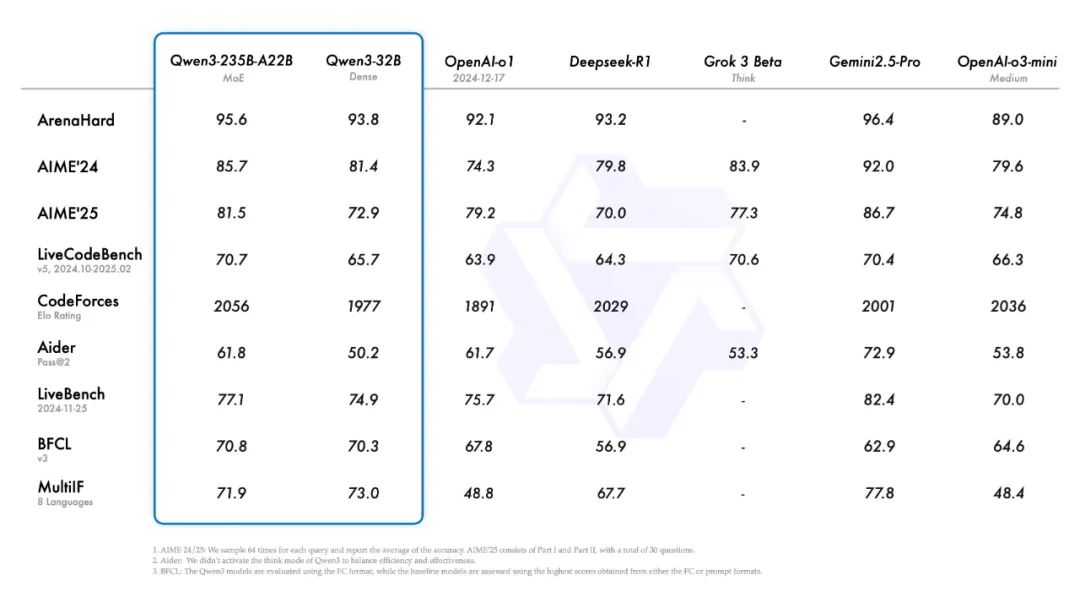

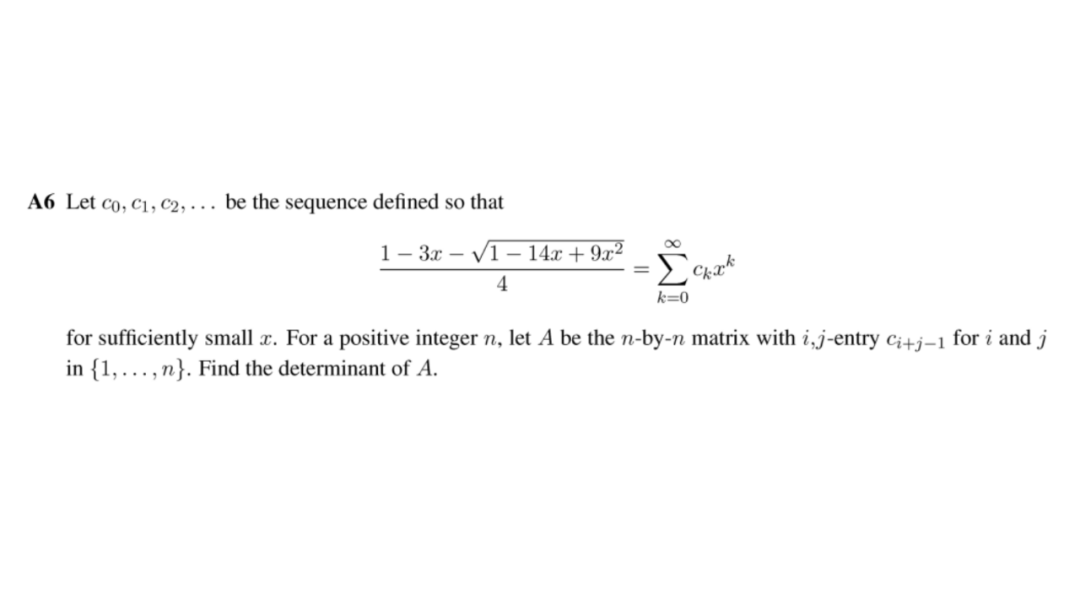

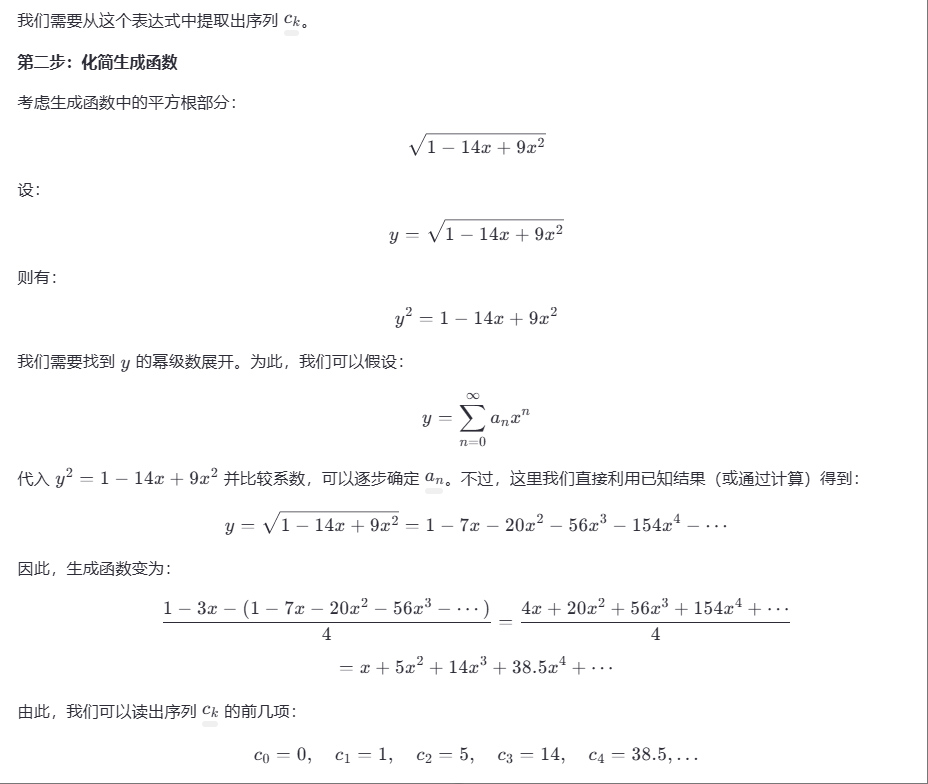

这是它的测评基准。

有多牛呢?与DeepSeek-R1、o1、o3-mini、Grok-3和Gemini-2.5-Pro等顶尖模型相比,旗舰模型Qwen3-235B-A22B在编码、数学和通用能力等基准测试中,取得了非常亮眼的成绩。

更牛的是,Qwen3的小尺寸模型也很能打。比如Qwen3-4B,性能竟然完全不输72B的Qwen2.5-72B-Instruct模型。

当然,更更更牛的是,千问3全系模型开源!包括旗舰模型Qwen3-235B-A22B在内的八款千问3家族模型,全部开源。

可以自信且大胆的说,这就是目前全球最强的开源模型,来自中国的阿里。

源神“八”仙过海

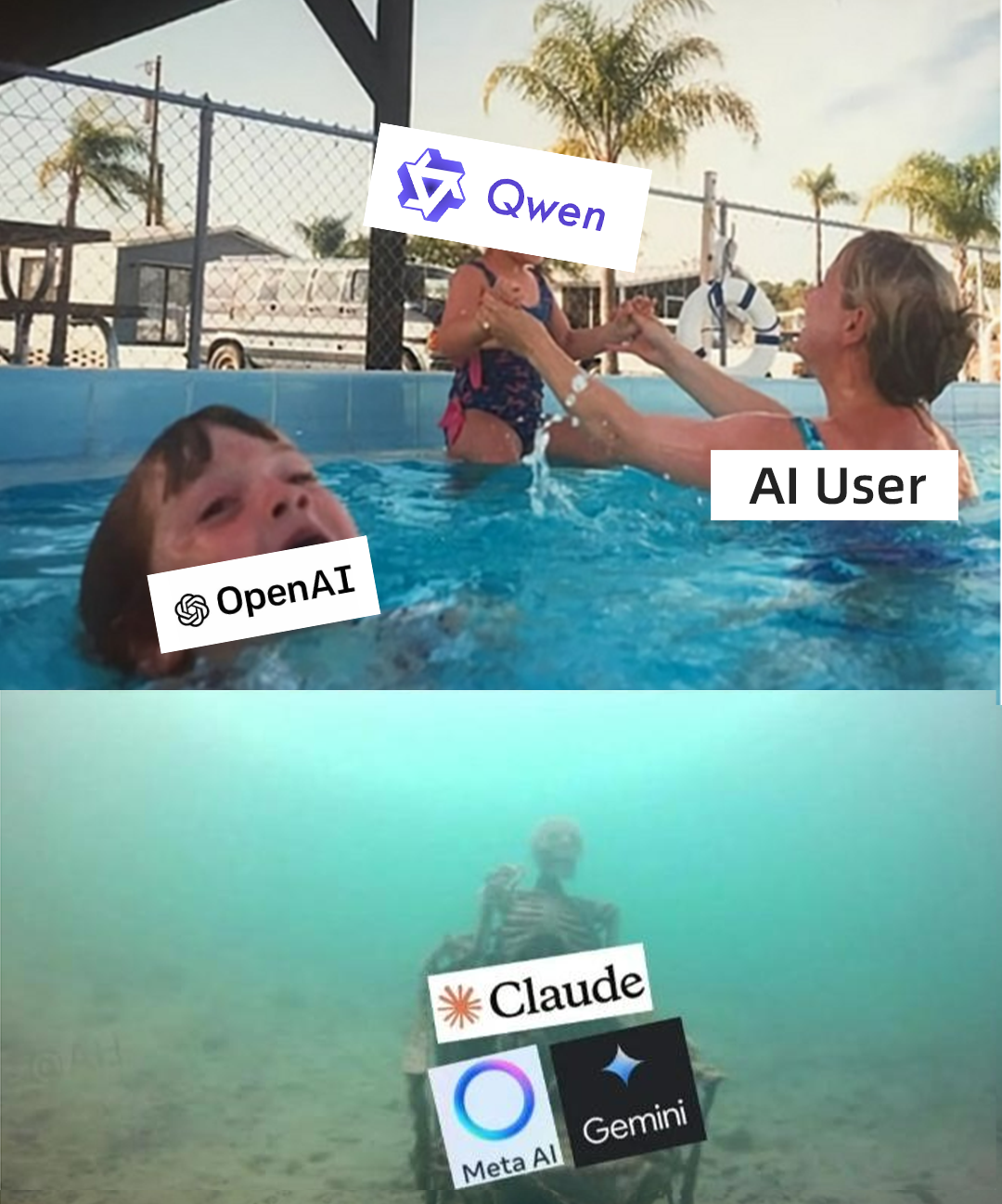

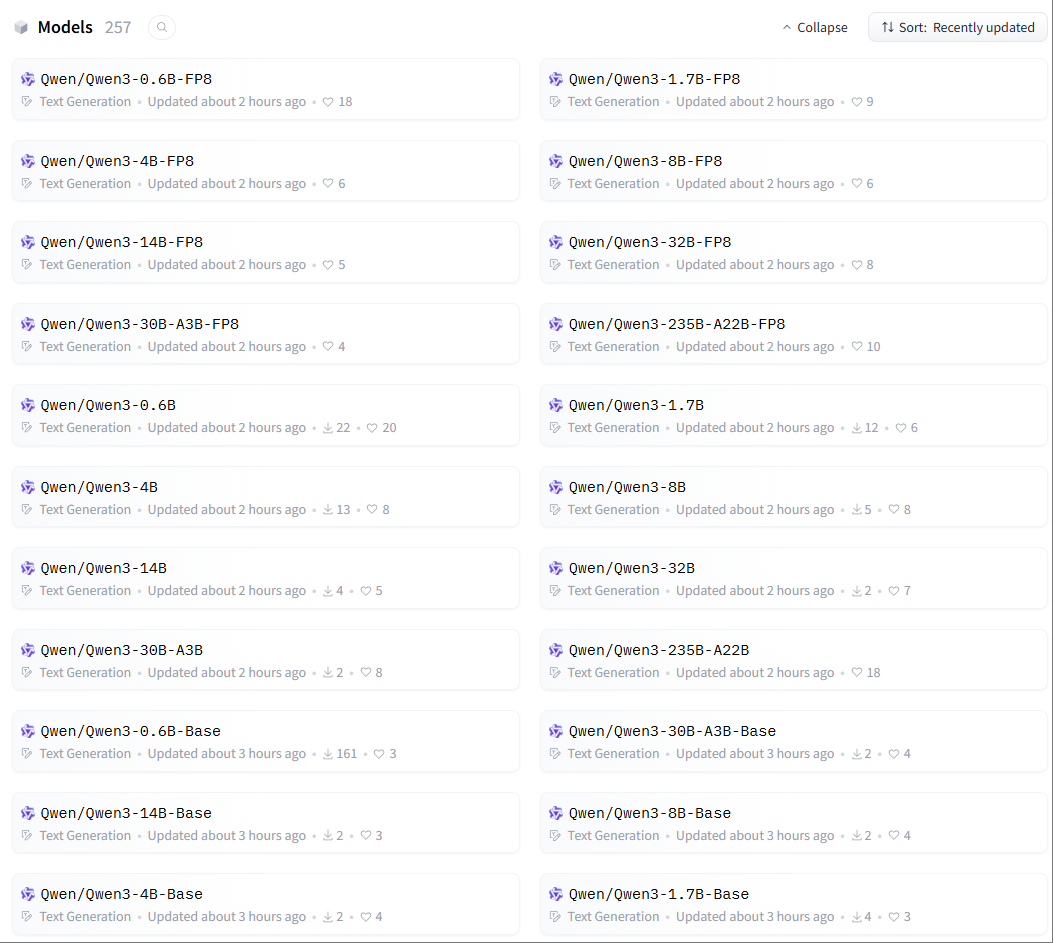

本次开源的千问3家族模型一共有8款:

-

6款Dense模型:0.6B、1.7B、4B、8B、14B、32B。

-

2款MoE模型:Qwen3-30B-A3B和旗舰版Qwen3-235B-A22B。

通常,简单问题用Dense模型,复杂问题用MoE模型。

关于各模型的参数和推荐配置,我简单整理了个表格。

自部署,优先推荐Qwen3-0.6B、Qwen3-14B及以上、Qwen3-30B-A3B和Qwen3-235B-A22B这几款模型。

-

Qwen3-0.6B,在手机端侧可跑。

-

Qwen3-30B-A3B,消费级显卡可跑,激活参数仅3B,整体性能堪比Qwen2.5-32B,实现了10倍性能的提升。

-

Qwen3-235B-A22B,Qwen3的旗舰模型,总参数235B(激活参数22B),只需4张H20即可部署。

以上8款开源模型,均采用宽松的Apache2.0协议(可自由修改、商用),支持119种语言。所有公司无论规模大小,所有AI开发者、科研机构不惧显卡门槛,大家都能够用得上、也用得起千问3模型。

Hugging Face:

https://huggingface.co/spaces/Qwen/Qwen3-Demo

ModelScope:

https://www.modelscope.cn/collections/Qwen3-9743180bdc6b48

GitHub:

https://github.com/QwenLM/Qwen3

如果嫌本地部署麻烦,也可以直接在他们的Qwen Chat官网体验。

网址是这个:https://chat.qwen.ai

进去后,左上角选择“Qwen3”系列模型,即可体验。

当然,也支持API调用,大家可在阿里云百炼调用API服务(正在上线中)。

上周六,某高端局会议提到,“人工智能可以是造福人类的国际公共产品。要广泛开展人工智能国际合作,帮助全球南方国家加强技术能力建设,为弥合全球智能鸿沟作出中国贡献。”

这款千问3模型,就是最好的代表。

千问3的“特异”功能

新一代千问3模型,有些不一样的地方。

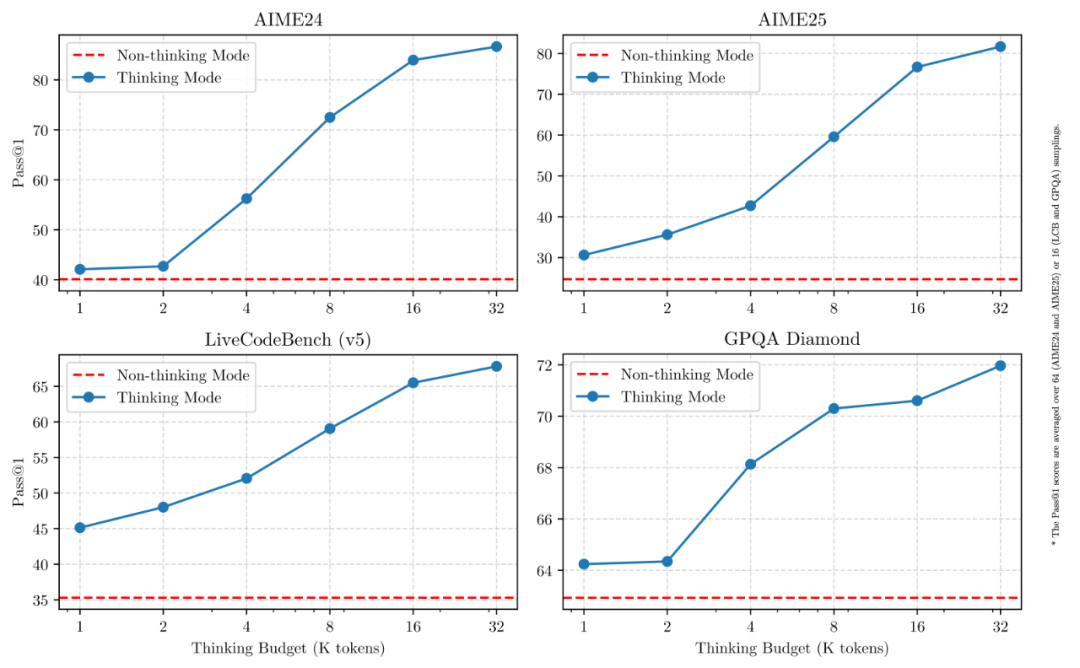

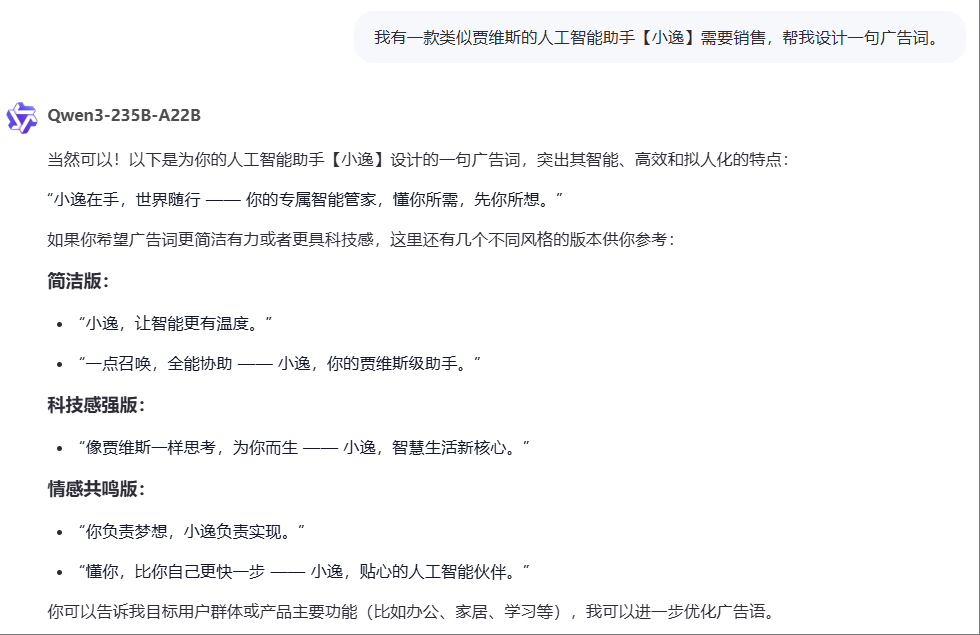

1)国内首款“混合推理模型”

千问3既非单模态的语言模型,也非专注CoT的推理模型,而是“混合推理模型”,原生支持推理模式与非推理模式两种工作模式。

在使用中,用户可通过enable_thinking=Ture硬开关机制方式,控制模型开启推理模式;同时也支持软开关机制,允许用户在enable_thinking=True时通过/think和/no_think指令来开启推理模式。

说人话就是,用户既可以通过功能键选择是否需要推理,也可以用大白话来命令模型是否进行推理。在简单任务场景中,关闭推理模式,可以实现更快响应和更低推理成本;在复杂任务场景中,启用逐步推理,可以带来更精准、严谨的结果。

from transformers import AutoModelForCausalLM, AutoTokenizerclass QwenChatbot:def __init__(self, model_name="Qwen/Qwen3-30B-A3B"):self.tokenizer = AutoTokenizer.from_pretrained(model_name)self.model = AutoModelForCausalLM.from_pretrained(model_name)self.history = []def generate_response(self, user_input):messages = self.history + [{"role": "user", "content": user_input}]text = self.tokenizer.apply_chat_template(messages,tokenize=False,add_generation_prompt=True)inputs = self.tokenizer(text, return_tensors="pt")response_ids = self.model.generate(**inputs, max_new_tokens=32768)[0][len(inputs.input_ids[0]):].tolist()response = self.tokenizer.decode(response_ids, skip_special_tokens=True)# Update historyself.history.append({"role": "user", "content": user_input})self.history.append({"role": "assistant", "content": response})return response# Example Usageif __name__ == "__main__":chatbot = QwenChatbot()# First input (without /think or /no_think tags, thinking mode is enabled by default)user_input_1 = "How many r's in strawberries?"print(f"User: {user_input_1}")response_1 = chatbot.generate_response(user_input_1)print(f"Bot: {response_1}")print("----------------------")# Second input with /no_thinkuser_input_2 = "Then, how many r's in blueberries? /no_think"print(f"User: {user_input_2}")response_2 = chatbot.generate_response(user_input_2)print(f"Bot: {response_2}")print("----------------------")# Third input with /thinkuser_input_3 = "Really? /think"print(f"User: {user_input_3}")response_3 = chatbot.generate_response(user_input_3)print(f"Bot: {response_3}")

这是继Claude 3.7 Sonnet、Gemini 2.5家族后全球唯三的混合推理模型,也是国内首款“混合推理模型”。

2)Agent的“好搭子”

千问3模型原生支持MCP协议,具备强大的工具调用(function calling)能力。

最近,大家都在说“大模型从对话走向执行”,Manus、Genspark、AutoGLM、飞猪AI问一问、扣子空间等通用智能体雏形不断涌现。但实际体验起来,你会发现,这些Agent还差点意思。

差的这个东西,其实就是底座模型。

千问3,全面适配AI Agent生态。其架构不再局限于“问答能力”,而是面向Agent架构优化的执行效率、响应结构与工具泛化能力。支持手机及电脑Agent操作等代理任务。

搭建Agent,强烈推荐用千问3来作底座模型。

附Agent示例。

from qwen_agent.agents import Assistant# Define LLMllm_cfg = {'model': 'Qwen3-30B-A3B',# Use the endpoint provided by Alibaba Model Studio:# 'model_type': 'qwen_dashscope',# 'api_key': os.getenv('DASHSCOPE_API_KEY'),# Use a custom endpoint compatible with OpenAI API:'model_server': 'http://localhost:8000/v1', # api_base'api_key': 'EMPTY',# Other parameters:# 'generate_cfg': {# # Add: When the response content is `<think>this is the thought</think>this is the answer;# # Do not add: When the response has been separated by reasoning_content and content.# 'thought_in_content': True,# },}# Define Toolstools = [{'mcpServers': { # You can specify the MCP configuration file'time': {'command': 'uvx','args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']},"fetch": {"command": "uvx","args": ["mcp-server-fetch"]}}},'code_interpreter', # Built-in tools]# Define Agentbot = Assistant(llm=llm_cfg, function_list=tools)# Streaming generationmessages = [{'role': 'user', 'content': 'https://qwenlm.github.io/blog/ Introduce the latest developments of Qwen'}]for responses in bot.run(messages=messages):passprint(responses)

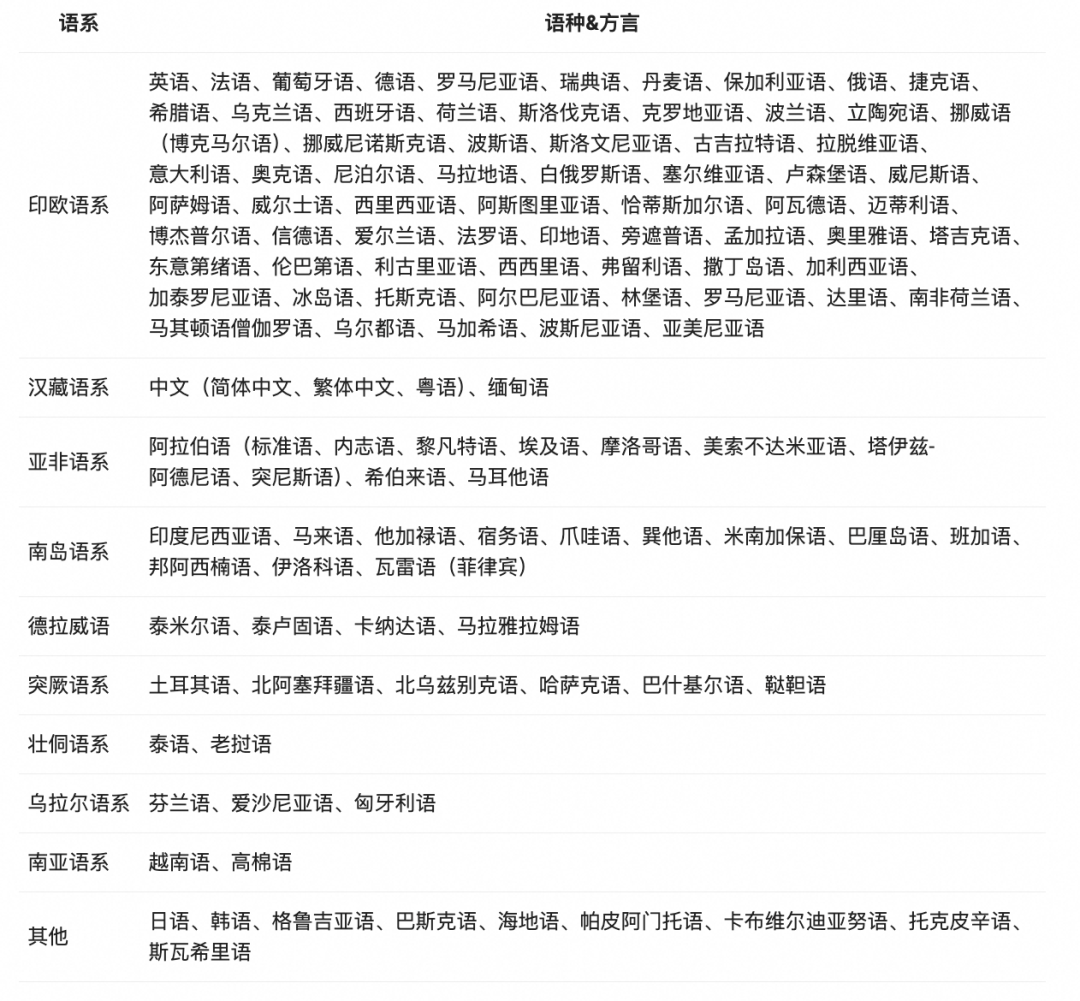

3)亚非拉的“好兄弟”

千问3模型的语言支持,多达119种。

不仅囊括了中、英、法、西、俄、阿拉伯等主要的联合国语言,还包含德、意、日、韩、泰、越南、尼泊尔、瑞典、波兰、匈牙利等各国官方语言,甚至连中国的粤语、非洲的斯瓦西里语、中东的意第绪语、西亚的亚美尼亚语、东南亚的爪哇语、美洲的海地语等地方性语言都支持。

上周六某高端局会议为什么要强调“帮助全球南方国家”?因为这些国家大多集中在亚洲、非洲、拉丁美洲和大洋洲,他们的总人口占了全球的70%,但经济却只有40%。

很多南方国家,根本没有能力开发自己语种的大模型。现在有了开源的千问3,这道题就很好解了——你只要有电脑、能上网,就能够部署自己的模型。

从技术平权这个角度来说,阿里是真的NB。

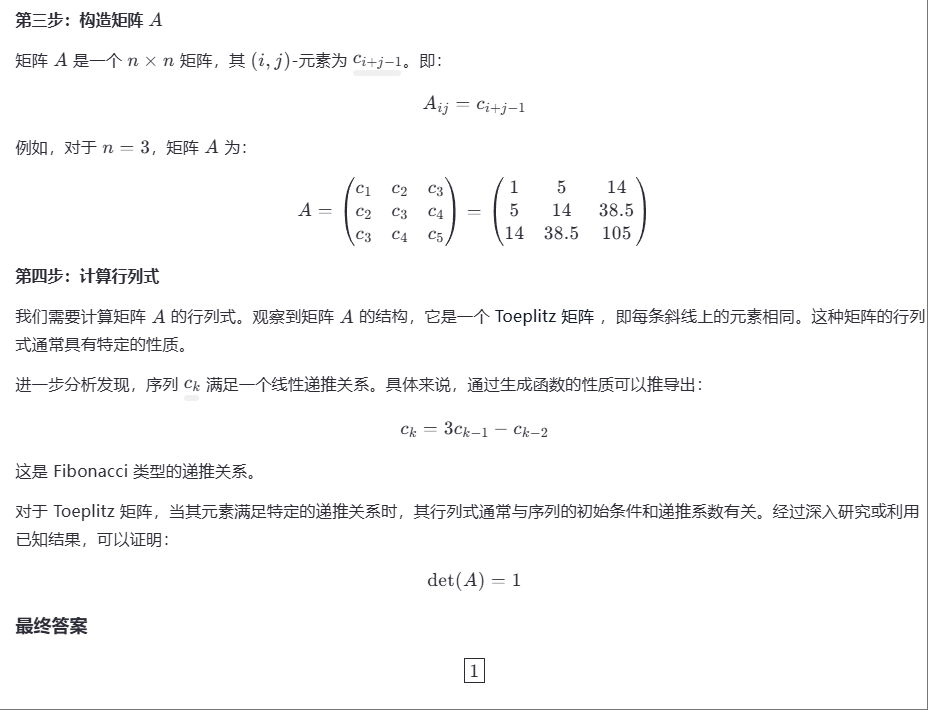

Qwen3一手实测

现在,所有人都可以在Qwen Chat中体验最新版千问3模型。

体验地址:https://chat.qwen.ai

我们来测几个Case,看看模型的表现。

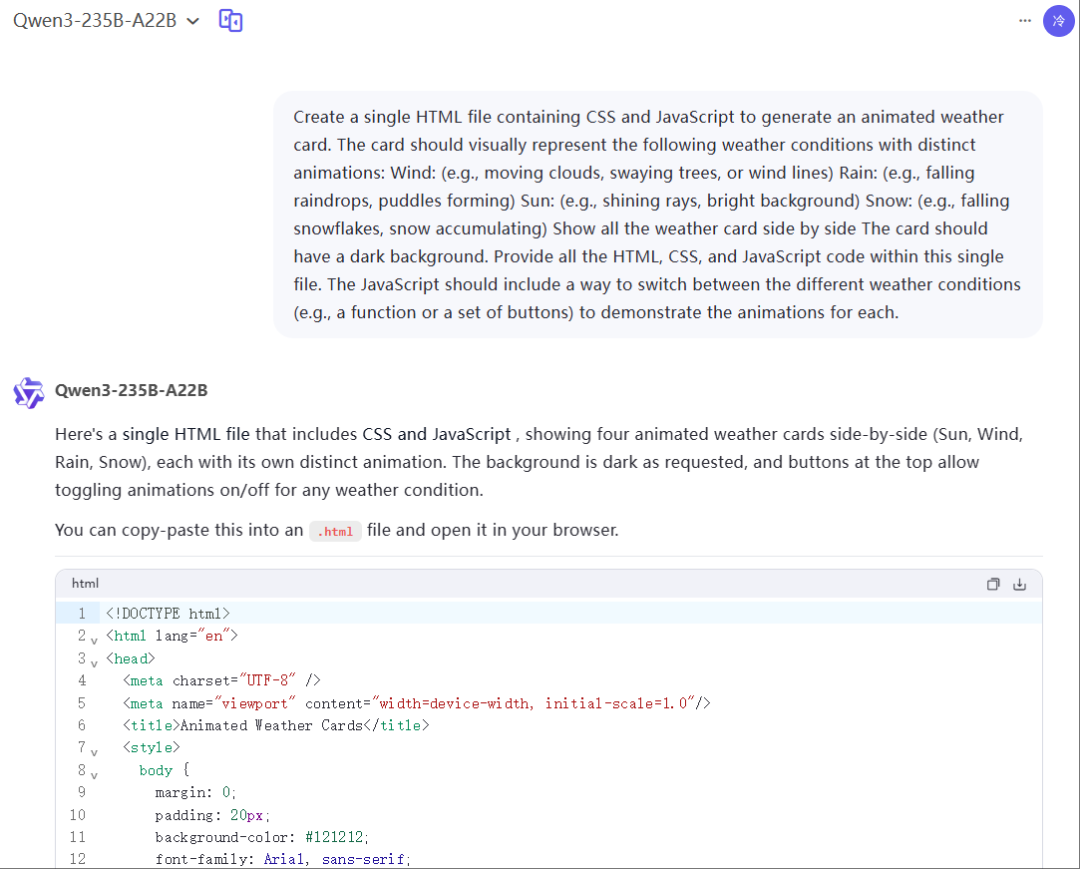

先是网页设计能力,用的X上@AGI_FromWalmart 的Prompt。

再来看一个case,Prompt来自X网友@_akhaliq。

这效果太棒了,非常惊艳。最关键的是,模型的生成速度真的很快。这2个case,基本都在1分钟内完成任务。

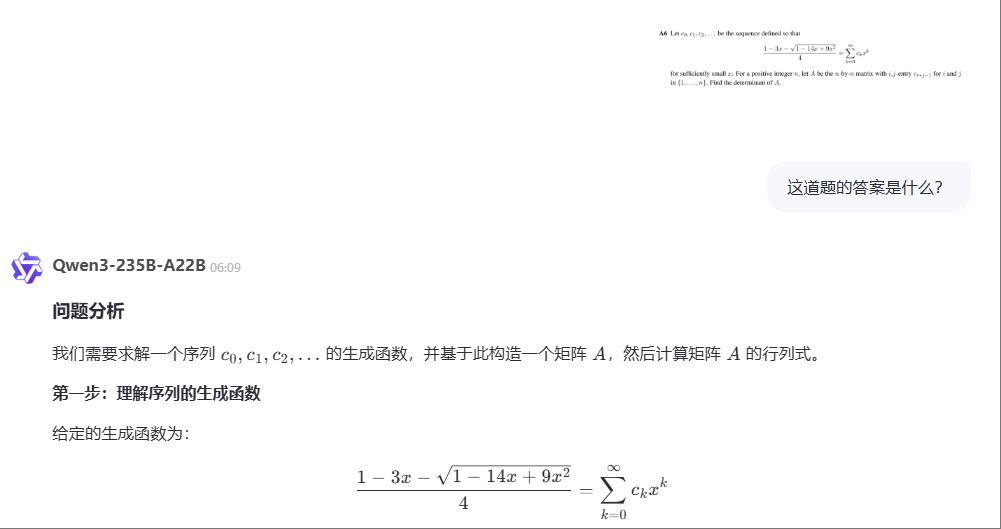

接着,我们来看下数学能力。用了一道来自Putnam竞赛前500名人类选手都未能攻克的难题。

Qwen3先进行了解题,准确理解题目。我传给它的是一张图片,看来Qwen3多模态能力不错,而且也能理解La Tex数学公式。

有没有数学大佬,能不能帮忙看看,这道题Qwen3到底有没有答对。

测了代码、数学,我们再来看下文学创作吧。

还行,过得去。

最后,考验一下模型的工具调用能力(Qwen3独有的功能)。

不错啊,居然调用了这么多工具来回答我的问题。

写在最后

我们一直都说,人工智能是模拟、延伸和拓展人的智能。

但如果一个模型技术出来,总要我们人为去区分这模型、那模型,其实这样的模型并不智能,也一定不是人工智能的最终版本。

今年新出的混合推理模型,它结合了单一语言模型和推理模型的优势,能够自如切换两种模式。快速回答,模仿人类直觉反应;CoT逐步推理,模仿人类慢思考。

在混合推理模型下,无论简单问题还是复杂问题,模型都能够应对自如,实现速度与深度的平衡。理论说起来简单,但要真正实现起来非常困难,这会对模型的训练策略、数据设计和损失函数调度提出更高的要求。

在全球唯三的混合推理模型中,阿里Qwen3做到了。不仅做到,还大方开源。

只能说,源神NB,阿里NB。

之前,我们写过一篇文章(详细介绍),2024年中美顶级AI大模型性能差距接近抹平,阿里AI贡献全球第三。当时,阿里凭借6款重要模型入选。

今天,阿里发布的Qwen3一定也会入选2025年的年度AI大模型。这一夜,你我都是见证者。

两周前,我在另一家国产开源模型的文章里写到:“真正的技术进步不是闭源垄断,而是开放共享。”

今天,我想给这句话打上补丁——开源是技术实力的试金石,只有领先者才敢开源。

千问3,敢做,敢当。

(文:沃垠AI)