在人工智能领域,推理能力一直是衡量大模型智能水平的重要指标。2025年7月,原石科技推出的MetaStone-S1模型以其独特的”反思型”架构在业内引起广泛关注。

一、项目概述

MetaStone-S1是原石科技推出的反思型生成式大模型,首次将深度推理与推理链自筛选机制融合,采用基于共享主干结构的策略模型和过程评分模型(SPRM),支持Long-CoT强化学习生成超长推理链,在数学(AIME)、代码(LiveCodeBench)和中文推理(C-EVAL)任务中表现优异,提供1.5B、7B、32B三种开源版本,以低推理成本实现高性能推理,推动AI进入”自我修正”新阶段。

二、技术原理

(一)双头共享架构设计

MetaStone-S1的核心创新在于其独特的双头共享架构:

1.并行部署机制:在Transformer层上同时部署生成头(Generation Head)和评分头(Scoring Head),前者负责生成推理链,后者基于自监督学习对每个推理步骤实时评分。

2.参数效率优化:通过共享主干网络的设计,策略模型(Policy Model)与过程评分模型(SPRM)仅增加53M参数就实现了复杂推理能力的显著提升。

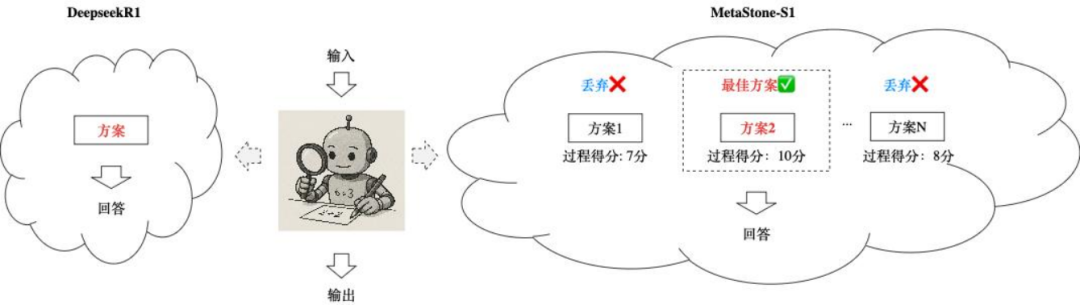

3.动态推理择优:采用Test-Time Scaling技术,在High模式下可生成32条候选推理链,通过SPRM计算路径总分后选择最优路径继续生成,形成”生成-评估-择优”的闭环流程。

(二)自监督学习机制

1.SPR Loss算法:提出自监督过程奖励损失函数(Self-supervised Process Reward Loss),利用最终答案正确性作为弱监督信号,结合噪声过滤机制自动生成步骤级伪标签,摆脱对人工标注的依赖。

2.联合优化策略:基于GRPO强化学习算法同步优化策略模型和SPRM,策略模型最大化答案正确率,SPRM通过对比学习区分优质与低质推理步骤,二者共享梯度实现协同进化。

3.计算量调控:设计思考长度与模型性能的Scaling Law,通过调整rollout次数控制计算量(参数量×思考token数),实现从快速响应(Low)到深度思考(High)的平滑过渡。

三、主要功能

(一)核心推理能力

1.深度推理生成:支持生成超长且复杂的推理链条(Long-CoT),特别适用于解决数学证明、编程算法等高难度推理任务。

2.智能错误修正:内置自监督过程评分机制(SPRM),可自动识别并剔除推理过程中的错误步骤,显著提高最终答案的准确性。

(二)实用功能特性

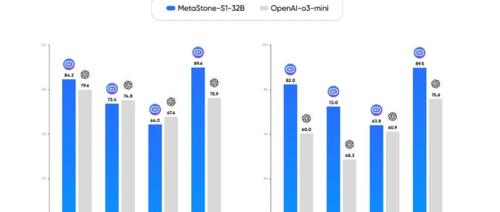

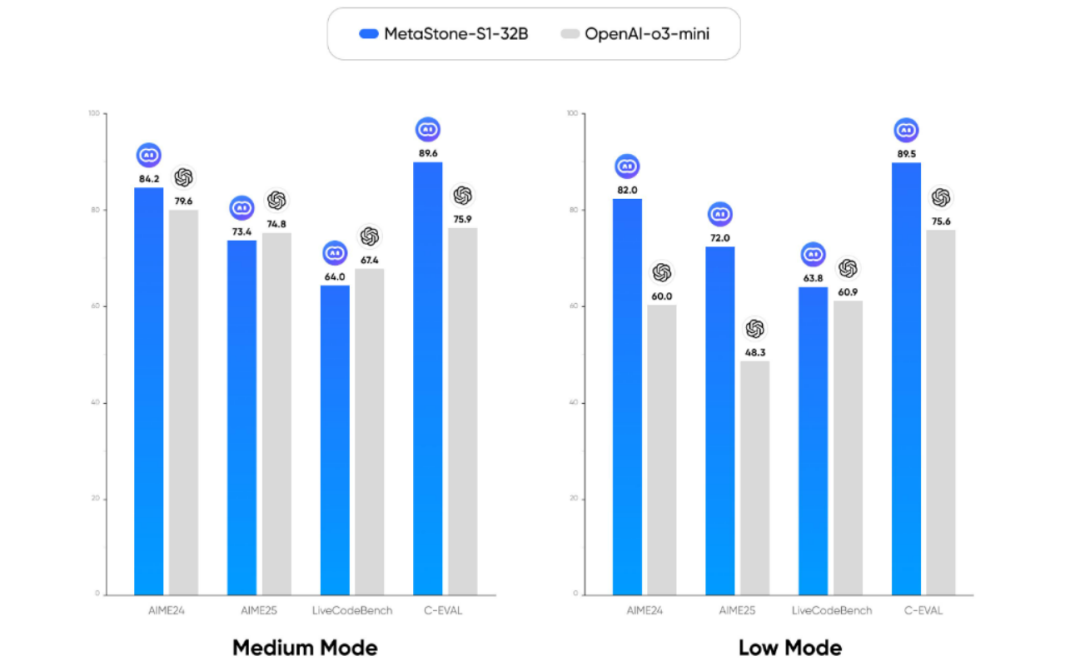

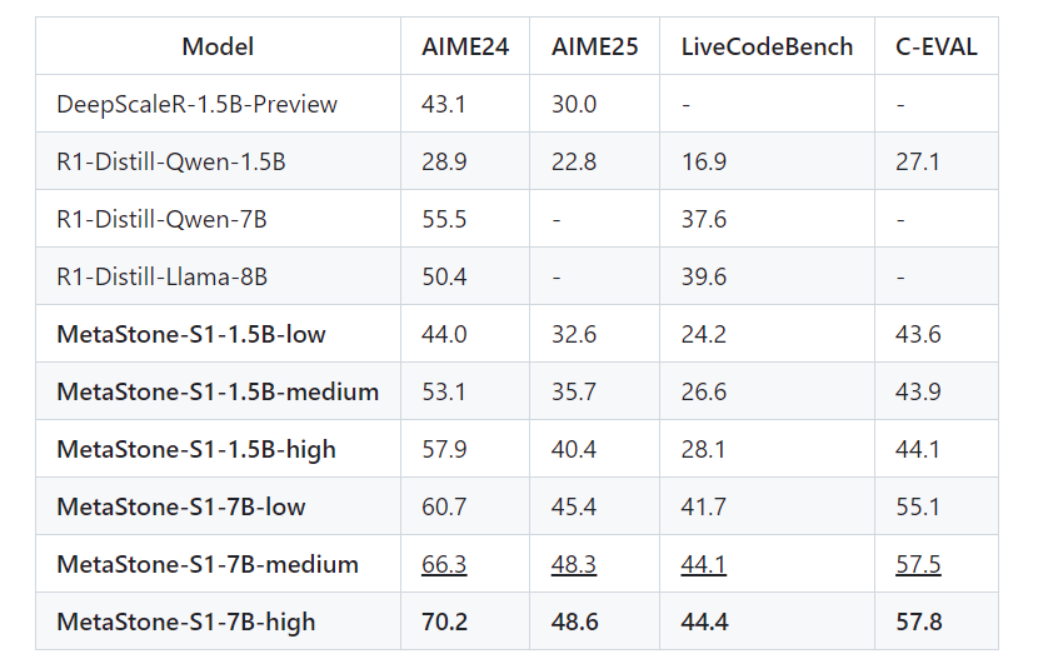

1.多档位推理模式:

– Low模式:快速响应,适合实时性要求高的场景

– Medium模式:平衡精度与速度,适用于大多数日常任务

– High模式:深度思考,生成32条候选推理链并择优,用于高难度问题

2.开源可扩展性:全面开源1.5B/7B/32B三种规模模型及配套工具,支持开发者在特定领域进一步优化模型的推理能力。

3.高效推理成本:基于团队自研高效推理技术,7B版本每百万token推理成本可低至0.2元,支持手机本地部署。

四、应用场景

(一)教育智能化

作为”AI导师”精准解答数学/物理竞赛题,生成可交互的解题路径说明。在AIME数学竞赛测试中表现优异,能够逐步解析复杂数学问题。

(二)法律智能领域

深度分析合同条款的逻辑关系,精准识别潜在法律风险点,提供符合法律逻辑的修订建议。其长文本推理能力特别适合法律文件分析。

(三)智能制造

基于多级因果推理,快速定位工业设备故障根源,生成最优维修方案。其推理链优化能力可显著提升故障诊断效率。

(四)学术研究

支持科研论文的公式推导和理论验证,确保学术内容的逻辑严谨性。特别适合数学、物理等需要复杂推理的学科。

五、性能表现

MetaStone-S1在数学推理(AIME 62.3%准确率)、代码生成(LiveCodeBench通过率提升27%)和中文推理(C-EVAL 82.5分)三大基准测试中显著超越同规模模型,其中7B版本在数学多步推理任务上较传统方法提升130%。

六、快速使用

(一)环境准备

1.硬件要求:

– 1.5B模型:8GB显存GPU

– 7B模型:16GB显存GPU

– 32B模型:多GPU或云服务器部署

2.软件依赖:

pip install transformers>=4.40.0pip install torch>=2.3.0

(二)模型加载

通过Hugging Face快速加载7B模型:

from transformers import AutoModelForCausalLM, AutoTokenizermodel_name = "MetaStoneTec/MetaStone-S1-7B"tokenizer = AutoTokenizer.from_pretrained(model_name)model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto")

(三)推理模式设置

# 设置推理模式(Low/Medium/High)input_text = "[MODE=High] 问题:证明勾股定理"inputs = tokenizer(input_text, return_tensors="pt").to("cuda")outputs = model.generate(**inputs, max_length=512)print(tokenizer.decode(outputs[0]))

结语

MetaStone-S1代表了生成式AI在推理能力上的重要突破,其创新的反思型架构和自监督学习机制为复杂问题求解提供了新思路。通过开源1.5B/7B/32B三种规模的模型,原石科技不仅降低了高性能推理的门槛,也为AI社区贡献了可扩展的技术框架。随着技术的不断演进,这种”生成-评估-择优”的闭环推理模式有望在更多专业领域发挥价值,推动AI从单纯的内容生成向真正的逻辑思考迈进。

相关资料

GitHub仓库:https://github.com/MetaStone-AI/MetaStone-S1

HuggingFace模型库:https://huggingface.co/MetaStoneTec

技术论文:https://arxiv.org/pdf/2507.00195

(文:小兵的AI视界)