专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

目前,评估大模型的方法就是比在基准测试中的数值,在于突出SOTA结果,并未充分考虑统计显著性。例如,在对不同模型进行评估时,若仅依据表面的得分高低判断优劣,而不考虑数据的不确定性和变异性,可能会得出不准确的结论。

所以,Anthropic提出了将严谨的统计思维引入大模型评估领域。通过构建全面的分析框架,能帮助研究人员量化评估结果的精确性,判断模型之间的差异是否具有统计显著性,而非仅仅依赖于表面的得分差异,进而为模型的选择和改进提供更可靠的依据。

我们需要理解评估框架中的一个基本概念——超总体。在统计学中,总体是指研究对象的全体,而超总体则是一个更为宏观的概念,它包含了所有可能的问题。

在大模型评估的背景下,这意味着不仅仅关注评估中出现的具体问题,而是将这些问题视为从一个更大的、无限的、未观察到的问题集合中随机抽取的样本。这种思维方式允许我们从更宏观的角度来分析评估数据,从而更准确地估计模型的性能。

在评估框架的理论基础中,每个问题得分被分解为均值部分和零均值随机部分。如果一个评估由n个独立抽取的问题组成,我们可以将第i个问题的得分表示为si,将其分解为均值部分xi和一个零均值随机部分ϵi,即si=xi+ϵi。这里的xi被称为条件均值,它代表了在给定问题i被选中的情况下的得分均值。

而ϵi的方差,记作σ²i=Var(ϵi),被称为条件方差,它是在问题i被选中的情况下得分的方差。

在这个框架下,可以使用中心极限定理来估计均值的标准误差。中心极限定理是一个强大的统计学工具,它指出,无论原始数据的分布如何,只要样本量足够大,样本均值的分布将趋近于正态分布。

因此,即使评估得分的分布未知,也可以利用中心极限定理来估计均值的标准误差,可以估计为SEC.L.T.=√[Var(s)/n]=√[(1/n)Σ(i=1ton-1)(si-¯s)²]/n,其中¯s是观察到的得分的平均值。

但评估中的问题并不总是独立的。例如,在阅读理解评估中,多个相关问题可能基于同一文本段落。这种情况下,问题的抽取是非独立的,中心极限定理的一个关键假设被违反,因此直接应用上述公式将导致不一致的标准误差。

为了解决这个问题,研究人员引入了聚类标准误差的概念。聚类标准误差是一种在社会科学中发展出来的技术,用于处理问题聚类中的依赖和相关结构。

在评估框架的理论基础中,还有一个重要的概念是方差的降低。方差是衡量得分分布离散程度的统计量,降低方差可以提高估计的精度。方差可以分解为两个部分:从超总体中选择问题的方差和所选问题的得分的均值条件方差。这种分解是加性的,遵循全方差定律。

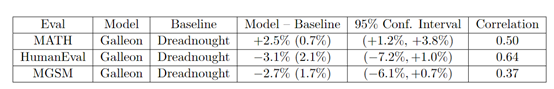

为了展示这种统计学评估方法,研究人员设计了一个假设性的实验,比较了两个虚构模型“Galleon”和“Dreadnought”在三个非虚构评估上的表现:MATH(数学推理评估)、HumanEval(Python编程评估)和MGSM(多语言小学数学评估)。

在MATH评估中,Galleon的平均得分为65.5%,标准误差为0.7%;Dreadnought的平均得分为63.0%,标准误差为0.7%。

通过计算95%的置信区间,我们可以得出Galleon的真实得分在64.1%到66.9%之间,而Dreadnought的真实得分在62.3%到63.7%之间。这表明Galleon在MATH评估上的表现显著优于Dreadnought。

在HumanEval评估中,Dreadnought的平均得分为87.7%,标准误差为2.1%;Galleon的平均得分为83.6%,标准误差为2.1%。通过计算95%的置信区间,我们可以得出Dreadnought的真实得分在83.6%到91.8%之间,而Galleon的真实得分在79.5%到87.7%之间。这表明Dreadnought在HumanEval评估上的表现显著优于Galleon。

在MGSM评估中,Dreadnought的平均得分为78.0%,标准误差为1.7%;Galleon的平均得分为75.3%,标准误差为1.7%。通过计算95%的置信区间,我们可以得出Dreadnought的真实得分在74.6%到81.4%之间,而Galleon的真实得分在71.9%到78.7%之间。这表明Dreadnought在MGSM评估上的表现也优于Galleon。

通过这些案例分析,我们可以看到,计算标准误差和置信区间不仅能够提供更丰富的信息,还能帮助研究者更准确地评估模型在不同任务上的表现。

(文:AIGC开放社区)