线性注意力机制的Scaling Law。

作者|赵健

今天,国产大模型市场掀起巨浪。

MiniMax今天发布并开源了新模型MiniMax-01,并断言:“传统Transformer架构不再是唯一选择。”

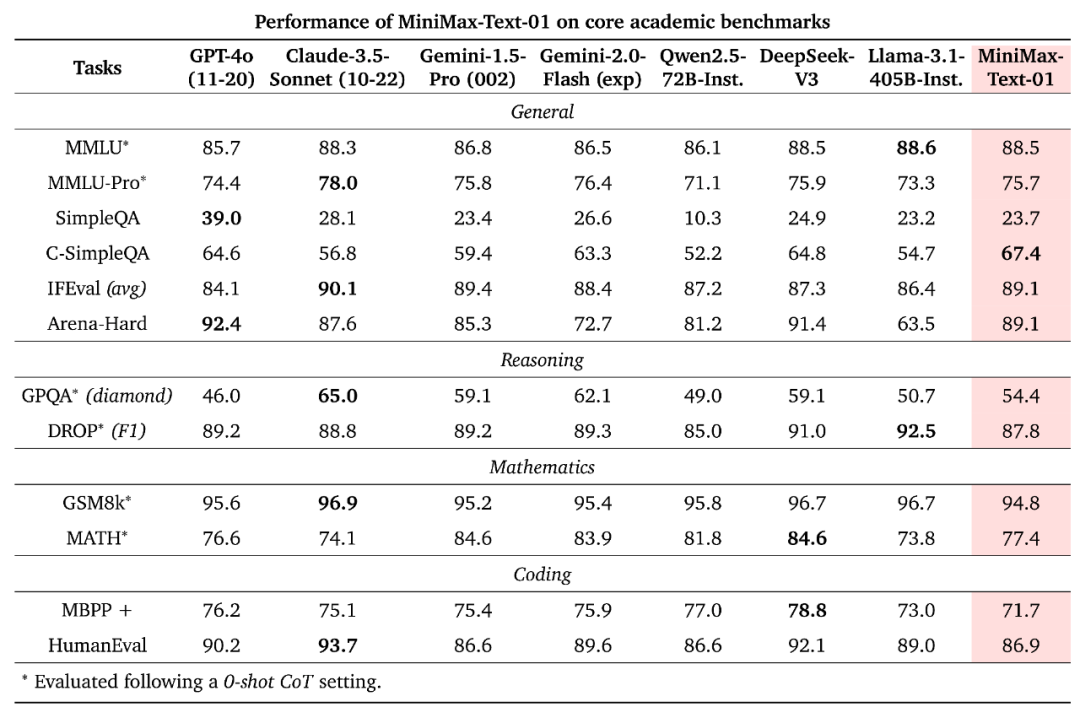

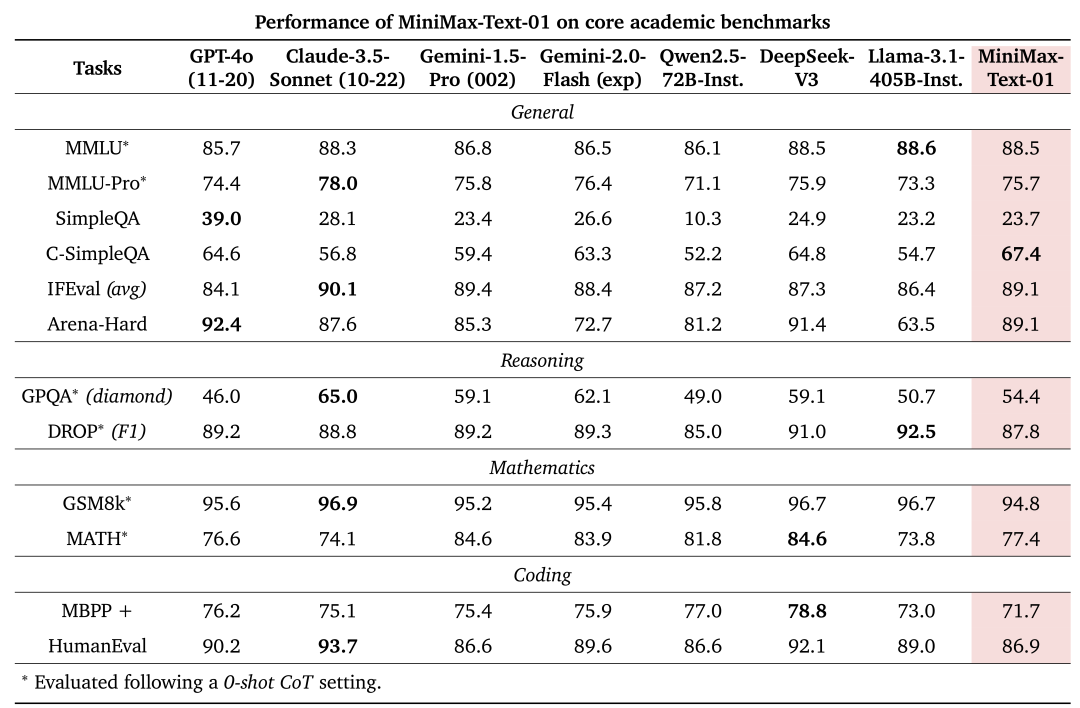

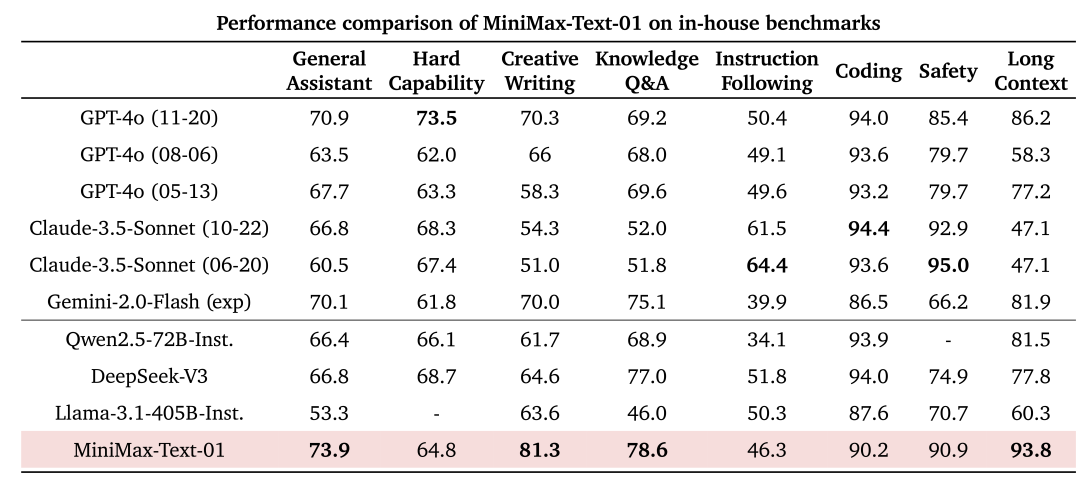

MiniMax-01包含两个模型:基础大语言模型MiniMax-Text-01和视觉多模态大模型MiniMax-VL-01。在大部分的学术集上,MiniMax-01都取得了比肩海外第一梯队的成绩,基本超越Qwen2.5-72B与Llama 3.1-405B,与DeepSeek V3相比互有胜负。

这不仅是MiniMax首次将模型开源,也是MiniMax首次公开其技术细节。在此之前,MiniMax一直以闭源模型的身份示人,外界对其底层模型细节知之甚少。

MiniMax发布了MiniMax-01的技术报告。技术报告中透露了MiniMax基础大模型的大胆创新:一是线性注意力机制(Linear Attention)的大规模训练,二是400万Token的超长上下文。

之所以说“大胆创新”,是因为研究一个新的架构风险极大,有去无回。

MiniMax创始人、CEO闫俊杰曾表示,MiniMax在2023年夏天开始研发MoE混合专家架构,投入了80%的算力与研发资源,经历了两次失败才成功。2024年4月,MiniMax开始钻研Linear Attention,并将其与MoE架构融合,成功研发出新一代的基于MoE+Linear Attention的模型,并达到了可以比肩GPT-4o的水平。

将如此核心的技术开源,MiniMax给出的原因是:“一是因为我们认为这有可能启发更多长上下文的研究和应用,从而更快促进Agent时代的到来,二是开源也能促使我们努力做更多创新,更高质量地开展后续的模型研发工作。”

「甲子光年」认真阅读了MiniMax的技术报告,将其核心信息梳理如下。

1.MiniMax想要解决什么问题?

大模型在业内的核心趋势之一,就是越来越长的上下文。目前大多数模型的上下文窗口长度在32K到256K token之间。但这仍然无法满足实际需求,比如使用专业书籍作为上下文协助整个编程项目,或者通过多示例学习最大化上下文学习的潜力。

过去两年中,上下文窗口的扩展主要得益于更强大的GPU和更好的I/O感知softmax注意力实现。然而,进一步扩展这些窗口已经证明是具有挑战性的。传统Transformer架构的核心在于注意力机制,传统注意力机制的计算复杂度是二次的,即随着序列长度的增加,计算量呈平方增长,这在处理长序列时会导致计算效率低下。换句活说,即使有无限的硬件资源可供使用,企业也无法承受计算量暴涨带来的成本压力。

为了解决这一挑战,研究人员提出了各种方法来降低注意力机制的计算复杂度:稀疏注意力、线性注意力、长卷积、状态空间模型和线性RNN。尽管这些创新在理论上具有潜力,但它们在商业规模模型中的采用有限。

MiniMax就是从这一业务难题切入,目标是构建一个在性能上与领先商业模型相匹配的模型,同时提供一个长一个数量级的上下文窗口。

MiniMax选择了线性注意力机制。线性注意力机制是一种改进的注意力机制,旨在解决传统基于softmax的注意力机制在处理长序列时的计算复杂度问题。线性注意力机制通过将计算复杂度降低到线性,使得模型能够更高效地处理长序列数据。

线性注意力机制并非MiniMax首次提出,但是此前线性注意力机制主要是学术研究以及小规模试验,MiniMax首次实现了将线性注意力机制模型的大规模训练。

线性注意力机制并非完美。MiniMax在技术报告中提到,线性注意力机制在高效并行计算中存在限制,这可能解释了为什么尽管这一理论存在了九年之久,但领先的开源大模型包括Llama-3.1、Qwen-2.5、DeepSeek-V3以及Mistral都没有采用线性注意力机制。

MiniMax就是要解决线性注意力机制在大规模训练后如何高效计算的问题。

MiniMax创始人、CEO闫俊杰去年曾表示:“在做Linear Attention的过程中,我们非常惊喜地发现,其实GPT-4o也是这么做的。”

2.架构、数据与计算

MiniMax雄心勃勃的目标需要仔细平衡多个因素:网络架构、数据和计算。

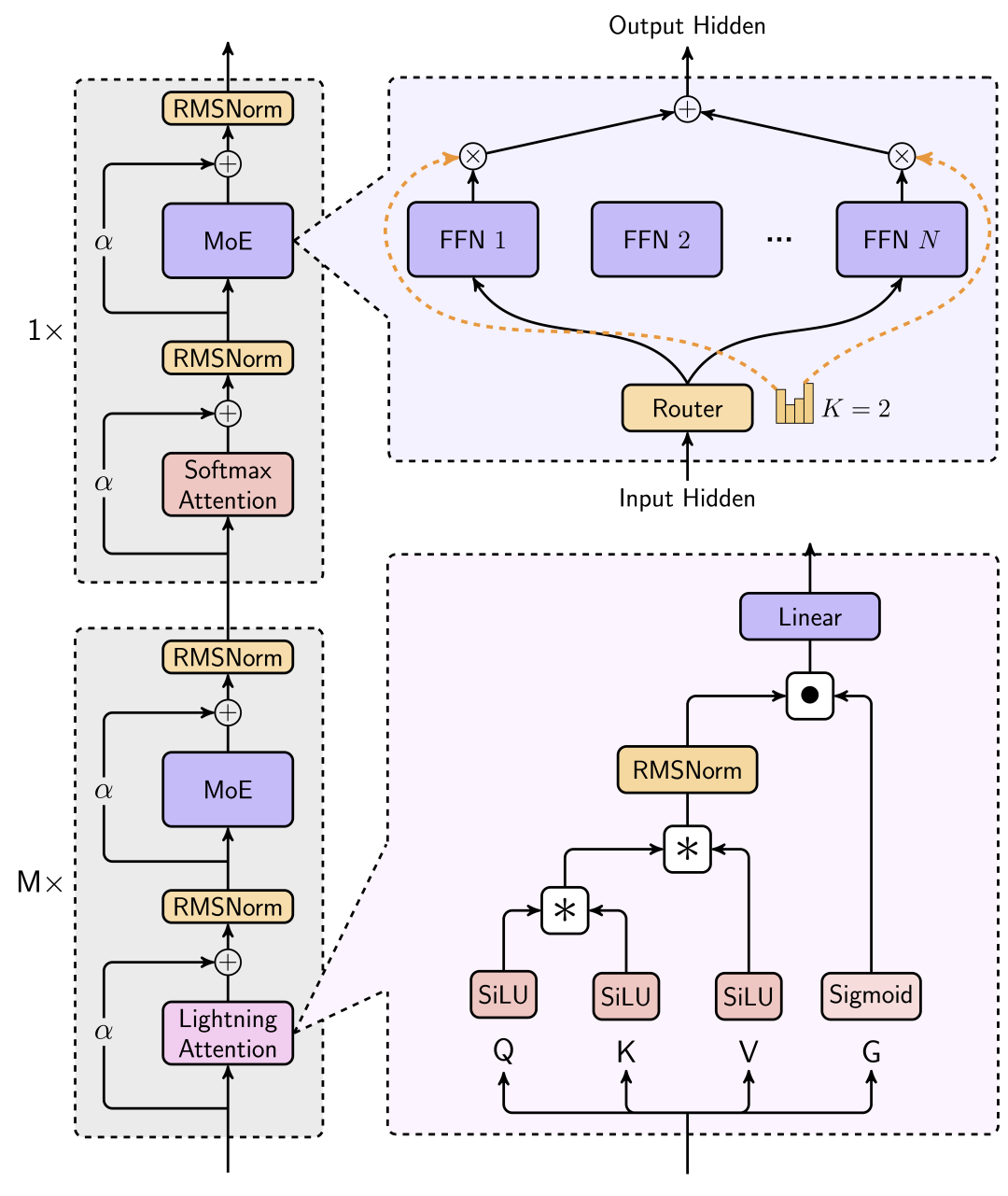

首先看网络架构设计。为了在有限资源内实现最佳性能并更好地处理更长序列,MiniMax采用了MoE方法,并尽可能多地使用线性注意力而不是标准Transformer中使用的softmax注意力。

MoE基础的大型语言模型的训练可以分为token-drop和dropless两种。MiniMax采用token-drop策略来提高训练效率。通过这种方法,每个专家被分配一个容量限制,指定它最多可以处理的token数量。一旦达到这个容量,任何额外路由到该专家的token将被丢弃。

对于注意力机制,经过广泛的实验,MiniMax最终选择了一种混合架构,主要使用闪电注意力(Lightning Attention),这是一种线性注意力变体的I/O感知实现,由MiniMax团队在2024年提出。在混合架构中,每七个使用闪电注意力的transnormer块后,跟随一个使用softmax注意力的transformer块。

基于对扩展法则实验、下游性能和速度比较的分析,MiniMax得出的结论是,虽然纯线性注意力模型在计算上是高效的,但它们不适合LLMs。这是因为纯线性注意力机制在检索方面存在固有的不足,而这是LLMs中上下文学习所必需的。相比之下,MiniMax的混合模型不仅匹配而且超越了softmax注意力在检索和外推任务中的能力。

在最终确定模型模块的架构后,下一步是进行模型的规模扩展。MiniMax根据实际约束确定模型的总参数:能够在单机上使用多达8个GPU和640GB内存,通过8位量化处理超过100万个token。

在综合考虑训练资源、推理资源和最终模型性能,并在三者之间找到平衡,MiniMax在广泛的实验后确定了最终模型规格:4560亿参数,459亿激活,32个专家。

接下来就是计算的优化,包括训练与推理。MiniMax透露了其训练集群的规模:一个动态变化的GPU集群,其中H800 GPU的数量在1500到2500之间波动。

现有的分布式训练和推理框架主要针对softmax注意力进行优化。然而,MiniMax的新架构集成了闪电注意力、softmax注意力和MoE,需要对训练和推理框架进行彻底的重新设计。此外,框架必须具备支持训练和推理数百亿参数模型和数百万token上下文窗口的能力。

MiniMax表示自己独立且全面地重新发明了分布式训练和推理框架,提出了针对MoE架构的优化策略,包括减少通信开销、优化数据分布和管理推理时的批量输入。这些优化策略使得模型能够在大规模GPU集群上高效运行,在英伟达H20上端到端超过75%的模型浮点运算利用率(MFU),同时保持了模型性能和推理效率。

基于架构设计和计算优化,MiniMax训练了最新版模型MiniMax-01。

3.训练策略,以及User-in-the-loop

MiniMax-01具体是如何训练出来的?MiniMax在报告中也给出详细的过程。

预训练过程从精心策划和高质量语料库的构建开始,通过严格的清理、基于奖励的质量增强和更好的数据混合平衡进行验证。为了充分利用架构的长上下文能力,MiniMax引入了超参数的深入分析,并提出了一个三阶段训练程序,成功将上下文窗口扩展到一百万个token。

后训练过程包括监督式微调(Supervised Fine-Tuning,简称SFT)、离线和在线强化学习(Reinforcement Learning,简称RL)。通过这些阶段,MiniMax系统地使模型与定义的目标对齐。

在对齐阶段,MiniMax通过精确调整奖励维度和多阶段训练方法,激励模型的各种能力,特别是在长上下文和实际场景方面。随后,通过整合一个轻量级的视觉变换器(ViT)模块,增强了语言模型的视觉能力,从而创建了视觉语言模型MiniMax-VL-01。MiniMax-VL-01通过额外的5120亿视觉语言token进行训练,采用四阶段训练过程。该训练过程的最后阶段专门设计用于优化用户体验。

在核心学术基准测试中,这两个模型在文本和视觉语言任务中均达到了与封闭源代码顶级模型相当的性能水平。

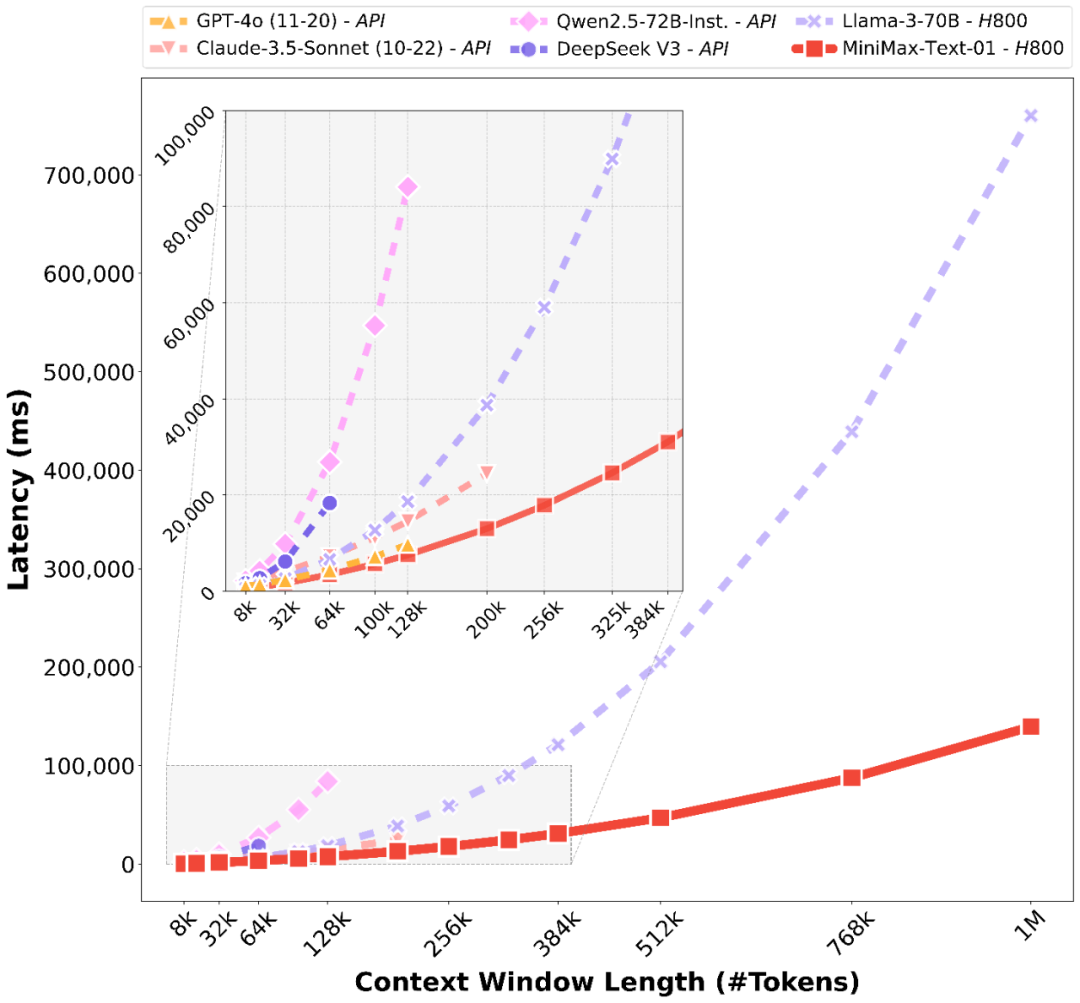

受益于架构创新,MiniMax的模型在处理长输入的时候有非常高的效率,接近线性复杂度。和其他全球顶尖模型的对比如下:

当然,今天的测试集跑分数据很大程度上不能完全反映模型的真实能力。除了常见的刷榜之外,还有一个原因是学术评估缺乏对真实世界用户交互的理解。

为此,MiniMax在技术报告中提出了在2023年就提过的“User-in-the-loop(用户反馈数据驱动)”的模式。MiniMax专注于旗下C端AI智能助手工具海螺AI,通过基于真实案例的用户参与循环评估来监控和提升用户体验,并适应工具以更好地在实际应用中实现可用性和性能。

MiniMax的研究表明,在学术基准测试和实际用户体验之间存在显著差异,领先的开源和商业模型在用作交互助手时可能表现不佳。于是,MiniMax使用源自实际使用场景——主要来自海螺AI——的内部基准测试评估模型的性能,并显示其模型在这些场景中处于顶级水平。

4.大模型的“六边形战士”

总结来说,MiniMax-01系列的两个模型——MiniMax-Text-01和MiniMax-VL-01,在处理长上下文方面展现了顶级性能,同时提供了处理更长上下文的优越能力。

背后的核心创新在于闪电注意力及其高效的扩展能力。为了最大化计算能力,MiniMax将其与专家混合(MoE)集成,创建了一个拥有32个专家和4560亿总参数的模型,其中每个token激活459亿参数。

MiniMax为MoE和闪电注意力开发了优化的并行策略和高效的计算-通信重叠技术。这种方法使其能够在跨越数百万token的上下文中,对拥有数千亿参数的模型进行高效的训练和推理。MiniMax-Text-01的训练上下文窗口可以达到100万个token,并且在推理期间以可承受的成本外推到400万个token。视觉-语言模型MiniMax-VL-01通过继续训练512亿视觉-语言token构建而成。

MiniMax表示,其模型与GPT-4o和Claude-3.5-Sonnet等最先进模型的性能相匹配,同时提供了20-32倍更长的上下文窗口。

当然,MiniMax也提出了现有模型的局限性。

一是长上下文评估:当前长上下文检索任务的评估数据集主要为人工或简化场景设计,实际应用中如文档分析的长文本推理能力的评估仍然有限。MiniMax计划在更现实的设置中增强长上下文检索,并在更广泛的任务中扩展长上下文推理的评估。

二是模型架构:模型目前仍保留了1/8的组件使用传统的softmax注意力。MiniMax表示正在研究更高效的架构,可以完全消除softmax注意力,可能实现无计算开销的无限上下文窗口。

三是复杂编程任务:模型在高级编程任务上的性能需要改进,因为我们预训练阶段的编码数据集仍然有限。MiniMax正在不断改进训练数据选择和继续训练程序,以解决下一版本模型中的这些局限性。

可以说,MiniMax通过全面的基础大模型布局——包括语言模型与视频模型,以及海内外AI产品的布局——海螺AI、星野+Talkie,已经成为大模型领域的“六边形战士”。

不过,在OpenAI发布推理模型o1与o3之后,大模型的技术范式从预训练扩展到了推理阶段。国内不少大模型已经跟进,包括Kimi、DeepSeek、Qwen,以及科大讯飞今天刚刚发布的讯飞星火。MiniMax目前尚未发布相关模型。

此外,李开复近期公开表态放弃追求AGI。对于同为“六小虎”的MiniMax,不知又会做出什么选择呢?

(封面图来自MiniMax)

(文:甲子光年)