极市导读

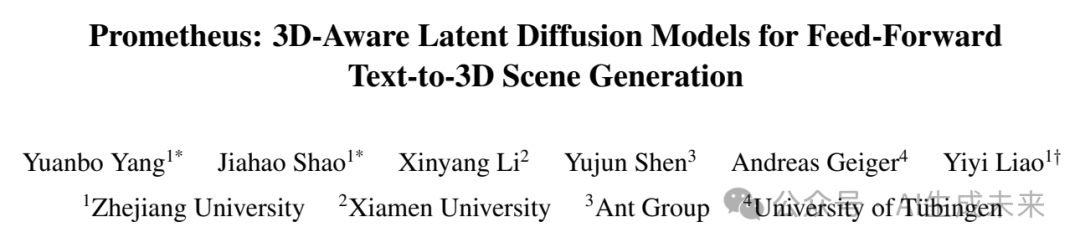

浙大和蚂蚁集团提出的Prometheus模型,这是一种面向文本到3D生成的3D感知隐空间扩散模型,能够在几秒钟内生成逼真的3D场景。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

论文链接:https://arxiv.org/pdf/2412.21117

git链接:https://freemty.github.io/project-prometheus/

亮点直击

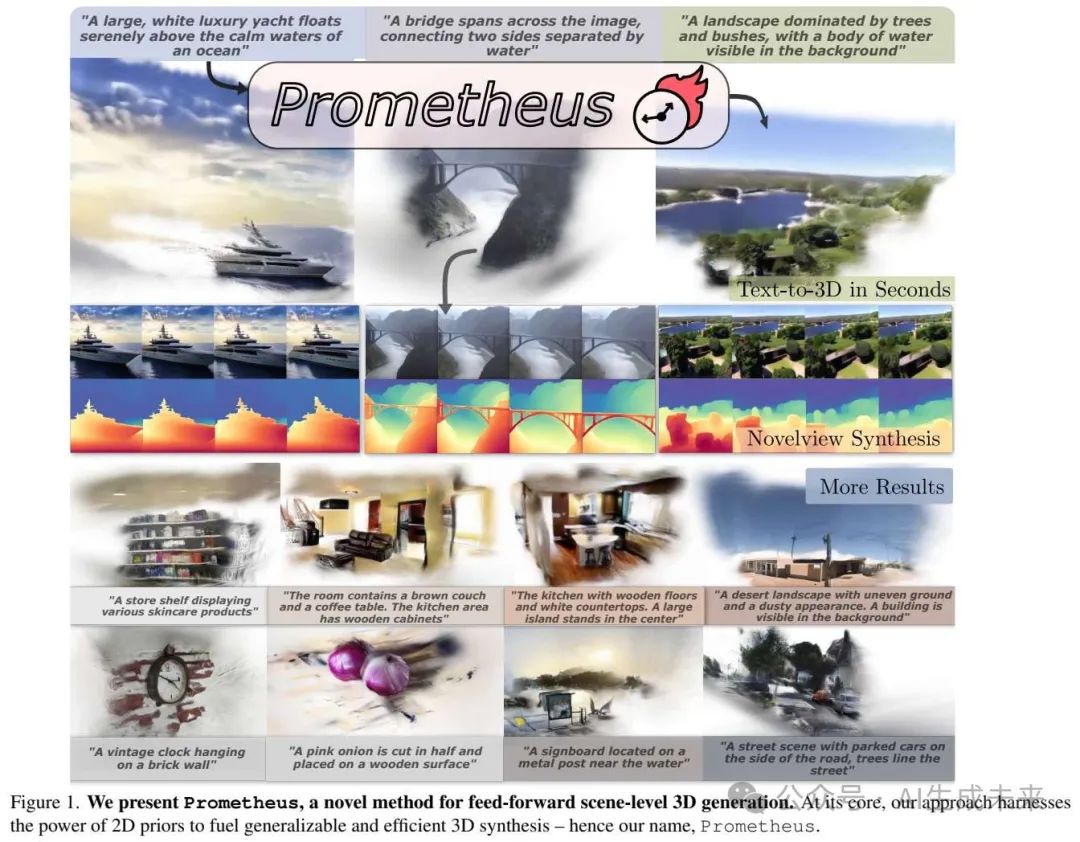

Prometheus,这是一种面向文本到3D生成的3D感知隐空间扩散模型,适用于对象和场景级别。 按照标准的隐空间扩散范式,将训练分为两个不同的阶段。在第一阶段,训练一个3D高斯变分自编码器(GS-VAE),它以多视角或单视角RGB-D图像为输入,预测每个像素对齐的3D高斯。在第二阶段,训练一个多视角LDM,联合预测多视角RGB-D隐空间code,并以相机姿态和文本提示为条件。 此外,本文的完整模型在9个多视角和单视角数据集的组合上进行训练,旨在实现与Stable Diffusion相当的泛化能力。 展示了该方法在前馈3D高斯重建和文本到3D生成中的有效性,表明本模型能够在几秒钟内生成3D场景,同时很好地泛化到各种3D对象和场景。

总结速览

解决的问题

-

实现从文本到3D场景的高效生成,适用于对象级别和场景级别。 -

提升生成3D内容的保真度和几何质量,同时确保模型具备良好的泛化能力。 -

改善现有方法在3D生成中的效率问题,实现快速且高质量的3D生成。

提出的方案

-

多视图、前馈、像素对齐的3D高斯生成:将3D场景生成表述为在隐空间变量扩散框架中的这一过程。

-

两阶段训练框架:

-

第一阶段:训练3D高斯变分自编码器(GS-VAE),以多视角或单视角的RGB-D图像为输入,预测每个像素对齐的3D高斯。 -

第二阶段:训练多视角隐空间变量扩散模型(LDM),联合预测多视角RGB-D隐空间代码,并以相机姿态和文本提示为条件进行生成。 -

RGB-D隐空间变量空间的引入:通过解耦外观和几何信息,优化3D高斯生成的效率和质量。

-

基于预训练模型的微调:以预训练的文本到图像生成模型为基础,进行最小调整后,利用来自单视图和多视图数据集的大量图像进行训练。

应用的技术

-

隐空间变量扩散模型(LDM):作为生成框架,结合3D高斯生成和多视角条件。 -

3D高斯变分自编码器(GS-VAE):用于从RGB-D图像中提取隐空间变量并生成像素对齐的3D高斯。 -

RGB-D隐变量空间:解耦外观(RGB)和几何信息(D),提升生成的保真度和几何质量。 -

多视角训练数据:结合9个多视角和单视角数据集,增强模型的泛化能力。 -

前馈生成策略:相比传统方法,显著加速生成过程。

达到的效果

-

高效生成:在几秒内实现对象级别和场景级别的3D生成。 -

高质量输出:生成的3D内容在保真度和几何质量上表现优异。 -

良好的泛化能力:在不同类型的3D对象和场景中均表现出色,与Stable Diffusion相当的泛化能力。 -

实验验证:大量实验结果证明了Prometheus在前馈3D高斯重建和文本到3D生成中的有效性。

方法

如下图2所示,Prometheus遵循常见的隐空间变量扩散框架,该框架包括两个训练阶段。在第一个阶段,3D自动编码器GS-VAE从多视图图像中学习压缩和抽象的隐空间变量空间。随后,它将该隐空间变量空间解码为像素对齐的3D高斯(3DGS)表示,作为场景级别的表示。在第二个阶段,一个隐空间变量多视图扩散模型(MVLDM)在第一阶段自动编码器生成的隐空间变量表示上进行训练,从而形成一个完全生成的模型。最后,详细说明了采样策略,该策略能够在几秒钟内采样出3D场景,同时保持一致性和视觉保真度。

第一阶段: GS-VAE

在阶段 1 中,目标是训练一个能够将数据压缩到隐空间并随后将其重建为3D表示的3D自动编码器。给定具有相机位姿的多视角输入图像,GS-VAE输出多视角像素对齐的3D高斯表示(3DGS)。这些输出随后被合并为场景级别的3D表示。

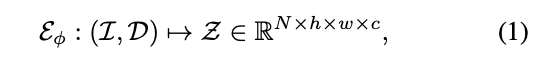

编码多视角RGB-D图像。 提出将RGB图像及其预测的单目深度图一起编码到隐空间中,考虑到单目深度图为后续的3D高斯解码过程提供了线索,并且可以轻松获取。给定一组多视角图像

,

其中每张图像是一个底层3D场景的观察结果,我们首先使用一个现成的深度估计器来获得它们对应的单目深度图:

。

接下来,我们利用一个预训练的图像编码器 对多视角图像 及其深度图 进行编码,以获得潜表示:

其中 是下采样后的分辨率。在实际操作中,使用预训练的 Stable Diffusion(SD)图像编码器,并在训练过程中冻结它。最近的方法(如 Marigold)表明,SD 编码器在处理深度图时表现出强大的泛化能力。因此,我们选择使用相同的 SD 编码器分别对图像和深度进行编码,而无需进行微调。随后,我们将这些编码表示进行拼接,以获得完整的多视图隐空间变量 ,该隐空间变量可用于 3D 重建。此外,我们的扩散模型在联合的 RGB-D 隐空间变量空间中进行训练。

融合多视图隐空间变量图像

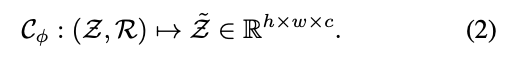

最近的研究进展 [26, 35, 77, 101, 102] 强调了基于 Transformer 的模型在整合多视图信息方面的显著潜力。由于每个视图的隐空间变量编码是独立生成的,我们采用多视图 Transformer 来促进跨视图信息的交换。

我们进一步向多视图 Transformer 中注入 个相机姿态。受近期研究 的启发,我们选择 Plücker 坐标作为相机表示,具体为 ,其中 表示归一化的光线方向, 表示相机原点。因此,初始的 个相机姿态可以重新参数化为多视图光线图

通过在特征通道上拼接多视图隐空间变量编码 和相机光线图 ,并将它们输入到跨视图 Transformer中,从而获得融合的隐空间变量编码 ,该编码融合了多视图上下文信息:

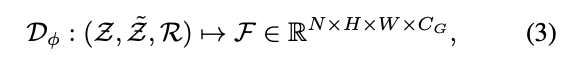

解码为高斯场景 将原始图像的隐空间变量编码 ,光线图 和融合后的隐空间变量编码 进行拼接,并将它们输入解码器,从而获得像素对齐的多视图 3D 高斯场景

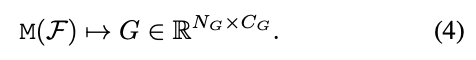

其中, 是与每张图像对应的像素对齐的三维高斯分布。一个三维高斯分布的参数包括: 1 通道的深度,4通道的旋转四元数,3通道的尺度,1通道的不透明度以及3通道的球谐系数。因此,在我们的公式中, 。 在聚合多视图三维高斯分布后,我们可以得到最终的场景级三维高斯分布 ,如公式(4)所示:

这里, 表示聚合操作,通过将所有的 3D 高斯转换为全局坐标系来实现。 表示完整高斯基元的数量,其等于 。

在实践中,该架构同样适用于单视图图像,此时 等于 1 。在训练过程中,同时从单视图和多视图图像中进行采样。此外,为了最大化利用 2D 生成先验,遵循 Director3D 的方法,并对预训练的 Stable Diffusion 图像解码器进行轻微修改,将其重新用作我们的高斯解码器 。具体来说,仅调整了第一层和最后一层卷积层的通道数。

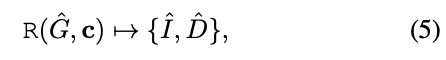

损失函数 给定重建的场景级 3D 高斯 ,可以从任意视点对其进行渲染。设 表示给定的视点,可以从 渲染出相应的 RGB 图像和深度图:

其中,表示 3D 高斯点渲染的可微分渲染。随后可以应用渲染损失,该损失结合了 MSE(均方误差)损失和感知损失:

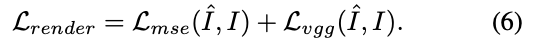

除了在RGB域上的渲染损失外,还在渲染的期望深度 与单目深度 之间施加损失,后者作为伪几何真实值,如下所示:

其中, 是一种尺度不变的深度损失,引用了[55]的方法。这里, 和 是用于将 与 对齐的尺度和偏移,因为 仅在尺度和偏移上是定义的。使用最小二乘准则来确定 和 。

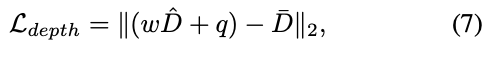

完整的 GS-VAE 损失函数如下:

其中, 表示 GS-VAE 中可优化的参数, 用于平衡每个损失项的权重。

第二阶段: 几何感知多视图降噪器

在第一阶段的训练之后,获得了一个GS-VAE,其具备以下能力:

-

能够高效地将图像压缩到一个紧凑的隐空间空间中; -

通过3D高斯解码器在2D和3D之间架起桥梁.

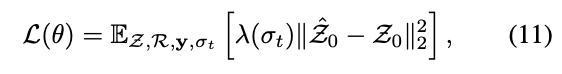

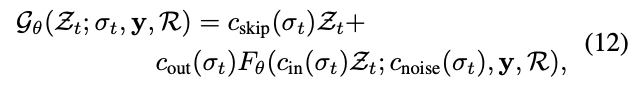

这种能力使能够在隐空间空间中训练多视图扩散模型(MV-LDM)。目标是联合生成多视图RGB-D隐空间编码 ,以提供更丰富的几何线索用于解码 3 DGS 。因此,制定了一个连续时间去噪扩散过程,该过程以文本提示 和相机姿态 为条件。扩散模型包括一个随机的前向过程,用于将一个噪声水平的高斯噪声注入到输入的隐空间编码中,以及一个通过可学习去噪器 移除噪声的反向过程。

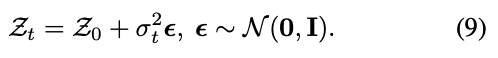

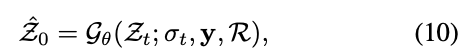

训练。 在每个训练步骤中,采样一个噪声水平 ,其中 。接下来,将这一水平的噪声添加到干净的多视图隐空间编码 中,以获得带噪声的隐空间编码 为:

在反向过程中,扩散模型通过一个可学习的多视图去噪器 将 去噪为预测的干净隐空间编码 ,表示如下:

其中, 和 分别是文本和相机姿态的条件。MV-LDM 是通过在隐空间中使用去噪得分匹配 (DSM)进行训练的。

带有加权函数 。在本工作中,我们遵循 EDM,并将去噪器 参数化为:

其中, 是要训练的 UNet, 和 是预处理函数。此外,与阶段1中的公式(3)一致,使用射线图作为姿态表示,并通过将其与带噪声的隐空间编码 沿特征通道连接的方式将其引入网络中。此外,文本提示条件通过交叉注意力机制引入。

受最近多视图扩散方法 [18, 38, 63] 的启发,将原始 UNet 中的自注意力块替换为3D跨视图自注意力块,以捕捉多视图相关性。在实践中,为了利用预训练的文本到图像模型的先验,从预训练的文本到图像扩散模型(特别是 Stable Diffusion 的 UNet)初始化模型。

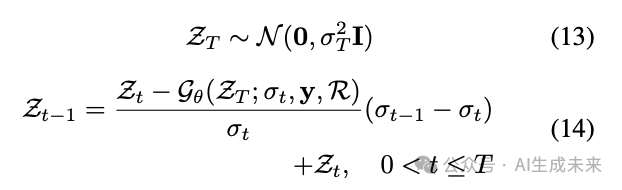

采样。 在采样时,多视图隐空间编码 是通过在文本提示和相机姿态的条件下,从随机采样的高斯噪声 开始,通过迭代应用训练好的 MV-LDM 的去噪过程恢复的。

其中, 是从一个具有 步固定方差计划的去噪过程采样得到的。

噪声水平的重要性 受近期研究工作的启发 ,认识到在去噪步骤中较低的信噪比(Signal-to- Noise Ratio,SNR)对于确定内容的全局低频结构至关重要。此外,在采样过程中较低的 SNR 对于在多视图扩散模型 中实现多视图一致性也是必不可少的。因此,在 MV-LDM 的多视图训练中采用了一个相对较大的噪声分布,具体为 和 ,而在单视图训练中采用了 和 。

几秒钟内生成文本到 3D 场景

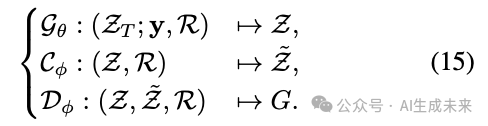

基于上述模型,可以通过以下方式实现前馈的文本到3D场景生成:从隐空间中使用多视图扩散模型 对随机采样的高斯噪声 进行采样,生成多视图的 RGB-D 隐空间变量 ,随后通过 GS-VAE 解码器解码为一个 3 D 高斯场景 :

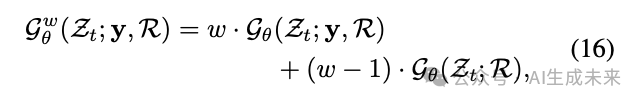

为了以高质量进行采样并与条件对齐,使用无分类器引导(CFG)来引导多视图生成朝向条件信号。

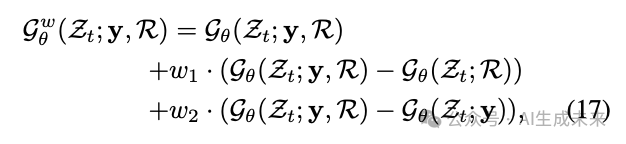

其中, 表示引导强度。然而,如果我们简单地应用大多数文本到图像方法中常用的朴素CFG公式 (公式(16)),增加 会导致生成结果中的多视图不一致。上述朴素设计导致模型过度拟合文本条件,同时损害多视图一致性,这与 中的发现一致。为了在采样过程中平衡多视图一致性和保真度,遵循 HarmonyView 并调整混合采样引导,将公式(16)重写如下:

其中, 和 分别表示文本引导和姿态引导的权重,且满足 ,从而更好地在生成的视图中保持保真度和一致性。此外,还采用[41]中提出的 CFG-rescale 方法,以避免在条件采样过程中出现过饱和问题。

实验

训练数据

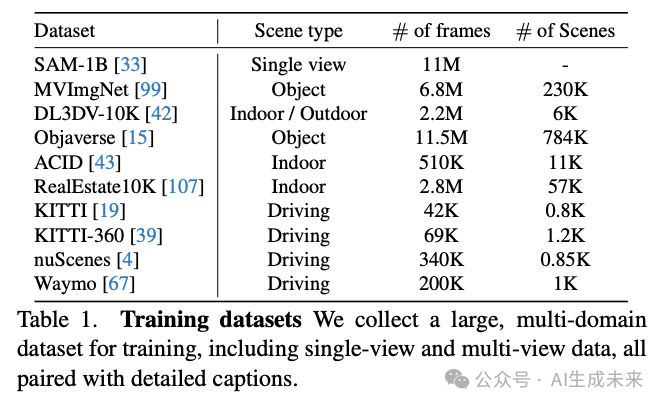

本文方法在大规模单视图和多视图数据集上进行训练,详见下表1。关于单视图数据集,使用了高质量的 SAM-1B 数据集,该数据集包含详细的描述,并出现在 PixArt-α 中。本文模型在9个多视图数据集的组合上进行训练,这些数据集包括以物体为中心、室内、室外和驾驶场景。每个场景的文本提示由多模态大语言模型 生成。

实施细节

在GS-VAE的训练阶段(阶段1),为每个多视图场景设置输入视图和新视图的数量为 。为了提高模型的泛化能力,还在多视图图像旁采样 2 个单视图图像,并仅对单视图图像的输入视图应用损失。

GS-VAE在 8 个A800 GPU上以 32 的批量大小进行训练。最终模型经过 200,000 次迭代,大约需要 4 天。使用gsplat作为我们的3D高斯渲染器。从预训练的RayDiff模型初始化跨视图Transformer的权重。

对于MV-LDM(阶段2),采用Stable Diffusion 2.1作为基础模型。在训练过程中,为每个多视图场景设置 。与阶段 1 类似,在多视图图像旁采样 个单视图图像。每次迭代时,在每个GPU上采样批大小为 8 的图像。最终的MV-LDM模型在 32 个A800 GPU上训练,总批量大小为 3072 张图像。模型经过 350,000 次迭代,大约需要 7 天。使用DepthAnything-V2-S模型动态估计深度图。为了在采样过程中实现无分类器引导,在训练过程中,以 的概率随机丢弃文本条件 和姿态条件 。

评估协议

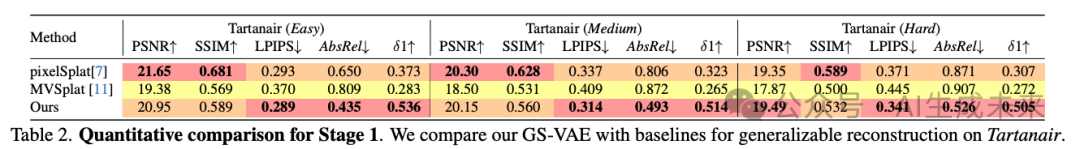

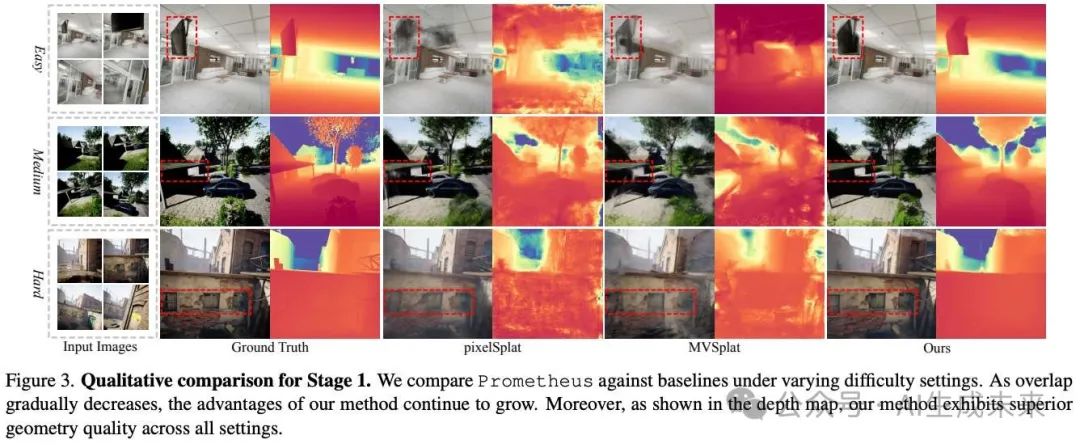

3D重建(阶段1)。 为了展示GS-VAE的3D重建泛化能力,使用Tartanair进行评估。Tartanair是一个多样化的合成数据集,包含18个不在我们训练集中的场景,涵盖室内和室外场景。根据输入视图之间的重叠程度和距离,将其分为三种不同模式:简单、中等和困难,每种模式包含4个上下文视图和3个目标视图。使用PSNR、SSIM 和LPIPS 指标来评估重建图像。为了更好地比较重建的几何形状,评估渲染的深度图。按照[27, 61]的方法,将渲染的深度图与真实值进行每场景的比例和偏移对齐,并计算两个广泛认可的指标进行评估:绝对平均相对误差(AbsRel)和在指定阈值1.25下的准确率。

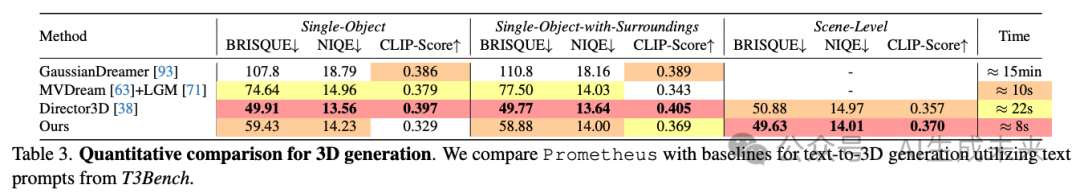

3D生成(阶段2)。 为了评估本文模型的文本到3D生成能力,使用来自T3Bench 的两个文本提示集——单对象和单对象带环境。这些集合共同评估模型在对象级别和场景级别生成任务中的熟练程度。此外,收集了80个涵盖室内和室外场景的多样化场景级别文本提示。定量结果使用CLIPScore、NIQE 和BRISQUE 指标进行评估。CLIPScore评估生成图像与文本提示之间的一致性,而NIQE和BRISQUE则表示图像质量。

与基线比较

3D重建。 将Prometheus的GS-VAE与两种稀疏视图重建模型进行比较,即pixelSplat 和MVSplat 。定量结果如下表2所示,其中强调了所有指标中的最佳、次佳和第三佳得分。首先在几何方面,Prometheus超过了其他两个基线,其优势随着输入视图重叠程度的减少而更加明显——参见,在简单模式下相对提升了44%,在困难模式下相对于pixelSplat有显著的64%提升。关于重建的图像,Prometheus在简单模式下提供了可比的结果,并且在模式加剧时,特别是在困难模式下,明显优于其对手。在下图3中也提供了定性结果。这些关于几何和图像重建的发现表明,Prometheus比其基线对输入视图重叠的变化更具鲁棒性,这是下游3D生成任务成功的关键因素。

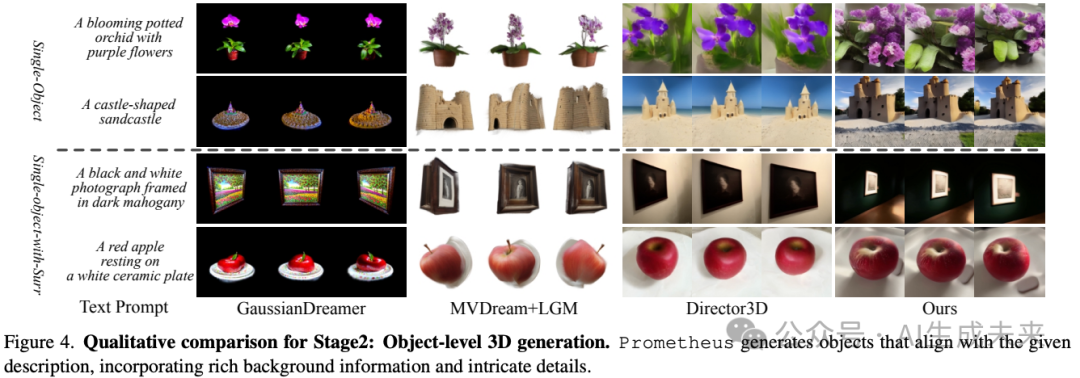

3D生成。 将Prometheus与三种文本到3D的基线方法进行比较,涵盖了基于优化的方法和前馈方法。GaussianDreamer 是一种最先进的基于SDS的3DGS方法。还实现了一个基线,它将多视图到3D的方法LGM 应用于由MVDream 生成的图像。我们还与一种前馈方法Director3D(不带精炼器)进行比较。下图4和下图5显示,本文方法能够生成对象和场景级别的内容,包含背景和丰富的细节,优于基于优化和前馈的基线。下表3显示,整体指标在对象级别上不如Director3D,但在其他情况下领先。这归因于对象中心设置中的失败案例。请注意,我们方法仅需8秒即可生成,优于所有基线。

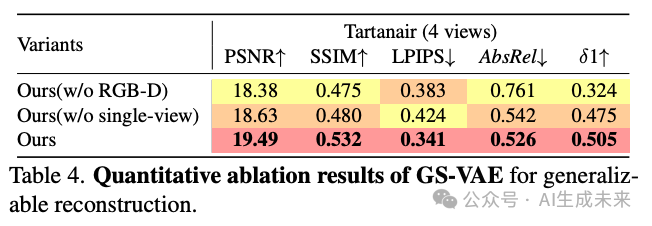

GS-VAE 消融 (Stage 1)

在下表4中,对Tartanair的困难模式进行了消融研究,分析了GS-VAE的以下因素。

深度先验对GS-VAE的有效性: 研究了在第一阶段训练中RGB-D隐空间空间的影响。上表4中的结果显示,仅使用RGB隐空间空间而不使用RGB-D隐空间空间进行训练,会导致几何结果比完整模型更差。此外,这种较差的几何将导致重建图像的质量不佳,详见图6中的定性结果。

大规模数据集在可泛化重建中的重要性: 接下来,对大规模数据集的有效性进行了消融研究,在上表4中标记为“w/o single-view”。排除单视图数据集会导致重建图像和几何性能的下降。这强调了大规模数据集在实现稳健的可泛化重建中的重要作用。也在下图6中展示了定性结果。

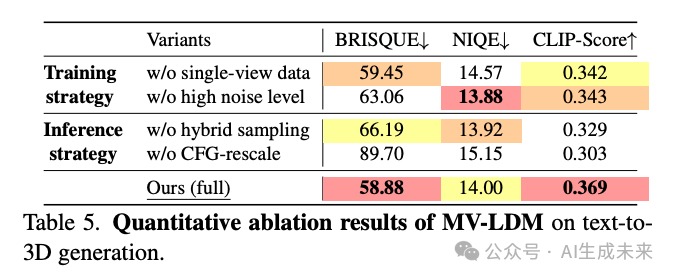

MV-LDM 消融(Stage 2)

在下表 5 中,对 T3Bench 的 SingleObject-with-Surroundings 子集进行了消融研究,分析了 MV-LDM 的训练和推理策略。

单视图数据集 (Single-View Dataset)

评估了单视图数据的影响。当仅使用多视图数据进行训练(即不包含单视图数据,w/o single-view data)时,模型性能出现了下降。这种性能下降可归因于缺乏单视图数据,导致模型的泛化能力降低,这与 MVDream 中的观察结果一致。

高噪声水平 (High Noise Level)

如 Zero123++ 和前文所述,对模型而言,在低频空间中学习高层次结构是至关重要的。因此,通过在多视图训练中设置 和 (即不包含高噪声水平,w/o high-noise level)来评估高噪声水平的有效性。上表 3 的结果显示,在这种设置下,视觉质量和 CLIP 分数均有所下降。

混合采样和 CFG 重标定 (Hybrid Sampling and CFG-Rescale)

最后,评估了前文中推理策略的设计,具体包括混合 CFG 采样和 CFG 重标定。在实验中,仅对文本提示应用 CFG(即不使用混合采样,w/o hybrid sampling),并将 CFG 重标定因子设置为 0(w/o CFG-rescale)。上表 5 显示,缺乏混合采样和 CFG 重标定会导致指标在不同程度上下降。

结论

Prometheus,这是一种3D感知的隐空间扩散模型,专为在对象级别和场景级别上实现文本到3D生成而设计,并且能够在数秒内完成。通过大量实验,展示了该方法在前馈重建和3D生成任务中的有效性。相信,本工作为文本到3D场景生成提供了重要贡献,提升了通用性、保真度和效率。

参考文献

[1] Prometheus: 3D-Aware Latent Diffusion Models for Feed-Forward Text-to-3D Scene Generation

(文:极市干货)

这不就是最近大火的多视图3D生成模型吗?我看懂了一点:通过融合RGB-D隐空间变量和相机姿态,再用Transformer进行跨视图信息整合,最后解码成像素对齐的高斯分布场景。这论文写得太专业了!不过看样子还是得先预训练Stable Diffusion才行,真是个精巧的设计。