选自The Algorithmic Bridge

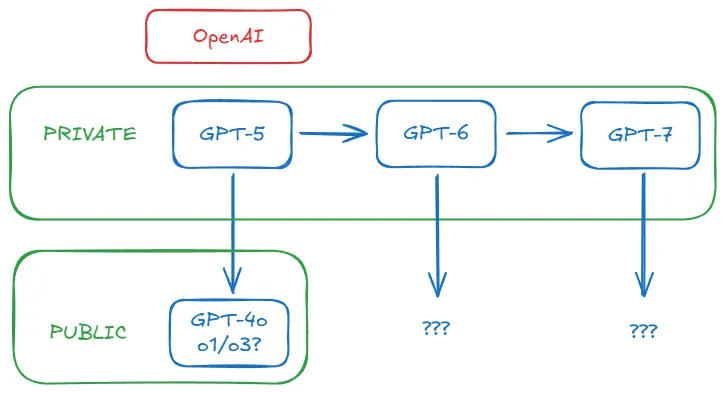

「从现在开始,基础模型可能在后台运行,让其他模型能够完成它们自己无法完成的壮举——就像一个老隐士从秘密山洞中传递智慧。」

-

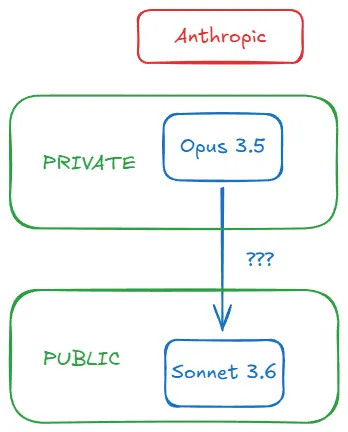

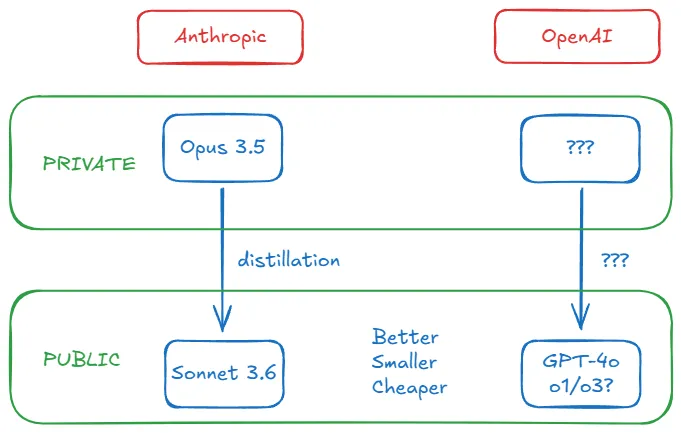

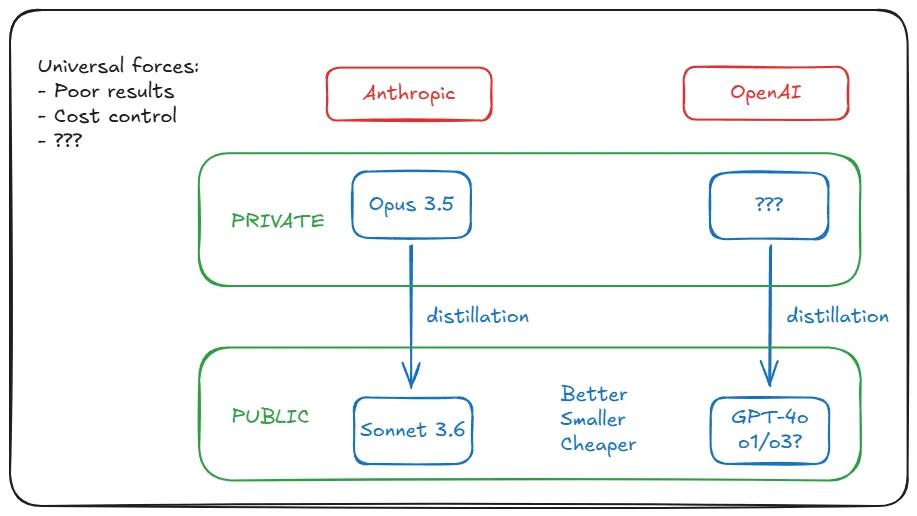

10 月 28 日,有传言称 Sonnet 3.6 是…… 备受期待的 Opus 3.5 训练失败的中间检查点。r/ClaudeAI subreddit 上出现了一篇文章称 Claude 3.5 Opus 已被废弃,并附有指向 Anthropic 模型页面的链接。截至今天,该页面没有提及 Opus 3.5。有人猜测,删除 Opus 3.5 是为了在即将到来的融资轮之前保持投资者的信任而采取的战略举措。 -

11 月 11 日,Anthropic 首席执行官 Dario Amodei 在 Lex Fridman 播客上否认他们已经放弃 Opus 3.5,从而消除了谣言:「没有给出确切的日期,但据我们所知,计划仍然是推出 Claude 3.5 Opus。」态度谨慎,但是确认。 -

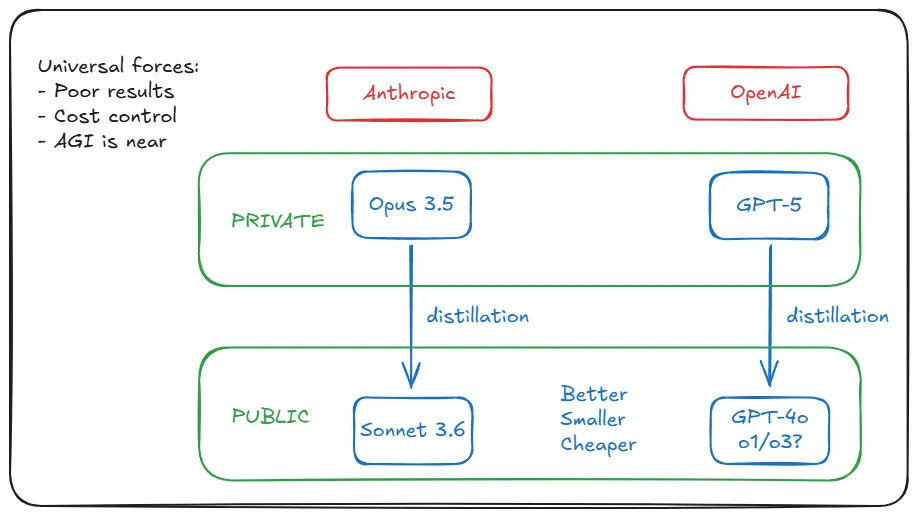

11 月 13 日,彭博社的报道证实了之前的传言:「经过训练后,Anthropic 发现 3.5 Opus 在评估中的表现优于旧版本,但考虑到模型的大小以及构建和运行的成本,其优势并没有达到应有的程度。」Dario 似乎没有给出日期,因为尽管 Opus 3.5 的训练运行没有失败,但其结果却不尽如人意。请注意,重点是相对于性能的成本,而不仅仅是性能。 -

12 月 11 日,半导体专家 Dylan Patel 和他的 Semianalysis 团队给出了最后的情节转折,提出了一个将所有数据点编织成一个连贯故事的解释:「Anthropic 完成了对 Claude 3.5 Opus 的训练,它表现良好,并且能够适当扩展…… 但 Anthropic 并没有发布它。这是因为 Anthropic 没有公开发布,而是使用 Claude 3.5 Opus 来生成合成数据并进行奖励建模,从而与用户数据一起显著改进了 Claude 3.5 Sonnet。」

推理成本(新 Sonnet 与旧 Sonnet 相比)没有显著变化,但模型性能提升了。为什么要发布 3.5 Opus 呢?从成本角度来看,相比发布经过 3.5 Opus 进一步后训练的 3.5 Sonnet,这样做在经济上是不合理的。

……GPT-4o 和 Claude 3.5 Sonnet 等当前的前沿模型的参数量可能比 GPT-4 小一个数量级:4o 大约有 2000 亿参数,3.5 Sonnet 大约有 4000 亿参数…… 考虑到我得出这个数字的粗略方式,这些估计值可能有 2 倍的误差。

「理论上,即使我们现有的硬件也足以支持比 GPT-4 大得多的模型:例如,一个放大 50 倍的 GPT-4 版本,拥有大约 100 万亿参数,可能每百万输出 token 的成本为 3000 美元,输出速度为每秒 10-20 个 token。然而,要实现这一点,这些大型模型必须为使用它们的客户带来大量经济价值。」

©

(文:机器之心)