AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文作者王晓强,加拿大蒙特利尔大学(Université de Montréal)和 Mila 人工智能研究所博士生,师从刘邦教授。博士期间的主要研究方向为自然语言处理,重点关注大语言模型的能力评估及其在智能体中的应用。目前已在自然语言处理领域的顶级会议 ACL、EMNLP 等发表多篇论文。

在人工智能的宏大发展蓝图里,通用人工智能(AGI)堪称研究者们梦寐以求的 「圣杯」,其终极目标是打造出像人类一样拥有广泛且灵活智能的系统,能够理解、学习并胜任几乎所有任务。在迈向这个目标的征程中,实现人工智能与数字世界的高效交互至关重要,而桌面任务 UI 自动化更是其中的关键赛道。

想象一下,未来我们只需轻松说出指令,电脑就能自动完成各种复杂操作,繁琐的手动操作成为历史,工作效率大幅提升,这样的场景是不是很令人期待?

去年,Anthropic 发布的 Computer use 为 AI 在桌面操作领域带来了新突破。它允许开发者通过 API,让 Claude 像人类一样操作计算机,极大拓展了 AI 在桌面操作领域的应用场景。

今年一月份,OpenAI 重磅推出的 Computer Using Agent(CUA)也备受瞩目,其赋能的 Operator 凭借 GPT-4o 的视觉能力,能够 「看懂」网站并与之交互,还可在 ChatGPT 界面自动执行多种常规浏览器任务。

与它们采用商用 API 不同,今天要给大家介绍一个来自加拿大蒙特利尔大学和 Mila 研究所的研究团队的开源解决方案 ——OSCAR(Operating System Control via state-Aware reasoning and Re-planning)。

OSCAR 不仅实现了桌面任务 UI 自动化,还在多个操作系统环境(桌面 Windows、Ubuntu 和智能手机 Android)完成了泛化与验证。目前,该研究已被 AI 领域顶级会议 ICLR 录用。下面,就让我们深入了解一下它的创新之处。

-

论文题目:OSCAR: Operating System Control via State-Aware Reasoning and Re-Planning

-

论文链接:https://arxiv.org/abs/2410.18963

操作系统 UI 交互自动化面临的挑战:

动态自适应难题

基于多模态大型语言模型(MLLM)的智能体(Agent)在复杂任务自动化领域表现出色,广泛应用于网络浏览、游戏、软件开发等场景,但不同应用的观察和动作空间差异极大,导致智能体通用性差,难以适应复杂工作流。

此外,以往的 UI 交互智能体多在静态离线的环境中开发,靠视觉问答和预设动作路径操作,缺乏操作系统实时反馈,任务失败时无法动态自适应。在现实应用中,实时反馈和自适应调整对适应新的 UI 环境至关重要,比如 「打开某文件并打印」 有多种操作路径,可通过开始菜单搜索,也能直接导航路径,但传统智能体难以应对这种多样性。

具体构建通用 UI 交互智能体面临以下挑战:

-

统一控制接口难题:智能体需熟练运用鼠标、键盘等标准输入方式,精准理解视觉信息并转化为指令,在不同应用中稳定高效操作。

-

UI 定位困境:智能体要能解读屏幕信息,精准识别各类元素,如网页搜索时准确找到搜索框并正确交互,对其理解和定位能力要求高。

-

新 UI 探索与重规划挑战:智能体需像人类面对陌生软件一样,具备动态探索和调整计划的能力,能处理软件崩溃等意外,依据反馈优化策略。

OSCAR 的独特设计:

灵活状态机与动态重规划的巧妙结合

为解决上述难题,研究团队推出 OSCAR。它以代码为核心控制方式,与动态操作系统环境自主交互,创新点如下:

-

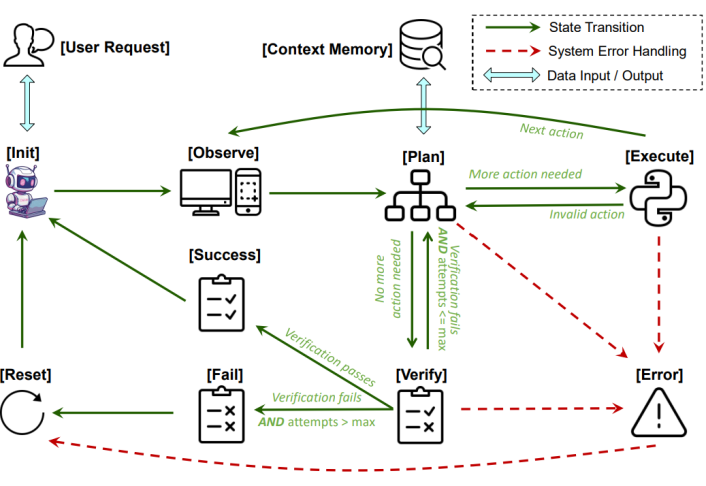

状态机架构:OSCAR 采用状态机模式,通过 [Init](初始化)、[Observe](观察)、[Plan](规划)、[Execute](执行)、[Verify](验证)等状态循环,处理任务各环节。遇到问题时利用实时反馈重新规划,比传统方式效率更高、适应性更强。

OSCAR 状态机

-

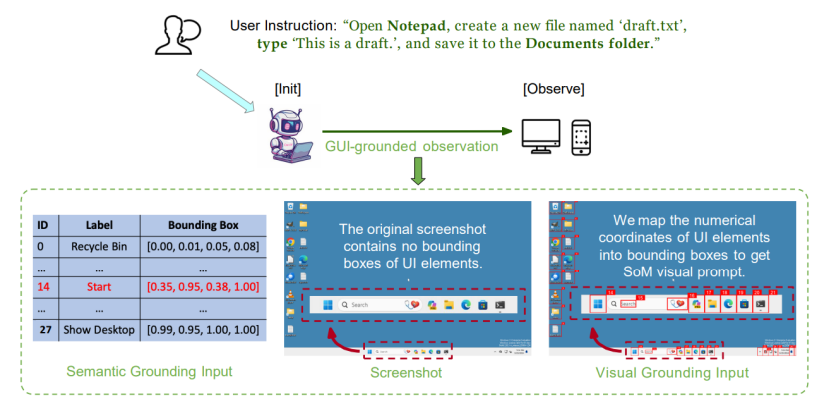

视觉和语义双重 UI 定位:OSCAR 利用 Set-of-Mark(SoM)提示技术和可访问性(A11Y)树生成视觉提示,精准定位 UI 元素;同时添加描述性标签进行语义定位,便于把握 UI 布局,灵活操作元素。

OSCAR 视觉和语义双重 UI 定位

-

任务驱动重新规划:受计划 – 解决提示(plan-and-solve)启发,OSCAR 将用户指令分解为子任务并逐步生成动作。收到负面反馈时,针对特定子任务重新规划,避免整体重规划,提高效率并防止错误传播。

-

基于代码的动作:OSCAR 借助生成的语义定位信息,利用元素 ID 或坐标引用交互元素,通过 PyAutoGUI 库生成控制代码,精确控制操作系统。

OSCAR 任务分解与重规划

OSCAR 实验验证:

UI 理解、定位和动态导航能力的实力认证

研究人员在 GAIA、OSWorld、AndroidWorld 等多个真实世界工作流自动化基准测评数据集中对 OSCAR 进行了评估,这些基准涵盖了不同难度和类型的任务,包括简单操作、复杂多步骤任务以及跨多种应用的任务。

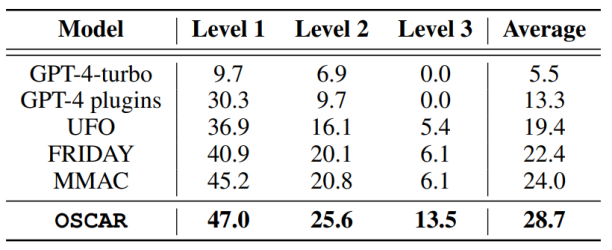

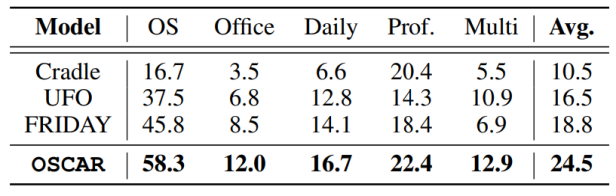

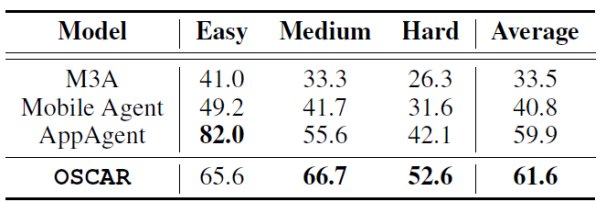

1. 基准测评成绩突出:在 GAIA 基准测试中,OSCAR 在所有工作流复杂程度级别上都表现最佳。尤其是在最复杂的 Level 3 任务上,成功率达到 13.5%,几乎是之前最先进方法的两倍。在 OSWorld 和 AndroidWorld 基准测评中,OSCAR 同样超越其他智能体,展现出强大的适应性。

6a. GAIA 基准测评

6b. OSWorld 基准测评

6c. AndroidWorld 基准测评

OSCAR 在基准测评 GAIA, OSWorld 和 AndroidWorld 中取得最好水平

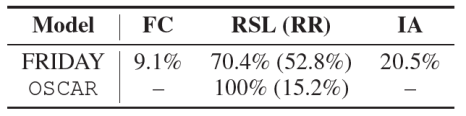

2. 规划效率优势显著:

在成功案例中,OSCAR 成功案例所需重新规划次数更少,而且每次重新规划的步骤更高效

在失败案例中,OSCAR 在错误完成(FC)、达到步骤限制(RSL)和无效动作(IA)这些情况中的重新规划冗余度(RR)明显低于其他智能体系统

结语:开启操作系统交互新时代

OSCAR 作为通用智能体,凭借灵活的状态机和动态的重新规划能力,在桌面和智能手机操作系统任务中展现出强大的适应性和有效性。它为自动化工作流提供了高效通用的解决方案,有望成为提升动态操作系统环境生产力的有力工具,让操作系统交互变得更加便捷、高效、易访问。而且,凭借其开源特性,未来 OSCAR 还将在众多开发者的共同努力下不断进化,持续助力通用人工智能与数字世界实现完美交互。

(文:机器之心)