多模态大模型是实现AGI的必经之路。它通过模拟人类的多模态感知能力,使模型能够更自然地与人类交互,理解人类的喜怒哀乐以及工作和生活习惯。在人工智能的浪潮中,多模态大语言模型(MLLM)正引领着一场深刻的变革。

这次我整理了多模态论文700篇,还邀请了头部互联网企业算法专家,研发多模态大模型的Geoff老师,在2月13号晚8点给大家带来《深度解析比肩GPT-4o——实时交互多模态大模型VITA-1.5》

扫码回复:多模态

领导师整理700篇多模态大模型论文

如需其他AI相关资料,请扫码索取~

在人工智能的浪潮中,多模态大语言模型(MLLM)正引领着一场深刻的变革。VITA-1.5,作为这一领域的前沿成果,通过其创新的三阶段训练方法,成功地将视觉、语言和语音模态深度融合,实现了近实时的交互能力。这次Geoff老师将在13号晚八点深入探讨VITA-1.5的技术细节、架构设计、训练策略以及性能评估,会给大家提供一个全面而深入的理解框架,把握这一多模态交互领域的最新进展。

课程大纲

1. 多模态融合的背景与挑战

2. VITA-1.5模型架构详解

3. 三阶段训练策略

4. 数据集构建与性能评估

5. 未来应用机会

扫码预约直播

领导师整理700篇多模态大模型论文

如需其他AI相关资料,请扫码索取~

未来,多模态模型预计将在多模态预训练模型、多模态与强化学习的结合、人机交互、少样本学习等多个领域实现技术突破,同时,也将面临数据隐私、模型可解释性、计算资源需求等方面的挑战。

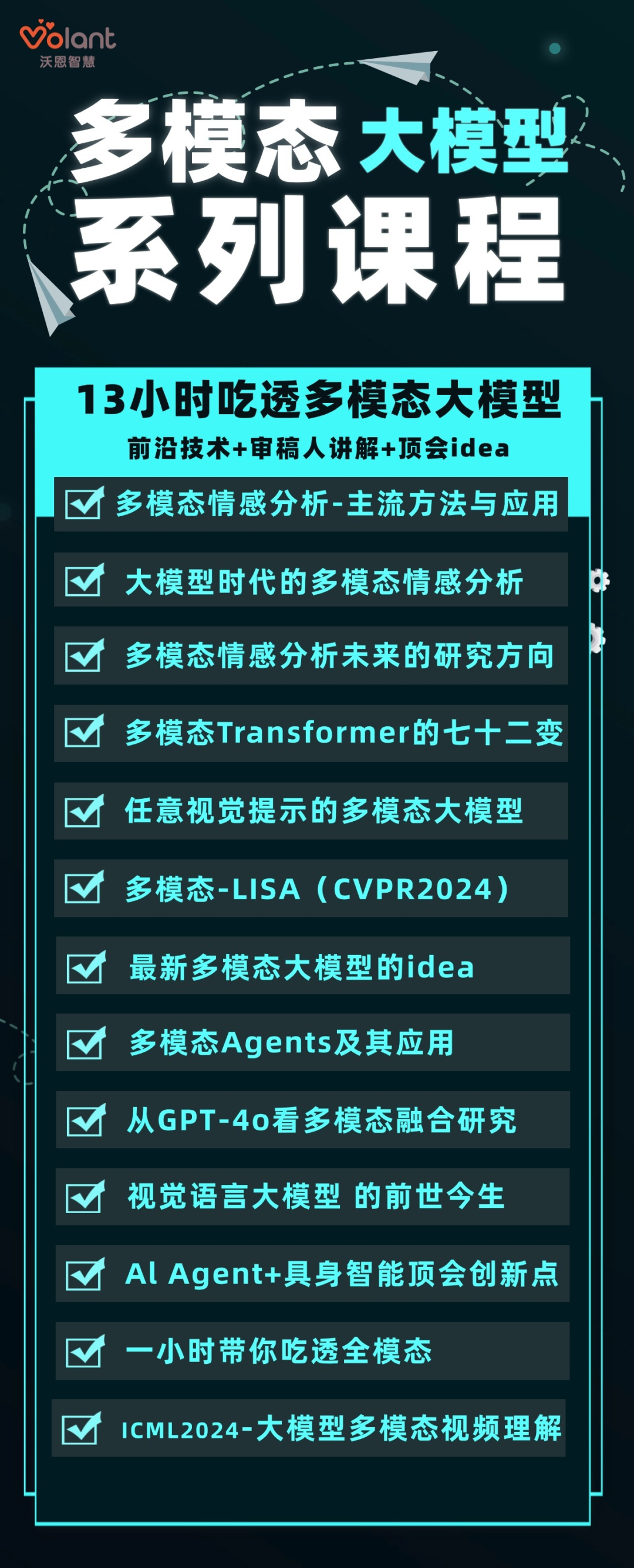

随着技术的不断进步,多模态模型有望在更多新兴领域得到应用,为社会带来新的商业模式和价值。我特意整理了多模态大模型系列课+多个多模态顶会idea,免费分享给大家!

扫码回复“多模态”

领取多模态学习大礼包

(文:PaperWeekly)