PaperWeekly

PaperWeekly

ICCV 2025 视觉Token跳起来!上交大×蚂蚁联手推出多模态通用加速框架

近日,上海交通大学人工智能研究院晏轶超副教授联合蚂蚁集团的研究团队提出Skip-Vision框架,无需额外预训练或重新训练大模型,在SFT流程中插入即可加速视觉-语言模型。该框架通过跳过冗余视觉Token和使用Summary Token机制在保留理解能力的同时显著降低计算开销和延迟。

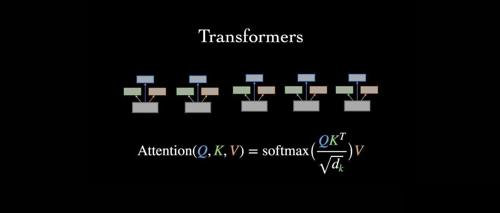

建议所有博士都去学一遍,真的赢麻了

文章介绍了科研过程中的方法和技巧,强调了实践的重要性超过单纯阅读文献。它推荐了一门由顶级学术会议主席讲授的系统课程,涵盖选题、实验设计等多个环节,帮助新手快速提升论文发表能力。

ICML 2025 Entropy不灵了?北大港中文用“区域置信”重新定义模型的不确定性

来自北京大学与香港中文大学的最新研究提出 ReCAP 框架,成功打破熵最小化在 Test-Time Training 的性能瓶颈。论文提出区域置信度代理概念,通过优化区域内模型预测不确定性与稳定性之间的联系来提升下游任务泛化性能。