-

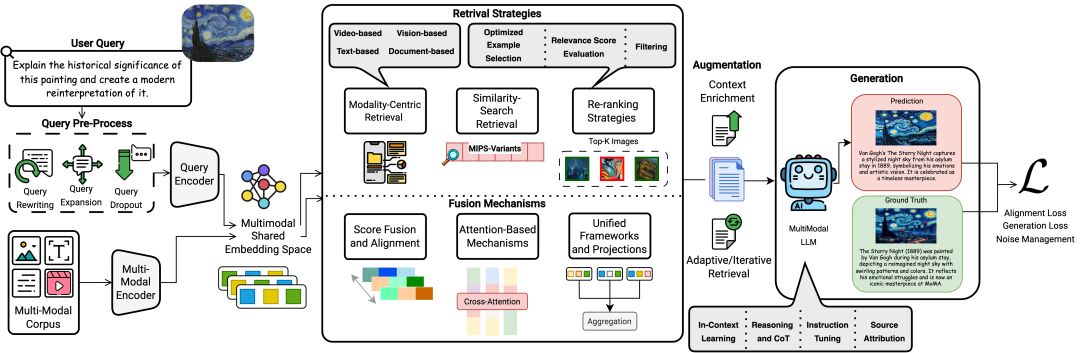

提出了一个多模态RAG系统的通用框架;

-

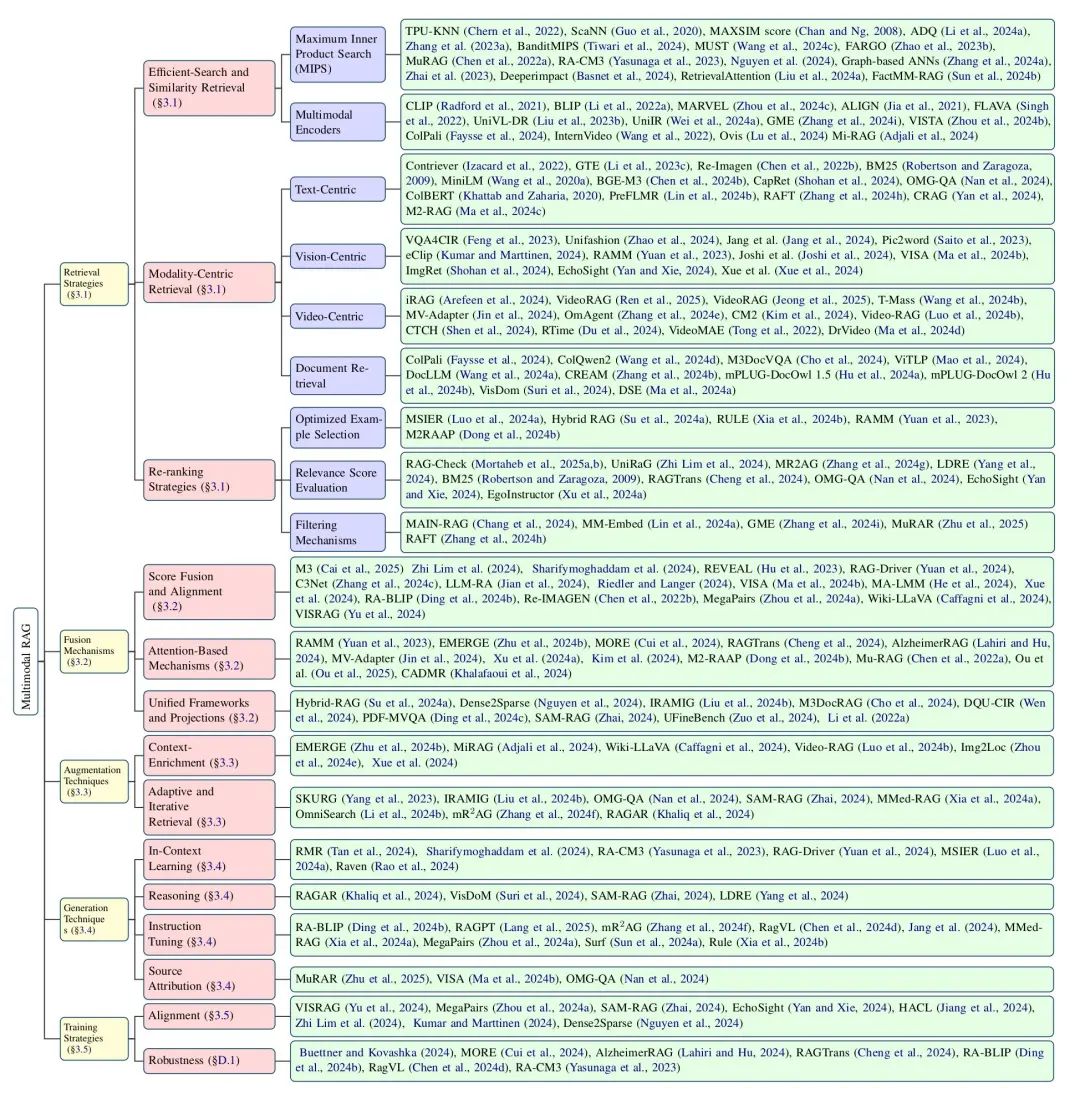

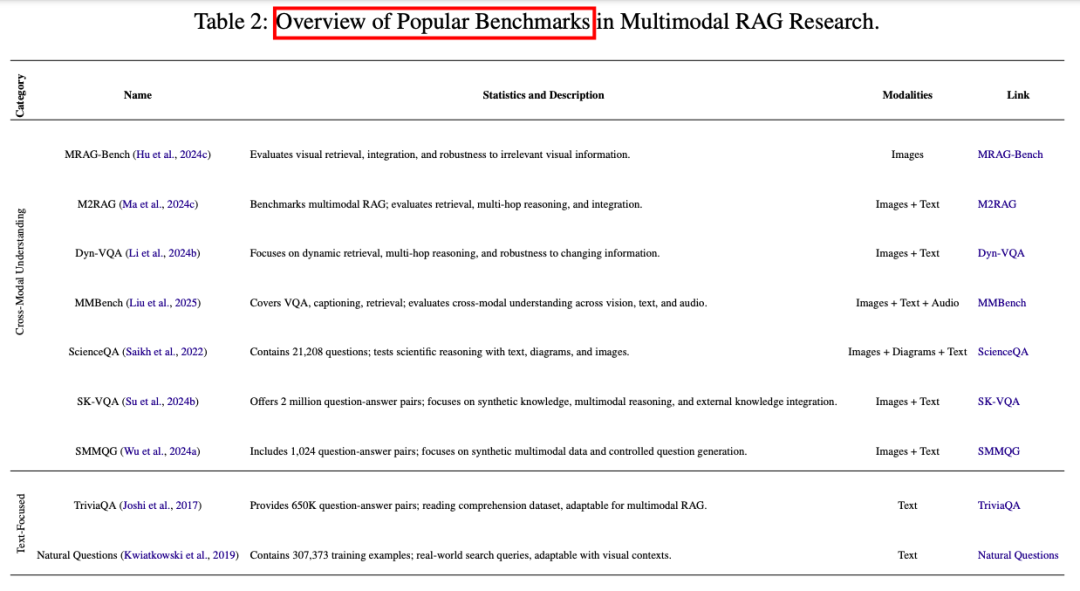

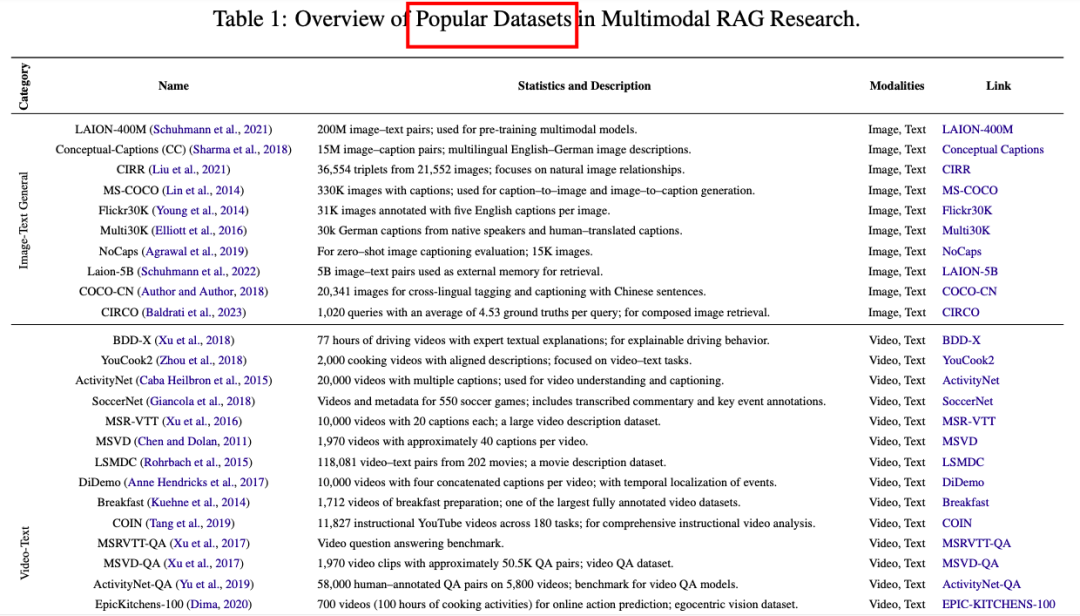

并对多模态RAG系统进行了系统且全面的分析,涵盖了数据集、评估指标、基准测试、评估方法以及检索、融合、增强和生成方面的创新

多模态检索增强生成(RAG)通用框架,突出展示了每个阶段所采用的先进技术和方法。查询预处理、多模态数据库、检索策略(模态为中心)、融合机制、增强技术、生成阶段、训练策略(噪声管理技术)。

1、检索策略(Retrieval Strategy)

检索策略是多模态RAG系统的核心部分,主要通过高效搜索和相似性检索来提升信息检索的准确性和效率。具体方法包括:

-

高效搜索和相似性检索:使用最大内积搜索(MIPS)及其变体,如TPU-KNN、Scalable Nearest Neighbors(ScaNN)等,通过近似最近邻搜索提高检索速度。

-

模态中心检索:根据模态特性优化检索效率,包括文本中心(如BM25、MiniLM)、视觉中心(如EchoSight、ImgRet)和视频中心(如iRAG、VideoRAG)的检索方法。

-

重排序和选择策略:通过优化示例选择、改进相关性评分和应用过滤机制来提高检索质量。例如,使用BERTScore、SSIM等多模态相似性度量进行重排序,以及通过硬负样本挖掘和共识过滤方法去除低质量数据。

2、融合机制(Fusion Mechanisms)

融合机制的目标是将来自不同模态的数据整合到统一的表示中,以支持跨模态推理。主要方法包括:

-

分数融合与对齐:通过将不同模态的数据转换为统一格式(如文本)或嵌入到共享语义空间中,实现模态间的对齐。例如,使用CLIP Score或BLIP特征融合来衡量图像和文本的相关性。

-

基于注意力的机制:动态加权跨模态交互,支持特定任务的推理。例如,双流共注意力机制(如RAMM)和基于用户注意力的特征融合(如RAGTrans)。

-

统一框架和投影:将多模态输入整合为连贯的表示。例如,通过层次化交叉链和晚期融合处理医疗数据(如IRAMIG),或通过将图像转换为文本描述以简化多模态输入(如SAM-RAG)。

3、增强技术(Augmentation Techniques)

增强技术通过优化检索到的文档,提升多模态RAG系统的性能。主要方法包括:

-

上下文丰富化:通过添加额外的上下文元素(如文本片段、图像标记或结构化数据)来增强检索到的知识,使其更适合生成任务。例如,通过实体检索和查询重构来优化视觉问答(如MiRAG)。

-

自适应和迭代检索:根据查询的复杂性动态调整检索过程。例如,通过多轮检索策略逐步细化检索结果(如OMG-QA),或通过反馈机制优化检索内容(如IRAMIG)。

4、生成方法(Generation Techniques)

生成方法关注于提升多模态RAG系统的输出质量和连贯性。主要创新包括:

-

上下文学习(In-Context Learning):利用检索到的内容作为少样本示例,增强模型的推理能力。例如,通过检索相关驾驶经验来优化生成(如RAG-Driver)。

-

推理(Reasoning):通过分解复杂推理任务为多个小步骤(如链式推理),提升生成内容的逻辑性和准确性。例如,通过多跳推理和证据整合来支持复杂问答(如RAGAR)。

-

指令调整(Instruction Tuning):针对特定任务调整生成模块,提升模型对指令的理解和执行能力。例如,通过指令调整优化医学图像报告生成(如FactMM-RAG)。

-

来源归因(Source Attribution):确保生成内容能够追溯到具体的来源,提升系统的透明度和可信度。例如,通过高亮显示支持证据的图像区域来归因(如VISA)。

5、训练策略(Training Strategies)

训练策略旨在优化多模态RAG系统的训练过程,提升模型的泛化能力和鲁棒性。主要方法包括:

-

对齐(Alignment):通过对比学习(如InfoNCE损失)优化多模态表示的对齐,确保正样本更接近、负样本更远离。

-

生成(Generation):使用交叉熵损失训练自回归语言模型,或通过生成对抗网络(GAN)和扩散模型优化图像生成。

-

鲁棒性增强(Robustness):通过注入噪声、使用硬负样本或知识蒸馏等方法,提升模型对噪声和错误数据的鲁棒性。例如,通过Query Dropout增强生成器性能(如RA-CM3)。

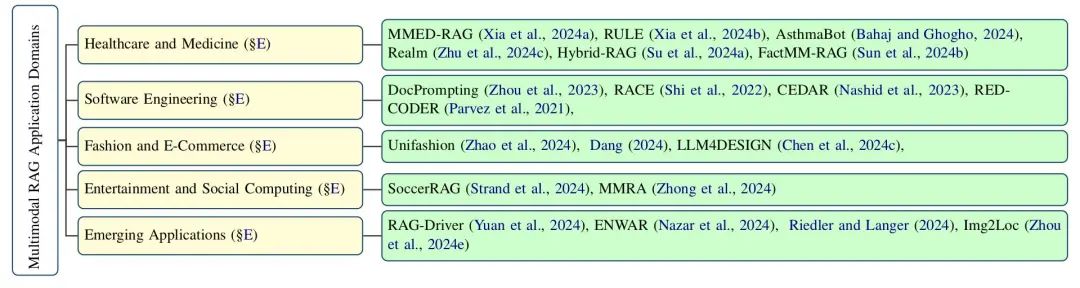

RAG领域首篇多模态RAG综述,过往的RAG相关综述是非多模态的

Ask in Any Modality: A Comprehensive Survey on Multimodal Retrieval-Augmented Generationhttps://arxiv.org/abs/2502.08826https://github.com/llm-lab-org/Multimodal-RAG-Survey

(文:PaperAgent)