DeepSeek 在保证服务质量的同时,实现了极高的成本效益:

-

硬件配置:所有服务使用 H800 GPU,保持与训练一致的FP8/BF16精度 -

动态资源调度:根据白天/夜间负载差异动态调整节点数量,最大化资源利用率 -

成本数据:24 小时内平均使用 226.75 个节点(每节点8个H800),成本约 $87,072/天 -

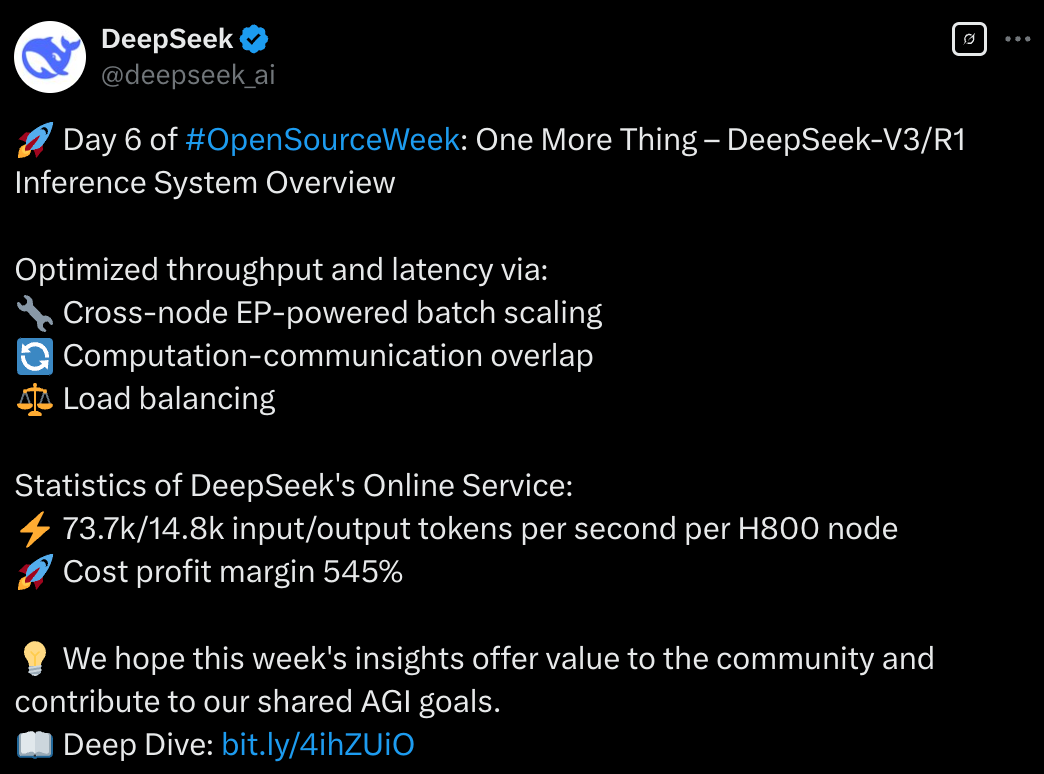

吞吐能力:每台 H800的 prefill 吞吐约 73.7k tokens/s,decode 吞吐约 14.8k tokens/s -

利润率:按 DeepSeek R1 定价计算,理论日收入$562,027,成本利润率 545%

-

准备阶段(Prefill):类似于餐前准备,需要 4 个分店协作,每个厨房有 9+1 名厨师 -

出餐阶段(Decode):类似于快速出餐,需要 18 个分店协作,每个厨房有 2+1名 厨师

-

确保每个厨房处理的订单数量和复杂度相近 -

合理分配热门菜的厨师数量,避免某些特色菜(热门专家)导致部分厨房超负荷 -

动态调整各分店的顾客分配,使得所有厨师的工作量和食材配送量尽可能平衡

Day 2️⃣:降本增效神器,榨干每一块 GPU

Day 3️⃣:300 行代码揭示 V3/R1 推理效率

Day 4️⃣:梁文锋亲自写的代码长什么样?

Day 5️⃣:开源周最后一天,重塑 AI 训练底层逻辑

(文:APPSO)