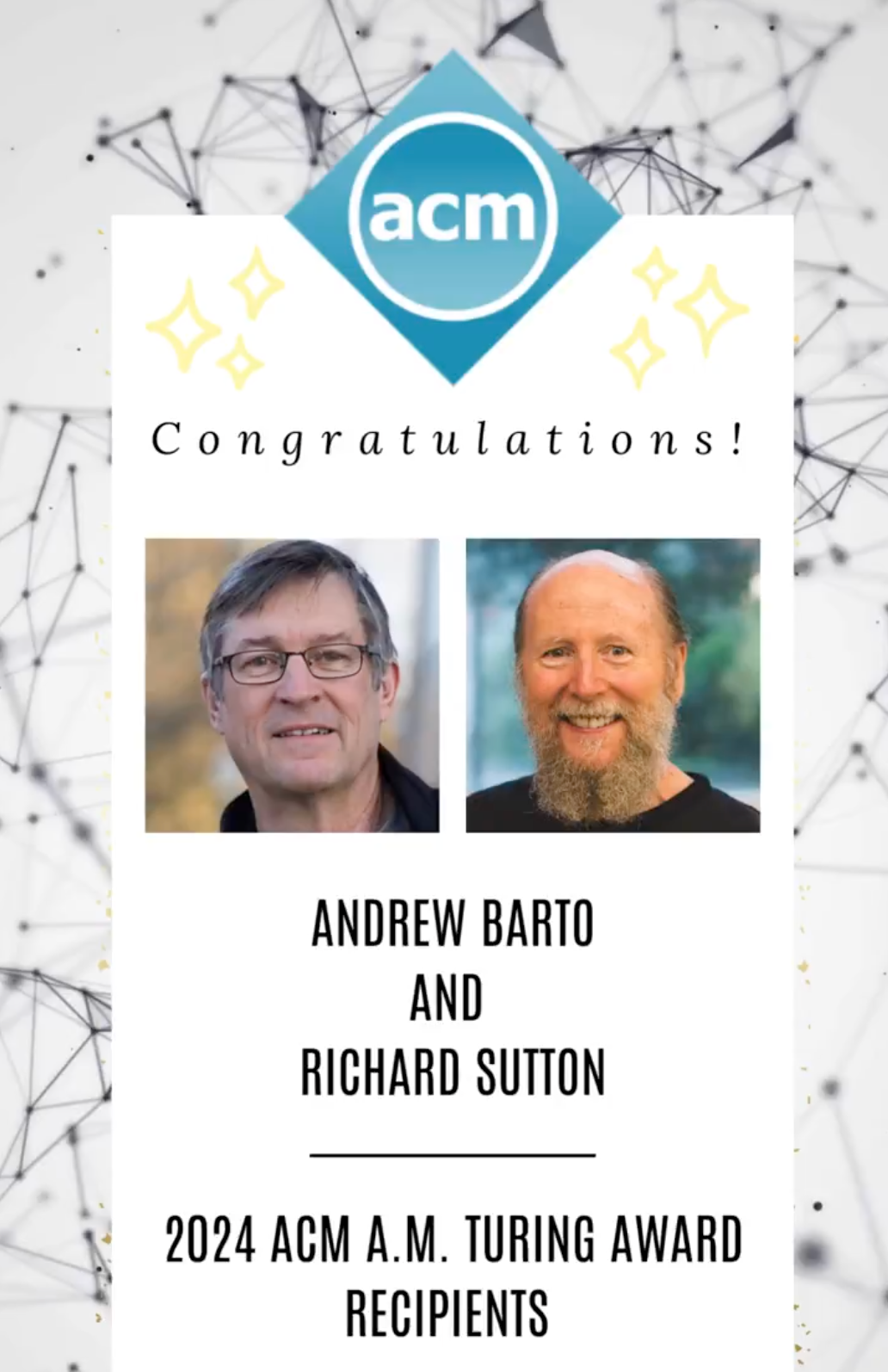

重磅消息!“计算机科学界诺贝尔奖”的 ACM图灵奖,刚刚揭晓了2024年的得主!

🎉🎉🎉 Andrew Barto 和 Richard Sutton 两位大神,因在 强化学习(Reinforcement Learning, RL) 领域的奠基性贡献,共同荣获此殊荣!

划重点: 这两位大佬,正是强化学习 这项AI核心技术的先驱和奠基人!想想看,近年来火爆全网的 AlphaGo 战胜人类围棋冠军,再到 ChatGPT 横空出世,背后都离不开强化学习的强大支撑!可以说,Barto 和 Sutton 两位教授,绝对是当之无愧的幕后英雄!

什么是强化学习?

可能有些小伙伴对“强化学习”这个词还不太熟悉,这就来给大家科普一下:

简单来说,强化学习 就像训练小动物一样,通过 奖励 和 惩罚 来引导 智能体 学习,让它在与环境的互动中不断试错、改进,最终学会完成特定任务。

-

• 智能体 (Agent): 可以理解为我们想要训练的AI程序,比如下棋的AI、聊天机器人等。 -

• 环境 (Environment): 智能体所处的世界,比如棋盘、互联网等。 -

• 奖励 (Reward): 智能体做得好时得到的正向反馈,比如下棋赢了、对话流畅等。

想象一下,你教小狗坐下,做对了就给它零食,做错了就口头制止。强化学习的原理与之类似,只不过对象变成了AI,奖励和惩罚也变成了计算机可以理解的信号。

别小看这个简单的概念! 强化学习可是人工智能领域的一颗璀璨明珠,它赋予了机器像人类一样从经验中学习的能力,无需人为编写复杂的规则,就能让AI在复杂多变的环境中自主决策、不断进步。

两位大神,奠定RL基石!

Barto 和 Sutton 两位教授,早在上世纪80年代就开始潜心研究强化学习。他们:

-

• 构建理论框架: 将心理学和神经科学的洞见融入计算机科学,提出了强化学习的通用问题框架。 -

• 奠定数学基础: 利用马尔可夫决策过程 (MDPs) 等数学工具,为强化学习建立了坚实的理论基础。 -

• 开发核心算法: 发明了 时间差分学习 (Temporal Difference Learning) 等一系列关键算法,解决了奖励预测等核心难题。 -

• 著书立说,影响深远: 他们1998年出版的经典教材 《Reinforcement Learning: An Introduction》 至今仍是该领域的圣经,被引用超过75000次,培养了无数RL研究人才!

可以说,没有Barto 和 Sutton 两位教授的早期开拓和深耕,就没有今天强化学习的蓬勃发展,更不会有AlphaGo、ChatGPT等一系列AI奇迹的诞生!

RL应用遍地开花

虽然强化学习理论早在几十年前就已提出,但真正迎来爆发式发展还是近十几年的事情。特别是当它与 深度学习 技术结合后,诞生了 深度强化学习 (Deep Reinforcement Learning) 这一强大武器,彻底打通了RL的应用之路。

如今,强化学习已经渗透到我们生活的方方面面:

-

• 游戏AI: AlphaGo、星际争霸AI,都是RL的杰作。 -

• 聊天机器人: ChatGPT 的训练也用到了 人类反馈强化学习 (RLHF) 技术。 -

• 机器人控制: 让机器人学会复杂的操作,比如玩魔方、抓取物体。 -

• 工业优化: 网络拥塞控制、芯片设计、供应链优化,都能看到RL的身影。 -

• 科学研究: 甚至在神经科学领域,RL算法也被用来解释人脑中的多巴胺系统!

正如 ACM 主席 Yannis Ioannidis 所说,Barto 和 Sutton 的工作 “展示了多学科方法解决长期挑战的巨大潜力”。 谷歌高级副总裁 Jeff Dean 也表示,强化学习 “直接回应了图灵的挑战”,是 “过去几十年人工智能进步的基石”。

两位大师实至名归! 他们的贡献不仅推动了人工智能技术的飞速发展,也为我们理解智能的本质提供了新的视角

今年DeepSeek R1,OpenAI o1到o3,等一系列模型都是强化学习的突破才有的推理模型,而且强化学习的强大能力还有待挖掘,接下来让我拭目以待DeepSeek R2,😄

参考:

https://www.acm.org/media-center/2025/march/turing-award-2024

⭐

(文:AI寒武纪)