跳至内容

昨日,腾讯科技发布了一篇题为《AI 视频的后 Sora 时代》的文章,里面详细介绍了 AI 视频技术的发展以及各家的产品和发展历程。

回望这近一年的发展,未免有些吊诡而又有些欣慰。吊诡的是,当初点燃这把火的 Sora,至今不支持公开访问。欣慰的是,这几个月里,我们见证了许多国内的优秀团队在国际上,在 AI 视频生成领域,做出的卓越贡献。

是他们对模型技术的开源,以及产品的公开访问和快速迭代,让我们切实感受到 AI 视频并非空中楼阁,也非洪水猛兽,更具象地体会到 AIGC 技术的魅力。

而就在今天,腾讯混元也给予了我们一个惊喜,发布了其视频生成大模型,并直接开源。

前两天我们非常荣幸拿到了内测资格,虽然生成视频长度才五秒,但视频包含的信息量和质量都有些出乎意料,实际测试下来有以下几个印象深刻的点。

混元模型生成的视频内容具备高清质感、真实感。在我们的测试过程中,身边的同事瞄到我的屏幕误以为我在追剧…(绷不住了,我上班怎么可能摸鱼嘛)

之前使用一些模型,即使我耐心地按照“主体+场景+运动 + (风格表达) + (氛围描述) + (运镜方式) + (光线) + (景别)”这样的格式详细清楚地表达我的需求,但得到的结果跟我预想的相似性很低,而混元就像别人家的孩子,“听话”还表现优异。

一开始测试的时候,总觉得混元很有灵性,但那种感觉很难描述出来。测试多了之后才发现,原来模型原生具备自动生成多视角同主体的镜头切换画面。

此外,我们发现部分内测的创作者已经基于混元视频生成模型,做出了优秀的短视频作品。

那混元是如何实现如此效果,异军突起的呢?我们向资深创作者以及混元官方请教后,得出了三个原因。

这一创新赋予了模型强大的语义跟随能力,使其能够轻松应对多主体的复杂场景描述。相较于行业内普遍采用的上一代语言模型,混元视频生成模型通过适配最新一代大语言模型 MLLM(Multimodal Large Language Model),在处理文本和理解文字方面展现出了卓越的能力,更好地应对了多主体描绘的需求,实现了更精细的指令和画面呈现。

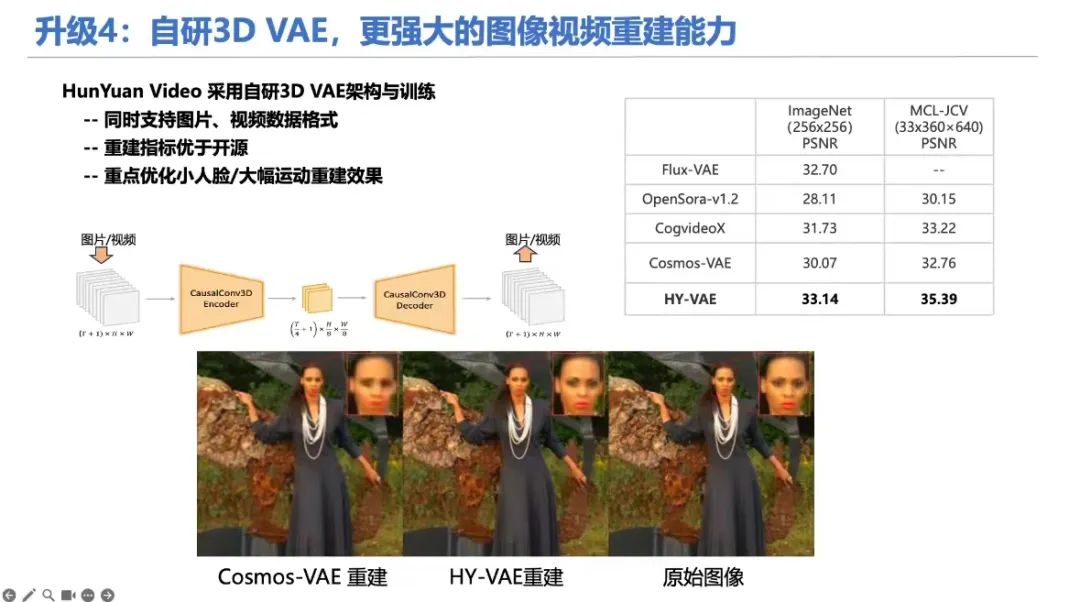

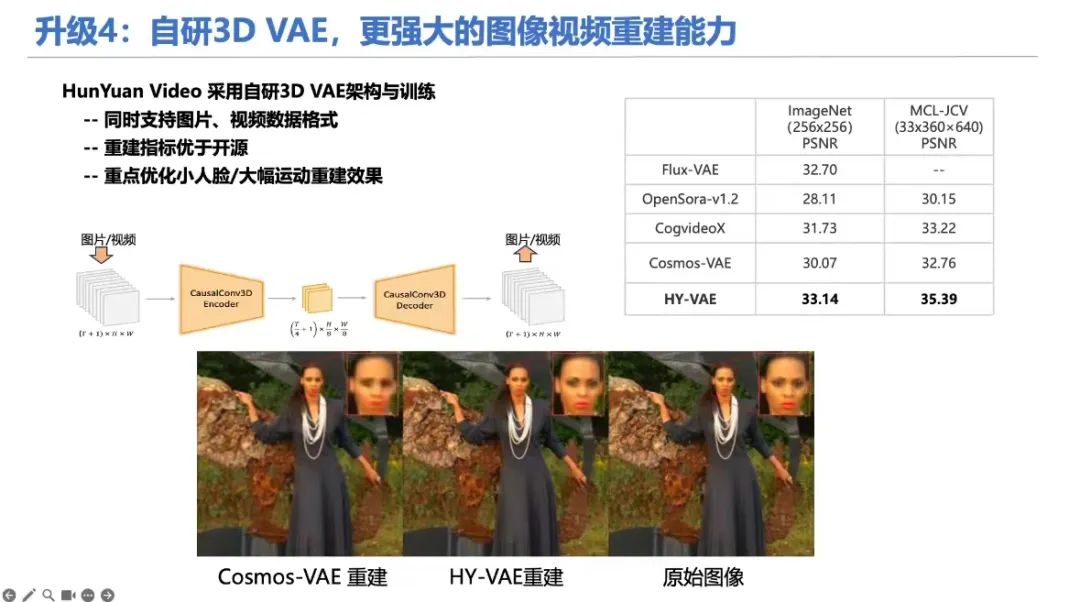

2. 自研 3D 视觉编码器,支持混合图片和视频训练/先进的图像视频混合 VAE(3D 变分编码器)。

这一技术特别适用于混合图片和视频训练场景,优化了编码器训练算法,大幅提升了在快速运行和纹理细节压缩重建方面的表现。结果表明,视频生成模型在细节呈现上,尤其是在小人脸和高速动作场景中,实现了质的飞跃。

3. 从头到尾均使用 full attention(全注意力)的机制。

这种机制使得视频的每一帧都能实现无缝衔接,并能够保持主体在多视角镜头切换中的连贯性。与那些依赖于分离的时空注意力机制的模型相比,全注意力机制更像是一个纯粹的视频处理模型,它在视频流畅性和主体一致性方面展现出了更卓越的性能。

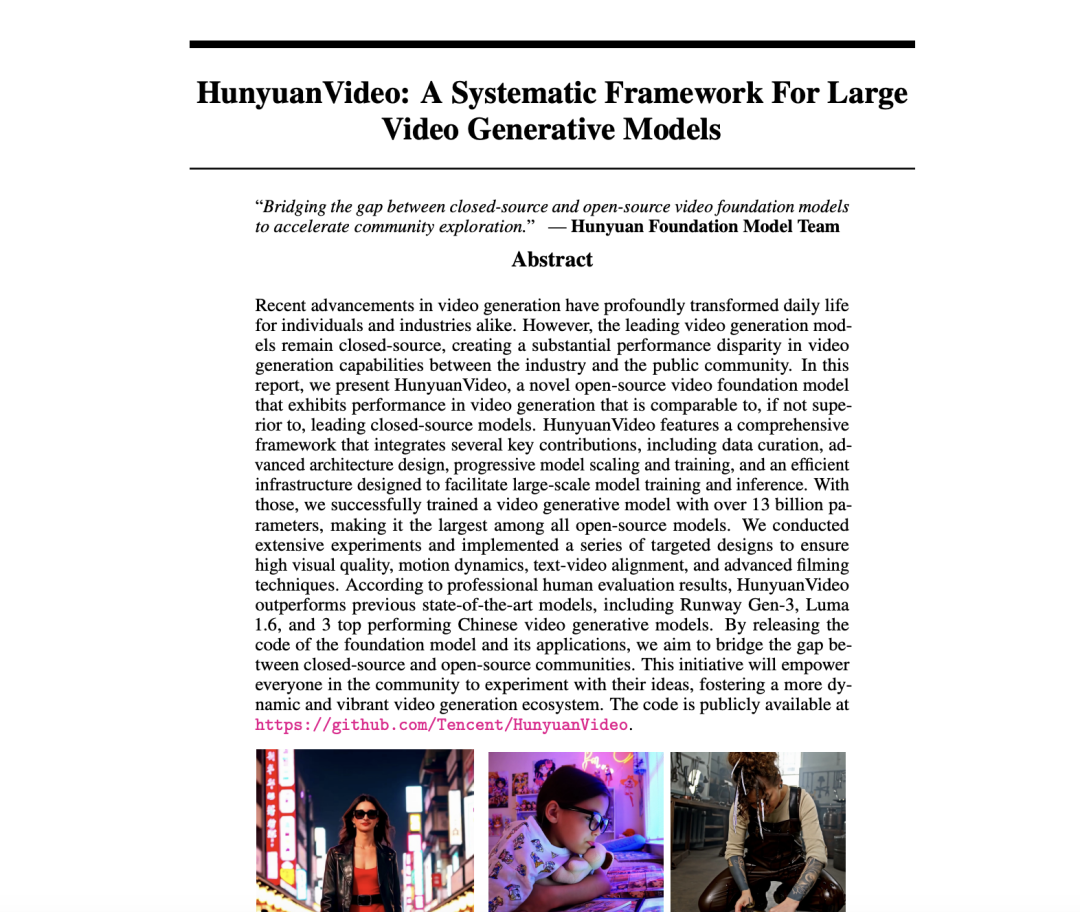

此外据官方报道,腾讯还将此视频生成大模型进行了开源,包含模型权重、推理代码、模型算法等完整模型,可供企业与个人开发者免费使用和开发生态插件。总参数量达 130 亿,还是当前最大的视频开源模型。

官网:https://aivideo.hunyuan.tencent.com

代码:https://github.com/Tencent/HunyuanVideo

模型:https://huggingface.co/tencent/HunyuanVideo

在与国内外的多个顶尖模型的评测对比中,混元视频生成模型在文本视频一致性、运动质量和画面质量多个维度效果领先,并且在人物、人造场所等场景下表现尤为出色!

那么快快去腾讯元宝 APP 中提交申请试用!BTW,企业客户可以通过腾讯云提供服务接入,目前 API 同步开放内测申请~

(文:特工宇宙)