最强AI推理模型评分终于诞生了!

关键结论

-

发布版o3,尤其是medium和high模式,在能力方面更像o3-preview而非o1

-

在不考虑超时的情况下,应该默认使用o3 (high)。如果遇到超时,则使用medium。如果你关心准确率,没有令人信服的理由使用low模式

-

ARC-AGI v1仍然是了解前沿AI系统的有用工具。v1任务仍然能「压榨」这些系统,揭示其效率和能力限制

-

ARC-AGI v2还有很长的路要走,即使有o3出色的推理效率,也需要新的想法!

ARC Prize终于公布了o3模型在ARC-AGI测试中的表现,结果虽在预期之中但仍让人惊叹:

o3 (medium)以绝对优势成为行业领先的AI推理系统!

与下一个最强的链式思考系统相比,它不仅得分翻了一倍,成本还只有其1/20。

在ARC-AGI v1半私有集上得分为53%,每个任务仅需1.5美元。

但在更困难的v2测试集上,o3 (medium)只能达到2.9%的得分,每个任务成本为2.5美元。

至于o3 (high)的完整数据?

他们根本测不完!

不到一半的任务能够返回结果,直接耗尽了超过5万美元的测试预算。他们真的尽力了!

o3到底是个什么怪物?

去年12月,Mike Knoop在测试o3-preview时就表示:

「你对AI能力的直觉需要更新了」。

所以,现在正式发布的o3到底是怎样的存在?

它更像o1(在新任务上略优于纯LLM)?

还是更像o3-preview(具备超出训练数据的全新解题能力)?

测试数据表明,o3 (medium)保留了o3-preview的大部分质变能力,但成本大幅降低。

虽然o3 (medium)的准确率严格来说低于o3-preview(后者在每任务200美元的成本下达到76%),但OpenAI在优化o3的准确率和成本方面做得极其出色。

目前,你无法在其他地方购买到o3这样的AI推理能力。

(题外话,还会有一个即将推出的o3-pro,这可能会更接近o3-preview的高性能和低效率特性。)

不止是简单的自回归思维链

o3 (medium)在ARC-AGI v1上的表现如此出色,而成本却又如此低廉,这很难用纯自回归CoT系统(如o1)来解释。

数据显示,这里面肯定有更多门道。

虽然o3肯定没有像o3-preview那样进行大规模、缓慢、昂贵的并行采样,但有证据表明o3的准确率不仅仅是模型和思考token数量(「思考时间」)的函数。

还有一个额外的X因素:

task_success = f(model, thinking_tokens, x_factor)

支持这一点的证据包括:

-

o3在低、中、高三种模式下的tokens/sec很一致,表明没有重大的模型变化(不像o3/o4-mini,o1-pro有明显的tokens/sec差异)

-

在任意思考tokens截止点,o3 (high)的v1成功率严格优于medium,而medium又严格优于low

那么,这个X因素到底是什么?

可能的解释有很多:

-

可能是像o3-preview那样一致的并行CoT步骤采样;

-

可能是一个变化的「评分器」模型;

-

可能是一个激活不同头的MoE;或者完全是其他东西。

Mike Knoop认为o3的low/medium/high模式可能是沿着CoT的宽度和深度进行推理扩展,这使得它能够强力重组来自基础模型训练的知识。

深入分析模型表现

ARC Prize Foundation对o3和o4-mini的分析表明:

o3 (low)在ARC-AGI-1半私有评估集上得分41%,o3 (medium)达到53%。但在更困难的ARC-AGI-2上,两者都不超过3%。

至于o4-mini,low版本在ARC-AGI-1半私有评估集上得分21%,medium版本达到41%,效率达到了业界领先水平。

同样,在更困难的ARC-AGI-2集上,两者得分都低于3%。

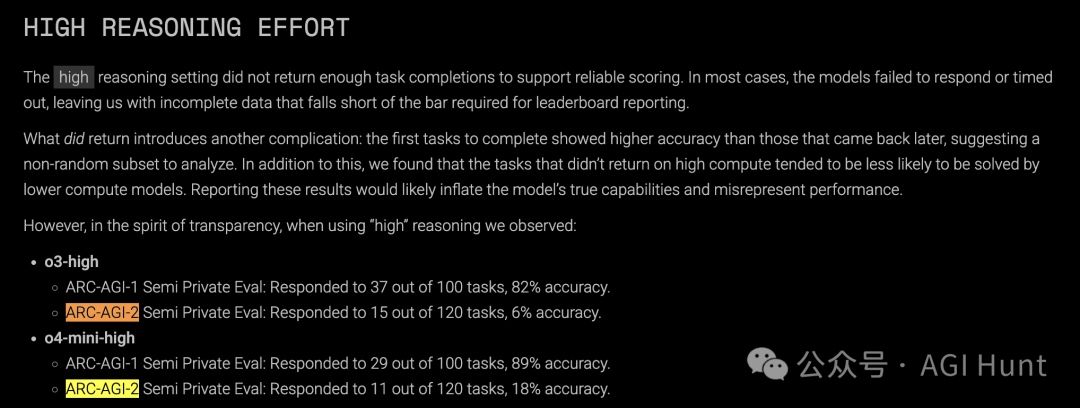

当使用「high」推理设置时,两个模型经常无法返回输出或超时。

这使得排行榜报告变得不可靠。

Mike Knoop(@mikeknoop)在随后的推文中更正了一个小数据错误:o3 (medium)在v1半私有集上的得分应为53%,而非57%。

这是因为有7个任务反复超时,被算作未完成。

他表示:

「我从早期数据中提取了我的帖子,在我们做出决定之前就发布了,并为错误报告道歉。」

测试过程中的关键发现

1. 早期响应显示更高准确率

研究团队注意到,模型更快返回的任务准确率更高。

那些耗时更长或使用更多token的任务更可能失败。这表明模型在CoT过程早期就能对更简单的任务得出结论或有更高的信心。

2. 更高推理可能效率低下

比较o3-medium和o3-high在相同任务上的表现时,他们发现o3-high一致地使用更多token来得出相同的答案。

这突显了一个关键权衡:在简单任务上,o3-high通常不会提高准确率,但会增加成本。

3. tokens/second的最小方差

o3-mini-low和o4-mini-low有比它们的medium和high对应版本更高的吞吐量(tok/s)。

这表明迷你模型可能在算法上存在差异。

对比o3-preview与o3

OpenAI正式确认,这个公开的o3模型与去年12月测试的o3-preview不同:

-

模型差异:生产版o3使用与o3-preview不同的模型

-

多模态能力:o3-preview仅支持文本,而生产版o3整合了视觉输入

-

计算约束:o3-preview可用的测试时计算在生产版o3中不可用

-

训练数据:o3-preview包含75%的ARC-AGI-1数据集用于训练

-

产品优化:公开版o3经过了聊天和产品应用的微调

虽然近期有所进步,但ARC-AGI-2仍未被最佳版本的o3所解决,得分低于3%。

Franck SN(@ndzfs)在回复中指出:

「从ARC-AGI-1到ARC-AGI-2的大幅下降表明,当前模型泛化能力有限,过度专注于ARC-AGI-1中见到的模式,而非展示真正的通用智能。当模型打败ARC-AGI-2但不敌ARC-AGI-3时,也会是同样的情况。」

AI Pro Workflow则评论称:

「效率和能力方面的差距使o3 (medium)成为严肃推理任务的当前ROI之王。你可以在曲线中看到智能工程——每个token的性能令人难以置信。不过,ARC v2仍然让所有人谦卑。下一次飞跃需要的不仅仅是规模扩大。」

测试结果让我们看到了AI推理能力的惊人进步,也为未来的发展指明了方向。

Permaximum Judicium(@permaximum88)猜测o3的结果可能是数据泄露和计算的结合,而Carlos Tecnico(@FutbolmeAI)则表示:

「o3 medium在ARC-AGI-1上以每任务1.5美元达到57%?他们完美掌握了成本-准确率平衡——优化真的令人印象深刻。」

测试报告见:

https://arcprize.org/blog/analyzing-o3-with-arc-agi

(文:AGI Hunt)