在人工智与3D技术融合的浪潮中,3D内容生成领域迎来了重大突破。传统的3D建模需要专业的知识和大量的时间,而新兴的AI驱动的3D生成技术正在改变这一局面。阿里巴巴通义实验室最近开源的LHM(Large Animatable Human Reconstruction Model)项目,专注于从单张图像快速生成可动画化的3D人体模型,为3D内容创作提供了全新的解决方案。本文将详细介绍LHM项目的背景、技术特点、核心功能、应用场景以及如何快速使用该模型。

一、项目概述

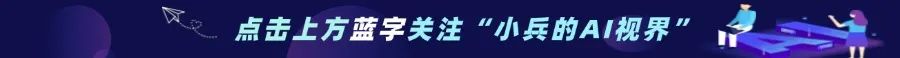

LHM是由阿里巴巴通义实验室推出的从单张图像重建可动画化3D人体模型的开源项目。基于多模态Transformer架构,融合3D几何特征和2D图像特征,LHM能够快速生成高质量的可动画化3D人体模型,适用于AR/VR等沉浸式应用。该模型在几秒钟内即可完成从单张图像到3D可动画化模型的转换,无需复杂的后处理。

二、技术原理

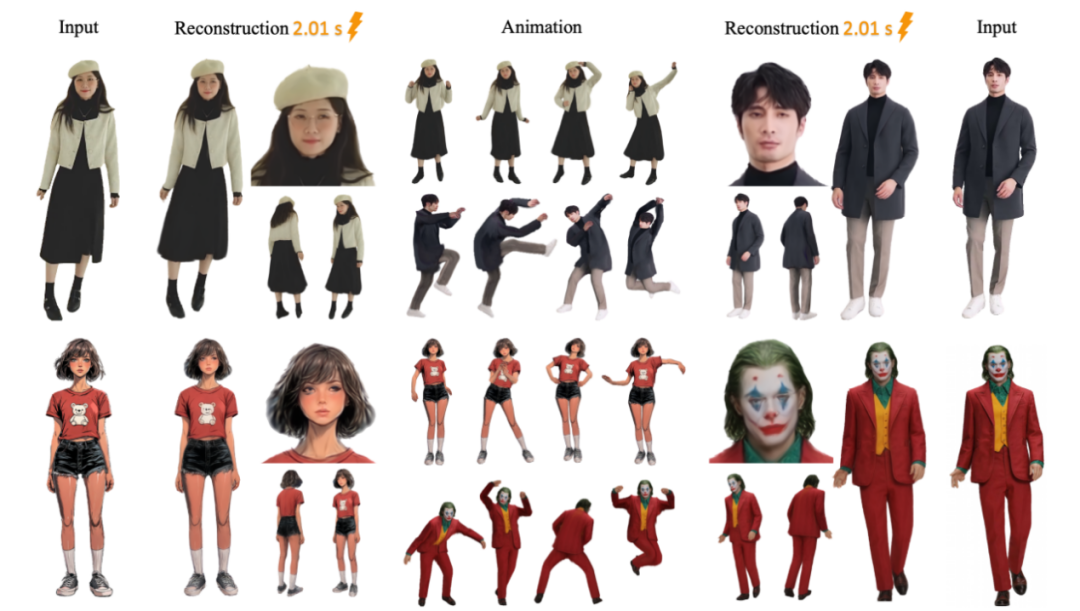

(一)多模态Transformer架构

LHM基于多模态Transformer架构,融合3D几何特征(从SMPL-X模板采样得到的表面点)和2D图像特征(从预训练的视觉Transformer提取),有效处理几何和视觉信息。针对头部区域设计的多尺度特征提取方案,聚合不同层次的特征增强面部细节的恢复能力。

(二)3D高斯点云表示

LHM采用3D高斯点云(Gaussian Splatting)形式表示3D模型,支持实时、高质量的渲染。网络直接预测高斯点云的参数(如位置、旋转、缩放、颜色等),实现从输入图像到3D模型的快速转换。

(三)自监督学习

LHM基于大规模视频数据进行训练,用渲染损失和正则化项优化模型,无需依赖稀缺的3D扫描数据。在训练过程中,引入“尽可能接近”(as close as possible)和“尽可能接近球形”(as spherical as possible)的正则化项,保持3D模型的几何合理性。

(四)实时动画支持

LHM基于SMPL-X骨架参数将重建的3D模型变形到目标姿态,支持实时姿态控制动画。整个重建和动画化过程在单次前向传播中完成,适合实时应用。

三、核心功能

(一)输入灵活

LHM支持从单张图像、双目视频、RGB视频、3D扫描数据和文本提示等多种输入形式生成3D人体模型,提供了极大的灵活性。

(二)高保真细节

LHM精确保留服装纹理、面部细节等关键信息,生成高质量的3D模型。其多模态Body-Head Transformer(MBHT)设计,精确捕捉服装褶皱和面部特征,生成的模型具有极高的细节保真度。

(三)快速重建

LHM在几秒钟内即可完成从单张图像到3D可动画化模型的转换,无需复杂的后处理。在A100 GPU上,单次重建仅需0.2秒,这种快速重建能力为实时应用提供了可能。

(四)实时动画

LHM支持基于姿态控制的实时动画渲染,适用于沉浸式应用(如AR/VR)。生成的模型可以实时变形到目标姿态,支持动态姿势控制和动作序列,为用户提供更自然、流畅的动画效果。

(五)多场景支持

LHM在开放环境(in-the-wild images)上表现出色,适应多种场景和姿态。无论是在室内还是室外,无论是静止还是动态姿态,LHM都能生成高质量的可动画化3D模型。

(六)多样化输出

LHM支持将生成的3D人体模型以多种格式输出,包括GAUSSIAN、OBJ、GLB和视频等。用户可以根据需求选择合适的输出格式,方便地将模型集成到不同的应用场景中。

四、应用场景

(一)虚拟现实(VR)和增强现实(AR)

LHM可以快速将照片转化为可动画化的3D虚拟角色,增强沉浸感和交互性。例如,在虚拟会议中,用户可以生成自己的3D虚拟形象参与会议;在虚拟旅游中,用户可以生成虚拟角色探索虚拟世界。它与VR设备结合,生成的数字人可进入虚拟世界与玩家交互,适用于社交元宇宙、沉浸式教育与模拟训练等XR场景。

(二)游戏开发

LHM快速生成高质量3D角色模型,支持实时动画,提升开发效率和游戏体验。游戏开发者可以利用LHM快速创建游戏角色,减少建模时间,提高生产效率。生成的3D模型可以无缝集成到游戏引擎中,如Unity和Unreal Engine,用于游戏中的角色动画和交互。

(三)影视制作

LHM用于特效制作和动画电影,快速生成角色模型,提升制作效率和质量。通过LHM生成的3D模型可以作为影视特效的基础素材,进行进一步的动画制作和渲染,节省大量的人力和时间成本。

(四)社交媒体和内容创作

用户可以使用LHM生成3D虚拟形象用于社交媒体,创作者可以快速生成3D角色用于短视频、直播等。例如,用户可以生成自己的3D虚拟形象用于虚拟直播,吸引更多的观众和粉丝。创作者可以利用LHM生成的3D角色制作高质量的短视频内容,提升创作效率和作品质量。

(五)教育和培训

LHM可以创建虚拟教师或助教用于在线教育,生成3D模型用于医疗、军事等领域的模拟训练。在医学教育中,LHM生成的3D人体模型可以用于解剖学教学和手术模拟训练;在军事训练中,LHM生成的3D模型可以用于战术演练和模拟作战场景。

(六)医疗康复

LHM生成的3D人体模型可以用于医疗康复领域,帮助医生和康复师更好地了解患者的肢体运动情况,制定个性化的康复计划。通过LHM生成的3D模型,医生可以实时观察患者的肢体运动轨迹,评估康复效果,调整治疗方案。

示例一:

五、快速使用

(一)环境搭建

1. 克隆项目仓库

git clone https://github.com/aigc3d/LHM.gitcd LHM

2. 安装依赖

CUDA 11.8 环境:

sh ./install_cu118.shpip install rembg

CUDA 12.1 环境:

sh ./install_cu121.shpip install rembg

(二)模型下载

模型权重会自动下载,但你也可以手动下载以节省时间。以下是手动下载模型权重的步骤:

1. 从HuggingFace下载

from huggingface_hub import snapshot_download# 下载 LHM-MINI 模型model_dir = snapshot_download(repo_id='3DAIGC/LHM-MINI', cache_dir='./pretrained_models/huggingface')# 下载 LHM-500M-HF 模型model_dir = snapshot_download(repo_id='3DAIGC/LHM-500M-HF', cache_dir='./pretrained_models/huggingface')# 下载 LHM-1B-HF 模型model_dir = snapshot_download(repo_id='3DAIGC/LHM-1B-HF', cache_dir='./pretrained_models/huggingface')

2. 从 ModelScope 下载

from modelscope import snapshot_download# 下载 LHM-MINI 模型model_dir = snapshot_download(model_id='Damo_XR_Lab/LHM-MINI', cache_dir='./pretrained_models')# 下载 LHM-500M-HF 模型model_dir = snapshot_download(model_id='Damo_XR_Lab/LHM-500M-HF', cache_dir='./pretrained_models')# 下载 LHM-1B-HF 模型model_dir = snapshot_download(model_id='Damo_XR_Lab/LHM-1B-HF', cache_dir='./pretrained_models')

(三)本地运行Gradio推理界面

目前支持用户运动序列输入。由于姿态估计器需要一些GPU 内存,此 Gradio 应用程序运行 LHM-500M 至少需要 24GB 的 GPU 内存。

# 内存优化版本;运行时间会更长,但对 GPU 内存要求较低。# 对于 720P 视频,支持的最大长度为 20 秒。python ./app_motion_ms.py # 使用默认模型(LHM-500M-HF)运行 Gradio 推理界面python ./app_motion_ms.py --model_name LHM-1B-HF # 指定使用 LHM-1B-HF 模型运行 Gradio 推理界面# 支持用户自定义运动序列输入。由于姿态估计器需要占用一定量的 GPU 内存,因此此 Gradio 应用程序至少需要 24GB 的 GPU 内存来运行 LHM-500M。python ./app_motion.py # 使用默认模型(LHM-500M)运行 Gradio 推理界面python ./app_motion.py --model_name LHM-1B-HF # 指定使用 LHM-1B-HF 模型运行 Gradio 推理界面# 对视频序列进行预处理python ./app.py # 使用默认模型(LHM-500M)运行 Gradio 推理界面python ./app.py --model_name LHM-1B # 指定使用 LHM-1B 模型运行 Gradio 推理界面

(四)本地直接推理

定义模型名称,可选值有:LHM-500M-HF、LHM-500M、LHM-1B、LHM-1B-HFMODEL_NAME={LHM-500M-HF, LHM-500M, LHM-1B, LHM-1B-HF}示例:bash ./inference.sh LHM-500M-HF ./train_data/example_imgs/ ./train_data/motion_video/mimo1/smplx_paramsbash ./inference.sh LHM-500M ./train_data/example_imgs/ ./train_data/motion_video/mimo1/smplx_paramsbash ./inference.sh LHM-1B ./train_data/example_imgs/ ./train_data/motion_video/mimo1/smplx_params# 运行推理脚本,生成动画bash inference.sh ${MODEL_NAME} ${IMAGE_PATH_OR_FOLDER} ${MOTION_SEQ}# export meshbash ./inference_mesh.sh ${MODEL_NAME}

更多详细信息和高级用法,请参考 GitHub 仓库。

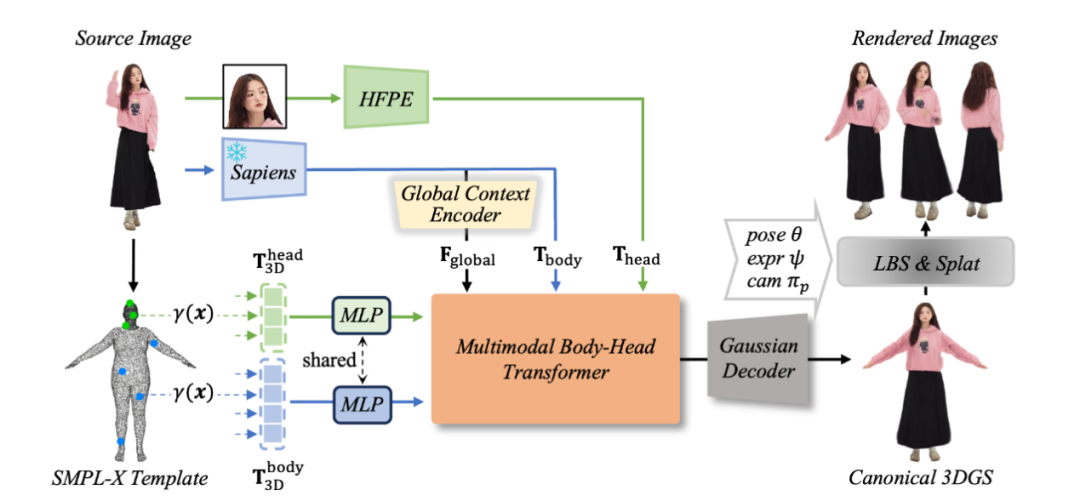

(五)在线体验

LHM还提供了在线体验Demo,用户可以通过HuggingFace或魔搭社区直接上传图片生成3D模型。在线体验地址:https://huggingface.co/spaces/DyrusQZ/LHM

六、结语

LHM作为阿里巴巴通义实验室开源的3D人体重建模型,通过多模态Transformer架构和3D高斯点云表示,实现了从单张图像到高质量可动画化3D模型的快速转换。其在虚拟现实、游戏开发、影视制作等多个领域的广泛应用前景,预示着3D建模技术的新纪元。随着项目的不断发展和优化,LHM将成为更多开发者的重要工具。

七、项目地址

项目官网:https://lingtengqiu.github.io/LHM

GitHub仓库:https://github.com/aigc3d/LHM

技术论文:https://arxiv.org/pdf/2503.10625

在线体验:https://huggingface.co/spaces/DyrusQZ/LHM

(文:小兵的AI视界)