今天凌晨,大模型领域最受关注的重磅消息来自阿里 Qwen 团队——他们正式发布了备受期待的全新 Qwen3 系列大模型。

不同于以往,这次其一次性开源了多达 8 款混合推理模型,在性能上全面逼近 OpenAI、Google 等闭源大模型,以及超越了开源大模型 DeepSeek R1,堪称当前最强的开源模型之一,也难怪昨晚 Qwen 团队一直在加班。

8 大模型齐发!

这 8 款混合推理模型中,包括了 2 个 MOE 模型:Qwen3-235B-A22B 和 Qwen3-30B-A3B。

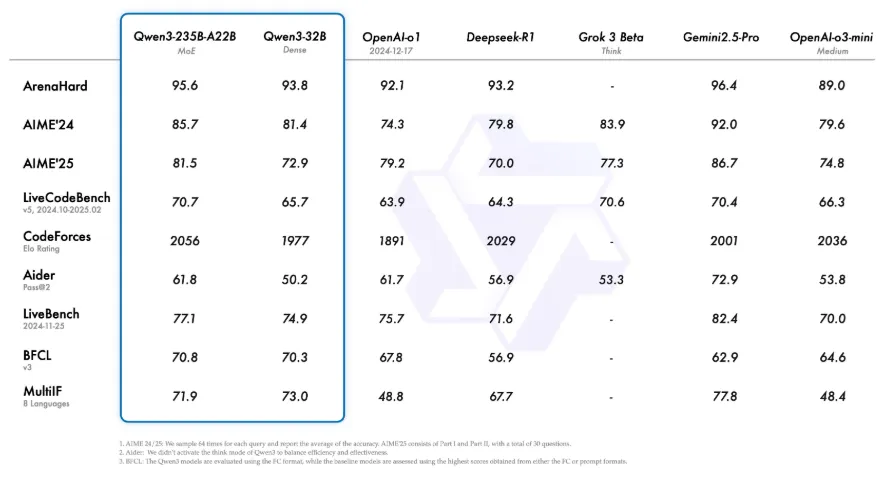

其中,Qwen3-235B-A22B 是本次发布中规模最大的旗舰模型,拥有 2350 亿个参数,激活参数超过 220 亿。

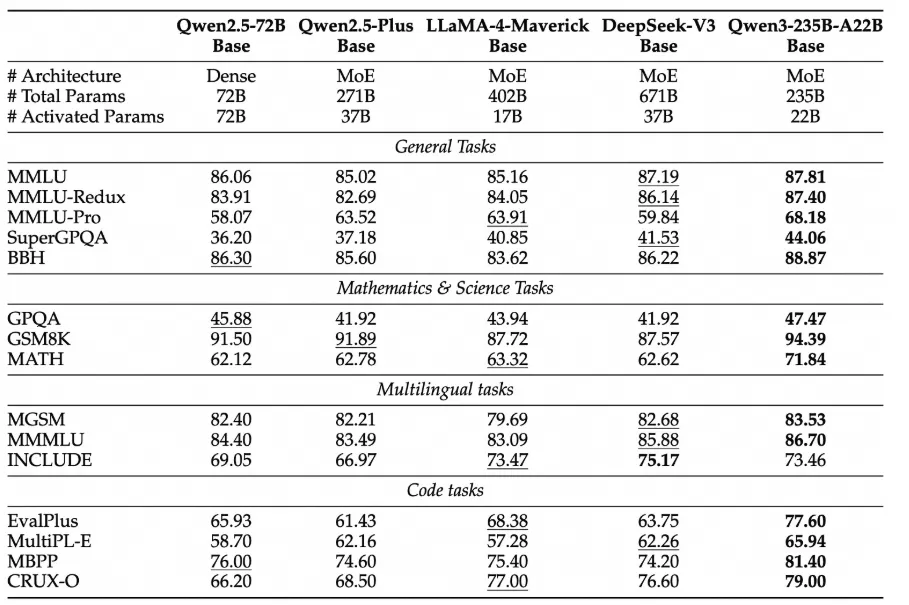

在代码、数学和通用能力等多个基准测试中,它的表现不仅超过了 DeepSeek 的 R1 开源模型,还优于 OpenAI 的闭源模型 o1。尤其在软件工程和数学领域的 ArenaHard 测试(共 500 道题)中,成绩甚至接近了 Google 最新发布的 Gemini 2.5-Pro,可见其实力不容小觑。

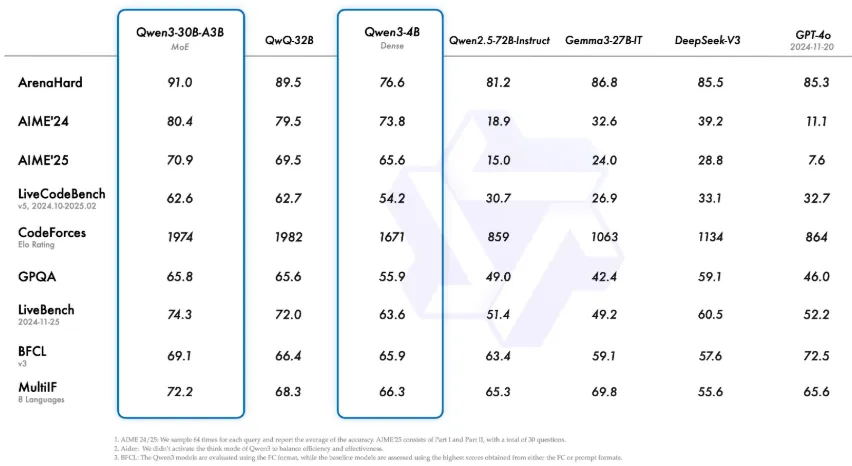

另一个 MOE 模型 Qwen3-30B-A3B 拥有 300 亿总参数,激活参数仅为 QwQ-32B 的 10%,约 30 亿,但实际表现却更胜一筹。甚至像 Qwen3-4B 这样的小模型,也能达到 Qwen2.5-72B-Instruct 的水平。

除了上述两款 MOE 模型,此次还发布了 6 款 Dense 模型,分别是:Qwen3-32B、Qwen3-14B、Qwen3-8B、Qwen3-4B、Qwen3-1.7B 和 Qwen3-0.6B。这些模型在规模和结构上各不相同,方便用户根据具体需求和计算资源进行选择。

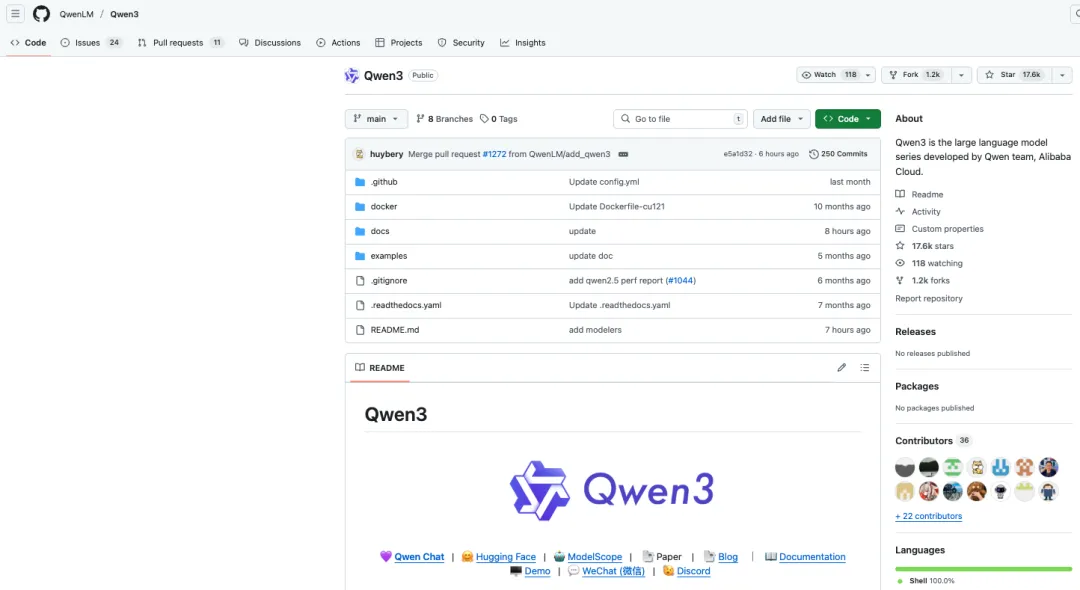

以上所有模型均在 Apache 2.0 许可协议下开源,对开发者和研究者开放。

国内首个混合推理模型来了

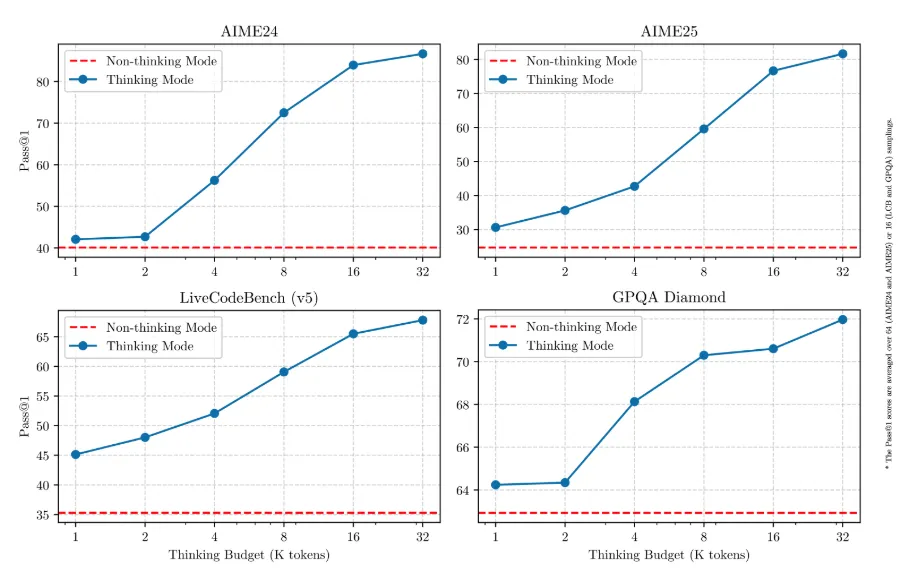

从能力上来看,Qwen3 系列模型经过特别训练,支持两种“思考模式”:快思考和慢思考,用官方的话就是“思考模式”和“非思考模式”。

-

思考模式:在这种模式下,模型会逐步推理,经过深思熟虑后给出最终答案。这种方法非常适合需要深入思考的复杂问题。

-

非思考模式:在此模式中,模型提供快速、近乎即时的响应,适用于那些对速度要求高于深度的简单问题。

正因此,Qwen3 是国内首个混合推理模型。

简单来说,就是 Qwen3 可以根据问题的难度,选择是快速给出答案,还是花更多时间进行更深层次的分析和推理。比如遇到一些复杂的数学、科学或工程类问题时,你可以切换到“深度思考模式”,让模型用更强的推理能力来处理问题。

Qwen 团队在技术报告中解释道,“Qwen3 展现出可扩展且平滑的性能提升,这与分配的计算推理预算直接相关。这样的设计让用户能够更轻松地为不同任务配置特定的预算,在成本效益和推理质量之间实现更优的平衡。”

使用方法也很简单:在 Qwen Chat 网站 上,有一个专门的按钮可以切换“思考模式”;如果你是在本地部署或者通过 API 使用模型,也可以通过输入指令,比如 /think 或 /no_think,自由切换不同模式,让模型根据任务难度灵活应对。

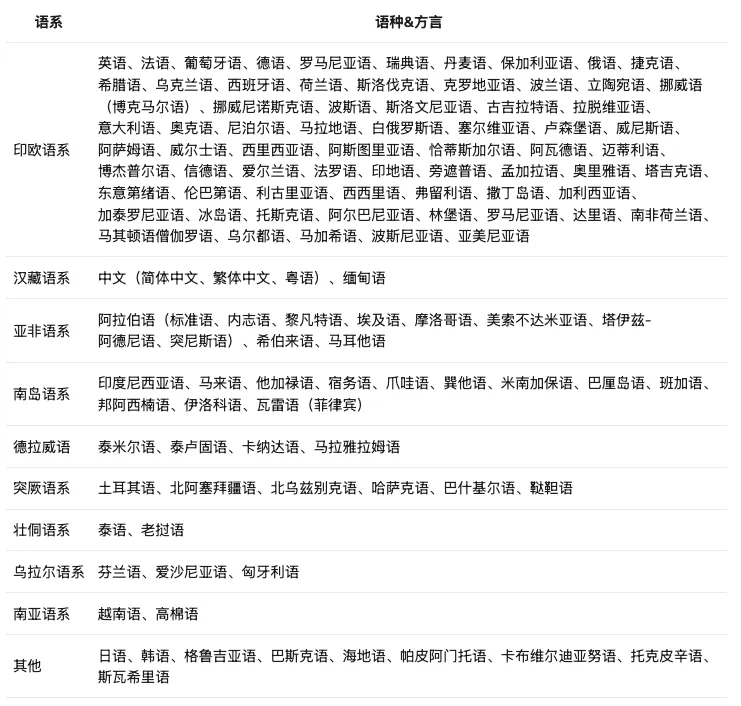

另外,Qwen3 的多语言能力也有了很大提升,目前已经能支持多达 119 种语言和方言,基本覆盖了全球主要的语言体系。

还有一点也很值得关注,Qwen3 在智能体(Agent)能力和编程(代码)方面也变得更强了,同时也更好地支持了 MCP 技术。下面这个视频展示 Qwen3 是如何思考并与环境进行交互的:

目前,经过后训练优化的 Qwen3 系列模型已经可以在多个平台上访问和部署,例如 Qwen3-30B-A3B,以及对应的预训练基座模型(如 Qwen3-30B-A3B-Base),已在 Hugging Face、ModelScope 和 Kaggle 等平台上线,面向公众开放使用。

普通用户也可以直接在 Qwen Chat 网页和手机 App 上使用。

快速体验 Qwen3 系列:

-

Qwen Chat 网页版:https://chat.qwen.ai/

-

GitHub:https://github.com/QwenLM/Qwen3

-

Hugging Face:https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

-

魔搭社区:https://modelscope.cn/collections/Qwen3-9743180bdc6b48

在部署方面,官方推荐使用 SGLang 和 vLLM 等推理框架,以获得更好的性能和易用性。对于本地部署场景,Ollama、LMStudio、MLX、llama.cpp 以及 KTransformers 等工具也提供了便捷的支持。

Qwen3 强大的背后,离不开多阶段的预训练和后训练

在模型预训练方面,Qwen3 相比之前的 Qwen2.5 有了大幅提升。此前 Qwen2.5 是在 18 万亿个 token 上进行预训练的,而 Qwen3 预训练使用的数据量几乎是其两倍,达到大约 36 万亿个 token,涵盖了 119 种语言和方言。

这些数据来源包括网页抓取内容、PDF 文档提取,还有用早期 Qwen2.5-Math 和 Qwen2.5-Coder 这两个数学和代码领域的专家模型合成数据,合成了包括教科书、问答对以及代码片段等多种形式的数据。

预训练

据官方技术报告介绍,Qwen3 的预训练流程分为三个阶段:

在第一阶段(S1),模型在超过 30 万亿个 token 的海量数据上进行了初步训练,处理的文本长度是 4K token,主要目的是打下基本的语言理解和通用知识基础。

到了第二阶段(S2),训练重点有所调整,加入了更多像 STEM(科学、技术、工程、数学)、编程和推理相关的专业数据,同时又在额外 5 万亿个 token 上进行了强化训练,进一步提升模型的专业能力。

最后,在第三阶段,Qwen 团队用高质量的长文本数据,把模型的上下文长度扩展到了 32K token,让它能更好地处理超长输入,适应更复杂的应用场景。

得益于模型架构的优化、训练数据量的增加,以及更高效的训练方法,Qwen3 的 Dense(密集)基础模型整体表现已经追上了体积更大的 Qwen2.5 版本。比如,Qwen3 的 1.7B、4B、8B、14B 和 32B 基础模型,整体能力分别能对标 Qwen2.5 的 3B、7B、14B、32B 和 72B 模型。

尤其在 STEM(科学、技术、工程、数学)、编程和推理这类专业领域,Qwen3 的表现甚至比 Qwen2.5 的大模型还要更好。

而对于 Qwen3 的 MoE(混合专家)基础模型来说,它们每次推理时只激活大约 10% 的参数,但依然能做到接近 Qwen2.5 Dense 基础模型的效果。这意味着,在保持高性能的同时,训练和推理的成本大大降低了。

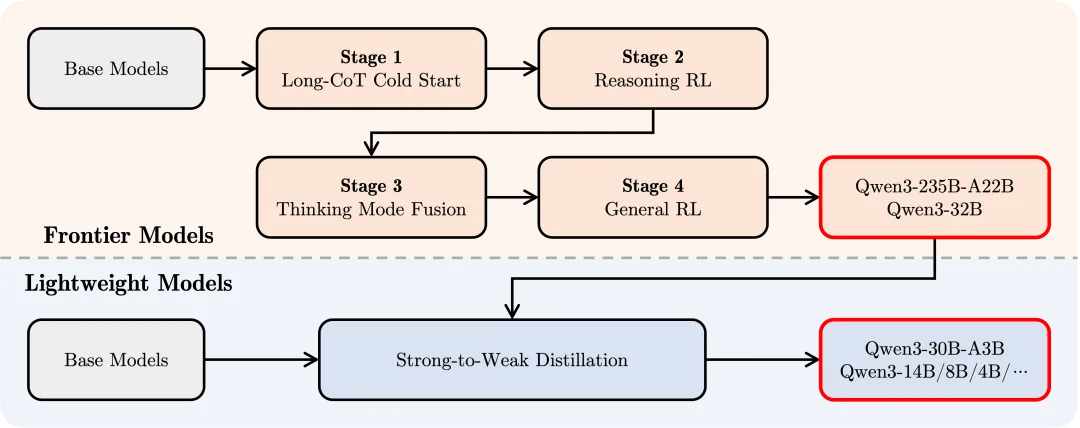

后训练

为了打造既能深度推理又能快速响应的混合型大模型,Qwen3 团队设计并执行了一套四阶段的后训练流程。具体包括:(1)长链推理冷启动、(2)长链推理强化学习、(3)思考与非思考模式融合、以及(4)通用能力强化学习。

在第一阶段,该团队通过大量涵盖数学、编程、逻辑推理和 STEM 等领域的长链推理数据,对模型进行了微调,打下了基本的推理能力基础。

第二阶段则引入了大规模的强化学习,通过设定规则奖励,引导模型在复杂问题中探索得更深入、更细致。

到了第三阶段,训练目标转向融合思考模式与快速响应模式。 Qwen 团队用一套混合了长链推理和常规指令微调的数据,对模型进行了再次微调,让它既能深度思考,又能根据任务需求快速作答,实现两种能力的平滑切换。

最后,在第四阶段,模型接受了更广泛领域的强化训练,覆盖指令遵循、格式规范、Agent 能力等二十多个方向,进一步提升了模型的通用性,同时修正了在早期训练中可能出现的不良行为。

这次阿里发布 Qwen3,毫无疑问是一次重磅操作。据了解,阿里至今已向全球开源 200 多款模型,千问衍生模型数量已突破 10万,超越美国 Meta 的 Llama 系列,成为全球最大的开源模型族群。可以说,Qwen3 的发布不是一次普通的升级,而是真正的“登顶”。

外媒 Venturebeat 也对此做出了高度评价,称对于企业来说,接入 Qwen3 非常高效,几小时内就能将现有的 OpenAI 接口系统切换到新模型,根本不用几周。Qwen3 的专家混合模型(MoE),在显存使用上相当节省,20-30B 规模模型的显存成本就能实现接近 GPT-4 的推理能力。

更有意思的是,Qwen3 提供了从 0.6B 到 32B 不同规模的密集模型版本,用户可以从笔记本小规模测试,一路扩展到多卡大集群,过程中几乎不用调整提示词。

Qwen3 发布后,在用户层也受到了广泛好评。其 GitHub 页面迅速获得了 17.9k 个 Star 和 1.2k 的 Fork,热度可见一斑。

在社交媒体上,不少网友们分享自己的一手体验感受。

有用户表示:“我刚试用了 @Alibaba_Qwen 的 Qwen3。

在需要快速响应时,它非常迅速;面对复杂问题时,它会花时间思考。它不是随便给个答案,而是经过深思熟虑,给出准确的结果。

在编程方面,它表现出色;在数学问题上,它依然冷静应对。

在语言处理上,它听起来很自然,不像其他模型那样怪异。令我惊讶的是,它甚至支持多达 119 种语言。

很久没见过这么优秀的开源模型了。”

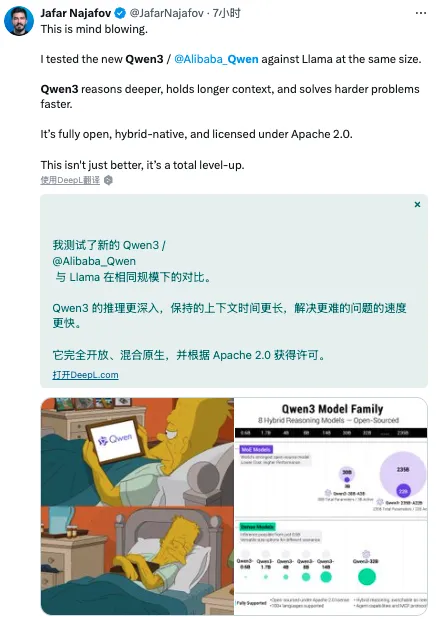

也有网友 Jafar Najafov 感叹道:“这真是令人震惊。我将 Qwen3 和同规模的 Llama 进行对比,Qwen3 的推理更深入,处理长上下文和解决复杂问题的速度都更快。它完全开源,原生支持混合推理,采用 Apache 2.0 许可证。这不仅仅是更好,简直是全新的升级!”

甚至苹果工程师 Awni Hannun 也在第一时间用 M2 苹果设备跑了 Qwen3 模型,随即发声道:“Qwen3 235B MoE(22B 激活参数)在 M2 Ultra 上通过 mlx-lm 运行得非常快。4 位模型大约用 132GB 内存,生成 580 个 token 的速度约为每秒 28 个!”

整体看来,Qwen3 的上线,AI 圈的反响都不错。

对此,Qwen 团队开源负责人林俊旸在 X 平台上表示,Qwen3 的开发过程中,团队解决了很多重要但容易被忽视的问题,比如:稳定的训练来扩展强化学习(RL)、平衡多领域数据,以及在提升多语言能力的同时不牺牲质量。

他还透露,未来团队将把重点转向训练能够进行长周期推理、执行真实世界任务的智能体。

那么,你体验上了 Qwen3 了吗?感觉怎么样?欢迎留言分享你的看法。

来源:

https://qwenlm.github.io/zh/blog/qwen3/

https://venturebeat.com/ai/alibaba-launches-open-source-qwen3-model-that-surpasses-openai-o1-and-deepseek-r1/

https://github.com/QwenLM/Qwen3

(文:AI科技大本营)