5 月 7 日,由 GOSIM、CSDN 和 1ms.ai 联合主办的全球开源技术盛会——GOSIM AI Paris 2025 在法国巴黎迎来了大会第二日的精彩议程。延续首日的热烈氛围,来自全球的 AI 专家、开发者和产业代表齐聚一堂,围绕 AI 技术的最新趋势与实践展开深入探讨。

从底层技术架构到前沿应用场景,本次大会围绕 AI 模型、AI 基础设施、AI 应用及具身智能等核心主题设立技术论坛,全方位覆盖 AI 领域的关键议题。此外,Spotlight Talks、PyTorch Day 等特色活动也为技术开发者搭建了一个思想碰撞与成果展示的技术舞台。

本次 GOSIM AI Paris 2025 不仅汇聚了来自 NVIDIA、Meta、阿里巴巴、Hugging Face、BAAI、MiniMax、Neo4j、Dify、MetaGPT、智谱 AI、Eigent.AI、Docker、英飞流、北京大学、德国 Fraunhofer 研究所、牛津大学、法国 openLLM 社区等机构的 80 余位技术专家与学者;更有华为、全法中国青年科创协会、中法人工智能协会、Apache 软件基金会、Eclipse 基金会、The Khronos Group 科纳斯标准联盟、WasmEdgeRuntime、LF Generative AI Commons、Linux 基金会研究部、OpenWallet 基金会、开放源代码促进会(OSI)、Software Heritage、K8SUG 等重量级合作伙伴深度参与,共同打造了一场 AI 与开源交织、学术与产业融合的国际技术盛宴。

开源+AI,不止是 1+1>2

在 Keynote 环节,LF AI & Data 基金会董事会成员 Zhipeng Huang 发表了题为《开放体验时代来临》的主题演讲,并系统梳理了当前大模型领域值得关注的六大发展趋势:

-

多模态统一架构。尽管“统一架构”仍有不少技术争议,但多个顶级实验室的研究已显示出明显趋势,即试图将多模态建模能力整合进统一框架。他特别提到 Meta 于去年年底发布的 BLT(Byte Latent Transformer)架构,展示了这一方向的可行性。Zhipeng Huang 认为,2025 年有望诞生具突破性的统一模型,对现有主流架构发起挑战。

-

高效注意力机制演进。线性注意力、动态稀疏注意力和混合注意力等机制正快速发展。

-

二阶优化走向实践:二阶优化因成本高昂,长期被视为理论工具,但这一局面正在改变。Zhipeng Huang 提到 Google Shampoo、PSGD、MARS 等项目,显示二阶优化正逐步应用于大规模训练场景。虽然尚未“爆发”,但他判断,未来随着计算资源更普及,二阶优化将在提升训练效率和模型泛化能力方面扮演关键角色。

-

从AI4S 到Equivariance4ALL:在科学建模、分子预测等结构化任务中,单靠大数据训练难以替代显式结构先验。Zhipeng Huang 强调,Equivariance 方法在小分子领域的重要性不容忽视,并呼吁研究者将先验知识与深度学习方法相结合,以增强模型对复杂结构的表达能力。

-

构建“数据油井”:数据质量决定模型上限。Zhipeng Huang 提到 Hugging Face 发起的 LeRobot 项目,代表了机器人数据向标准化、开放化演进的趋势。他强调,建立高质量、可复用的数据资产,是打造强大模型的基础。

-

后训练阶段成为关键环节:预训练日趋成熟后,后训练(如指令调整、奖励建模、记忆优化)逐渐成为提升模型性能的核心路径。Zhipeng Huang 指出,随着模型规模不断扩大,后训练将在特定任务优化中发挥越来越重要的作用,并可能带来实质性突破。

在这些技术趋势背后,也孕育着丰富的机会和全新的用户体验。Zhipeng Huang 表示,开放体验的核心不仅在于开放代码和模型,更在于开放协作与认知方式。他坚信,随着大模型持续演进,唯有拥抱开源、加强协作、推动标准建设,才能打造真正可持续的技术生态。

LF AI & Data 基金会董事会成员 Zhipeng Huang

“开源和开放标准正逐步成为推动人工智能发展的核心力量”,PyTorch 基金会执行董事、Linux 基金会 AI 总经理 Matt White 在《释放 AI 的全部潜能——开源与开放标准将定义智能系统的未来》主题演讲中说道。他指出,在全球 AI 竞赛不断加速的背景下,开源不仅成为各国政府高度关注的战略重点,也为那些依赖专有系统的“信息孤岛”提供了透明、可审计、可信赖的替代方案,“企业和用户越来越需要透明、安全且可信的系统,而开放性恰恰是解决之道。”

在谈及具体创新时,Matt White 分享了从智能体框架到数据平台,再到 Hugging Face、PyTorch 等开源社区的蓬勃发展,称这些生态系统正在共同推动 AI 的开放进程。他认为,开源 AI 的成功不仅源于代码本身,更来自于一个中立、开放且富有活力的社区,“不是由某家公司控制方向,而是大家共同推动标准与创新。”

随着 AI 从“模型中心”向“系统中心”演进,Matt White 强调开放标准的重要性日益凸显。他简要介绍了当前正在出现的 AI 标准,包括 Anthropic 的 MCP、谷歌的 A2A 协议、IBM 的 ACP 协议等,并指出 Linux 基金会是全球 200 多个开放标准的托管平台,支持标准建设的机制包括联合开发基金会(Joint Development Foundation)与社区规范(Community Specification)。他强调,标准必须厂商中立,才能真正服务于整个行业。

在开源许可方面,Matt White 宣布了一个重要进展——Linux 基金会正在推动一项专为 AI 模型设计的新型许可证 OpenMDW,该许可证涵盖模型架构、数据集、参数、文档与工具,具备全球适用性,并兼容现有主流开源许可证。他指出:“Apache 2.0 和 MIT 更适用于软件,但 AI 模型远比软件复杂,我们需要新的许可框架。”

最后,Matt White 也提出了几项建议:为 AI 工具和模型选用合适的开源许可证;积极参与全球协作,抵制“AI 民族主义”的保护主义倾向;反对对开源的过度监管,以避免抑制创新;支持中立、可靠的开放标准;并始终以负责任的方式构建可信的 AI,从工程层到产品发布保持一致。他总结道:“我们正处于开源 AI 的关键时刻,让我们共同努力,让它成为推动 AI 未来的事实标准。”

PyTorch 基金会执行董事、Linux 基金会 AI 总经理 Matt White

顶尖 AI 模型是如何炼成的?

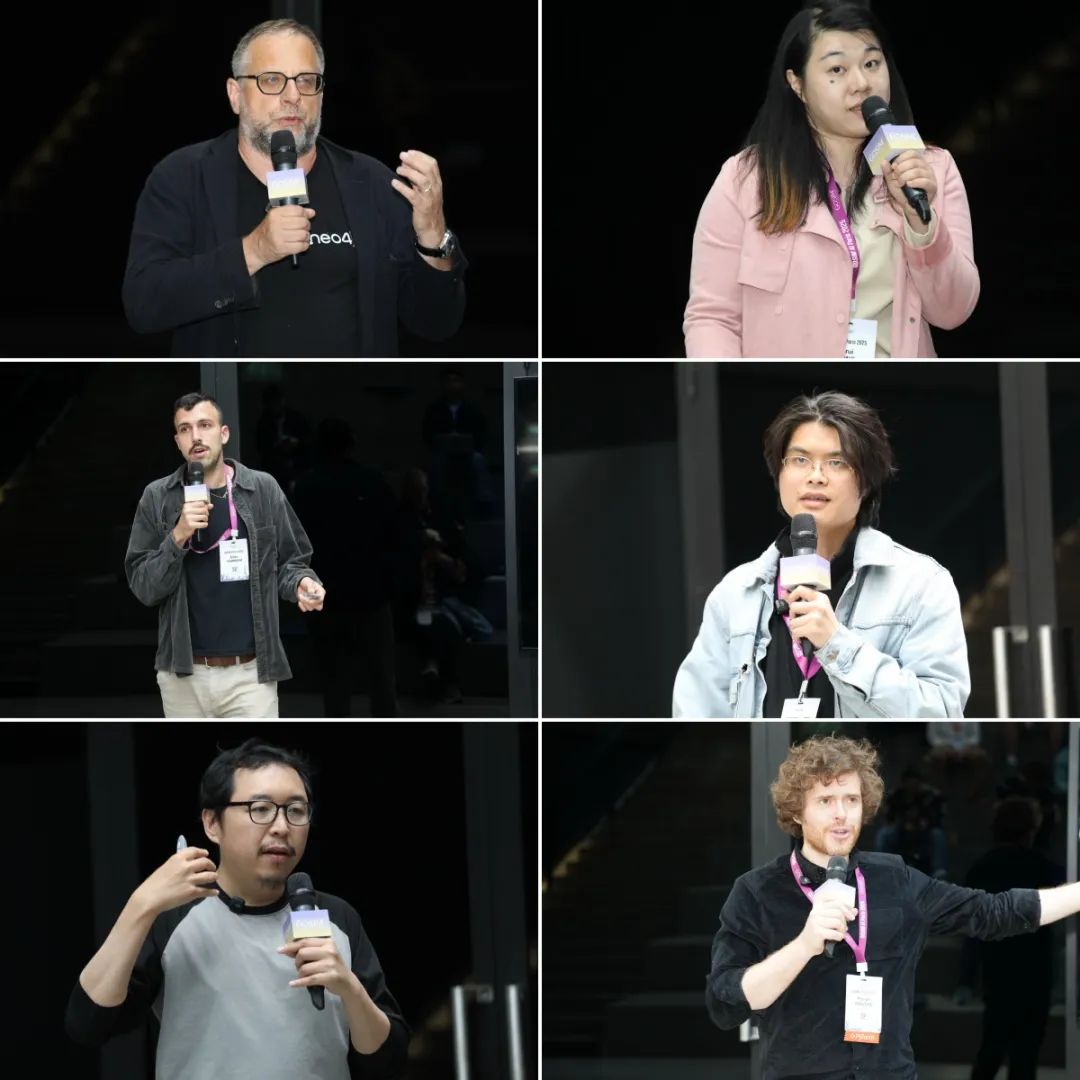

在 AI 模型分论坛上,一场关于模型构建与开源生态的深度探讨精彩展开,六位来自全球顶尖科研机构与企业的专家,带来了他们对基础模型研发和应用落地的第一手观察与技术干货。

阿里巴巴通义实验室科学家 Baosong Yang 分享了《Qwen 的多语言能力:从基础模型到应用落地》,展示了 Qwen 系列模型如何在多语言理解与生成任务中实现能力突破,并逐步走向产业级应用。来自 LAION 的科学负责人、Juelich 超级计算中心和研究中心高级研究员兼实验室负责人 Jenia Jitsev 在《开源基础模型:Scaling Laws 与泛化能力的探索》中指出,大模型的迁移能力需依托开源基础模型与数据集,强调 Scaling Laws 与泛化能力研究的重要性。

LINAGORA – OpenLLM 法国总经理 Michel-Marie Maudet 带来了《LUCIE:从零开始,用热爱打造的开源大模型》,他分享了一支由热情驱动的团队如何构建出“从训练代码到数据集全开放”的 LUCIE-7B 模型。美国东北大学电子与计算机工程系教授 Yanzhi Wang 则以《解构大模型训练——迈向从预训练到强化学习的完全开源 LLM》为题,提出“模型开放性框架(MOF)”,并展示了从预训练到强化学习全流程开源的 Moxin 系列模型。

在“小模型”方向,围绕《小而强:MiniCPM 如何在全球开源 AI 赛道实现突破》主题,OpenBMB & Modelbest 创始合伙人 Chao Jia 带来了热门项目 MiniCPM 的最新进展,展示了小模型在效率和性能上的平衡优势。而 Hugging Face 研究工程师 Elie Bakouch 也在《小模型与大模型的预训练实践》中,结合实践深入解析了当前构建强大 LLM 所需的关键要素,如 MoE、长上下文处理与训练稳定性优化。

解码 AI 基础设施的演进逻辑与技术趋势

随着大模型和 Agent 技术的广泛应用,AI 基础设施也日益成为决定技术能否规模化落地的关键。在本场分论坛中,我们邀请了来自产业与学界的多位技术专家,他们从多个维度展现了当前 AI 底层能力的建设成果与未来走向。

论坛开场,Docker 生成式 AI 加速高级副总裁 Jean-Laurent de Morlhon 带来《用 Docker 简化 AI 应用开发》主题演讲,介绍了如何借助 Docker Model Runner 实现本地化 GPU 推理,加速 AI 应用落地。马德里理工大学教授 Joaquin Salvachua 在《数据空间:构建 AI 数据宇宙的基石》中指出,可信的数据流通机制是构建 AI 生态的前提。

围绕大模型在企业环境中的工程化落地,Runhouse 机器学习工程师 Paul Yang 围绕《Kubetorch:面向 ML 执行和生产的现代 Kubernetes 原生方案》,强调了 Kubetorch 在 ML 模型执行与部署流程中的高效性与可调试性。随后,InfiniFlow 首席执行官 Yingfeng Zhang 的演讲《RAGFlow:引领企业级 RAG 的开源革命》,展示了如何通过开源手段解决数据质量差、语义匹配低等难题,全面提升企业级 RAG 系统的表现。

而在底层标准方面,英伟达开发者技术首席工程师 Markus Tavenrath 带来《Khronos 在开源与机器学习世界中的探索》,分享了 Khronos Group 在 OpenCL、SYCL、Vulkan 等开源标准领域的最新进展。Dimforge 首席执行官 Sebastien Crozet 在《WGML:构建高性能、跨平台、端侧推理框架的幕后故事》演讲中,聚焦于如何基于 Rust 与 WebGPU 构建轻量化、高性能的 GPU 推理框架 WGML。

AI Agent,驱动下一代应用生态的核心力量

作为本届大会关注的核心议题之一,AI 应用分论坛聚焦在大模型落地与智能体架构持续演进的关键环节。为此,多个重量级开源项目的实践者和技术领导者带来了他们在 AI 应用一线的深度思考与经验分享。

Neo4j AI 社区架构师 Alexy Khrabrov 以《OAKS:开放式智能体 AI 知识栈》为题,提出了以知识图谱和 AI 记忆系统为核心的可扩展架构,强调开放式生态对智能体成长的重要意义。紧接着,DeepWisdom 联合创始人、MetaGPT/OpenManus 项目负责人 Sirui Hong 在《OpenManus:通过框架与能力演进,赋能 LLM 智能体应用》中,通过增强推理规划和跨环境运行能力,为 LLM 智能体应用拓展了新的可能性。

随后,solo.io 高级架构师 Eitan Yarmush 带来《用 Kagent 重塑开源智能体技术栈》,聚焦底层基础设施,提出完整的 Kubernetes 原生技术栈解决方案。围绕智能体协作与扩展能力,Eigent.AI / CAMEL-AI.org 创始人兼 CEO Guohao Li 则在《探索智能体的 Scaling Law》中分享了 CAMEL 框架的前沿实践,深入研究智能体社群行为与协作机制。

当然,数据库层面的支撑也不可忽视。PingCAP 首席技术官 Dongxu Huang 在《面向 Agent 记忆的数据库,正确的实现方式》中,系统讲解了如何构建面向智能体记忆的高效 SQL 数据库。最后,Jina AI 首席 AI 工程师 Florian Hönicke 以《Agentic Search:智能体驱动的搜索范式》为本场论坛画上句点,系统阐述了智能搜索新范式,为智能体的信息获取与决策提供了新思路。

感知-认知-行动一体化,是具身智能的核心挑战

在具身智能论坛中,众多来自产业与科研前沿的专家学者齐聚一堂,围绕类人机器人、数据采集、情感交互等核心议题展开深入探讨。

Hugging Face 具身机器人工程师 Martino Russi 带来了《如何打造你的类人机器人》主题演讲,率先分享了他如何从开源一个拥有 16 个自由度的数据手套出发,探索构建类人机器人的实践路径。Unitree Robotics 欧洲区总监 Min Zhang 以《Unitree Robotics 推出的 G1 开源数据集与类人机器人》为题,分享了过去一年行业和学术界在类人机器人系统领域取得的重要进展,并宣布 Unitree 已正式开源 G1 类人机器人的运行数据集,支持多种开源解决方案并持续更新,以推动全球具身智能产业发展。Pollen Robotics 高级产品经理 Anne-Charlotte Passanisi 在《为机器人设计情感》演讲中提出了引人深思的问题:“当机器人开始感受,会发生什么?”她介绍了团队如何将语言模型接入 Reachy 2,通过手势、声音与表情将语言转化为情感,从而迈出了人机交互中实现人工共情的第一步。

北京智源人工智能研究院机器人算法工程师 Junkai Zhao 带来了《从人类示范中学习:可扩展机器人数据采集的新范式》的分享,介绍了一种新型的数据采集框架,展示其如何突破传统限制,支持跨任务、跨环境的机器人泛化学习,为通用机器人的现实应用奠定基础。机智云创始人兼 CEO Jack Huang 的演讲《人工智能赋能物联网设备,驱动产业变革的双引擎》强调了 AI 与 IoT 设备融合所带来的深刻变革。他深入分析了这一融合趋势、技术创新和多样应用,并探讨其如何成为推动传统产业数字化重构与新兴产业增长的核心动力。最后,北京智源研究院研究员 Cheng Chi 带来了《面向大规模具身模型的“大脑-小脑协同”框架探索》主题分享,该团队受生物大脑中“大脑-小脑协同机制”的启发,提出一种融合高层认知推理与快速低延迟运动响应的新型架构框架,将高层认知推理与快速、低延迟的传感-运动适应结合。

GOSIM AI Spotlight 精选亮点成果重磅呈现

与主题分明的分论坛不同,Spotlight Talks 更像是一场快速、高密度的信息闪电战。来自全球各地的开发者与研究人员与带来了极具代表性的项目与方法论,不乏对绿色 AI、机器人终身学习、RAG 智能体框架等热门技术的深入探索,展示了 AI 实践前沿的多元风貌。

CodeCarbon 非营利组织主席 Benoit Courty 率先介绍了《CodeCarbon:衡量你服务器的碳足迹》,展示了如何通过全新 API 与仪表盘更准确地评估服务器的碳足迹,助力开发者实现更可持续的计算。北京智源研究院研究员 Siao Liu 聚焦机器人终身学习,分享了《从小处着眼,从大处着手:为终身机器人操作的原语提示学习》,提出了“原语提示学习(PPL)”方法,以提升机器人在真实与模拟环境中的操作泛化能力。随后,阿里巴巴通义实验室算法专家 Ruixue Ding 在《ViDoRAG:基于动态迭代推理智能体的视觉文档 RAG》中介绍了 ViDoRAG 在多模态理解与动态推理中的创新。

在工具层面,北京航空航天大学博士生 Yaowei Zheng 介绍了《Llama Factory》,一个无需编码即可高效微调主流大模型的训练框架,支持包括 LLaMA、Qwen、Mistral 等在内的百余种预训练模型。而在智能体架构设计方面,Relevant Study LLC 创始人 Zonghuan Wu 带来了《MoFA,一切皆为智能体》的主题演讲,他系统介绍了通用智能体框架 MoFA,通过组合式构建理念推动 AI 普惠发展。

专家云集,共探 PyTorch 如何引领 AI 实践落地

PyTorch 凭借其灵活性、易用性和强大的扩展性,已成为人工智能研究和应用的核心框架,推动着多个领域的技术突破。在本次大会的 PyTorch Day 论坛,PyTorch 基金会执行董事、Linux 基金会 AI 总经理 Matt White 进行了开幕致辞,随后多位重量级嘉宾分享了 PyTorch 在实际应用中的创新成果,并探讨了如何借助这一框架实现前沿技术。

其中,Pollen Robotics 联合创始人兼 CTO Pierre Rouanet 带来了题为《现实世界中的机器人技术,会是 AI 的下一个前沿吗?》的演讲,深入探讨了机器学习与机器人技术的融合如何为交互、操作与具身智能开辟新的可能性,并强调真实世界中的实验与数据采集在弥合仿真与实际部署之间鸿沟中的关键作用。Meta 机器学习研究工程师 Nicolas Hug 在《TorchCodec:为 PyTorch 设计的媒体解码库》的分享中,展示这个全新库如何优化解码流程,使视频和音频数据能够高效转换为 PyTorch 张量,并与 PyTorch 生态系统深度融合的实践。Red Hat 高级首席产品经理 Erwan Gallen 和 Red Hat 高级机器学习研究工程师 Eldar Kurtic 共同呈现了《使用 vLLM 扩展 LLM 推理:多加速器部署与量化 LLM 应用》的演讲,介绍了通过 vLLM 扩展大语言模型推理的实践过程,并借助多加速器部署与量化技术提升推理性能,进一步推动 AI 系统的规模化应用。

对于近期业界备受关注的开源大模型 LLama 4,Meta 生成式 AI 研究产品负责人 Christian Keller 详解了 Llama 4 的开发历程,并通过真实案例展示其在具身智能场景中如自主决策与人机协作方面的广阔应用潜力。紧随其后,Common Crawl 高级研究科学家 Pedro Ortis Suarez 带来了《利用 Common Crawl 数据服务于 AI 与 ML 应用》主题演讲,分享了如何高效利用 Common Crawl 的网页归档,从预处理到数据过滤的全流程实践,为数据驱动的研究提供了宝贵经验。而 Hugging Face 机器学习工程师 Nouamane Tazi ,则以《超大规模经验分享:将训练扩展到数千个 GPU》为题,深入剖析超大规模训练的实践细节,并通过 5D 并行策略——涵盖数据、张量、流水线、上下文和专家维度,揭示了 LLM 扩展背后的系统工程之美。

基于《教 Mistral 推理:使用 PyTorch 和 NVIDIA 进行训练后优化》主题,NVIDIA 对话式人工智能解决方案架构经理 Meriem Bendris 以 Mistral 为工作示例,聚焦推理性能优化,演示了如何使用 PyTorch 与 NVIDIA 工具链(如 NeMo、TensorRT-LLM)提升 Mistral 等开源模型的实际运行效率,满足当下对高性能推理的旺盛需求。深度学习专家 Olatunji Ruwase 在《DeepSpeed – 深度学习模型的高效训练可扩展性》分享中介绍了深度学习优化库 DeepSpeed 在提升极大规模模型训练的计算、通信和 I/O 优化方面的应用。IBM 研究科学家 Garrett Goon 发表了《在 PyTorch 中推进 Mamba》主题演讲,带来了 IBM 在推动 PyTorch 中 Mamba 训练的最新进展,包括长序列数据的上下文并行训练、Mamba 与专家混合模型的支持以及专家并行、Torch 原生关联扫描操作,以及改进的 DTensor 操作支持等。在硬件感知优化方面,Lightning AI CTO Luca Antiga 在《Lightning Thunder:为现代硬件加速的增强版 PyTorch》中展示了 Lightning Thunder 如何将“教学式” PyTorch 代码编译为经过优化的分布式 PyTorch 代码,帮助团队轻松编写自定义代码转换,以高效扩展模型、减少 GPU 浪费,并掌控技术栈。

聚焦个性化 AI 应用,Runhouse 机器学习工程师 Paul Yang 带来了《超越 GPT-4,打造最适合你的 AI:用微调释放第一方数据的价值》的主题演讲,探讨了如何结合第一方数据与微调方法,在质量、速度和成本间找到最佳平衡,为用户构建真正“属于自己的 AI”。而在多语言大模型的评估实践上,EleutherAI 自然语言处理研究员 Catherine Arnett 总结了一套可复现、可扩展的评估最佳范式,尤其强调了开发新多语言基准时应重点考虑的关键因素。围绕《Kyutai 的多模态开源,从在线演示到设备端实现》这一主题,Kyutai 首席探索官 Alexandre Défossez 分享了实验室从在线 demo 到本地设备上的流式模型运行的探索历程,涵盖语音、视觉、同声传译等多个模型方向,并剖析了跨平台部署带来的技术挑战。最后,Hugging Face 机器学习工程师 Pablo Montalvo 在《PyTorch x Transformers 的演进之路:Python 式编程风格、自动微分与模块化如何塑造现代 AI》演讲中率先回顾了 Transformers 库的发展之路,如何从单一 BERT 实现演进为模块化生态系统,并通过 PyTorch 的灵活性与新特性(如 torch.compile、DTensor)持续推动现代 AI 工程的可组合性与可扩展性。

从技术展示到实践探索,共绘智能新篇章

大会第二天依旧干货满满、亮点频出。在展示单元(Showcase Sessions),众多企业与科研机构带来了他们在 AI 领域的最新技术成果与产品,吸引了大量观众驻足交流,现场气氛热烈。而在竞赛单元(Competition Sessions),来自全球的开发者、工程师与机器人爱好者围绕开源 SO-ARM100 机械臂套件展开实践探索,尝试通过模仿学习解决真实任务。这一套件集成了 Hugging Face 的 LeRobot 框架,并结合 NVIDIA 的 AI 与机器人技术,支持包括 ACT 和 Diffusion Policy 在内的前沿架构,为参赛者提供了丰富的技术支持和广阔的探索空间。

两天的时间虽短,但精彩不断。我们一起见证了前沿技术的碰撞、思想观点的交锋,也感受到了社区蓬勃的活力与创造力。GOSIM AI Paris 2025 至此圆满落幕,感谢每一位参与者的热情投入与支持。

当然,技术探索永不停步!下一场技术盛宴已提上日程——GOSIM HANGZHOU 2025(杭州),将于 9 月 13-14 日隆重召开。届时,更多精彩议题、重磅嘉宾和实践分享即将揭晓,敬请关注~

(文:AI科技大本营)