每次写完一段得意的 Python 代码,你是不是也幻想着在客户或老板面前来一场完美的产品 demo?但现实往往是,要么在 Jupyter Notebook 里翻来覆去地展示 cell,要么在命令行里敲一堆指令,显得有点……不够高级,对吧?我最开始也这么想,于是脑子里冒出了一堆计划:要不学学 Streamlit 或 Gradio,搭个漂亮的前端页面?后端再用 FastAPI 撑起来?听起来不错,但一想到学习成本和开发时间……有没有更轻松的办法呢?

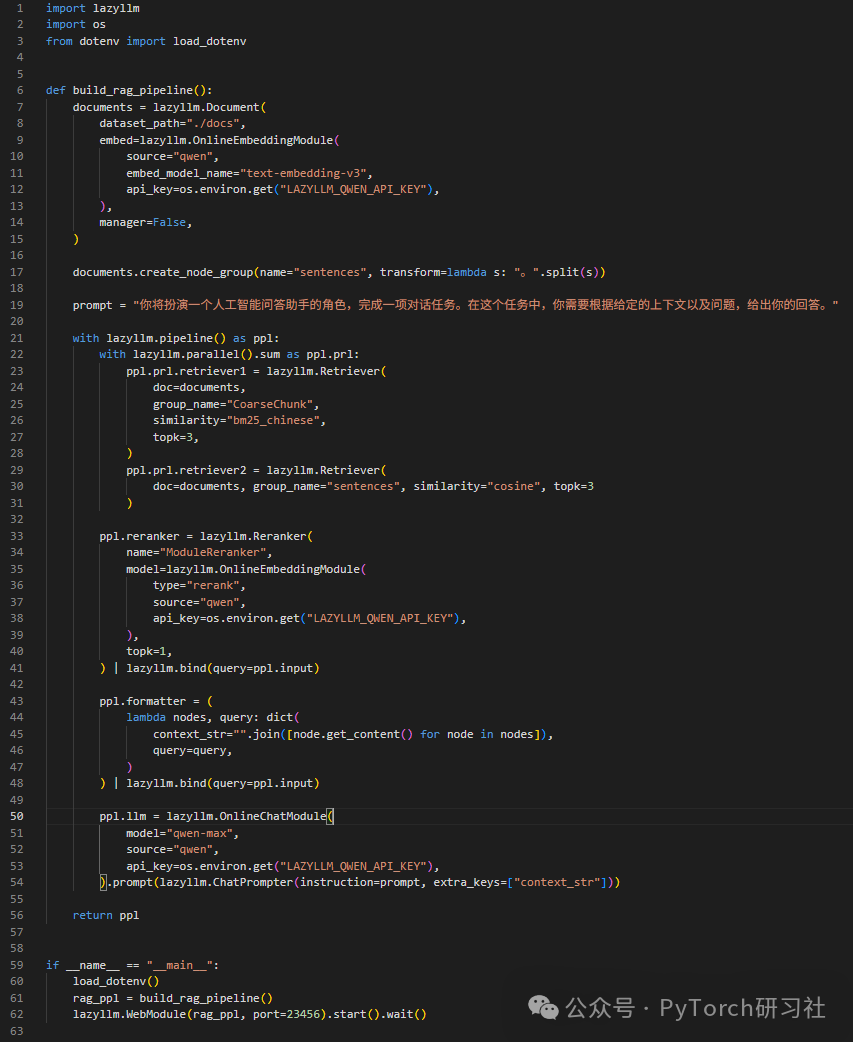

直到我昨天看到了 LazyLLM,我用不到 10 行 Python 代码实现了一个带有两个并行检索方法和一个重排方法的 RAG 系统。

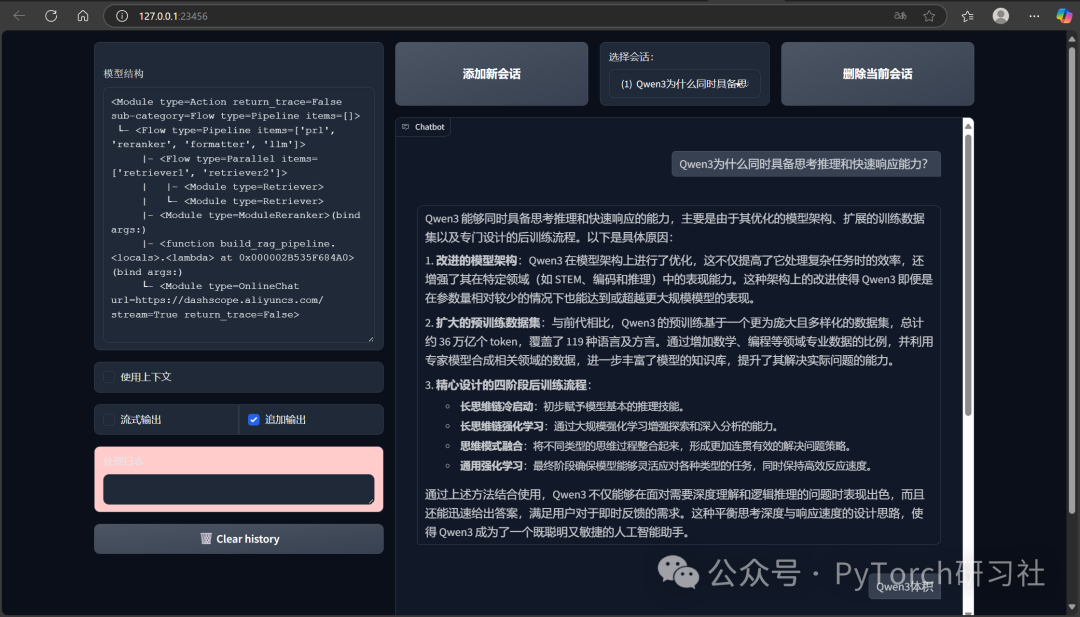

我用 Qwen3 官方技术博客作为知识库,然后开始询问 RAG 系统有关 Qwen3 的知识,毫无疑问,系统全部答对了。

你认为构建一个像上面一样带有交互页面的 RAG 系统 demo 要写多少代码? 如果用 LangChain 或者 LangGraph + Gradio 的话,我感觉至少需要 100 行代码!

带上格式化自动换行和空行也就 63 行代码!而且我还实现了两个检索器(retriever)和一个重排器(reranker)!

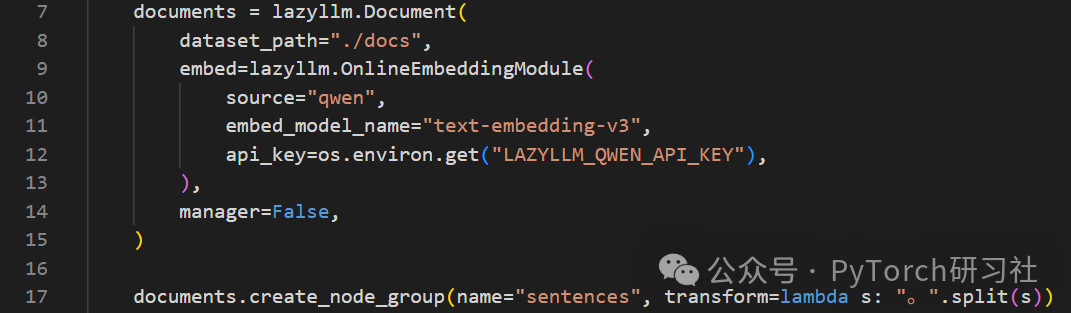

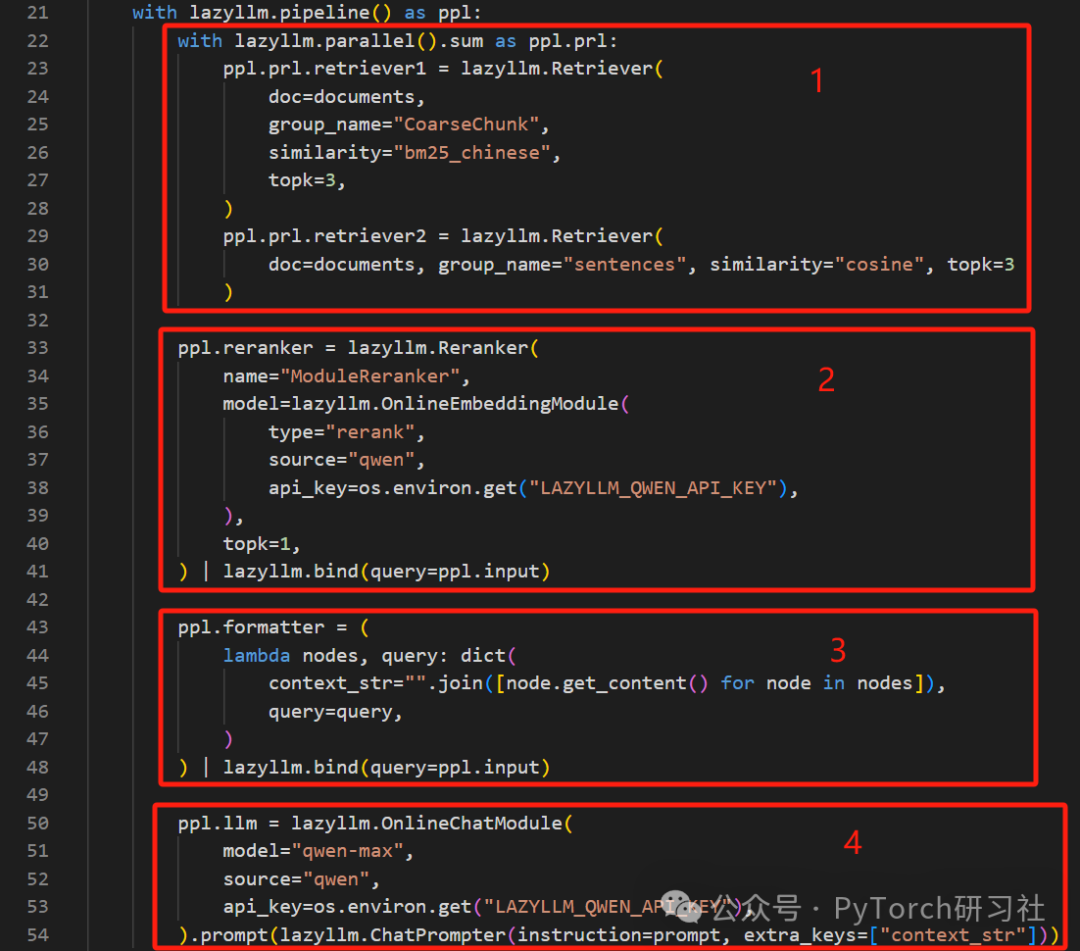

所有核心逻辑都位于 build_rag_pipeline 函数中,顾名思义,这是一个构造 RAG 工作流的函数。

我首先将与代码文件同级的 docs 目录下的所有文档作为知识库,并借助于阿里云提供的 text-embedding-v3 嵌入模型生成嵌入向量。

4. 利用阿里云提供的 qwen-max 大模型根据用户查询和检索到的结果生成回复

lazyllm.WebModule(rag_ppl, port=23456).start().wait()

在浏览器中输入 http://127.0.0.1:23456/ 即可开启会话。

这一切得益于商汤 LazyAGI 团队开发的开源低代码开发框架:LazyLLM。专为构建和优化多智能体(Multi-Agent)大语言模型(LLM)应用而设计。它提供从应用搭建、数据准备、模型部署、微调到评测的一站式工具支持,帮助开发者以极低的成本快速构建 AI 应用,并持续迭代优化效果。

🔧 LazyLLM 的核心特性

-

模块化与数据流管理:通过 Pipeline、Parallel 等预定义流程,轻松组织复杂应用逻辑。

-

多智能体支持:快速构建包含多个 AI 智能体的应用,适配大模型任务。

-

一键部署与跨平台兼容性:支持从原型验证到生产发布的完整流程,自动配置子模块服务,兼容裸金属服务器、开发机、Slurm 集群和公有云。

-

高效的模型微调:支持应用内模型微调,持续提升应用性能。

-

轻量级网关机制:简化服务启动和 URL 配置,提升开发效率。

感兴趣的小伙伴可以去官方 GitHub 仓库查看:

https://github.com/LazyAGI/LazyLLM/tree/main

官方免费课程

另外,LazyLLM 还提供了《20小时通关工业级RAG》的免费课程。课程在 RAG 基础概念的基础上,系统讲解了:

1. 如何通过优化检索策略来逐步提升知识库召回的准确性;

2. 如何运用向量数据库来加速工程的冷启动和召回效率;

3. 如何将多模态、知识图谱和Agent融入到RAG中。

力求帮助学员突破 “只能开发玩具级 RAG” 的瓶颈,掌握工业级交付能力。课程不仅涵盖丰富的理论知识,还配备大量实践案例,助力学员在产业智能化浪潮中抢占先机。

加入星球获取我为你精心打造的提示工程、RAG和Agent开发实践教程。

(文:PyTorch研习社)