“十年后我们会说,我们需要无处不在的人工智能,就像互联网和电力一样。”英伟达 CEO 黄仁勋 5 月 19 日在 Computex2025 的开幕演讲的开始再次强调了 AI 及英伟达作为 AI 基础设施的重要性。

这次演讲中,黄仁勋分享了关于人工智能和机器人未来的观点以及一些新的计算产品。但与之前的传言不同,黄仁勋并未在演讲中提及 CPU。

此外,演讲最后,黄仁勋还称将建立中国台湾省办事处。从公布的渲染图可以看到,英伟达在中国台湾地区的办事处大楼采用了类似宇宙飞船的设计风格,命名为 NVDIA Constellation。黄仁勋表示,该园区将尽快开始建造,为员工提供办公空间。

此次发布重点之一是围绕扩展版的 Blackwell 平台——内部称为 Blackwell Ultra AI。

在此之前,黄仁勋重点提到了之前在 GTC 上分享到的 AI 发展历程:Agentic AI 和 Physical AI。

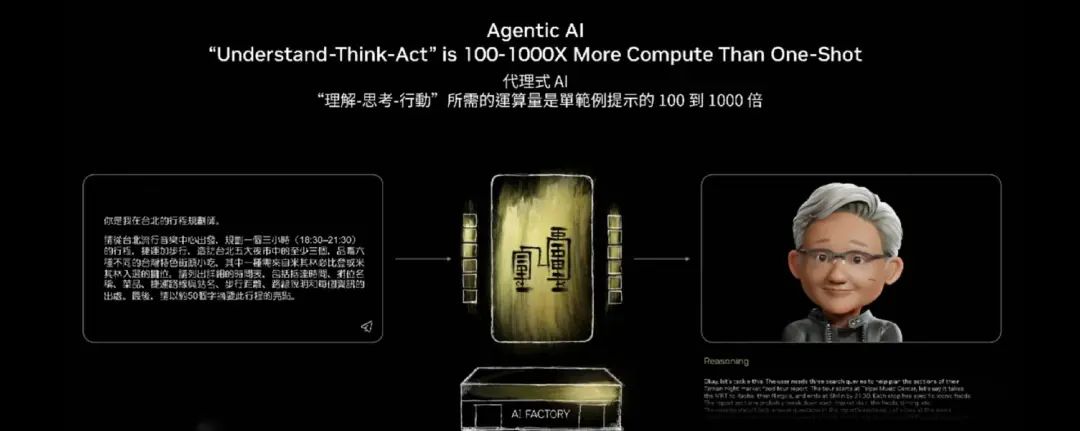

“一旦 AI 具备推理能力和感知能力(如多模态处理,读取 PDF、搜索、使用工具),就成为了 Agentic AI。”黄仁勋说道,Agentic AI 能完成:给定目标、逐步拆解、思考最佳方案、考虑后果,然后执行计划,其中可能包括研究、使用工具或与其他 Agent 协作。

黄仁勋认为,Agentic AI 本质上是数字形态的机器人:Agentic AI 本质上是 “理解、思考、行动” 的循环,而这也是机器人技术的闭环。

而对于接下来的 Physical AI,即理解真实世界的 AI,如理解惯性、摩擦力、因果关系等。

黄仁勋表示, Physical AI 是机器人革命的基石,能对物理环境进行推理等。从 “单次响应” 转向 “思考型”、“推理型”、“推理时间扩展型” AI,需要更多计算。因此,英伟达创建了新系统 Grace Blackwell。

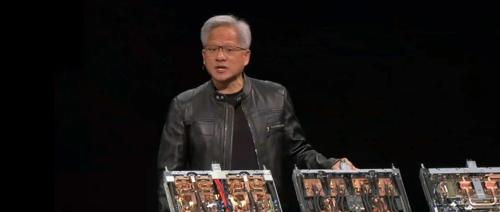

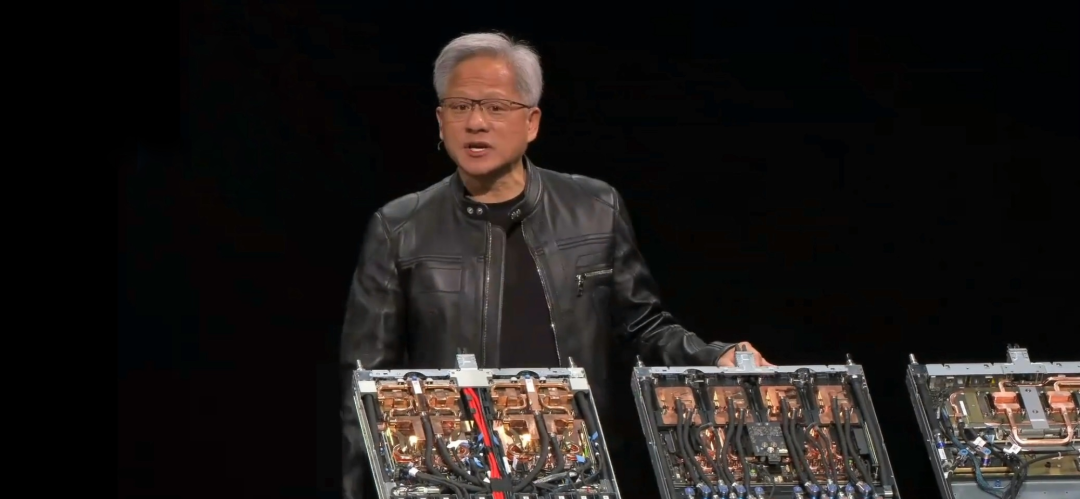

“我很高兴地宣布,我们的 Grace Blackwell 系统在经历了艰难的开发过程后,现在已全面投入生产。基于 HGX 主板的 Blackwell 系统自去年以来已全面投入生产,并于 2 月开始交付。Grace Blackwell 已被多家云服务提供商采纳,并在 Twitter 等平台上获得广泛认可。

我们计划在本季度升级到 Grace Blackwell GB300 版本,GB300 配备了升级版 Blackwell 芯片,其推理性能提升了 1.5 倍,HBM 内存容量增加了 1.5 倍,网络连接能力翻倍,增强了整体系统性能。”

据介绍,Grace Blackwell 具备 “扩展” 能力:“向上扩展”(Scale up)指将单个计算机变为巨型计算机;“向外扩展”(Scale out)指连接多台计算机分布式处理。“向外扩展容易,向上扩展极难 —— 构建超越半导体物理极限的大型计算机极其困难,而这正是 Grace Blackwell 的使命。”黄仁勋说道。

Grace Blackwell GB300 系统达 40 PFLOPS,约相当于 2018 年 Sierra 超级计算机的性能。“Sierra 超级计算机配备 18000 块 Volta GPU,而这里一个节点就取代了整台超级计算机,六年内性能提升 4000 倍,这是‘超摩尔定律’。”黄仁勋说道。

黄仁勋在现场还展示了 GB200 Grace Blackwell 超级芯片。他表示,英伟达的 AI 算力每 10 年提升大约 100 万倍。公司已与台积电的合作促成了一种名为 COOS-L 的新工艺,使得大规模芯片的制造成为可能。同时,公司开发了“全球最快”的交换机 NVLink,目前运行速度为 7.2TB/s。NVLink 主干网带宽达到 130TB/s,连接了 72 个 GPU,采用创新的布线和结构化同轴电缆。

此外,Vera Rubin(Vera 是 CPU,Rubin 是 GPU)整体性能是 GB300 的 3.3 倍,CPU 内存容量是 Grace 的 4.2 倍,内存带宽是 Grace 的 2.4 倍,预计将于 2026 年下半年量产出货;此外,黄仁勋还预览了下一代 AI 超级芯片 Rubin Ultra,内存带宽是前代的 8 倍,性能是 GB300 的 14 倍,下一代 GPU 架构采用了最新的 Feynman。

“数据中心正在经历几十年来的根本性重构——AI 正在融入每一个计算平台。”黄仁勋说道。

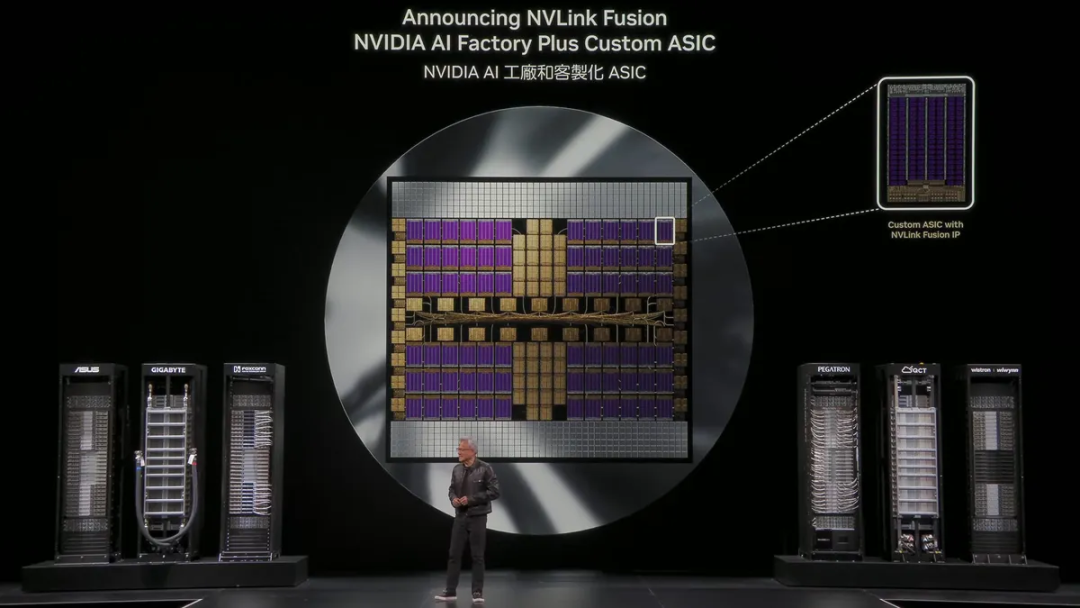

基于此,英伟达宣布推出 NVLink Fusion,助力构建 AI 基础设施,而非仅仅构建单一、特定的超级芯片。

据悉,Fusion 旨在帮助云服务商将 AI 工厂规模扩展到百万级 GPU,兼容任何 ASIC(专用集成电路),并可与英伟达的机架级系统和端到端网络平台整合,后者可实现高达 800 Gbps 的数据吞吐能力。

通过 NVLink Fusion,包括富士通(Fujitsu)与高通(Qualcomm)在内的 CPU 厂商也可与英伟达 GPU 搭配,构建高性能 AI 工厂。此外,基于 NVLink 打造定制化 AI 计算方案的厂商还包括:联发科(MediaTek)、迈威尔(Marvell)、阿捷科技(Alchip)、Astera Labs、新思科技(Synopsys) 和 Cadence 等。

RTX Pro Enterprise 则是新发布的一款全能服务器,是用于 AI 代理的计算机:无论是文本、图片还是视频模态,支持全球所有已知模型和应用,甚至支持《孤岛危机》等游戏。“RTX Pro 服务器已在所有行业合作伙伴中批量生产,这可能是我们有史以来市场推广规模最大的系统。”黄仁勋说道。

黄仁勋还提到,DeepSeek R1 有突破性的性能提升,其计算能力提高了四倍。“DeepSeekR1 确实是送给全球 AI 行业的礼物,其计算机科学突破意义重大,为全球研究者开辟了新方向。DeepSeek-R1 影响着人们对 AI 和推理的思考,为行业和世界做出了重大贡献。”

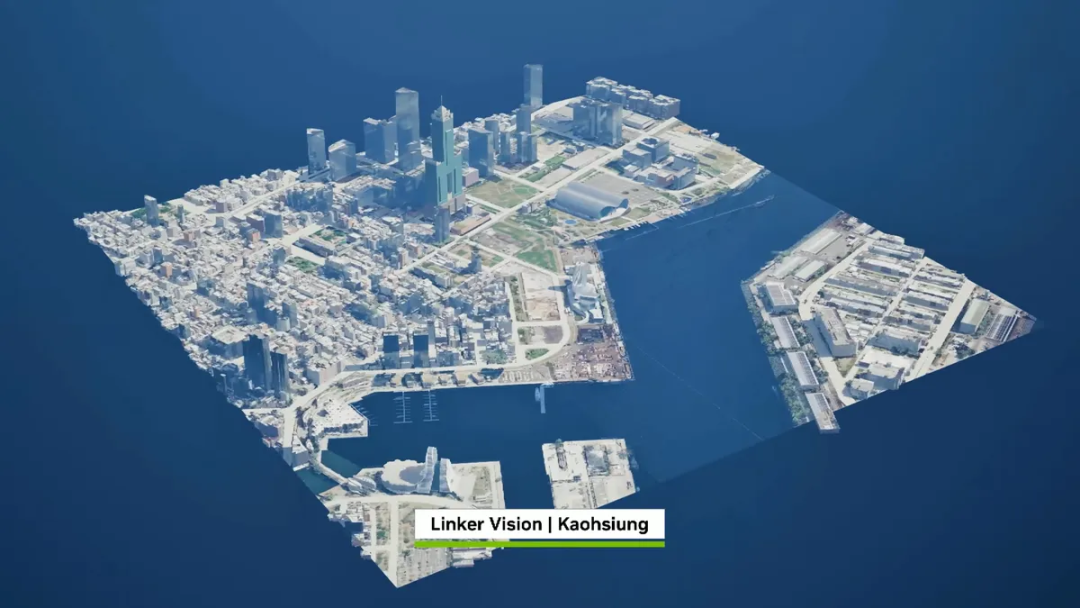

现场,黄仁勋宣布,英伟达将联合台积电、富士康在中国台湾省建立 AI 超级计算机。

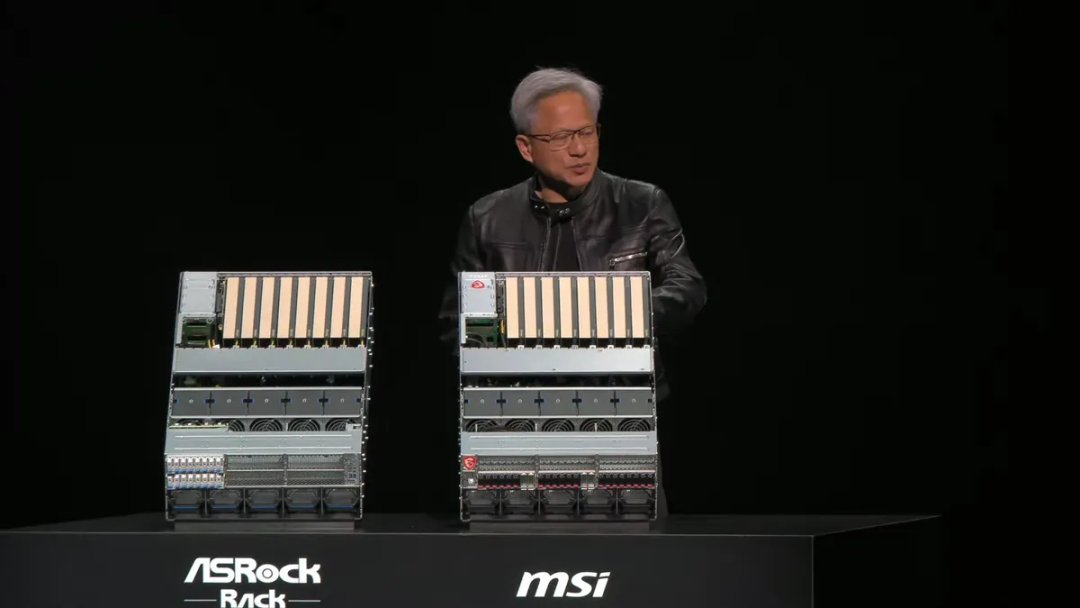

黄仁勋表示,此前在 CES 上谈到的 Project DIGITS 的个人 AI 计算机 DGX Spark 已全面投产,即将在未来几周上市。它面向那些想要拥有自己的超级计算机的人,各公司将自行定价。黄仁勋表示:“每个人都可以在圣诞节拥有一台。”

黄仁勋还展示了另一台个人超级计算机 DGX Station。采用与巨型系统采用相同的编程模型,采用单一架构,具备运行 1 万亿参数大模型的能力和性能。

开发人员可以使用 Lepton,根据其运营需求利用特定区域的 GPU 计算能力进行按需和长期计算。

Lepton 是一个人工智能平台,它提供了一个计算市场,将构建当今代理和物理人工智能应用程序的全球开发人员与 Nvidia 云合作伙伴全球网络提供的数万个 GPU 连接起来。

英伟达的云合作伙伴包括:CoreWeave、Crusoe Energy、Firmus Technologies、富士康 GMI Cloud、Lambda Labs、Nscale、软银(SoftBank)以及 Yotta Data Services 等。

“Nvidia DGX Cloud Lepton 将我们的全球 GPU 云提供商网络与 AI 开发者连接起来。我们正在与 NCP 携手打造一个全球规模的 AI 工厂。”黄仁勋表示。

Lepton 平台将 GPU 购买和管理过程抽象化,使合作伙伴能以统一的方式向开发者提供 GPU 算力资源。英伟达称,这一方式让开发者和企业能够专注于 AI 功能的开发与实验,同时灵活获取他们在测试、训练和部署模型时所需的算力资源。

“现在我们的主题演讲 90% 不再围绕 GeForce,但这并非因为我们不爱 GeForce——GeForce RTX 50 系列迎来了有史以来最成功的发布,是我们历史上发布速度最快的产品,而 PC 游戏已经有 30 年历史,这足以说明 GeForce 的非凡。但现在让我们谈谈核心的库。”黄仁勋说道。

一切当然始于 CUDA。他表示,通过让 CUDA 尽可能高性能、高普及,全球 CUDA 安装量庞大,应用程序就能轻松使用 CUDA GPU。安装量越大、开发者越愿意创建库;库越多,就能实现更多惊人的功能、开发出更好的应用,为用户带来更多价值,进而推动更多人购买计算机,更多计算机又意味着更多 CUDA——这种反馈循环至关重要。

然而,加速计算并非通用计算。通用计算中,人们用 Python、C 或 C++ 编写软件并编译,方法论始终一致:编写应用、编译、在 CPU 上运行,但这在加速计算中根本行不通。

因此,英伟达的逻辑是:深入理解应用就能加速应用;创建更适合加速计算的架构,就能让 99% 的运行时间以接近光速的效率运行,尽管这些代码仅占总量的 5%。但大多数应用中,一小部分代码占据了大部分运行时间。

黄仁勋还提到,英伟达正在开发量子经典或量子 GPU 计算平台,他预测未来所有超级计算机都有量子加速部分,超级计算机将拥有 GPU、QPU(量子处理单元)和 CPU。而今年 1 月时黄仁勋表示,量子计算投入使用至少还需要 20 年时间,但 3 月份又公开表示对量子计算应用时间的预测言论是错误的。

存储方面,黄仁勋认为,未来的存储不再是 CPU+ 存储机架,而是需要系统嵌入到存储机架中,在非结构化数据的原始数据中进行索引、搜索和排序,这一过程计算密集。因此,未来多数存储服务器前端将配备 GPU 计算节点。

“Agentic AI 本质上是数字机器人,因为机器人需要感知、理解和规划,这与 Agentic AI 的功能一致。但我们也想建造物理机器人,而物理机器人首先需要‘学习如何成为机器人’,这在现实世界中效率低下,因此必须创建虚拟世界让机器人学习,而虚拟世界必须遵循物理定律。”黄仁勋说道。

机器人领域最大的挑战(也是 AI 整体的最大挑战)是数据策略,这需要大量研究和技术投入。黄仁勋表示,在机器人领域,人类演示至关重要,人类演示可以告诉机器人如何执行任务,AI 可以从中学习泛化。但如果想教机器人大量技能,就需要很多的远程操作人员(被称为“轨迹数据”,trajectories)。因此,英伟达用 AI 扩展人类演示中收集的数据,来训练 AI 模型。

由于人工演示数据生成速度有限,英伟达开发了 GR00T-Dreams ——一个可以自动生成机器人在新环境中执行任务的视频系统。它甚至可以根据一张图片,生成视频供机器人学习新任务。

这属于合成数据生成,即通过 AI 模拟任务过程,提供用于训练机器人的大规模高质量数据。

GR00T-Dreams 也补充了 Isaac GR00T-Mimic 工具,后者可以通过 Omniverse 和 Cosmos 从少量人类演示中扩展出更多动作数据,而 Dreams 则可生成全新的视频内容。

黄仁勋还表示,已与 DeepMind 和 Disney Research 合作开发了全球最先进的物理引擎 Newton,计划于七月开源。据介绍,Newton 完全支持 GPU 加速,具有高度可微性和超实时操作能力,能够通过经验实现有效学习。

“为了实现机器人技术,我们需要 AI;为了训练 AI,又需要 AI。这正是 Agent 时代的伟大之处——需要大量合成数据生成、技能学习和巨大计算量。”黄仁勋说道。

黄仁勋表示,英伟达正在将该物理引擎整合进 Nvidia 的 ISAAC 模拟器,这一整合能够以真实的方式让这些机器人“活”起来。未来,英伟达会将训练好的 AI 模型植入仿真机器人,让它学习成为优秀的机器人。

英伟达还公布了其类人机器人基础模型 Isaac GR00T N1.5 的首次重大更新。GR00T N1.5 相较前一代模型在适应新环境和工作空间配置方面能力更强。英伟达表示,该版本显著提升了模型在物料搬运与制造任务(如物体分类与归位)中的成功率,并可部署于公司将在年内发布的 Jetson Thor 机器人计算平台上。GR00T 模型的早期采用者包括:AeiRobot、Foxlink Lightweel 和 NEURa Robotics 等公司。

此外,黄仁勋表示,正在使用 Isaac Groot 平台与汽车行业并行推进机器人系统。Isaac Groot 平台由一种名为 Jetson Thor 的新处理器驱动,专为机器人应用而设计,适用于从自主车辆到人机系统。英伟达的 Isaac 操作系统管理所有神经网络处理、传感器处理和数据管道,利用一支专业机器人团队开发的预训练模型来增强系统能力。

(文:AI前线)