作者|沐风

来源|AI先锋官

今年毕业季,一个新问题让高校和大学生们,陷入焦虑,即论文AI率问题。

前者各种办法,严控论文AI化。

后者的烦恼则是,明明自己一字一句熬夜敲出来论文,却被系统判定为“高度疑似AI生成”。

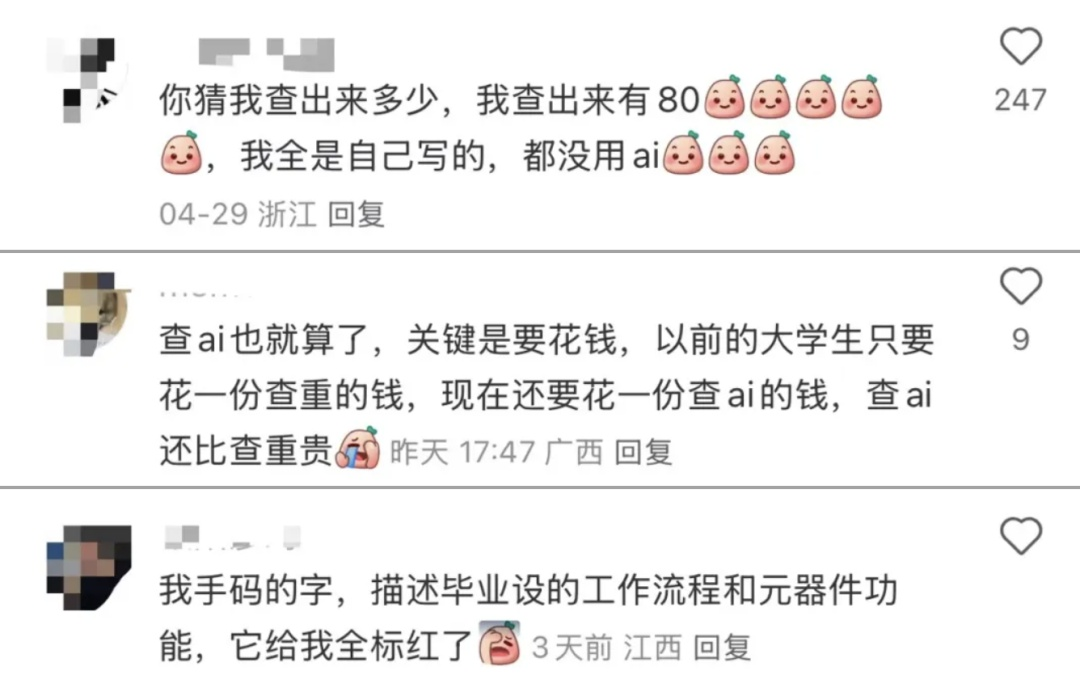

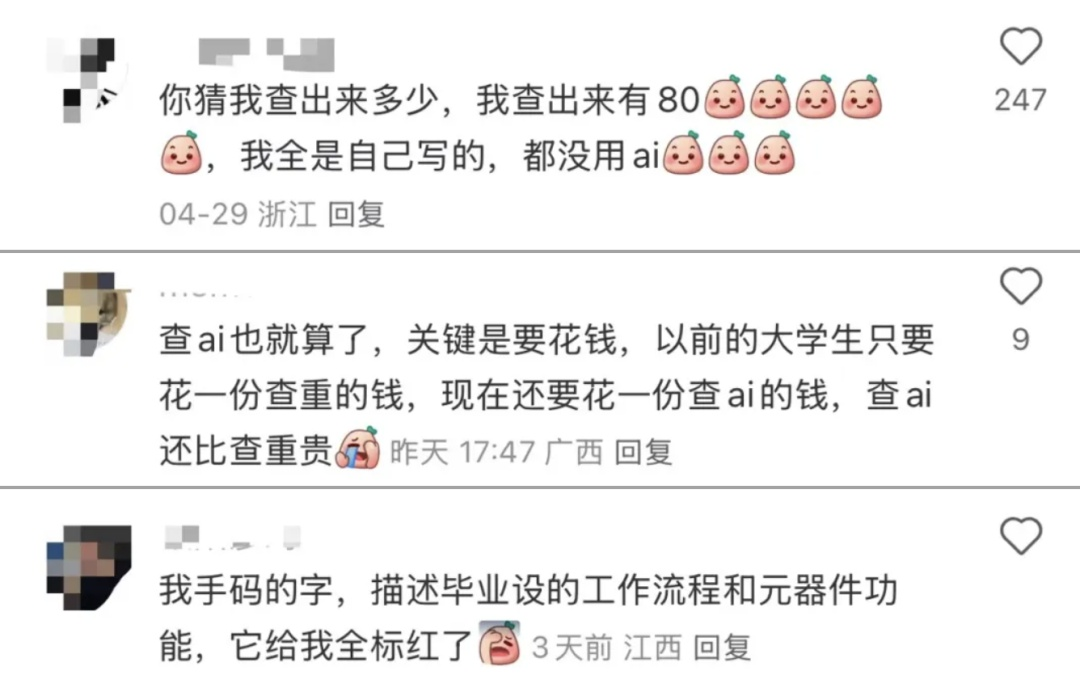

最典型的案例来自一则网络热帖。

一位学生分享称,他的论文是纯手工打造,没用一句AI生成的内容,却被检测系统判定为AI率高达80%。

更夸张的是,还有网友突发奇想,把《滕王阁序》、《岳阳楼记》和《荷塘月色》输入检测系统试了一下。

结果,《岳阳楼记》和《荷塘月色》的AI率分别是53%和62.88%,《滕王阁序》甚至被判了个“AI率100%”。

这些检测结果引发大量讨论,有人调侃“王勃老师得重写了”;也有人质疑,检测工具是否具备足够的科学性和判断力。

澎湃新闻在5月的一篇报道中指出,复旦大学、天津科技大学、广东工业大学等多所高校,已将AIGC检测纳入毕业论文管理流程。

复旦明确规定,论文撰写、数据分析等环节禁止使用AI,仅在文献检索等环节可以适度使用。

一项由斯坦福大学与加州大学伯克利分校共同发布的研究指出,当前主流AI内容检测工具在识别非母语英语写作内容时存在显著偏差。

研究团队使用Turnitin、GPTZero等工具检测91篇非母语写作者的托福作文,结果发现其中61.22%的文章被错误判定为AI生成,误判率高达76%。

论文指出,这些工具通常依据“困惑度”(perplexity)进行判断。

所谓“困惑度”(perplexity),本意是衡量文本的“随机性”和“人类风格”,可偏偏像非母语写作者这种用词规范、结构清晰的写作方式,在系统眼里反而“像AI”。

在去年12月发表的一项研究中,德国柏林应用科学大学专家黛博拉·韦伯· 沃尔夫团队评估了学术界广泛使用的14种AI检测工具。

结果显示,只有5款工具的准确率高于70%,没有一款工具的得分超过80%。

当研究团队通过替换同义词及重排句子顺序,对AI生成的文本进行微调后,检测工具的准确率下降到平均不足50%。

OpenAI早前也曾承认,他们开发的AI文本识别工具,识别AI生成内容的准确率仅为26%,而对人类写作的误判率为9%

可以理解,高校想通过规则框定AI使用边界,避免学术不端。

尽管如何界定“合理使用”,仍缺乏共识,但简单以比例划线、只依赖工具判断的方式,显然片面。

一个可以探讨的逻辑是,如果使用上,AI只是辅助,那么判定上,AI工具也应该只是辅助。

(文:AI先锋官)