SA-Radar团队 投稿

量子位 | 公众号 QbitAI

以神经网络为核心引擎,让AI承担雷达仿真数据生成任务,还实现对雷达物理特性的建模与控制——

作为高级驾驶辅助系统(ADAS)中扮演着至关重要角色的雷达,其相关研究和开发仍面临数据获取的挑战。

尤其让人头疼的事情,是雷达图像显著受到具体软硬件细节的影响。

为了解决这一问题,SA-Radar应运而生。

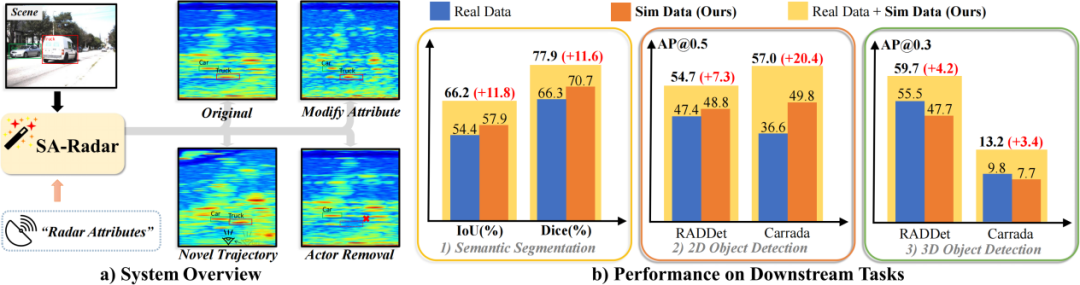

如下,真实画面右侧从左至右依次是RGB图像、雷达真值、雷达仿真结果、雷达属性修改后的仿真结果、去除场景目标后的仿真结果和新视角下的仿真结果。

下图展示了在同一场景中,不同雷达属性和不同视角下的仿真结果:

现存两种雷达仿真方法均有不足

凭借其卓越的抗干扰能力和在恶劣天气条件下的可靠性,雷达在复杂交通环境中表现出色。

然而,雷达相关研究和开发仍面临数据获取的挑战。

现有的雷达仿真方法可以被大致分为两种:

-

生成式雷达仿真 -

基于物理的雷达仿真

生成式雷达仿真通过生成对抗网络(GAN)等方法直接生成特定领域的雷达数据。

这种生成数据在简单的2D任务上能实现和真实数据接近的效果。

然而,该方法主要存在两个问题——

第一,不同雷达的接收信号存在明显的域差异,因此需要为每种雷达单独收集训练数据。

第二,由于缺乏物理先验,生成式方法无法实现雷达属性的外推,即只能仿真特定雷达属性下的数据。

相比之下,基于物理的雷达仿真通过建模电磁波从发射到接收的完整过程来仿真雷达数据,这使得它是可解释和属性可控的。

然而,这种方法需要了解详细的雷达硬件参数和复杂的信号处理算法,并花费较长的仿真时间。

通过神经渲染模型实现可控且高效仿真

为了解决上述问题,研究团队提出了SA-Radar。

该方法集成了生成式方法和基于物理方法的优势,通过基于波形参数的雷达属性表示和嵌入波形参数编码的3D U-Net模型,实现了多种传感器设置下雷达数据的可控且高效仿真。

具体来说,该项工作提出了一种基于波形参数的雷达属性表示方法。

它通过雷达回波信号在各维度的波形参数来表征雷达属性,从而有效克服了雷达具体细节的需要。

在此基础上,该项工作提出了一种高效的神经渲染方法-ICFAR-Net。

它以波形参数编码的雷达属性为条件,能够捕获由不同雷达配置引起的信号变化,从而有效生成不同雷达属性下的雷达立方体(距离–方位–多普勒张量)。

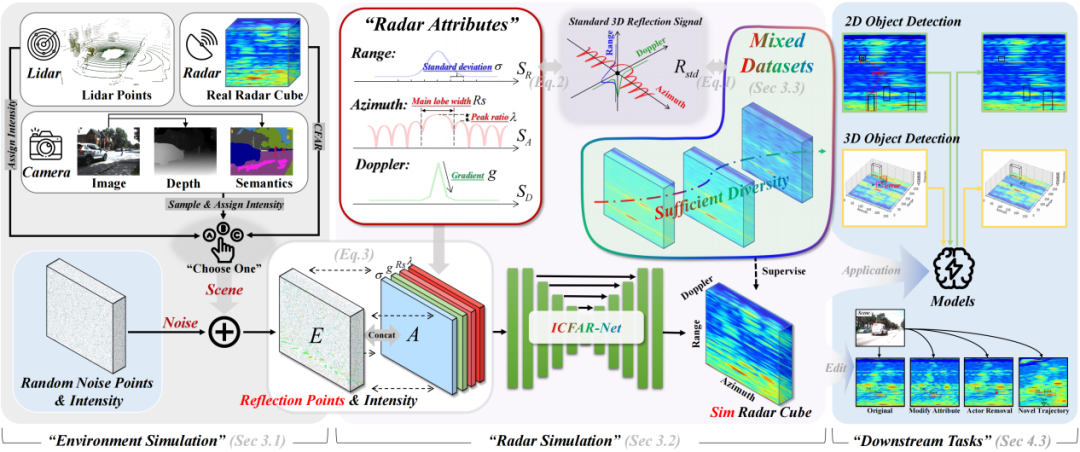

研究人员介绍,SA-Radar提供了一条完整的雷达仿真管线,精心设计了从环境仿真到雷达立方体仿真的全过程。

环境仿真

在环境仿真中,研究者构建了一个统一的反射环境张量。

该张量记录了所有反射点在雷达立方体中回波信号对应的离散位置和反射强度。

构建过程可拆分为两个阶段:场景仿真和噪声仿真。

对于场景仿真,研究过程中提供了多种传感器设置来捕捉场景中的反射点和并定义其反射强度,包括激光雷达、相机和传统雷达。

对于噪声仿真,则通过在距离、方位角和多普勒三个维度上都随机分布的反射点来模拟噪声源(即把噪声信号建模为来自噪声反射点的雷达信号)。

雷达仿真

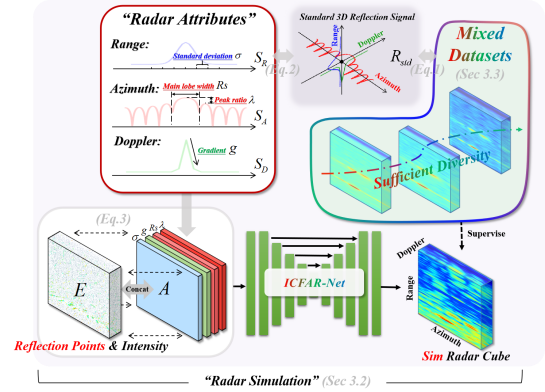

研究团队将雷达立方体建模为每个反射点上回波信号的叠加。

这使得可以在不需要获得雷达具体细节的情况下,通过一个三维反射波形来表征雷达属性。

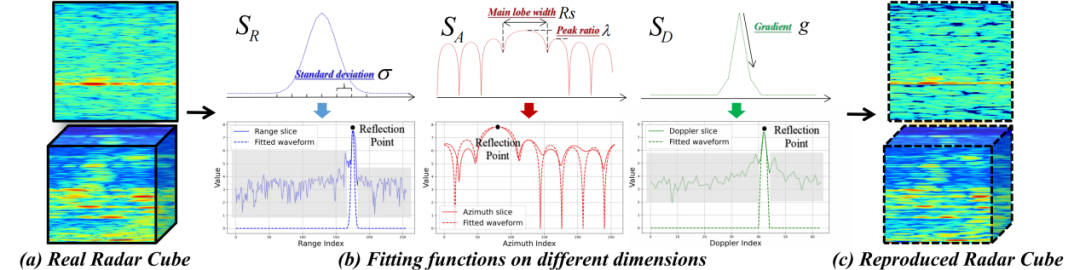

进一步地,团队提出了一种基于波形参数的雷达属性表示方法,通过三维反射波形在不同维度的波形参数{σ, g, Rs, λ}来直观地表征雷达属性。

在此基础上,研究团队设计了ICFAR-Net,这是一种基于波形参数编码的3D U-Net,能够捕捉不同雷达配置引起的信号变化,并准确生成对应的雷达立方体(距离–方位–多普勒张量),如下图所示。

与此同时,团队构建了一个带有丰富雷达属性注释的混合数据集,以确保ICFAR-Net稳定训练,极大地增强了ICFAR-Net对不同种雷达的仿真能力。

为了测试上述研究成果,研究人员在多个下游任务上——包括2D/3D目标检测和雷达语义分割等,进行了广泛评估。

结果表明,SA-Radar的模拟数据既逼真又有效,无论是单独使用还是与真实数据结合使用,都能持续提升模型性能。

此外,如文章开头所示,SA-Radar还支持在新的传感器视角和可编辑场景中进行仿真。

精度和效率较现有方法显著提升

实验结果表明,此方法在雷达仿真的质量和效率方面都优于已有方法,并显著增强了下游任务,包括2D/3D目标检测和多视图语义分割。

如下表所示,这一方法的仿真误差明显更小,尤其是全局平均误差。

效率方面,雷达仿真时间在0.036s左右,要远远快于RadSimReal和传统的物理模拟(一般至少花费5s)。

此外,这个方法的大部分时间成本在于反射环境张量E的生成,但也只需要0.26s左右。

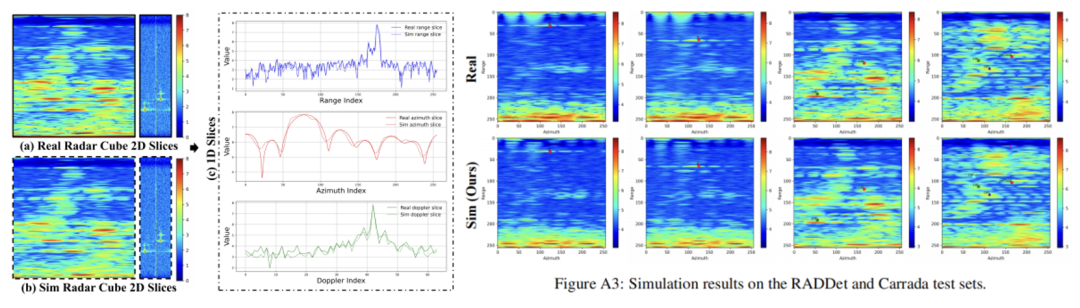

下图则展示了仿真结果和真实雷达立方体的比较,新方法的仿真结果与真实雷达立方体高度相似(包括噪声区域)。

团队也通过多种不同的下游任务来验证SA-Radar仿真数据的有效性。

为了排除场景多样性导致的增益,只在RADDet和Carrada的训练集场景上生成仿真数据,数据量大约为原始数据的两倍。

下面是各任务上的实验结果。

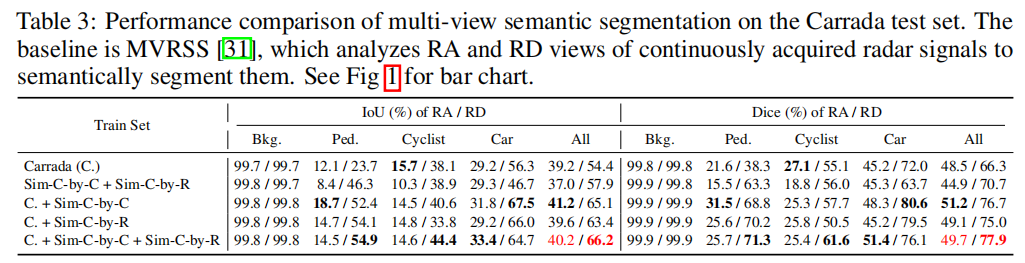

2D目标检测和多视图语义分割

在比较简单的任务上,如2D目标检测和多视图语义分割,即使仅使用此次提供的仿真数据,其效果优于使用真实数据进行训练的效果。

同时,该模型在仿真数据和真实数据的联合训练下取得了最佳性能。

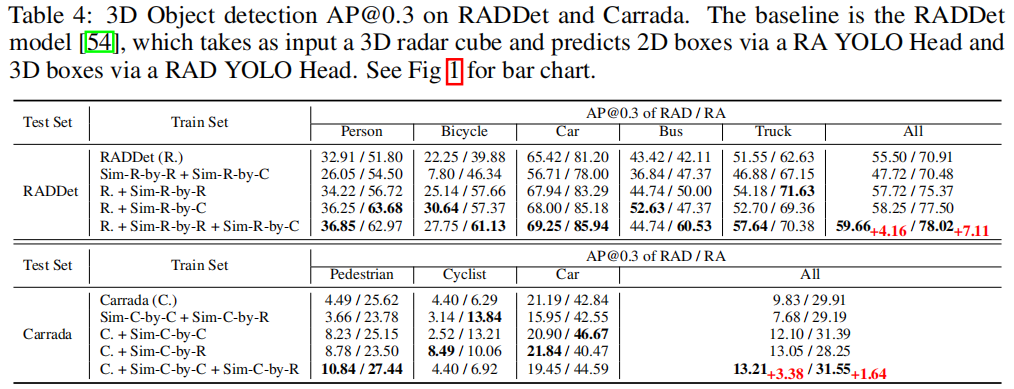

3D目标检测

团队的仿真数据训练的模型实现了接近真实数据集训练的性能,而联合训练的模型实现了最佳性能。

换句话说,SA-Radar团队的仿真数据在三维尺度上被证明是有价值的,能在复杂任务上对真实数据稳定提供增益。

更多可视化比较结果如下:

完全使用真实数据训练的模型在SA-Radar团队的仿真数据上依然能够实现相当的性能,这证明了其物理合理性。

此外,团队也在NuScene上探究了SA-Radar在没有见过的传感器和场景上的表现,进一步验证了SA-Radar在该情况下也能鲁棒地能够仿真物理可靠的雷达数据。

论文链接:

https://arxiv.org/abs/2506.03134

Github:

https://github.com/zhuxing0/SA-Radar

项目主页:

https://zhuxing0.github.io/projects/SA-Radar

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)