前几天简单介绍了OmniGen2的情况。

这个工具的来头很有意思,它是由智源研究院研发并开源的。

智源研究院由北京市政府支持成立,聚焦原始创新与核心技术攻关,目标成为全球AI学术思想、顶尖人才及产业政策的源头。其运行机制强调青年学者主导、开放协作,形成了“智源学者”“智源大会”等产学研生态。

和ChatGPT O4、Flux Kontext 等类似工具相比,OmniGen2最大的优势,是支持中文(依托千问2.5)。

原理就不多说了,下面放实际跑图效果和模型下载链接。

1、模型安装

ComfyUI原生支持OmniGen2,只需要升级到最新开发版即可加载工作流(模型和工作流在文末提供网盘免费下载)。

用到两个模型:

omnigen2_fp16.safetensors,安装路径:ComfyUI\models\diffusion_models

qwen_2.5_vl_fp16.safetensors,安装路径:ComfyUI\models\text_encoders

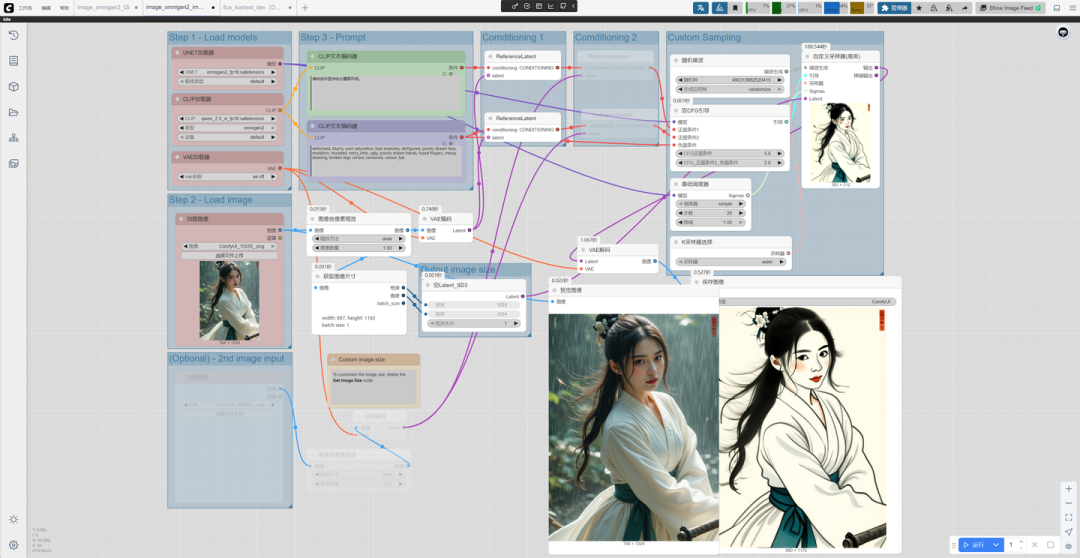

2、工作流概览

主要节点:

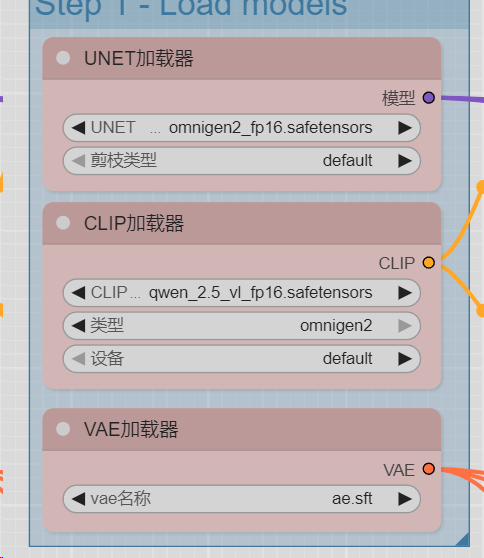

模型加载:

UNET加载器,选择OmniGen2模型(事实上OmniGen2放到UNET目录也可以)。

CLIP加载器,选择千问2.5VL模型。

VAE,选择ae.sft,该模型为Flux共用VAE,本文没有再提供下载。

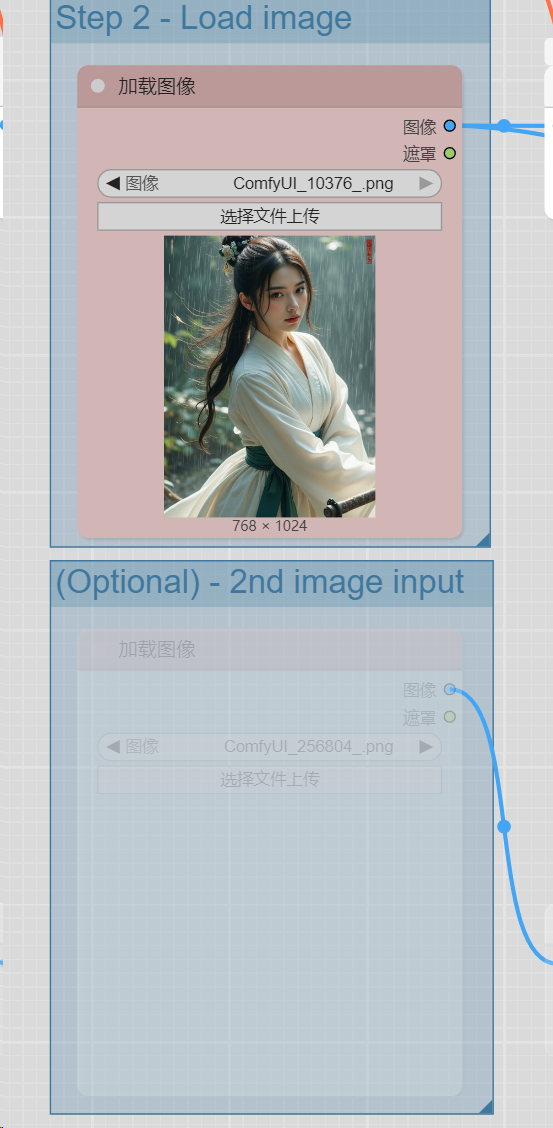

上传图片:

工作流支持上传多张图片,因为用到一张比较多,所以第二个上传图片节点置灰,有需要可以激活。

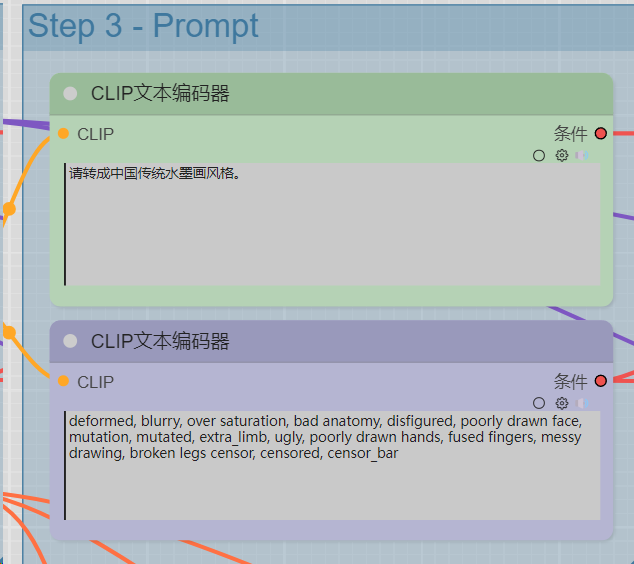

提示词:

由于千问是阿里的产品,所以原生支持中文。尽量写的详细、清晰。

3、跑图:

请转成中国传统水墨画风格。

请给角色戴上墨镜。

请给角色换成粉色比基尼。

(原画面没有露出手,所以AI就发挥了)

请把画面的背景换成上海夜景。

4、时间

在我的3060的12G显存上,一张图大约2-3分钟,比Flux Kontext dev略慢,勉强可以接受。

实测支持NSFW(狂喜)。

网盘下载:

https://pan.quark.cn/s/1a8d08291164

(文:路过银河AI)